上回分享了一些通用大模型的使用感受,今天咱们就来聊聊垂直领域大模型,照旧附上论文资料,同学们自取哈!

其实照目前的趋势来看,垂直领域大模型的未来发展是要比通用大模型好的,一是通用大模型有GPT4这座难以跨越的大山,二是自研通用大模型的成本实在太高,一般公司承受不来。所以,各类厂商们自然就会选择参与垂直领域大模型的角逐。

目前卷出来的垂直领域大模型已经有很多了,我今天就来和大家分享几个比较出名的,感兴趣的同学也可以自己上手一试。

1.BloombergGPT 金融大模型

原始论文:BloombergGPT: A Large Language Model for Finance

链接:https://arxiv.org/abs/2303.17564

BloombergGPT是由彭博社开发的拥有500亿参数的语言模型。依托彭博社的大量金融数据源,BloombergGPT构建了一个3630亿个标签的数据集,支持金融行业内的各类任务。

作为首个金融垂直领域大模型,BloombergGPT同样基于transformer架构,采用译码器的技术。实验可得,BloombergGPT在执行金融任务方面的表现超过了现有的通用 LLM模型。

2.FinBERT金融大模型

原始论文:FinBERT: A Large Language Model for Extracting Information from Financial Text*

链接:https://onlinelibrary.wiley.com/doi/pdfdirect/10.1111/1911-3846.12832

FinBERT同样是适用于金融领域的大型语言模型,采用了两大类预训练任务:字词级别的预训练和任务级别的预训练。具体来说,FinBERT有以下内容:

-

FinBERT-Pretrained:针对大规模金融文本的预训练 FinBERT 模型。

-

FinBERT-Sentiment:用于情感分类任务。

-

FinBERT-ESG:用于 ESG 分类任务。

-

FinBERT-FLS:用于前瞻性陈述(FLS)分类任务。

实验表明FinBERT在识别与环境、社会和治理问题相关的讨论方面优于其他模型。

3.LaWGPT 中文法律知识模型

项目地址:https://github.com/pengxiao-song/LaWGPT/

LaWGPT 目前也是比较热门的垂直领域大模型之一了,它是一系列基于中文法律知识的开源大语言模型。

该系列模型在通用中文基座模型(如 Chinese-LLaMA、ChatGLM 等)的基础上扩充法律领域专有词表、大规模中文法律语料预训练,增强了大模型在法律领域的基础语义理解能力。在此基础上,构造法律领域对话问答数据集、中国司法考试数据集进行指令精调,提升了模型对法律内容的理解和执行能力。

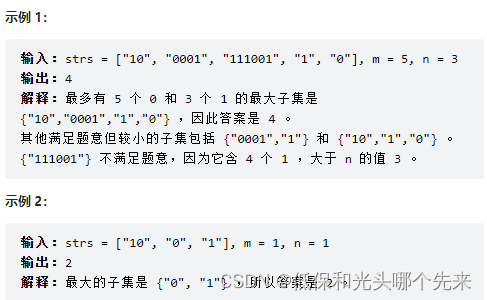

放两张官方图感受一下:

4.BenTsao 中文医学模型

项目地址:https://github.com/SCIR-HI/Huatuo-Llama-Med-Chinese

原名华佗(HuaTuo),是一个基于中文医学知识的LLaMA-7B微调模型,通过医学知识图谱和GPT3.5 API构建了中文医学指令数据集,在此基础上对LLaMA进行指令微调。

目前这个模型只开放针对"肝癌"单个疾病训练的模型参数,开发团队表示后期会针对“肝胆胰”相关16种疾病训练模型。

5.MathGPT 数学大模型

MathGPT是学而思自研,以数学领域的解题和讲题算法为核心的数学大模型,目前官方表示今年内将推出基于该自研大模型的产品级应用,可以等待一波。

另外还有DoctorGLM、ChatMed、Cornucopia等等医疗、金融、教育等领域的大模型,就不一一说说了,大家有觉得不错的可以在评论区分享!

关注下方《学姐带你玩AI》🚀🚀🚀

回复“大模型”获取必读论文+代码合集

码字不易,欢迎大家点赞评论收藏!