Python爬虫是指使用Python编写的程序,用来自动化地获取互联网上的数据。通过爬取网站的HTML内容,并解析和提取所需的数据,可以实现自动化地收集、分析和处理大量的在线数据。

学习Python爬虫需要掌握以下几个核心库:

Requests:用于发送、BeautifulSoup:用于解析HTML或XML文档,提取结构化数据。

Scrapy:一个功能强大的网络虫框架,可用于高效地爬取网站。

Selenium:一个自动化测试工具,也可用于爬取动态网页和处理JavaScript生成内容。

PyQuery:类似于jQuery语法的库,用于解析HTML文档和提取数据。

LXML:用于处理和解析HTML和XML文档的库,性能较高。

BeautifulSoup、Scrapy、Selenium和PyQuery这四个库常常一起使用以便更灵活、有效地进行网页爬取和数据提取。

此外,还可以了解其他相关库和工具,如Pandas(用于数据处理和分析)、NumPy(用于数值计算)和matplotlib这些库在整理和分析爬取到的数据时非常有用爬取数据必须遵守法律和道德规则,并尊重网站的服务条款。始终确保你的爬虫行为合法、友好且不会对网站造成负面影响。

学习python爬虫为什么需要库

Python爬虫需要使用库是因为:

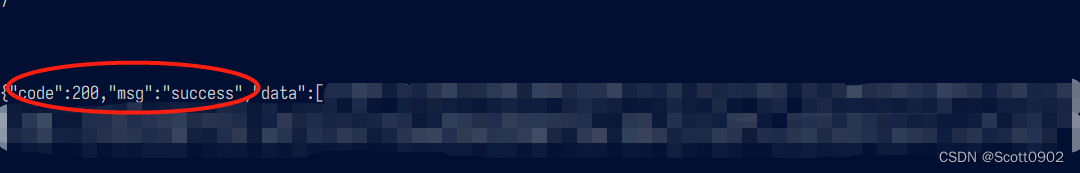

1、爬虫需要发送HTTP请求,获取网页内容,解析HTML或XML等数据格式,处理数据等操作。这些操作需要使用Python的一些基础库,如urllib、requests、beautifulsoup等。

2、爬虫需要处理大量的数据,需要使用一些高效的数据处理库,如pandas、numpy等。

3、爬虫需要处理一些复杂的数据结构,如JSON、XML等,需要使用一些专门的库,如json、xmltodict等。

4、爬虫需要处理一些图像、音频、视频等多媒体文件,需要使用一些专门的库,如Pillow、opencv-python等。

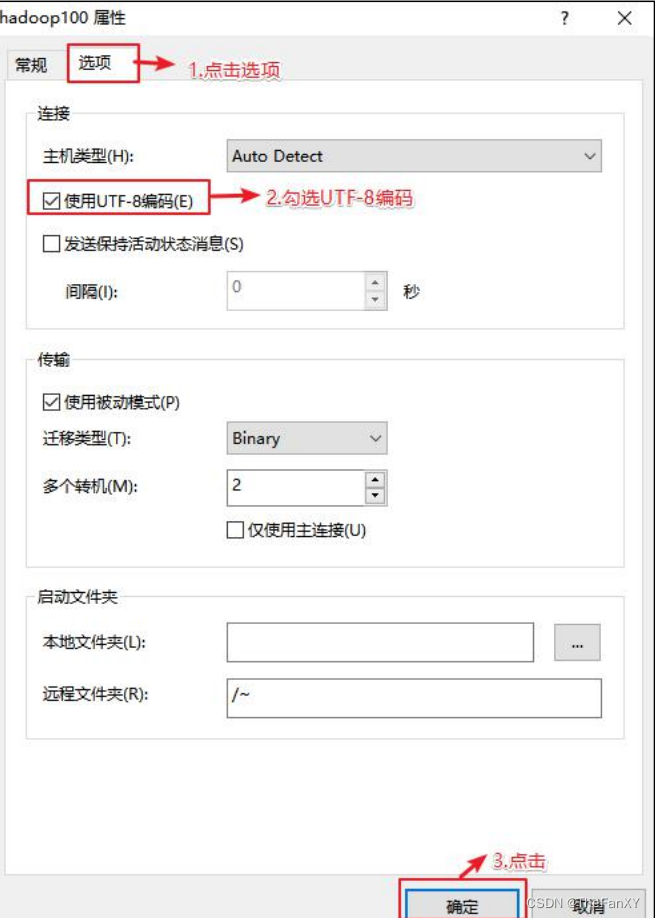

5、爬虫需要处理一些加密、解密、编码、解码等操作,需要使用一些专门的库,如hashlib、base64等。

综上所述,Python爬虫需要使用各种各样的库来完成不同的任务,这些库可以大大提高爬虫的效率和可靠性。

python爬虫库怎么学

学习Python爬虫库的步骤如下:

1、确定学习的目标:首先,明确学习爬虫库的目标。了解你希望爬取的数据类型和网站类型,这有助于确定选择哪些库进行学习。

2、学习基础知识:在开始学习具体的爬虫库之前,建议先掌握Python的基本语法和基础知识,例如变量、数据类型、条件语句、环和函数等,这将为学习爬虫库打下坚实的基础。

3、深入研究官方文档:针对选定的爬虫库,深入阅读官方文档是最全面、权威的学习资源。官方文档通常提供了完整的API参考、示例代码和使用说明,以便更好地理解库的用法和功能。

4、在线教程和学习资源:寻找优质的在线教程、博客文章、视频教程或网课等,以获取关于特定爬虫库的实际应用案例和技巧。这些资源可以通过搜索引擎或在线学习平台进行获取。

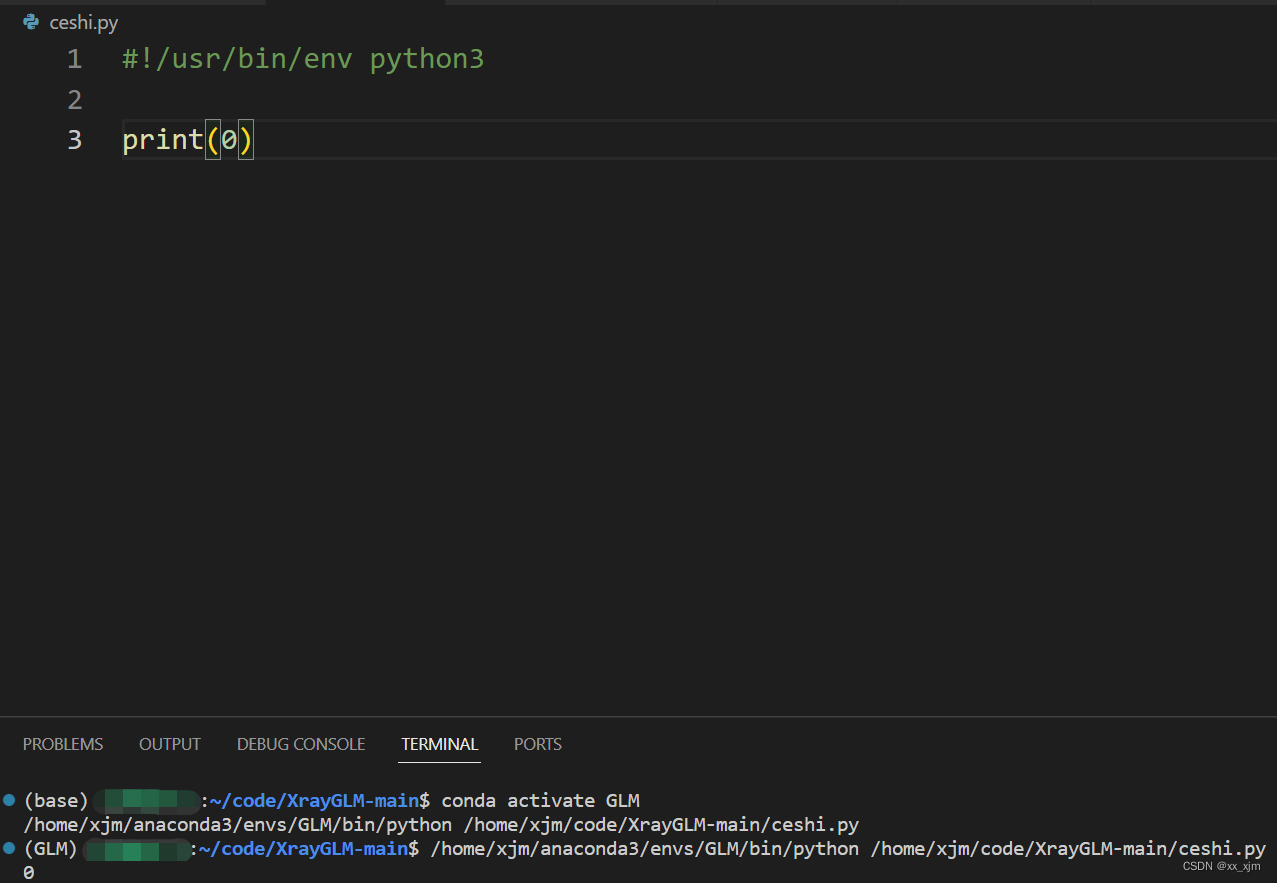

5、实践项目:尽可能多地进行实践。经过理论学习后,尝试编写小型的爬虫项目来巩固所学知识。简单的网页爬取、数据提取开始,逐渐挑战更复杂的任务,并尝试解决实际中的问题。

6、参与社区和讨论:加入相关的在线开发者社区、论坛或讨论组,与其他爬虫开发者交流经验、分享问题和解决方案。这可以帮助你扩展知识广度、获得额外的。

7、持续更新和学习:爬虫技术不断演进和更新,保持对新的库版本、技术趋势和最佳实践的关注。定期阅读相关的博客、新闻和文档,以保持学习状态并掌握最新的发展。

重要的是要通过实践来巩固所学的知识,并理解如何应用这些工具和库来解决实际问题。逐步积累项目经验,不断优化和提高自己的爬虫技术能力。