一、引言

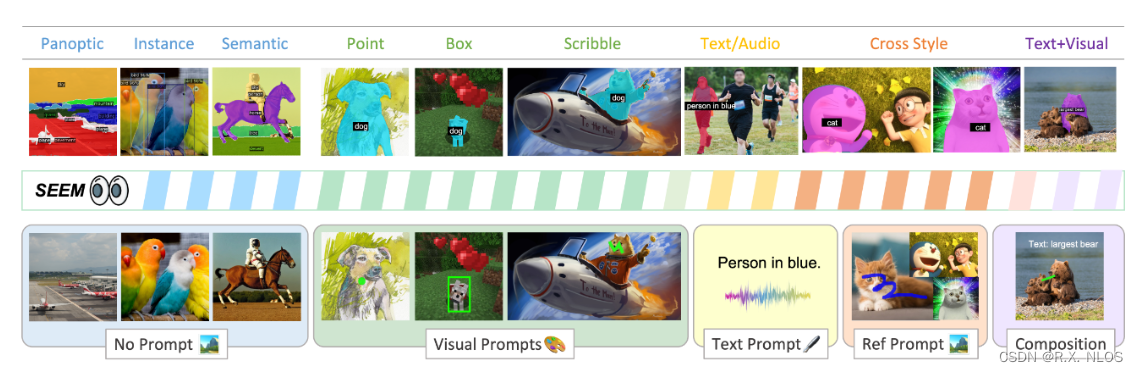

随着人工智能(AI)技术的快速发展,深度学习等算法在图像识别、自然语言处理、数据挖掘等方面表现出了强大的能力。而这些算法的底层计算,往往对硬件有着极高的要求。为了满足这些需求,越来越多的研究和工程实践开始尝试使用图形处理器(Graphics Processing Units,缩写:GPU)进行高速并行计算。那么,本文将通过对比CPU和GPU的特性,分析GPU的优势,并结合具体的实践案例,讨论为什么当前的AI领域对GPU有如此大的需求。

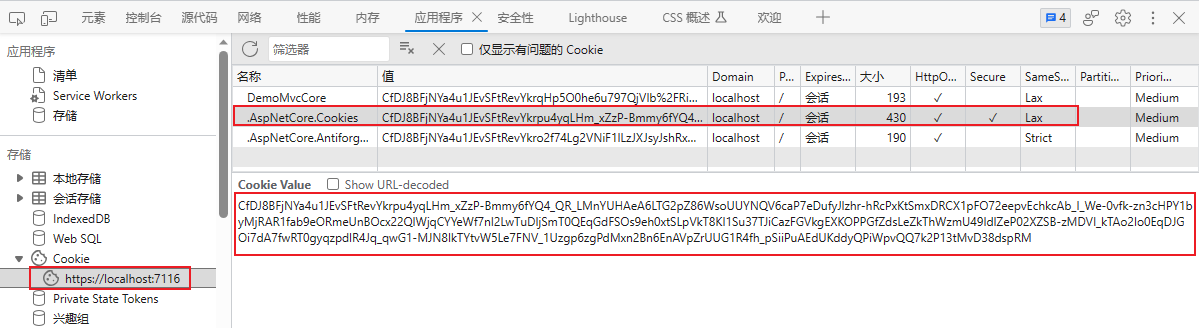

CPU 和 GPU 的本质区别

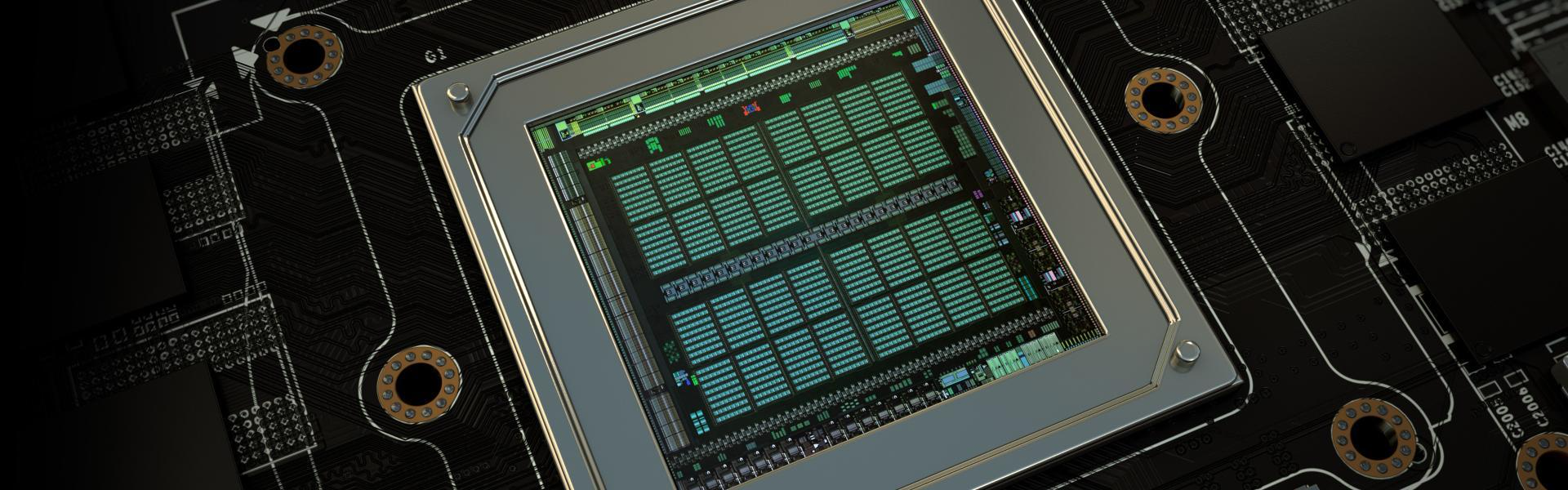

图形处理器(Graphics Processing Units,缩写:GPU)是一种专门为图形计算任务设计的处理器,其最初是为了解决3D图形渲染中计算量大、并行性好的问题而发展起来的。与中央处理器(Central Processing Units,缩写:CPU)相比,GPU具有更多的并行处理单元和更大的内存带宽,因此在执行大规模并行计算任务时具有明显的优势。简单来说,GPU的主要优势在于并行处理。

而CPU的主要优势在于串行处理。

从运作原理上来析CPU和GPU的的区别

CPU

-

结构:CPU通常具有多个核心,每个核心都是一个独立的处理器,能够执行多个线程。核心之间可以共享高速缓存,而且每个核心都具有比较大的缓存容量。而GPU由成千上万个处理器组成,这些处理器以“流处理器(Stream Processor)”为基本单位进行组织,形成一个高度并行的运算结构。流处理器通常组织成多个处理单元(如NVIDIA的SM,AMD的CU),而这些处理单元之间共享高速缓存。总体来看,GPU在硬件层面提供了更丰富的并行计算资源。

-

计算能力:CPU的设计重点是确保高性能串行计算,通过指令级并行、分支预测等技术来实现,同时也支持并行处理。而GPU则以大规模并行计算为核心,支持多线程(如NVIDIA的CUDA),为大数据量、复杂计算任务提供支持。

GPU

-

内存:GPU通常具有较大的显存,这使得它能够存储更多的数据,提高内存访问的带宽。而CPU的内存通常随着核心数量的增加而线性扩展,由于其主要用途不在并行计算,因此其内存容量相对较小。

-

功耗:CPU通常使用的是较高的功耗,目的是为了提高每个核心的运算性能。而GPU的设计更注重性能与功耗之间的平衡,尤其是在移动设备、数据中心等环境下,能效比(性能与功耗之比)对于GPU的成功应用具有关键意义。

为什么 AI特别喜欢要使用大量 GPU

AI领域尤其是深度学习算法的计算任务通常具有以下特点:大量的数据量,高度的并行性,复杂的计算过程,需要大量的计算资源。而GPU的特性恰好可以满足这些要求:

-

并行计算能力:深度学习算法中的矩阵运算、卷积操作等计算任务具有很高的并行性,而GPU可以通过多线程并行来处理这些任务。相比之下,CPU的并行计算能力有限,难以满足深度学习算法的需求。

-

内存带宽:深度学习算法需要处理大量的数据,因此需要高速内存来满足计算速度的要求。GPU具有较高的内存带宽,可以更快地完成数据的读取和写入,从而提高整体的计算速度。

-

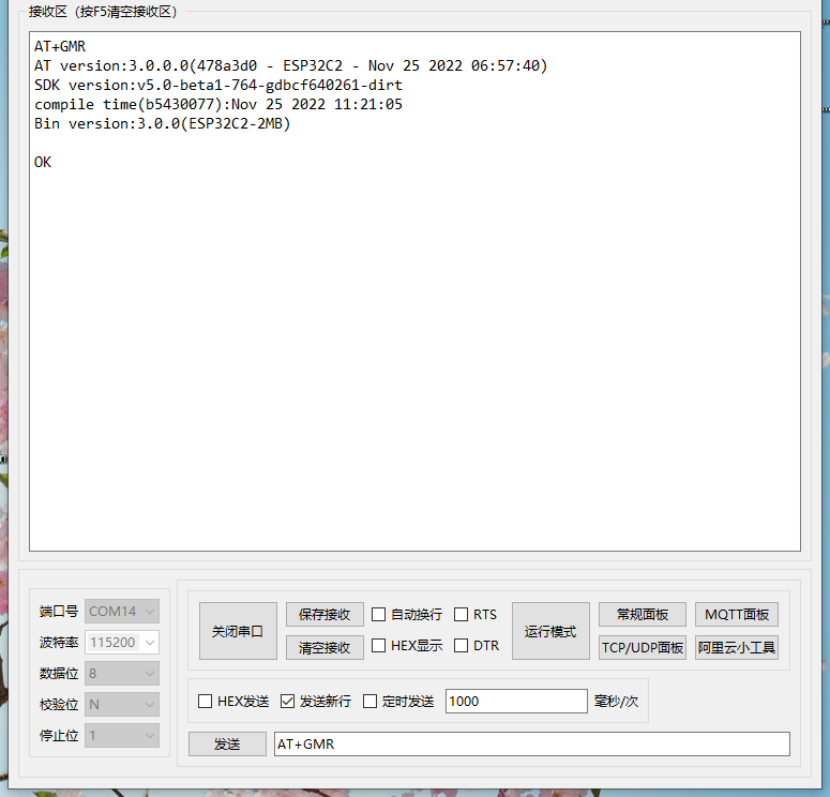

灵活性:GPU支持使用CUDA、OpenCL等编程框架和语言,这使得开发人员能够高度自定义GPU上的计算任务,为不同类型的AI算法提供支持。

通过以上分析,我们可以得出结论:GPU在处理AI相关算法时具有很大的优势,因此被广泛应用于深度学习、图像识别、自然语言处理等领域。

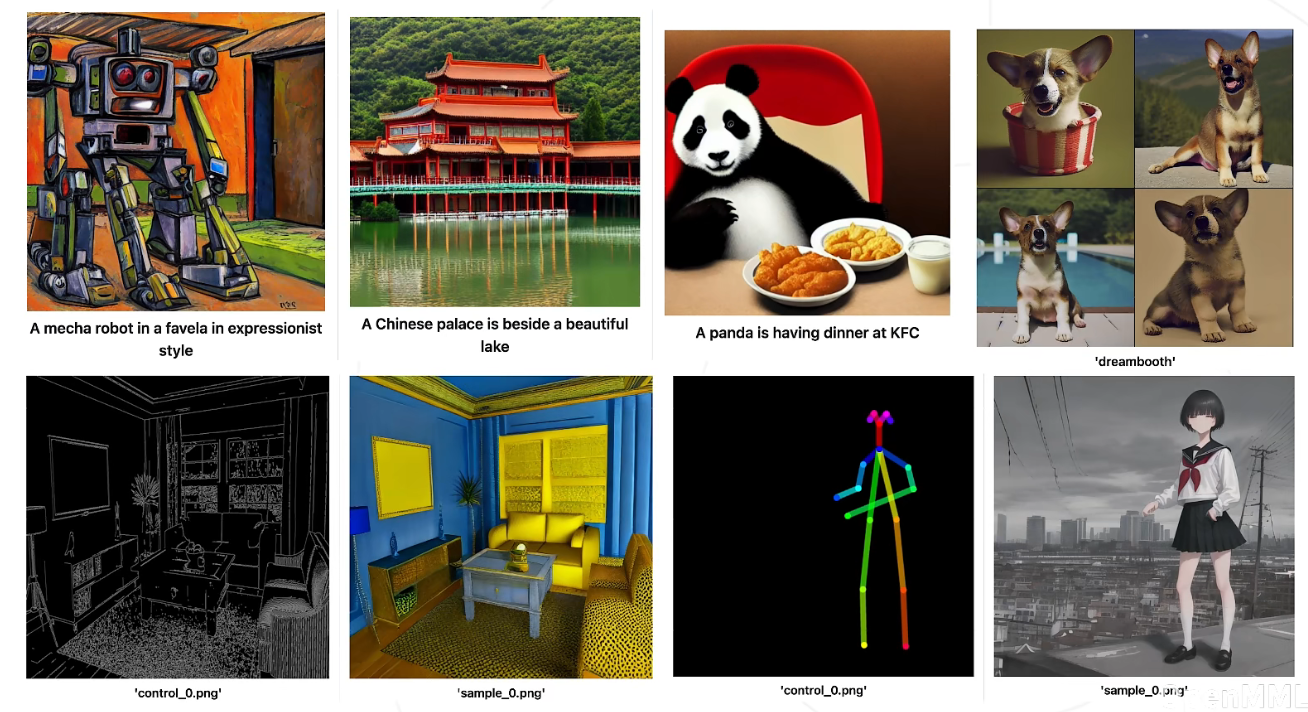

拿几个真实案例来分析CPU对比GPU在一些算力上的优劣

接下来我们结合实际的案例来说明何时使用CPU何时使用GPU以及二者之间的区别。

案例一: 图像识别

在图像识别领域,卷积神经网络(CNN)是一种常用的算法。基于NVIDIA Tesla K40 GPU和Intel Xeon E5-2690 v2 CPU的实验结果表明,在训练一个典型的卷积神经网络如AlexNet时,使用GPU可以比使用CPU提高10倍以上的速度。这是因为卷积操作本身具有很高的并行性,而使用GPU可以实现大规模的多线程并行处理。

案例二: 自然语言处理

自然语言处理(NLP)领域的深度学习模型往往涉及大量的矩阵运算。以BERT模型为例,使用NVIDIA Tesla V100 GPU与使用Intel Xeon Gold 6140 CPU进行训练对比,发现GPU训练的速度比CPU训练快30倍以上。这是因为矩阵运算在GPU中可以高度并行化。

案例三: 通用计算

一个密码学问题,需要进行大量的区间内整数因子分解。使用Intel Core i7-4770K CPU和NVIDIA GeForce GTX 780 Ti GPU进行相同的计算任务,发现GPU处理速度比CPU快约15倍。这种应用场景中,整数因子分解任务具有天然的并行性,因此GPU能够充分发挥其并行计算优势。

笔者的总结以及结合实际工作中给出大家的最佳实践建议

通过前文的分析,我们可以得出以下结论:

-

GPU在处理大规模并行计算任务时具有明显的优势,尤其是在深度学习、图像识别等AI领域能够发挥其强大的计算能力。

-

需要按照实际计算任务的要求选择CPU和GPU。在某些具有高度并行性的任务中,使用GPU可以显著加速计算进程;而在某些串行任务中,使用CPU可能更加合适。

结合实际案例给出的最佳实践建议如下:

-

对于具有高度并行性的任务,优先考虑使用GPU进行计算,并最大限度地利用其并行计算能力。

-

在实际应用中,应尽量优化计算任务,例如在图像识别中通过降低图片分辨率、减少参数数量等方法降低计算复杂度,以提高GPU的计算效率。

-

合理使用编程框架和语言,例如CUDA、OpenCL等,来实现GPU与CPU的协同计算,提高整体计算效果。

-

在选择硬件时,应充分考虑应用场景、计算需求、成本等因素,进行权衡和选择,从而达到性能和功耗之间的最佳平衡。

通过以上文章的阐述,可以看出GPU在AI领域发挥了巨大的作用。但是,我们也必须看到CPU的重要性。未来随着硬件技术的不断发展,CPU与GPU在AI领域的发展必将持续深化与优化,实现更出色的计算性能和能效比。