HTAP

- HTAP技术

- 传统的HTAP解决方案

- HATP的要求

- TiDB的HTAP架构

- TiDB的HTAP特性

- 使用场景

- MPP

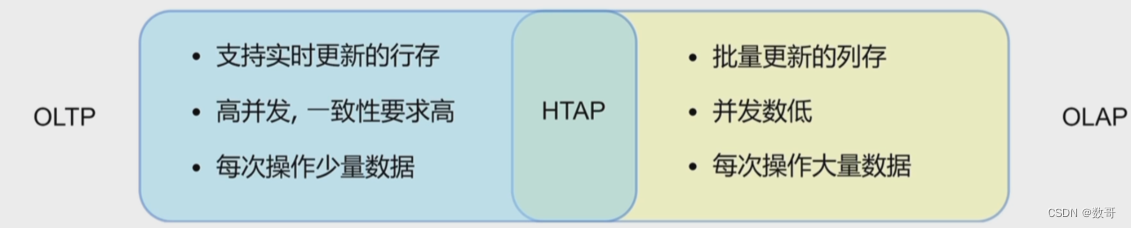

HTAP技术

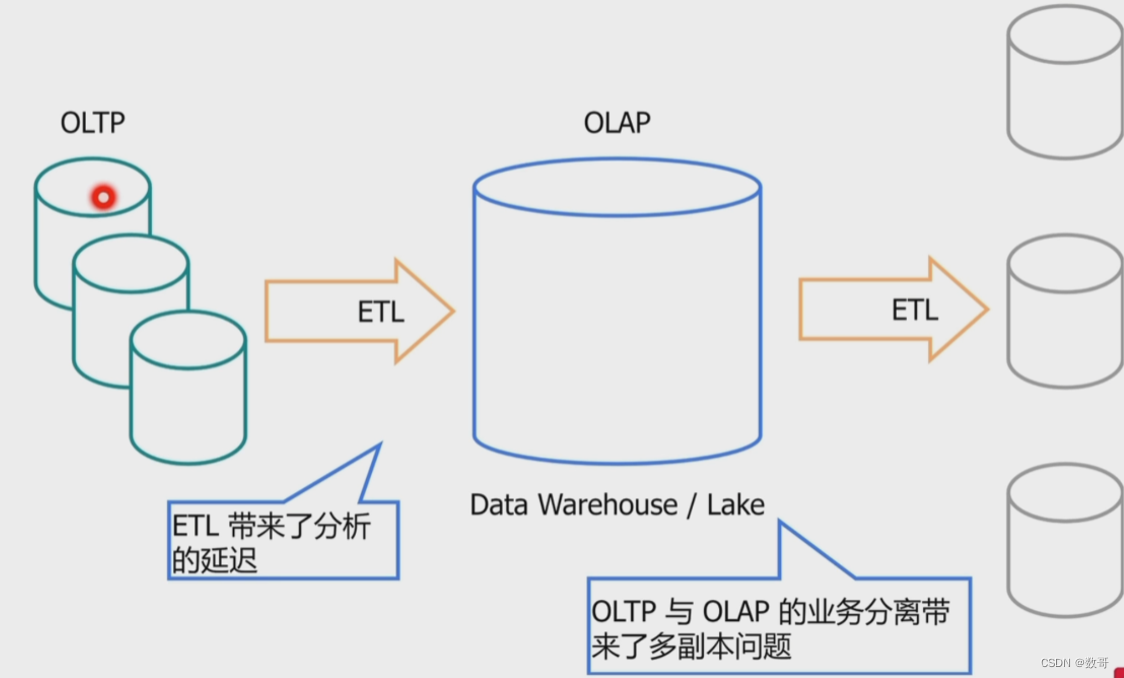

传统的HTAP解决方案

HATP的要求

- 可扩展性

- 分布式事务

- 分布式存储

- 同时支持OLTP与OLAP

- 同时支持行存和列存

- OLTP与OLAP业务隔离

- 实时性

- 行存与列存数据实时同步

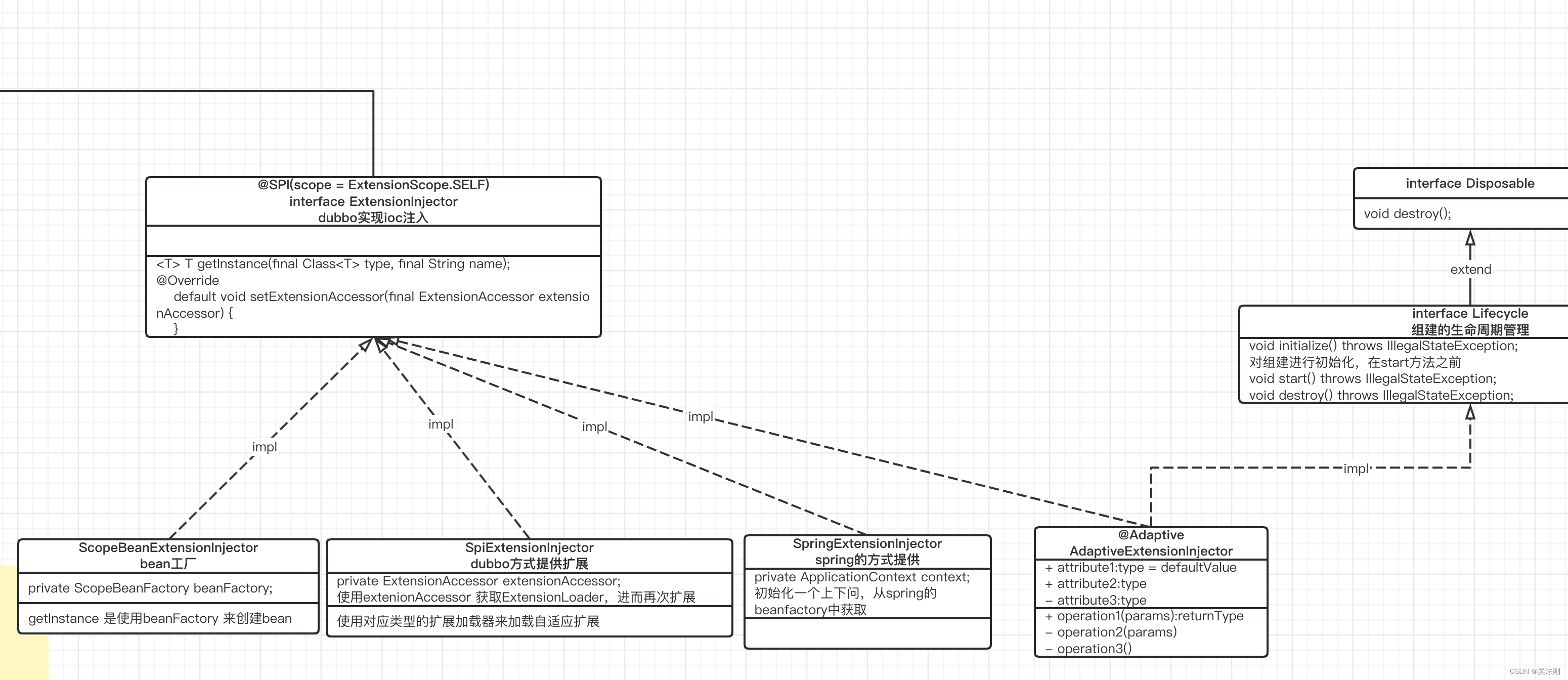

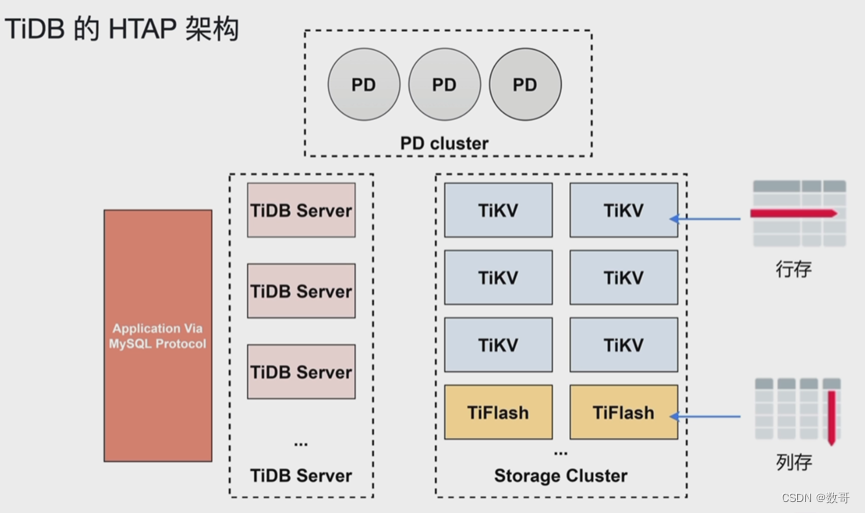

TiDB的HTAP架构

数据存到TiKV的同是也会同步(也是使用raft算法,并且它不参与选举,只用于同步)到TiFlash,并且是它是列式。列式的意思就是数据块当中存的不是一行数据,而是一列的数据。

对于数据一致性要求的查询,会去到TiKV当中(行存)处理数据。例如银行转账

对于某列的数据大量更新,则会去到TiFLASH当总(列存)处理数据。

TiDB的HTAP特性

- 行列混合

- 列存(TiFlash) 支持基于主键的实时更新

- TiFlash作为列存副本

- OLTP与OLAP业务隔离

- 智能选择(CBO自动或人工选择)

- MPP架构

- 强一致性,自动同步

MPP: 大规模平行并发处理。 它在TiFLASH中处理。

使用场景

HTAP—— TiDB 在线事务与在线分析处理 (Hybrid Transactional and Analytical Processing,HTAP) 功能。

TiDB HTAP 可以满⾜企业海量数据的增产需求、降低运维的⻛险成本、与现有的⼤数据栈⽆缝缝合,从⽽实现数据资产价值的实时变现。

以下是三种 HTAP 典型适⽤场景:

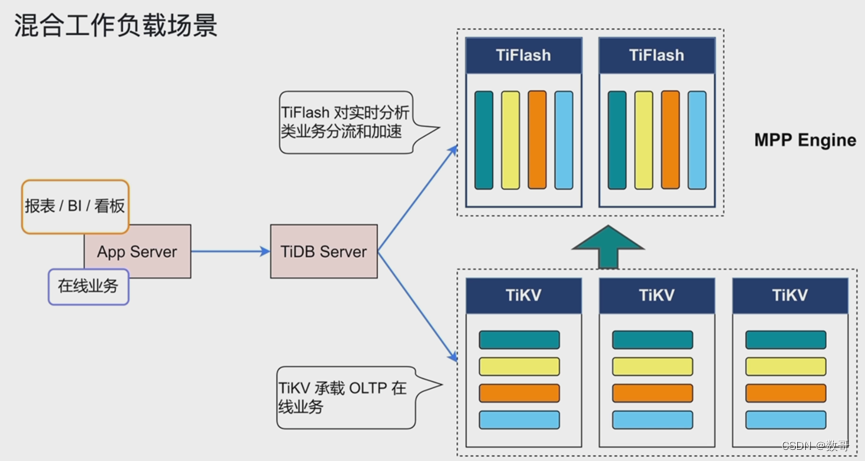

- 混合负载场景

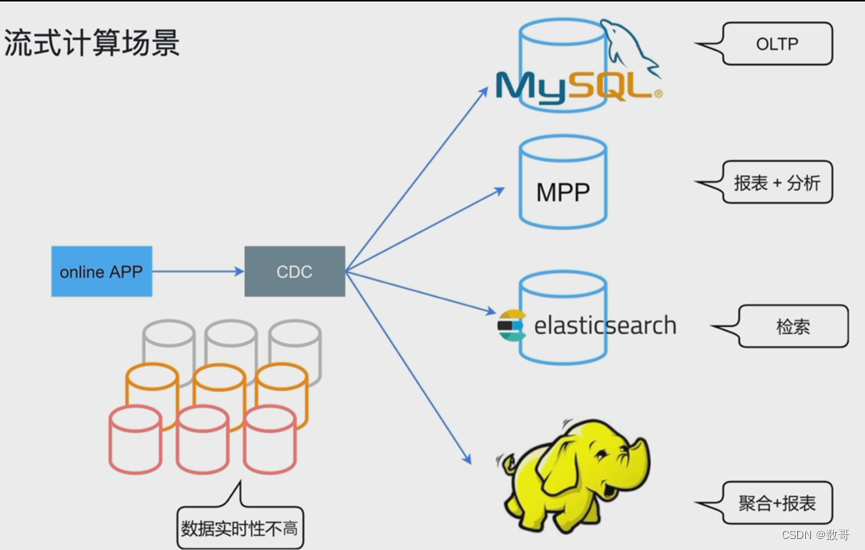

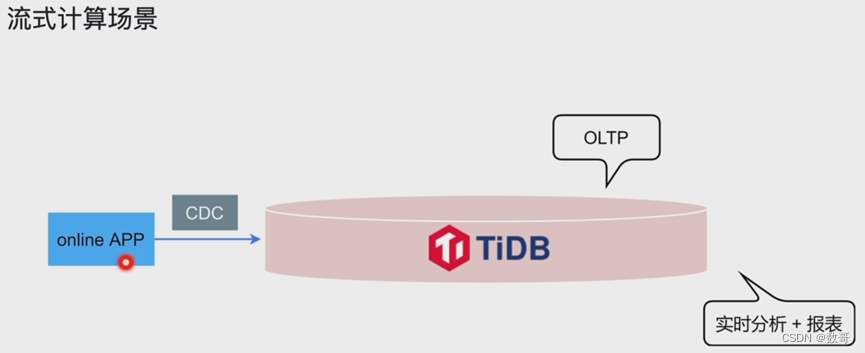

当将 TiDB 应⽤于在线实时分析处理的混合负载场景时,开发⼈员只需要提供⼀个⼊⼝,TiDB 将⾃动根据业务类型选择不同的处理引擎。 - 实时流处理场景

当将 TiDB 应⽤于实时流处理场景时,TiDB 能保证源源不断流⼊系统的数据实时可查,同时可兼顾⾼并发数据服务与 BI 查询。 - 数据中枢场景

当将 TiDB 应⽤于数据中枢场景时,TiDB 作为数据中枢可以⽆缝连接数据业务层和数据仓库层,满⾜不同业务的需求。 - 大数据量

⼤数据场景 (100 T) ,推荐使⽤ TiFlash MPP 作为 HTAP 的主要⽅案,TiSpark 作为补充⽅案。

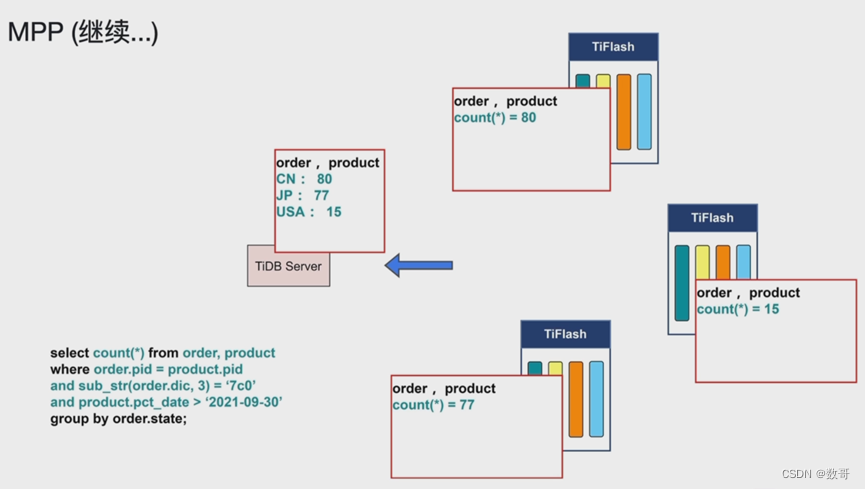

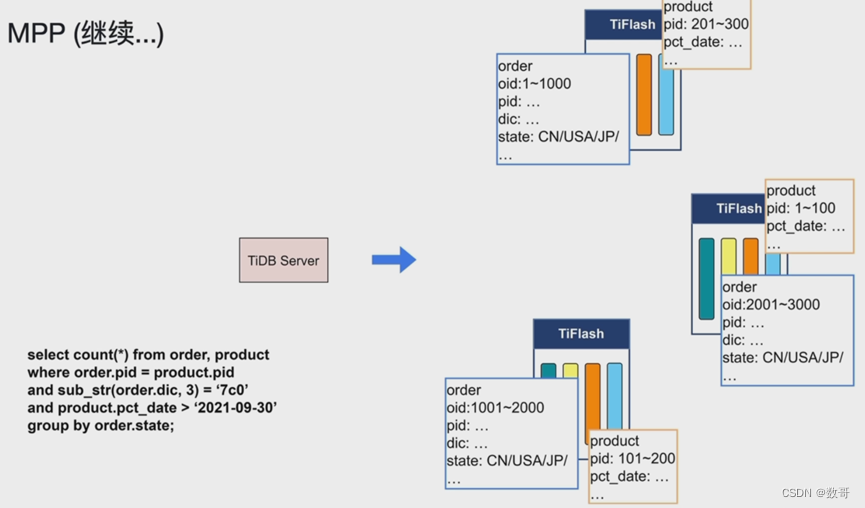

MPP

- 大量数据的join聚合查询

- 所有MPP计算都在TiFlash节点内存中完成

- 目前只支持等值连接

- Enforce_mpp 帮助验证是否可以使用MPP

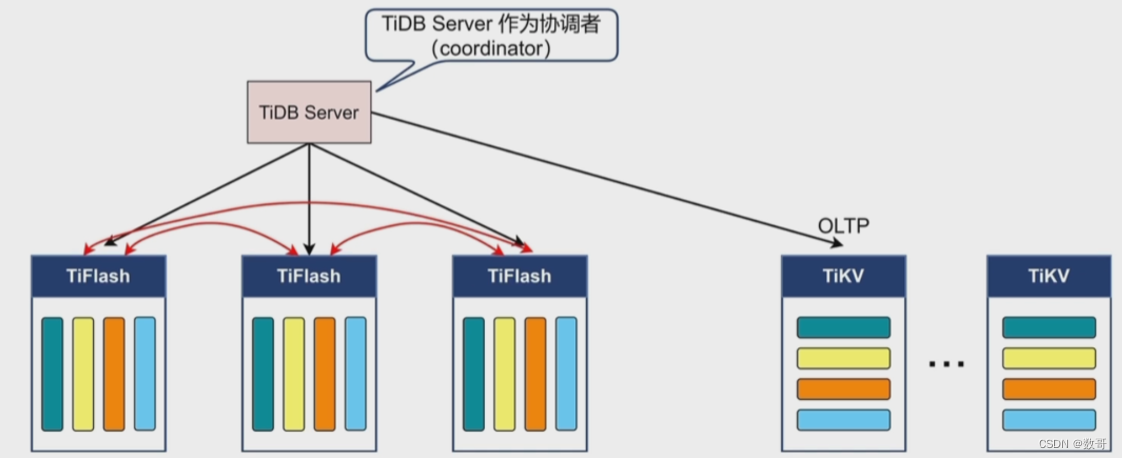

实现了聚合和连接的一个加速。MPP只在TiFlash上完成。

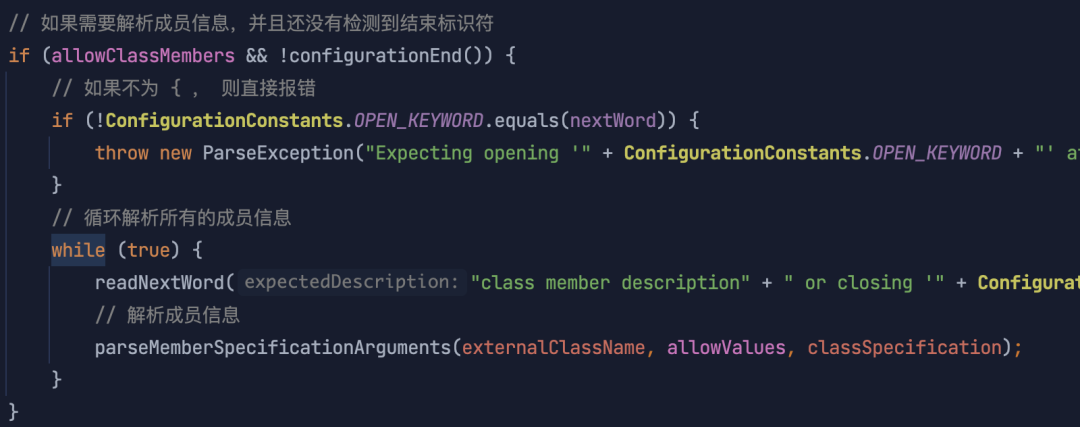

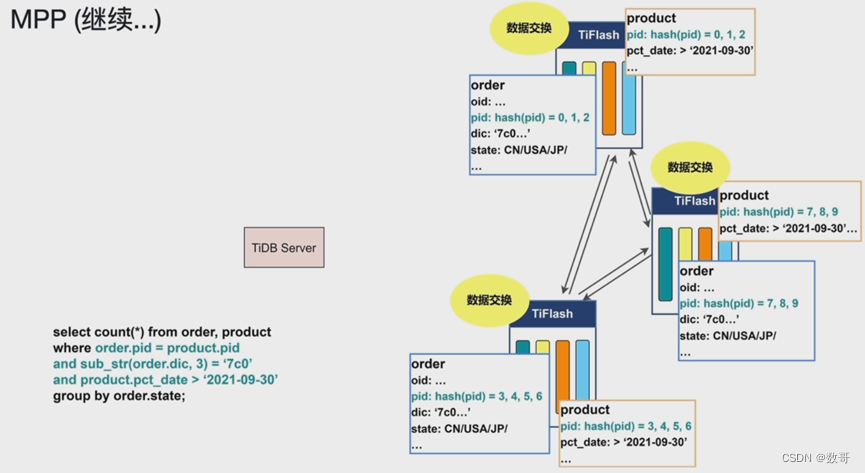

SQL过来,TiDB Server作为协调者,Tidb 会将每个TiFLASH 上面的列存做交换,交换后让表连接需要的数据只在一个TiFLASH上。(不会跨TiFlash做表连接)

另外TiFlash也会走计算下推到它,例如过滤,交换,连接,聚合等等。

每个TiFlash 在这里还有个专用名称(MPP WORKER)

先做过滤

然后数据交换

让pid相等(符合条件)的数据 都到一个节点上来。 这样在连接的时候,就只需要在本节点连接即可。

pid:hash(pid) = 0,1,2 : 假设分片的时候是按照hash或者求模的方式操作。 数据交换也可以根据对应的规则进行交换。

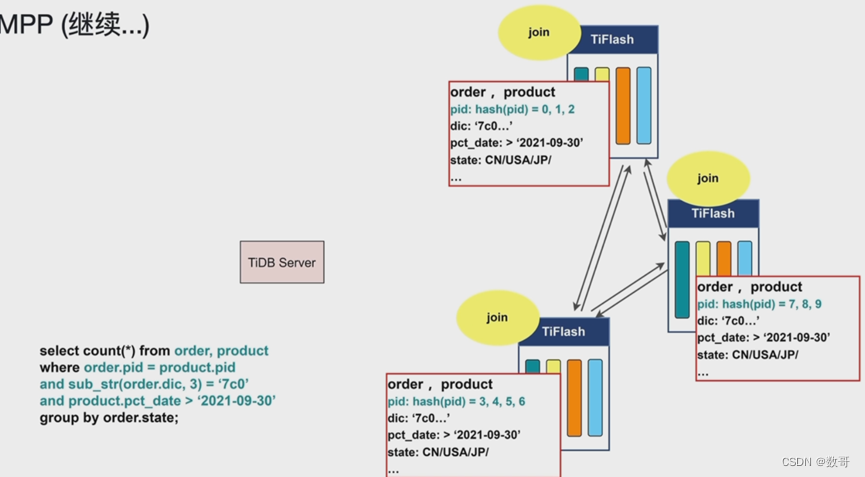

然后做连接的时候,只发生在本节点,不需要到其他节点查找数据,这样就可以并行执行了。

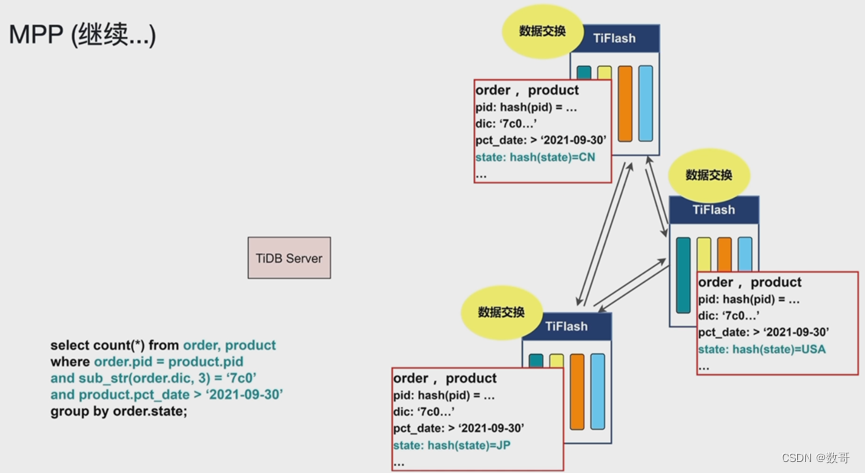

那如何对聚合做提速?

group by order.state 提速

state = cn 80个 的全放到一个TiFlash USA 15个 放到一个节点 Jp 77个都放到一个节点,

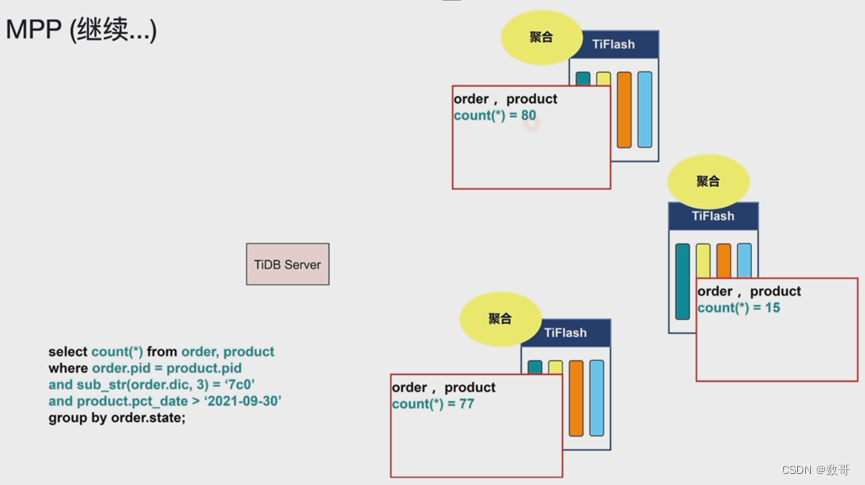

这个计算就下推到每个TiFLASH上。