本文重点

学习率是梯度下降算法中的一个重要参数,它控制着每次迭代中参数的更新幅度,因此学习率的大小直接影响着算法的收敛速度和精度。在实际应用中,如何选择合适的学习率是一个非常重要的问题。

手动调整法

最简单的方法是手动调整学习率。我们可以根据经验或者试错的方式来选择一个合适的学习率。通常来说,学习率的初始值可以设置为一个比较小的值,例如0.01或者0.001,然后根据模型的训练情况逐步调整学习率的大小。

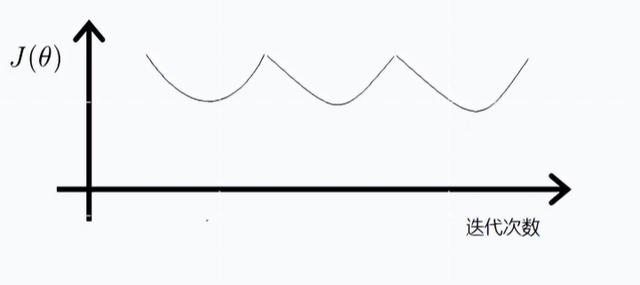

如果发现模型的损失函数在训练过程中波动较大或者无法收敛,就可以尝试降低学习率;如果发现模型的收敛速度过慢,就可以尝试增加学习率。这种方法的优点是简单易行,但是需要大量的试错和经验积累,比较耗费时间。

学习率衰减

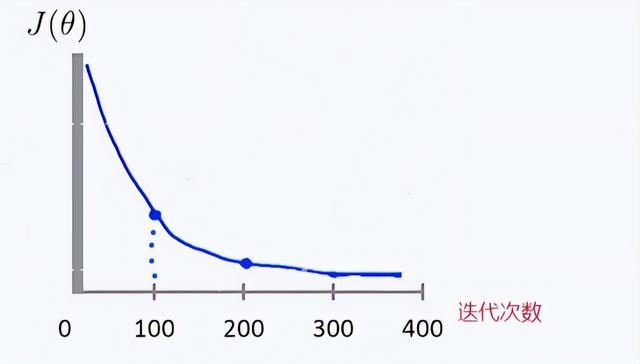

学习率衰减是一种常用的学习率调整方法,它可以在训练过程中逐步降低学习率的大小,从而使得模型更加稳定和收敛。这样的模型训练是有很大的好处的,比如开始训练的时候,学习率大一些,相当于下山速度快一些,模型训练速度快,随着训练的进行,模型的学习率逐渐变小,可以使得模型不会跨过局部最小值,能够更快的收敛。

常见的学习率衰减方法包括指数衰减、余弦衰减、多项式衰减等。以指数衰减为例,其更新公式为:

![[冷冻电镜]IMOD使用指南](https://img-blog.csdnimg.cn/3beb3da0651a4797ae9bc5e26f4b4c8e.png)

![[PyTorch][chapter 40][数据增强]](https://img-blog.csdnimg.cn/bd671d65e220400fab39371017cc9c7b.png)