11.1 降维

降维的两种应用:一是数据压缩;二是可视化数据。

11.1.1 数据压缩

将相关性强的两个特征导致冗余,可以直接去掉其中一个特征,或者将两个特征进行某种转换,得到一个特征。

11.1.2 可视化数据

直接看数据可能看不出什么现象出来

但是通过图来进行对比,按照GDP或者是其他标准来看,会更明显。

11.2 主成分分析(PCA)

假设我们有一个二维的样本x数据集,当我们向对数据进行降维从二维到一维,也就是想到找一条能够将数据投影成一条直线。PCA会找一个低维得平面,刚刚的假设例子是一条直线,然后将数据投影在上面使这些蓝色小线段长度(有时也叫投影误差)平方最小,PCA要做的就是找到一个投影平面对数据进行投影使得能最小化这个距离。

主成分分析(PCA)是一种数据压缩的算法,他将数据压缩到k维度,并使得所有数据投影到新维度的距离最小。在应用PCA之前,常规的做法是先进行均值归一化和特征常规化,使得特征得均值为0并且其数值在可比较范围之内。

PCA做的就是,对于二维降到一维:要试着找到一个向量,假设是(

),要找一个数据投影后能够最小化投影误差的方向,在这个例子里,希望PCA能找到这个向量

。当把数据投影到

存在的这条直线上时,就会得到非常小的重构误差(如上图所示)。

对于N维降到K维:我们要找的就不是单个向量来对数据进行投影二是想寻找K个方向来对数据进行投影来最小化投影误差。

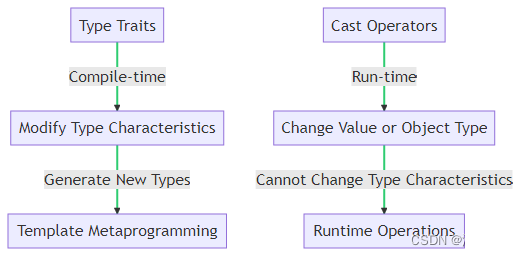

PCA不是线性回归,一个是投影距离,一个是点与直线上点的距离。

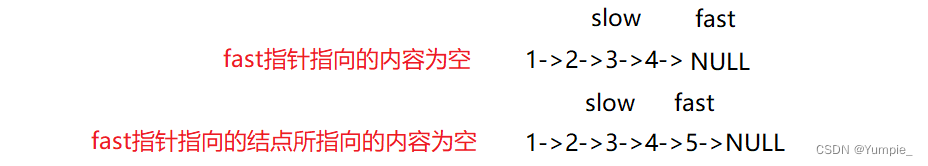

下图的左边部分表示线性回归,当我们处理线性回归时,给定某个输入的特征量x来预测出某变量y的值。所以在线性回归中,我们要做的就是拟合一条直线来最小化点和直线之间的平方误差,要最小化的是图中蓝线之和的平方。下图的右边部分表示PCA,在处理PCA中,它要做的是试图最小化这些蓝色直线的长度(是他们最短的正交距离)。线性回归垂直x轴,求预测与实际y差;而PCA是垂直于拟合线,求正交距离。

并且线性回归是用所有的x来预测y,在PCA中没有区别对待,没有什么特殊的变量y需要预测,相反我们有一系列特征都是同等对待。

PCA执行过程:首先对数据预处理,进行均值归一化(可能也要进行特征缩放),然后计算协方差,最后得到一个k维的矩阵。

首先对数据进行均值归一化,然后确定要压缩的目标维度,即对应向量的个数,PCA的目标是使得所有数据距离新维度的距离最小。

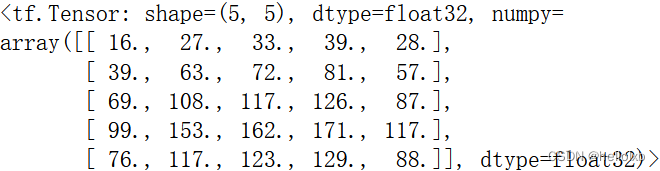

将n维降到k维,下面是过程:

在进行数据预处理后,首先计算协方差(covariance matrix)Sigma是nxn的矩阵, 再进行特征缩放。

11.3 压缩重现

怎么样把降维的数据再重现回去?

(这里反求的x是近似的)

11.4 确定维度K

为了选择k也就是主要成分的数量,这里有一些有用的概念。

PCA所做的是尝试使得这个式子最小化,这就是平均平方差投影误差。训练集数据的总方差:

(所有训练实例的范数得平均值)。也就是说,它代表了我的数据点与(0,0)点平均有多远。当我们选择k时,我们要取得最小值的k,使得下图的不等式小于等于0.01。

选择k使得平均投影平方误差(分子)除以总方差(分母),也就是代表数据波动有多大。这里的0.01,用术语说就是保留99%的方差特性,也就是降维后保留的数据量要占到原数据的99%以上。variance在这里不应该理解成为方差而是差异,PCA其实是保留差异的分量,将具有相关性。可能95%到99%是最常使用的数值。因为很多数据特征相关,所以降维依然可以保留95%以上的特征。

实现这一点的步骤如下:

如果你想要k的值,让k=1,执行PCA算法,计算下面这些变量的值,然后检查下面不等式是否满足小于等于0.01,如果不成立继续让k=2,k=3,k=4...;如果成立就选择k=1。但是这样做效率不高。

可以使用PCA运算中已经写好的svd分解函数,调用svd,通过Sigma参数,得到U,S,V三个参数。其中,S矩阵是一个对角阵。并且可以证明对于给定的k,将变换成

这样计算,接下来要做的就是验证它是否小于等于0.01,或者验证

是否大于0.99。

11.5 PCA的应用

如果直接再交叉验证集和测试集上用PCA会过拟合,所以只能用训练集降维矩阵去给测试机和交叉验证集做映射,不能另外在上面做PCA。

PCA的应用:首先它能进行数据压缩,其次可以使用PCA去加速学习算法以及可视化。

PCA不能防止过拟合!过拟合是由于某些异常数据的影响而产生的,通过主成分分析只能去除异常数据内部的一部分噪音,并不能把异常数据本身从数据集中去除,异常数据在投影面上的异常性还是存在。解决过拟合的好方式使用正则化。

PCA有时候会丢失一些重要的数据信息,这样训练出来的模型性能会减弱,除非数据太大或者算法太慢才会考虑PCA。