Python中的中文分词神器——jieba

介绍

如果你曾经在处理中文文本时,也许会遇到中文分词的需求,jieba就是一款不可错过的工具。

jieba 是目前最好的 Python 中文分词库,它具有高效、简单和可定制等优点,适合各种规模的文本分词任务。

安装

在安装 jieba 之前,需要先确保已经安装了 Python 开发环境和 pip 工具(如果已经安装过了,可以跳过该步骤)。

使用 pip 直接安装 jieba:

pip install jieba

如果你已经克隆了 jieba 代码,可以运行 setup.py 进行安装:

python3 setup.py install

使用

基本分词

使用 jieba.cut 方法对原始文本进行分词,得到的是一个可迭代的分词结果。

import jieba

seg_list = jieba.cut("我来到北京清华大学")

print("Full Mode:", "/ ".join(seg_list)) # 全模式分词

输出结果:

Full Mode: 我/ 来到/ 北京/ 清华/ 清华大学/ 华大/ 大学

其中 cut 方法默认使用全模式分词,可选的分词模式包括:

- 精确模式,即

jieba.cut(str, cut_all=False); - 全模式,即

jieba.cut(str, cut_all=True); - 搜索引擎模式,即

jieba.cut_for_search(str)。

添加用户词典

如果你需要对特定的文本进行分词,可以先添加自定义词典,jieba 会优先使用自定义词典中的分词结果。

import jieba

# 添加自定义词典

jieba.load_userdict(file_name)

seg_list = jieba.cut(text)

print("Full Mode:", "/ ".join(seg_list))

提取关键词

使用 jieba.analyse 模块可以对文本进行关键词提取,常用的方法有:

- 基于 TF-IDF 算法的关键词提取;

- 基于 TextRank 算法的关键词提取。

from jieba import analyse

# 基于 TF-IDF 算法的关键词提取

keywords = analyse.extract_tags(text, topK=20, withWeight=True)

# 基于 TextRank 算法的关键词提取

keywords = analyse.textrank(text, topK=20, withWeight=True)

结论

总的来说,jieba 是一款非常优秀的中文分词工具,它能够快速、准确地完成中文文本的分词任务。在实际使用中,我们可以根据具体的需求,使用不同的分词模式,并添加自定义词典以提高分词效果。

最后的最后

本文由chatgpt生成,文章没有在chatgpt生成的基础上进行任何的修改。以上只是chatgpt能力的冰山一角。作为通用的Aigc大模型,只是展现它原本的实力。

对于颠覆工作方式的ChatGPT,应该选择拥抱而不是抗拒,未来属于“会用”AI的人。

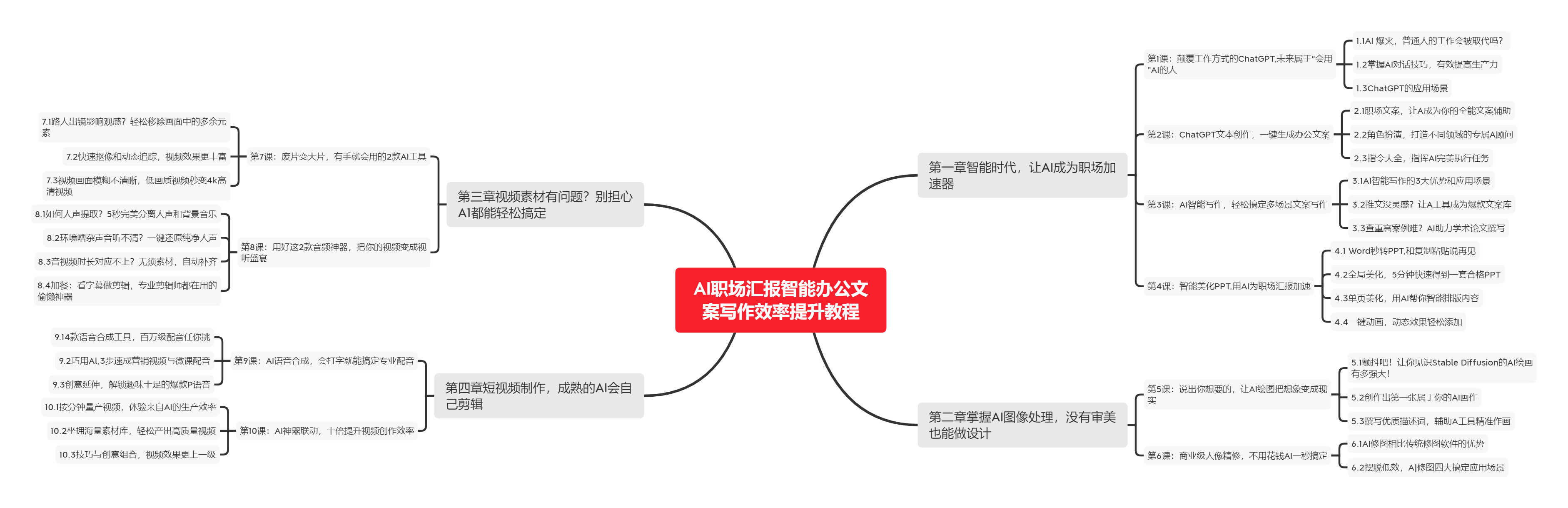

🧡AI职场汇报智能办公文案写作效率提升教程 🧡 专注于AI+职场+办公方向。

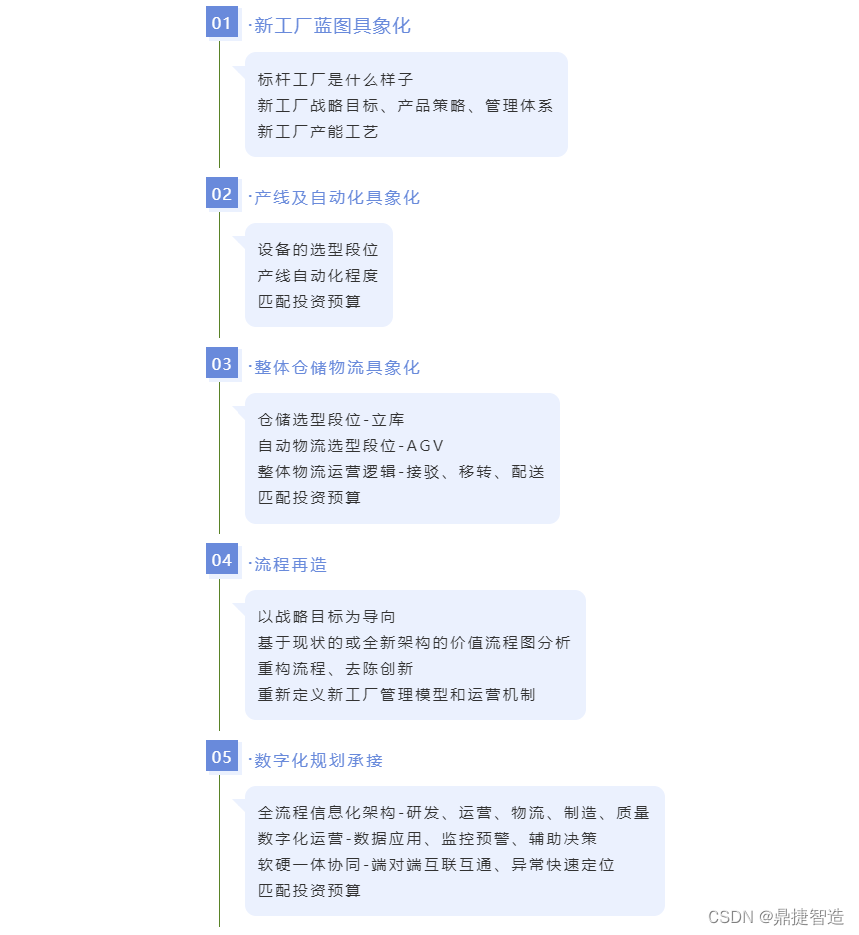

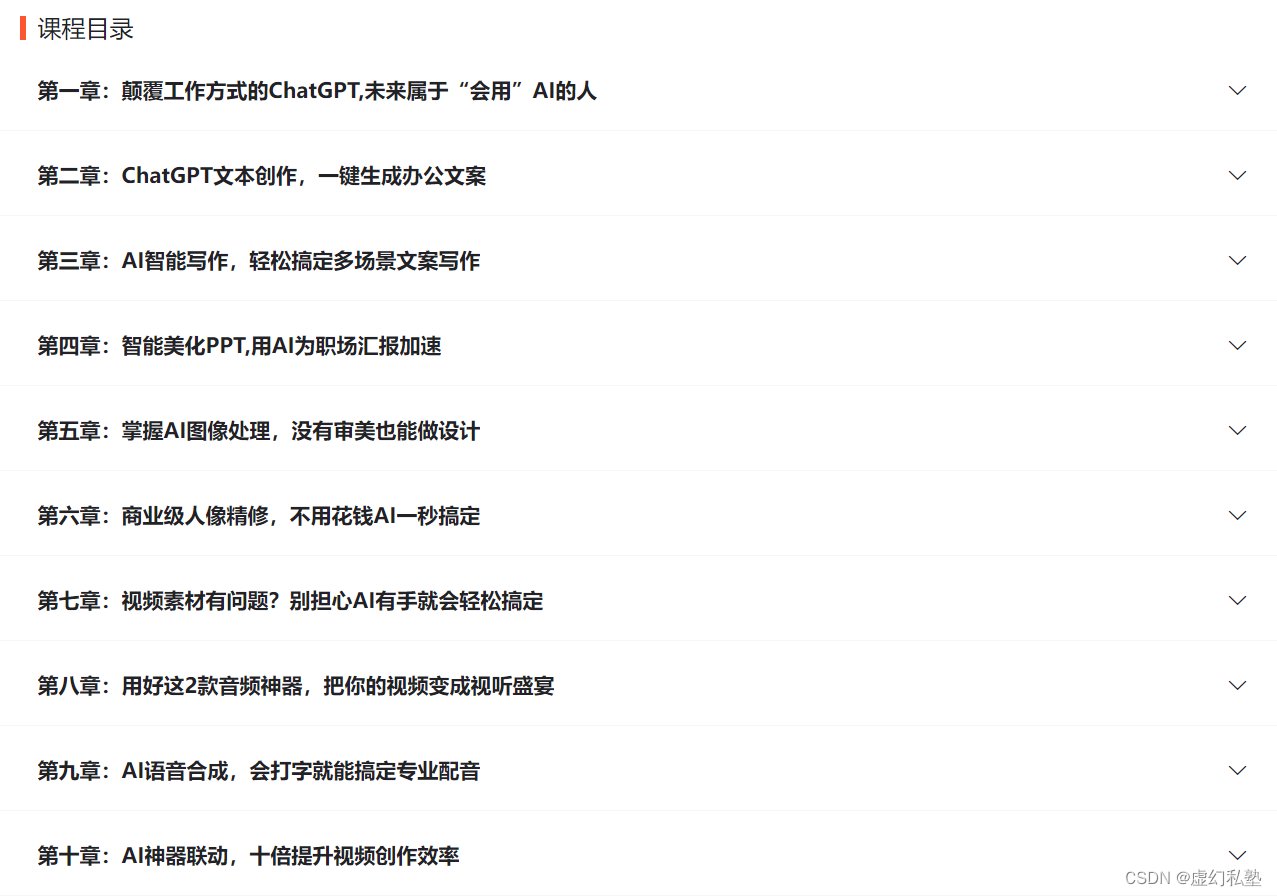

下图是课程的整体大纲

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具

🚀 优质教程分享 🚀

- 🎄可以学习更多的关于人工只能/Python的相关内容哦!直接点击下面颜色字体就可以跳转啦!

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| 🧡 AI职场汇报智能办公文案写作效率提升教程 🧡 | 进阶级 | 本课程是AI+职场+办公的完美结合,通过ChatGPT文本创作,一键生成办公文案,结合AI智能写作,轻松搞定多场景文案写作。智能美化PPT,用AI为职场汇报加速。AI神器联动,十倍提升视频创作效率 |

| 💛Python量化交易实战 💛 | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

| 🧡 Python实战微信订餐小程序 🧡 | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |