根据知乎问题 有没有什么可以节省大量时间的 Deep Learning 效率神器? 的回答,筛选整理出一些深度学习科研神器。包括参数优化、数据可视化、模型部署蒸馏剪枝等。收录到

人工智能-深度学习-科研神器推荐![]() https://www.webhub123.com/#/home/detail?p=4OtWv-Rmw1

https://www.webhub123.com/#/home/detail?p=4OtWv-Rmw1

收录效果如下

登录后点击右上角加号+ 可一键保存全部网址到我的收藏,可以完全自由免费的管理超过20000多个网址。目前已经收录4200+ 精品网址,涵盖娱乐、工具、科研、数据集、论文、博客、公众号好文等各类网址。全部都可一键收藏,层次化分级管理所有网站收藏

使用fitlog 辅助 fastNLP 进行科研 figlog原本是作为fastNLP的一部分开发,后来分为一个单独项目。fitlog是架构无关的,不管tensorflow还是pytorch都可以使用,不管是cv还是nlp也都支持。如果是NLP的任务,配合fastNLP框架,只需要增加三五行代码便可以实现metric,loss的自动记录。

GitHub - wandb/wandb: 🔥 A tool for visualizing and tracking your machine learning experiments. This repo contains the CLI and Python API. 每个实验要保存对应的log,training curve还有生成图片等等,光这些visualization就需要写很多重复的代码。跨设备的话还得把之前实验的记录都给拷到新设备去。wandb只要几行代码就可以把每一次实验打包保存在云端,而且提供了自家的可视化接口,不用每次都自己写一个logger,也省掉了import matplotlib, tensorboard等一大堆重复堆积的代码块。

Acronymify! - Automatically generate fun acronyms for your project 主要是发论文时给模型取各种炫酷的名字。

Mathpix: Document cloud for research 手写/截图 转 LaTex公式

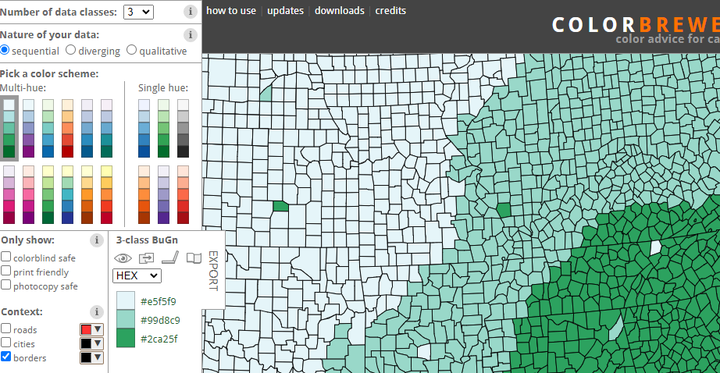

Color Advice for Maps 配色网站,红绿色盲友好。有时候画图的时候需要配色,这个可以帮下忙

Papers with Code - The latest in Machine Learning 搞深度学习不知道这个网站算是白搞了,论文、代码全收录。与Github同级的存在

GitHub - parrt/tensor-sensor: The goal of this library is to generate more helpful exception messages for matrix algebra expressions for numpy, pytorch, jax, tensorflow, keras, fastai. 在包含多个张量和张量运算的复杂表达式中,张量的维数很容易忘了。即使只是将数据输入到预定义的 TensorFlow 网络层,维度也要弄对。当你要求进行错误的计算时,通常会得到一些没啥用的异常消息。为了帮助自己和其他程序员调试张量代码,Terence Parr 写了一个名叫 TensorSensor 的库(pip install tensor-sensor 直接安装) 。TensorSensor 通过增加消息和可视化 Python 代码来展示张量变量的形状,让异常更清晰

Clarifying exceptions and visualizing tensor operations in deep learning code 这个是解释怎么用Tensor-tensor的

OmegaConf - OmegaConf 2.3.0 documentation OmegaConf是Meta出的配置管理工具,可将yaml文件转成有对应变量名的Python的class或dict。支持默认值、合并和override、导出成yaml或json等,十分好用。你再也不用手写配置管理了。

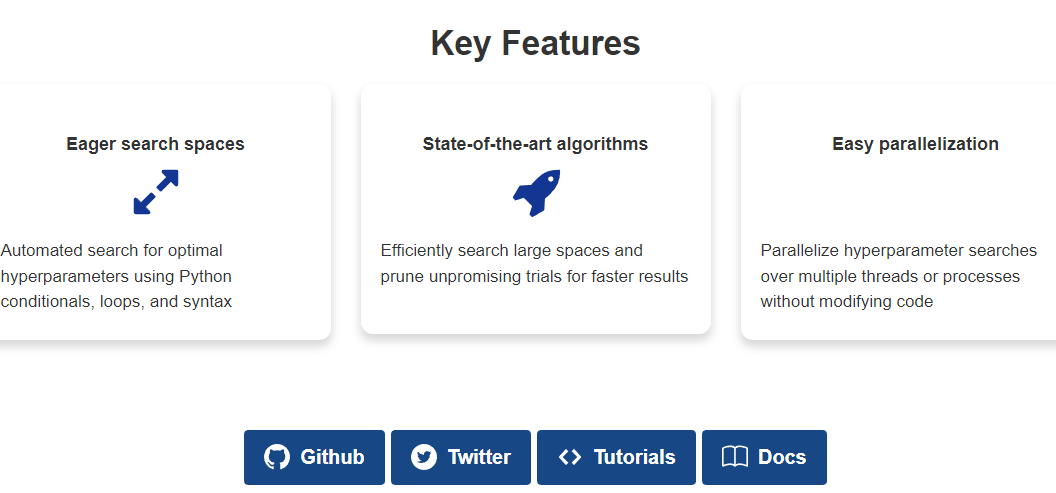

Optuna - A hyperparameter optimization framework PFN (Preferred Networks)出品的自动调参工具optuna。使用optuna的思路

1)sample个靠谱的子数据集;

2)大概写个objective函数的训练和测试代码,objective函数返回一个需要优化的metric;

3)把要优化的变量定义成optuna的parameter(通过trial.suggest_xxx);

4)copy个main部分代码,开始搜超参;

5)睡觉;

6)醒来用最优的参数在整个数据集上跑跑效果;

在自己的code上试了一下optuna,搜出来的参数和我手调的最佳参数差不太多,感觉还是靠谱的。

有没有什么可以节省大量时间的 Deep Learning 效率神器? - 崔权的回答 - 知乎 https://www.zhihu.com/question/384519338/answer/1206812752

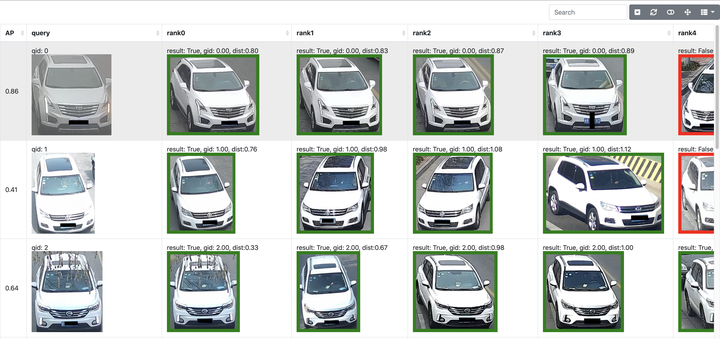

GitHub - silverbulletmdc/showdata: Large scale image dataset visiualization tool. 解决的是远程服务器上的数据可视化问题,比如图片、视频等。比如ReID结果展示

GitHub - microsoft/nni: An open source AutoML toolkit for automate machine learning lifecycle, including feature engineering, neural architecture search, model compression and hyper-parameter tuning. 微软亚洲研究院为研究人员和算法工程师量身定制的自动机器学习工具, NNI 通过前沿的算法、自动化的框架和高效的分布式配置,可以节省训练时间与人力成本,赋能超参调优(Hyperparameter Optimization)、神经网络架构搜索(Neural Architecture Search)、特征工程(Feature Engineering)和模型压缩(Model Compression)等各个机器学习生命周期,具有易于使用、可扩展、灵活和高效的特点

作者:微软亚洲研究院

链接:有没有什么可以节省大量时间的 Deep Learning 效率神器?

GitHub - luo3300612/Visualizer: assistant tools for attention visualization in deep learning 网络中间层变量可视化。有以下特点

精准直接,你可以取出任何变量名的模型中间结果

快捷方便,同时取出Transformer类模型中的所有attention map

非侵入式,你无须修改函数内的任何一行代码

训练-测试一致,可视化完成后,你无须在训练时再将代码改回来

GitHub - lucasjinreal/alfred: alfred-py: A deep learning utility library for **human**, more detail about the usage of lib to: https://zhuanlan.zhihu.com/p/341446046 可视化任意格式的标注数据

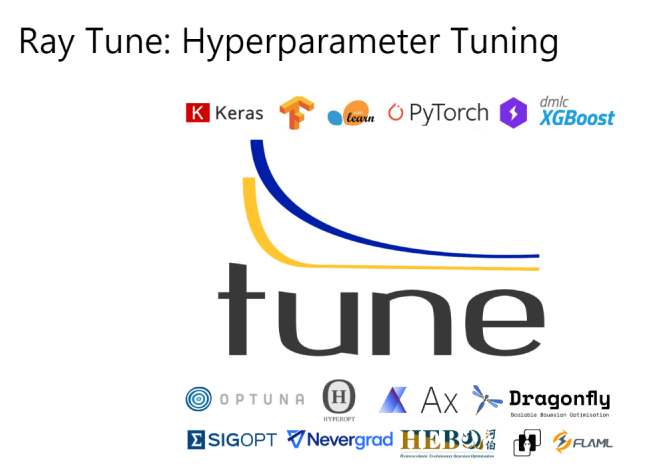

Ray Tune: Hyperparameter Tuning — Ray 2.4.0 用不到10行代码启动多节点分布式超参数搜索支持任何机器学习框架,包括PyTorch,XGBoost,MXNet和Keras与优化库(例如HyperOpt,贝叶斯优化和Facebook Ax)本地集成可选择PBT,HyperBand / ASHA使用TensorBoard可视化结果

作者:Dr.Lee

链接:有没有什么可以节省大量时间的 Deep Learning 效率神器?