使用C语言编写爬虫可以实现网络数据的快速获取和处理,适用于需要高效处理海量数据的场景。与其他编程语言相比,C语言具有较高的性能和灵活性,可以进行底层操作和内存管理,适合处理较复杂的网络请求和数据处理任务。

但是,使用C语言编写爬虫也存在一些挑战。C语言的语法较为复杂,需要较高的编程基础和技能。另外,在编写爬虫时需要处理HTTP请求、解析HTML、JavaScript等前端页面代码,并且避免被目标网站的反爬虫策略所限制,这一过程相对复杂,需要实现多种功能模块并设置适当的参数。

总的来说,使用C语言编写爬虫具有性能和灵活性优势,但需要投入较多的工作和精力,以克服可能出现的各种挑战和困难。

C语言写爬虫的总体思路如下:

-

确定爬取的目标网站和需要爬取的内容。

-

使用C语言中的网络编程库,如libcurl,建立与目标网站的连接。

-

发送HTTP请求,获取目标网站的响应数据。

-

解析响应数据,提取需要的内容。可以使用C语言中的字符串处理函数、正则表达式等工具。

-

将提取到的内容存储到本地文件或数据库中。

-

根据需要,可以设置定时爬取、多线程爬取等功能。

需要注意的是,在爬取网站时,要遵守相关法律法规和网站的使用协议,不得进行非法爬取和侵犯他人隐私等行为。

C语言写爬虫具体代码

以下是一个简单的C语言爬虫示例代码,可以爬取指定网站的HTML内容:

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <curl/curl.h>

int main(void)

{

CURL *curl;

CURLcode res;

char *url = "http://www.example.com";

char *html = NULL;

long html_size = 0;

curl = curl_easy_init();

if (curl) {

curl_easy_setopt(curl, CURLOPT_URL, url);

curl_easy_setopt(curl, CURLOPT_FOLLOWLOCATION, 1L);

curl_easy_setopt(curl, CURLOPT_WRITEFUNCTION, write_callback);

curl_easy_setopt(curl, CURLOPT_WRITEDATA, &html);

res = curl_easy_perform(curl);

if (res != CURLE_OK) {

fprintf(stderr, "curl_easy_perform() failed: %s\n", curl_easy_strerror(res));

} else {

html_size = strlen(html);

printf("HTML size: %ld\n", html_size);

printf("HTML content:\n%s\n", html);

}

curl_easy_cleanup(curl);

}

free(html);

return 0;

}

size_t write_callback(char *ptr, size_t size, size_t nmemb, char **userdata)

{

size_t realsize = size * nmemb;

char *temp = realloc(*userdata, strlen(*userdata) + realsize + 1);

if (temp == NULL) {

fprintf(stderr, "realloc() failed\n");

return 0;

}

*userdata = temp;

memcpy(&((*userdata)[strlen(*userdata)]), ptr, realsize);

(*userdata)[strlen(*userdata) + realsize] = '\0';

return realsize;

}

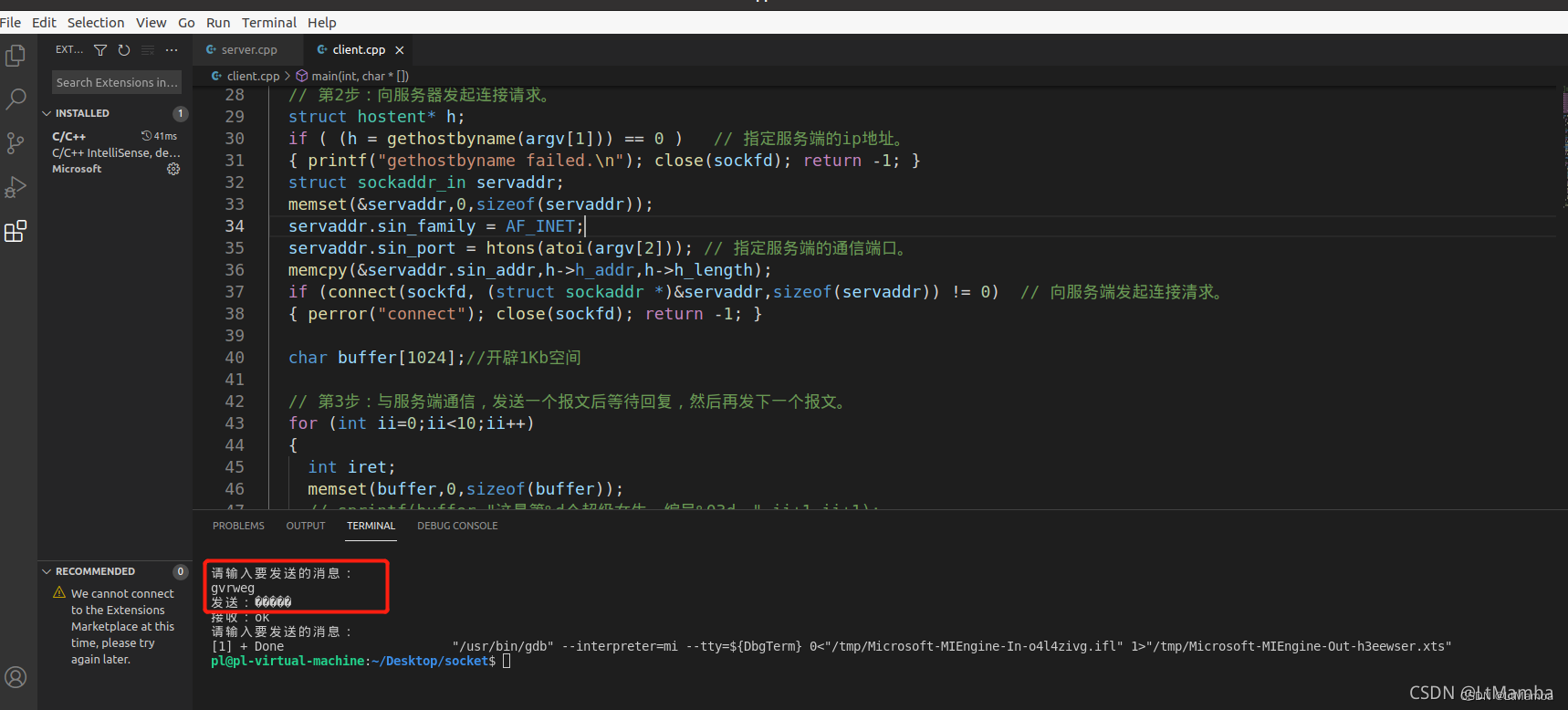

这个示例使用了libcurl库来进行HTTP请求和响应处理。在这个示例中,我们使用curl_easy_init()函数初始化一个CURL对象,然后设置一些选项,如URL、跟随重定向、写回调函数等。最后,我们使用curl_easy_perform()函数执行HTTP请求,并在回调函数中处理响应内容。

需要注意的是,这个示例只是一个简单的爬虫示例,实际上,爬虫需要考虑很多方面,如请求频率、页面解析、数据存储等。如果需要开发一个完整的爬虫,需要更多的工作和技术。

![[2]PCB设计实验|电路板布局布线要求及规律|电抗和电容的关系|8:30~9:30](https://img-blog.csdnimg.cn/74aab51b9a654b149e169539354944a9.png)