| 词向量模型 | ||

| bert4keras | 字级 | bert4keras 文档中心 bert4keras/examples at master · bojone/bert4keras · GitHub mirrors / bojone / bert4keras · GitCode GitHub - bojone/bert4keras: keras implement of transformers for humans bert4keras、transformers 加载预训练bert模型、句向量cls,字向量提取;tokenizer使用_loong_XL的博客-CSDN博客 |

| bert-wwm | 词级,目前向量表示最为准确的语言模型 | GitHub - ymcui/Chinese-BERT-wwm: Pre-Training with Whole Word Masking for Chinese BERT(中文BERT-wwm系列模型) 面向中文的BERT预训练模型 - 知乎 wwmbert GitHub - ymcui/Chinese-BERT-wwm: Pre-Training with Whole Word Masking for Chinese BERT(中文BERT-wwm系列模型) GitHub - ShenDezhou/Chinese-PreTrained-BERT: We released BERT-wwm, a Chinese pre-training model based on Whole Word Masking technology, and models closely related to this technology. 我们发布了基于全词遮罩(Whole Word Masking)技术的中文预训练模型BERT-wwm,以及与此技术密切相关的模型 |

| Alpaca | GitHub - ymcui/Chinese-LLaMA-Alpaca: 中文LLaMA&Alpaca大语言模型+本地CPU/GPU训练部署 (Chinese LLaMA & Alpaca LLMs) mirrors / ymcui / chinese-llama-alpaca · GitCode 【LLM】Windows本地CPU部署民间版中文羊驼模型(Chinese-LLaMA-Alpaca)踩坑记录_提笔忘字的帝国的博客-CSDN博客 【五一创作】跑alpaca-lora语言模型的常见问题(心得)_如果皮卡会coding的博客-CSDN博客 Gpt进阶(二):训练部署自己的ChatGPT模型(羊驼 Alpaca-LoRA) - 知乎 | |

| sentence_transformers | 5分钟 NLP系列 — SentenceTransformers 库介绍_sentence_transformers_deephub的博客-CSDN博客 | |

| roBERTa | GitHub - brightmart/roberta_zh: RoBERTa中文预训练模型: RoBERTa for Chinese 使用PaddleNLP识别垃圾邮件(四):用RoBERTa做中文邮件标题分类 - 飞桨AI Studio | |

| bert4vec | GitHub - zejunwang1/bert4vec: 一个基于预训练的句向量生成工具 可以生成相似句子对:GitHub - ZhuiyiTechnology/pretrained-models: Open Language Pre-trained Model Zoo | |

| hugging face | Models - Hugging Face hugging face 模型库的使用及加载 Bert 预训练模型_IT__learning的博客-CSDN博客 | |

| huggingfacehub 模型使用 | # 使用方式一:指定模型名字 ,这种方式不需要下载预训练模型,函数调用过程中如果发现没有这个模型就会自动下载 from transformers import AutoTokenizer, AutoModel tokenizer = AutoTokenizer.from_pretrained(“nghuyong/ernie-1.0”) model = AutoModel.from_pretrained(“nghuyong/ernie-1.0”) # 使用方式二:指定路径,这种方式需要先下载好预训练模型的文件 from transformers import AutoTokenizer, AutoModel tokenizer = AutoTokenizer.from_pretrained(“/home/models/huggingface/gpt2”) model = AutoModel.from_pretrained(“/home/models/huggingface/gpt2”) | |

| transformers | pipeline有问答模板Bert 输出及例子_bert输出_桃汽宝的博客-CSDN博客 | |

语言模型主流

news2026/2/14 22:50:48

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/610571.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

[4]PCB设计实验|LPWAN物联网系统解决方案 |LoRa模块/LoRa网关/云平台/LoRa应用案例|9:30~10:00

目录

1.LPWAN物联网系统解决方案

LoRa模块/LoRa网关/云平台/LoRa应用案例

2.LoRaWAN网络部署情况

LoRaWAN网络架构

3.基于LPWAN技术的无线通信端到端解决方案

LoRa低功耗广域网智能终端

CY-LRW-102开关控制器

CY-LRB-101开关检测器

4.Lo…

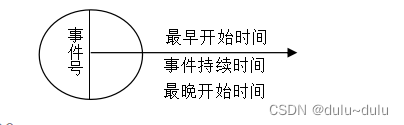

软件生命周期( 包括各开发模型的优缺点)知识点全面

软件生命周期

指软件产品从计划到软件交付使用,直到最终退出为止的过程。包括计划阶段、分析阶段、实现阶段、测试阶段和运行维护阶段。 软件开发模型 瀑布模型、螺旋模型、喷泉模型、原型化模型、演化模型 瀑布模型:严格遵循软件生命周期各阶段的固定顺…

vue对接海康摄像头,配合ifarme进行展示。

1、在public文件夹下建一个文件ifarme.index,和index.html同级。

<!doctype html>

<html><head><title></title><meta http-equiv"Content-Type" content"text/html; charsetutf-8" /><meta http-equi…

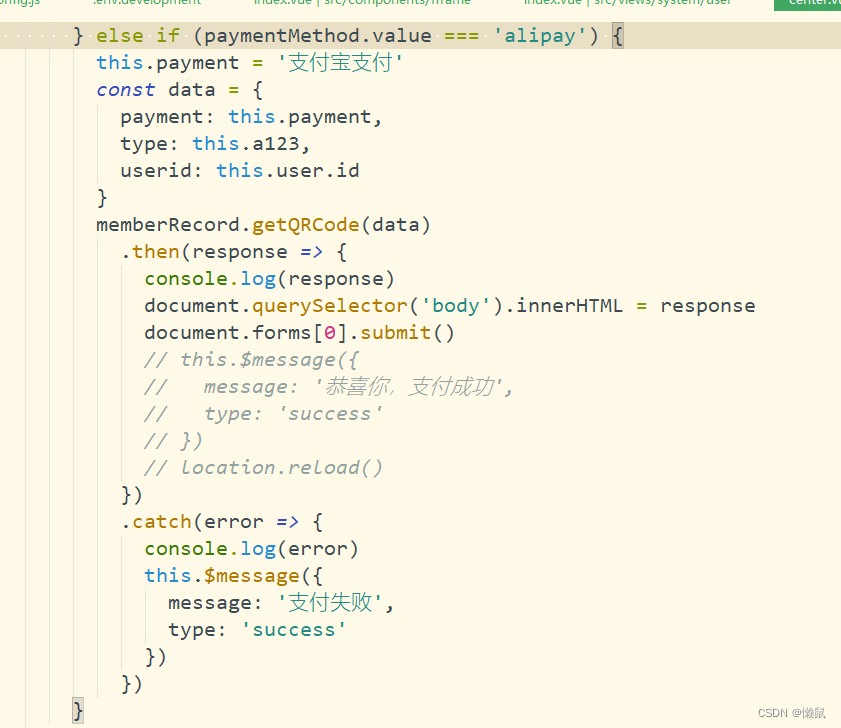

支付宝电脑版二维码Java

/*生成二维码/ PostMapping(value “getQRCode”) RequestLog(“支付宝支付”) ApiOperation(“支付宝支付”) AnonAccess public String qrCode(Validated RequestBody SysMemberRecordVo sysMemberRecordVo) throws AlipayApiException { AlipayClient alipayClient new De…

聚观早报|上海迪士尼辟谣乐园落户武汉;Wi-Fi7国内标准即将落地

今日要闻:上海迪士尼辟谣乐园将落户武汉;Wi-Fi7国内标准即将落地;微软Office365AI助手价格曝光;刘畊宏20秒短视频要价60万;滴滴旗下公司新增互联网游戏业务 上海迪士尼辟谣乐园将落户武汉

6 月 3 日,有消息…

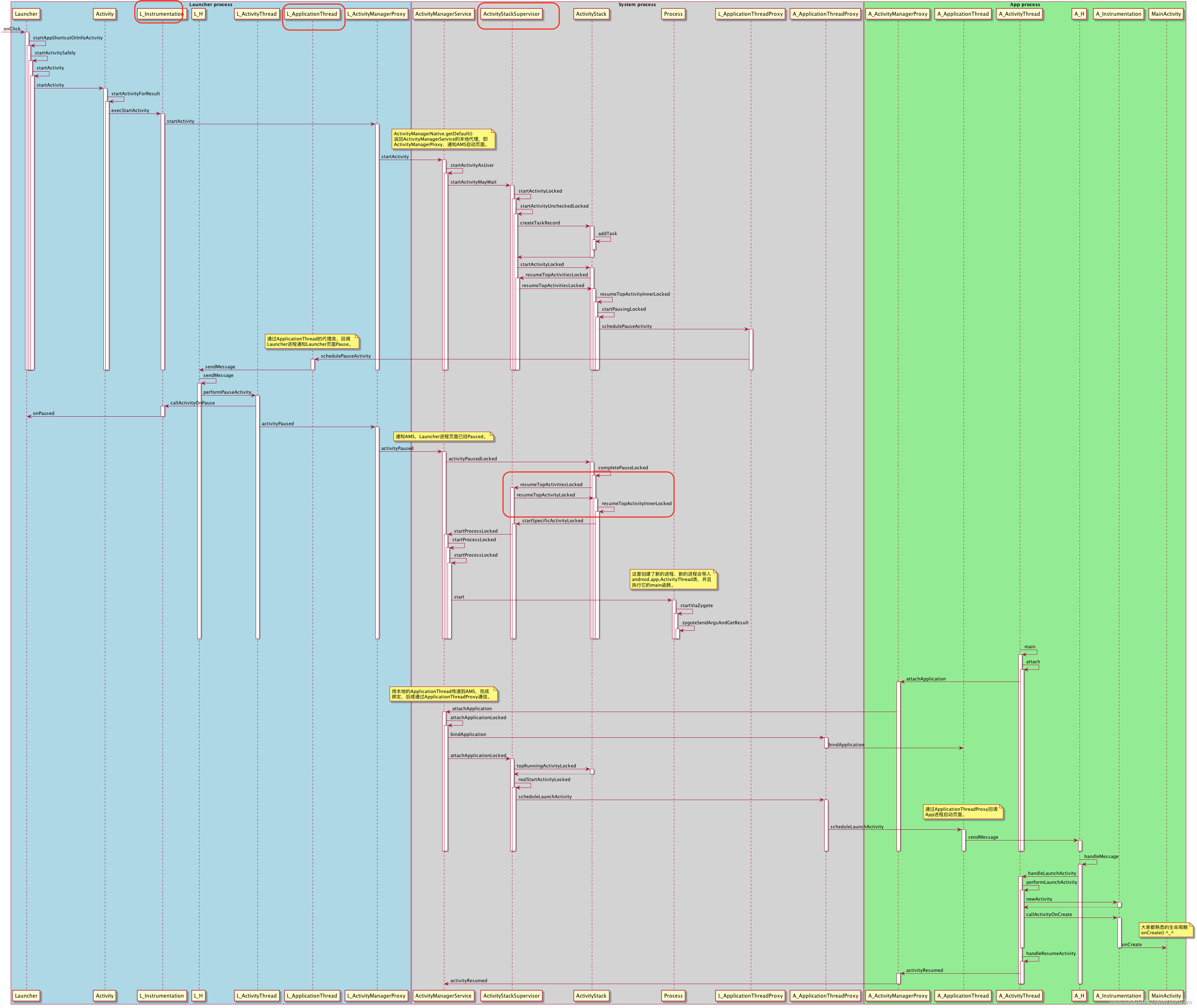

Android-Activity生命周期

文章参考:添加链接描述 文章参考:添加链接描述

五大状态

StartingRunningStoppedPausedDestroyed 借用一张已经包浆的图 PS:Running和Paused是可视阶段,其余都是不可视

几大函数 onCreate:通过setContentLayout初始…

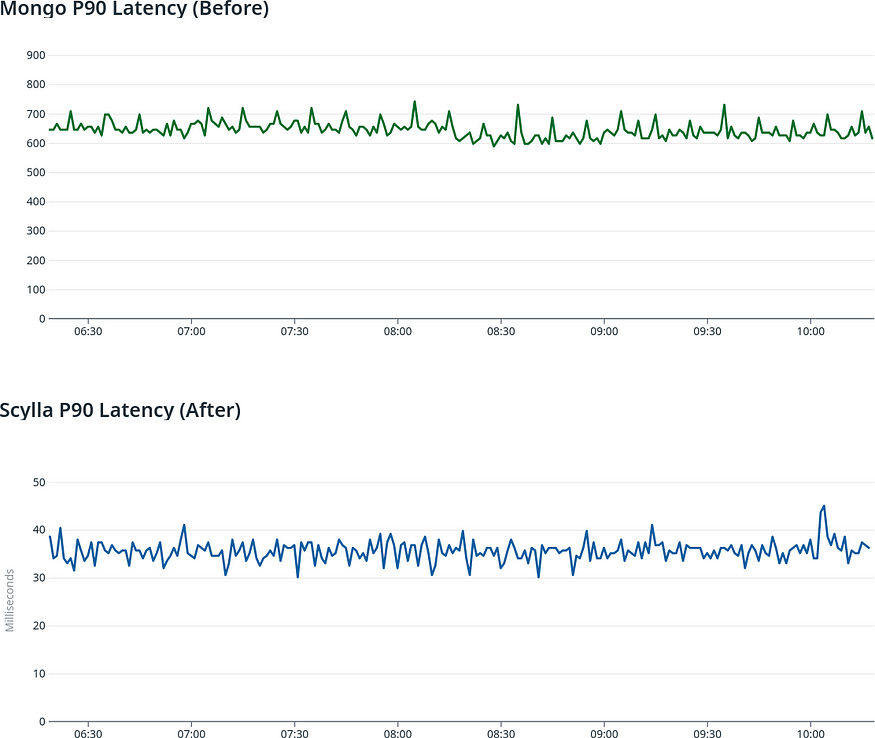

如何选择最佳数据库:MongoDB、PostgreSQL或ScyllaDB?

Tractian是一家提供工业监控系统的机器智能公司。去年,我们面临着将我们的实时机器学习(ML)环境和分析仪表板升级以支持数据吞吐量的大幅增长的挑战,因为我们成功地将客户数据库和数据量扩大了10倍。

我们意识到,在快…

MySQL版本5.7.99?

序:在项目工作中需要从三方厂商数据库同步数据到项目业务库中,本平平无奇的功能却被一个报错打破。 在使用某框架的DataSourceConfig(Object)方法初始化数据库连接时,日志输出报错: Unknown system variable transaction_isolatio…

sparkRDD编程实战

文章目录 sparkRDD编程实战1、Spark RDD 实现单词计数2、Spark RDD 实现分组求TopN3、Spark RDD 实现二次排序4、Spark RDD 计算平均成绩5、Spark RDD 倒排索引统计每日新增用户6、Spark案例实操7、Spark RDD 综合应用需求1:Top10热门品类需求说明实现方案一实现方案…

【Python SMTP/POP3/IMAP】零基础也能轻松掌握的学习路线与参考资料

Python是一种高级编程语言,广泛应用于Web开发、人工智能、数据科学、自动化等领域。SMTP/POP3/IMAP是与邮件相关的三个协议,分别用于发送邮件、接收邮件和访问邮件。使用Python可以轻松实现这些功能,本文将介绍Python SMTP/POP3/IMAP的学习路…

【Python】Python系列教程-- Python3 条件控制(十六)

文章目录 前言if 语句if 嵌套match...case 前言

往期回顾:

Python系列教程–Python3介绍(一)Python系列教程–Python3 环境搭建(二)Python系列教程–Python3 VScode(三)Python系列教程–Pytho…

Spring Boot整合Swagger2 Swagger2配置

目录

什么是Swagger?

Swagger如何使用

如何使用Swagger

查看SwaggerAPI文档 什么是Swagger?

Swagger是一款流行的RESTful API文档生成工具,它支持多种编程语言和多种框架,包括但不限于Java、Python、Node.js、Go等,Spring Boot也提供了…

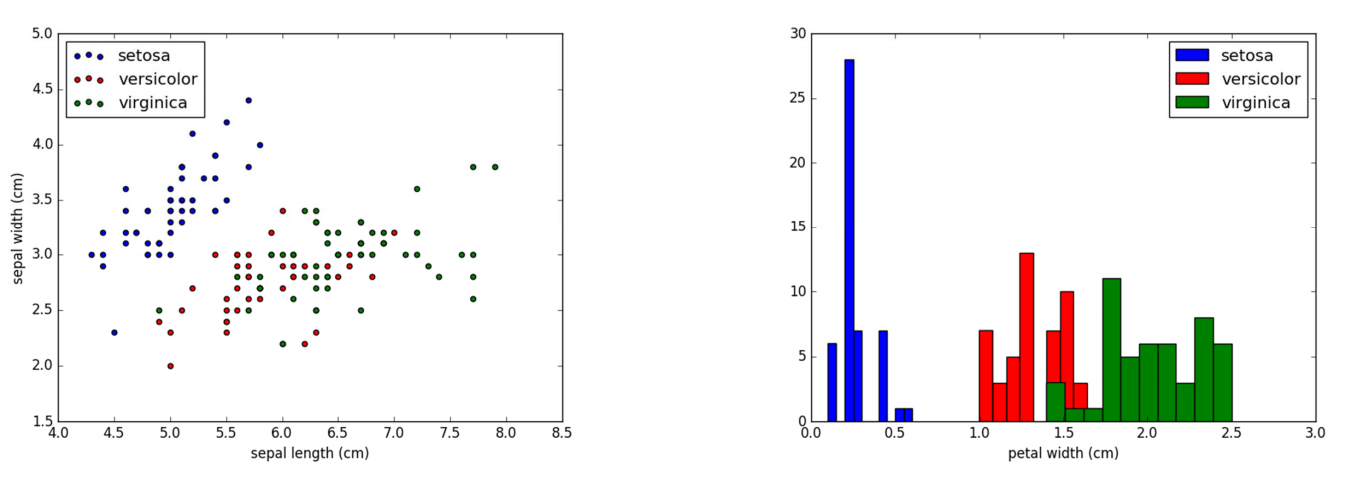

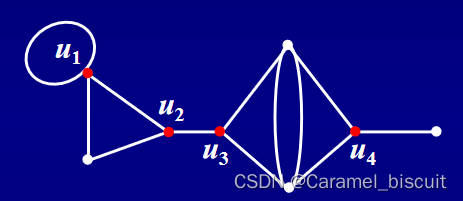

【机器学习】第二章:K近邻(分类)

系列文章目录

第二章:K近邻(分类) 相关代码地址:https://github.com/wzybmw888/MachineLearning.git 文章目录 系列文章目录一、最近邻算法二、最近邻算法的缺陷(1)策略一:K近邻(k‐…

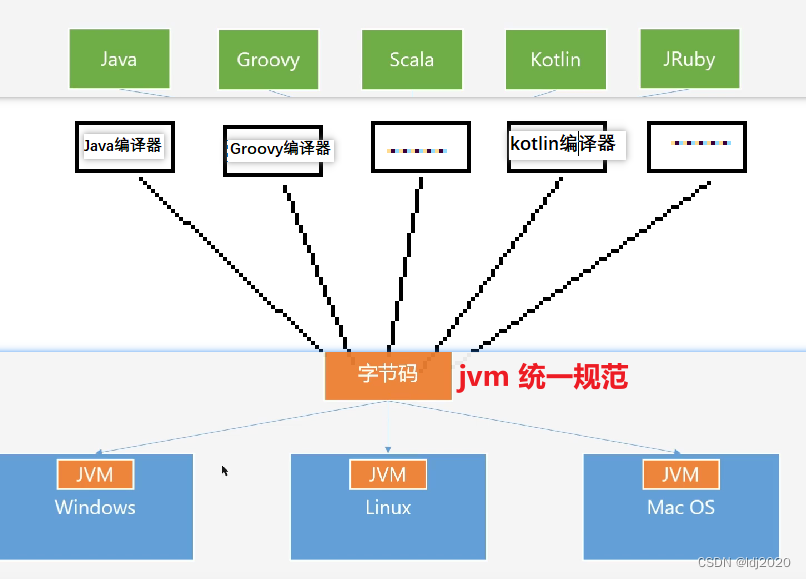

java源码为什么需要编译成字节码?

作用1: jvm支持多语言,需要字节码作为统一的规范 作用2: 字节码转成机器的指令会更快

作用3: 如果没有对应的反编译器,字节码还具有一定的安全保密作用

【Rust日报】2023-06-02 Rust 1.70.0 稳定版发布

Rust 1.70.0 稳定版发布 Rust 团队很高兴地宣布 Rust 的新版本 1.70.0。Rust 是一种编程语言,它使每个人都能构建可靠、高效的软件。 最大的特性是,OnceCell稳定版可用啦。 如果你通过 rustup 安装了以前版本的 Rust,你可以通过以下方式获得 …

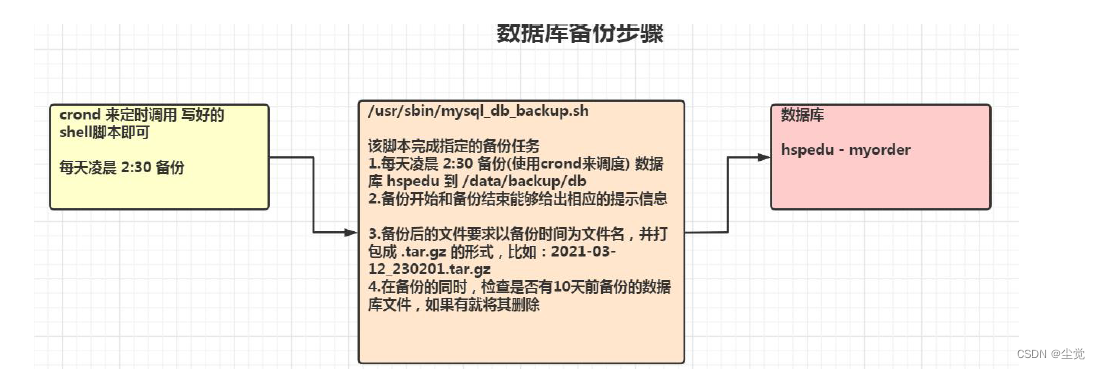

Linux 之大数据定制篇-Shell 编程

Linux 之大数据定制篇-Shell 编程

为什么要学习Shell 编程

Linux 运维工程师在进行服务器集群管理时,需要编写Shell 程序来进行服务器管理。对于JavaEE 和Python 程序员来说,工作的需要,你的老大会要求你编写一些Shell 脚本进行程序或者是服…

Mocha AE:图层相关面板

Mocha AE 左侧的图层面板、图层属性面板以及边缘属性面板提供了与图层、样条、跟踪等相关的选项。 Layers 图层 图层的上下顺序相当重要。 上方所有图层的样条区域将被自动排除出跟踪遮罩 Track Mattes。 也可在同一图层上绘制多个样条形状。相交的样条区域将被排除出遮罩。 Vi…

【MySQL】一文带你了解MySQL中的子查询

文章目录 1. 需求分析与问题解决1. 1实际问题1.2 子查询的基本使用1.3 子查询的分类 2. 单行子查询2.1 单行比较操作符2.2 代码示例2.3 HAVING 中的子查询2.4 注意的问题 3. 多行子查询3.1 多行比较操作符3.2 代码示例 4. 相关子查询4.1 相关子查询执行流程4.2 代码示例 子查询…

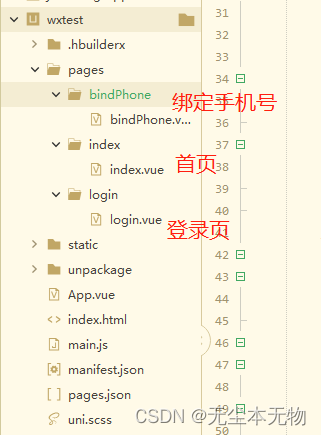

uniapp微信一键登录微信授权

前言

现在小程序逐渐成为主流,常用的微信授权登录很重要很常见的一个功能,今天自己总结了一下。

准备工作

1.如果你想自己想试一下这个功能首先你需要有一个开发中的项目并且你在开发成员里面。 2.配置自己的微信开发者工具的appid码 3.在hbuilderx的…

![[4]PCB设计实验|LPWAN物联网系统解决方案 |LoRa模块/LoRa网关/云平台/LoRa应用案例|9:30~10:00](https://img-blog.csdnimg.cn/6cb9d7d0af104fd9862817ac73ef30bb.png)