论文笔记--PANGU-α: LARGE-SCALE AUTOREGRESSIVE PRETRAINED CHINESE LANGUAGE MODELS WITH AUTO-PARALLEL COMPUTATION

- 1. 文章简介

- 2. 文章概括

- 3 文章重点技术

- 3.1 Transformer架构

- 3.2 数据集

- 3.2.1 数据清洗和过滤

- 3.2.2 数据去重

- 3.2.3 数据质量评估

- 4. 文章亮点

- 5. 原文传送门

- 6. References

1. 文章简介

- 标题:PANGU-α: LARGE-SCALE AUTOREGRESSIVE PRETRAINED CHINESE LANGUAGE MODELS WITH AUTO-PARALLEL COMPUTATION

- 作者:Zeng, Wei, et al.

- 日期:2021

- 期刊:arxiv preprint

2. 文章概括

文章提出了中午领域的大语言模型PANGU- α \alpha α。模型在1.1TB的中文数据上训练,参数为2000亿。为了支撑模型训练,文章提出了一种Auto-parallel的训练方式。

3 文章重点技术

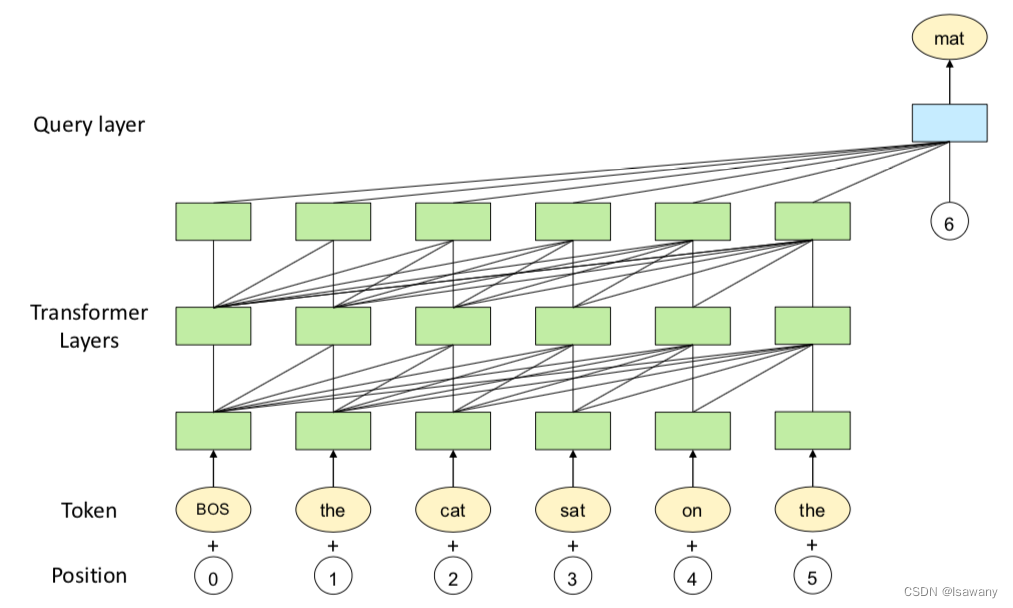

3.1 Transformer架构

和GPT等其它大语言模型一样,PANGU-

α

\alpha

α选择使用Transformer作为神经网络的架构。为了使得模型更精准地预测下一个token,文章在最后一个Transformer层后面增加了一个Query层。传统Transformer的注意力分数计算方式为

A

=

Q

K

T

=

H

L

W

Q

W

K

⊺

H

L

⊺

A = QK^T = H_LW^Q{W^K}^\intercal H_L^\intercal

A=QKT=HLWQWK⊺HL⊺,改良后的注意力分数表达式为为

A

=

p

n

W

Q

W

K

⊺

H

L

⊺

A =p_nW^Q{W^K}^\intercal H_L^\intercal

A=pnWQWK⊺HL⊺,其中

p

n

p_n

pn表示query层(位置编码)表示将位置编码信息用于注意力机制的查询。

3.2 数据集

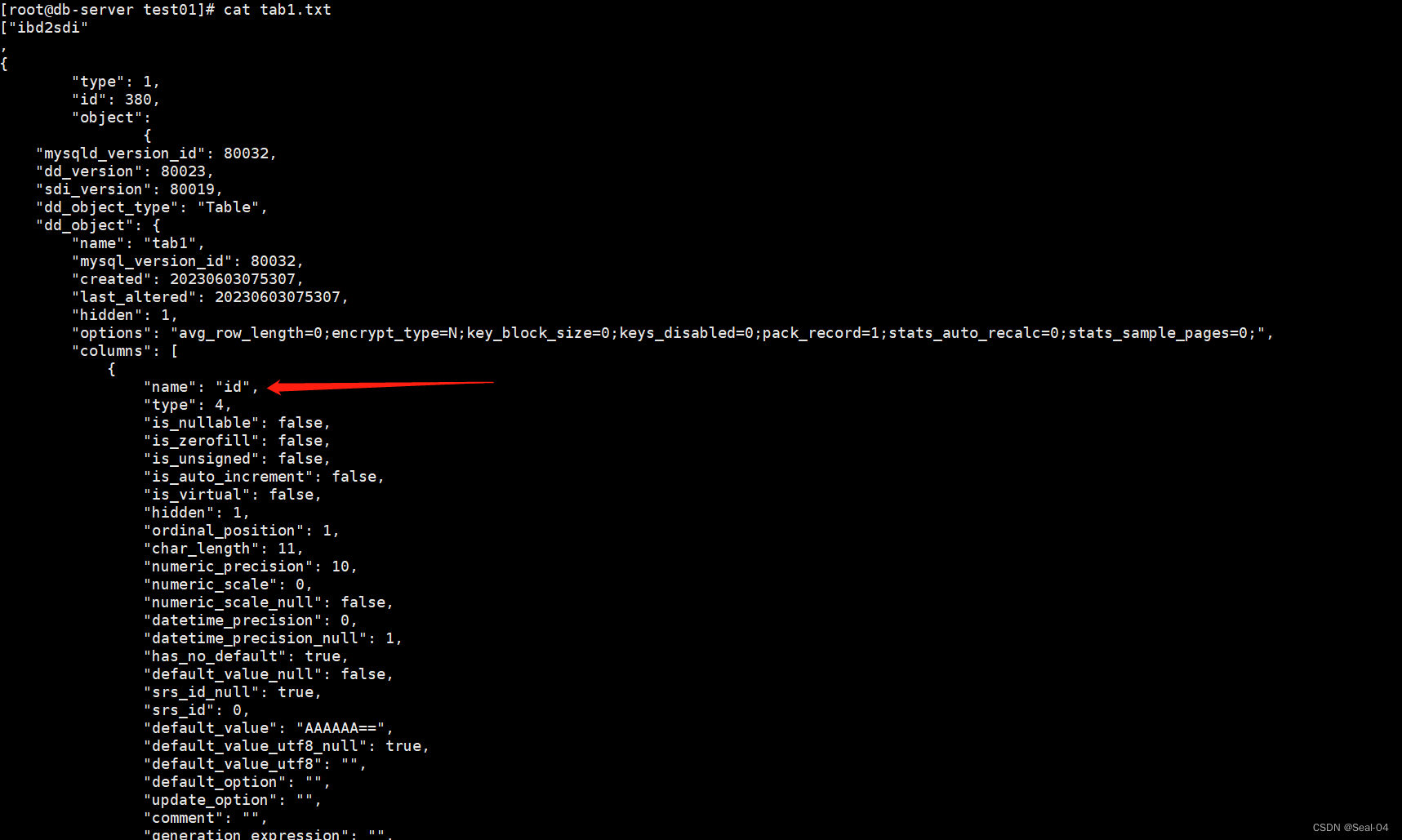

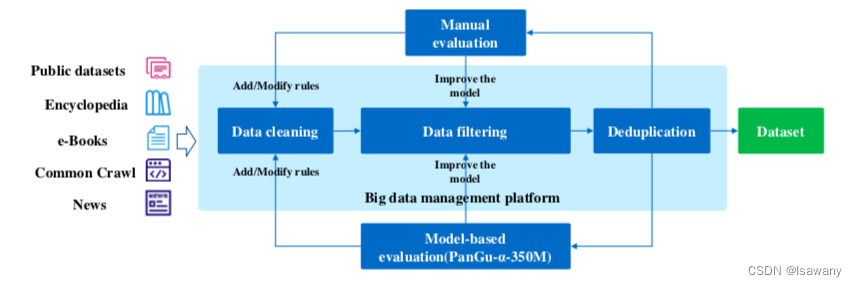

很多文章已经论证了模型参数的增加对模型的表现能力提升有很大帮助,但在增加模型参数的同时需要增加数据集来支撑参数的训练。为了获得大量的中文数据集,文章进行了数据收集、数据清洗、数据过滤和数据去重多个步骤,具体流程见下图。

3.2.1 数据清洗和过滤

语料库中大量的数据是来自于Common Crawl的文本,质量无法保证,文章首先对数据集进行了清洗工作:

- 移除字符少于150或中文字符少于60%文档;移除仅包含网页标题集合的文档;

- 移除特殊字符;移除每个文档中的重复段落;

- 基于关键词识别广告,移除包含广告的文档;

- 将繁体中文全部转化为简体中文;

- 移除网页中的导航栏

对上述清洗后的文档进行过滤以移除有害的、广告类的或低质量的文档: - 敏感词过滤:手动构建724个敏感词,移除包含超过3个敏感词的文档,从而保证模型不被有害网页误导。

- 基于模型的垃圾信息自动过滤:基于标注数据训练一个FastText垃圾文档分类器,将FastText识别为垃圾文档的文档过滤。

- 低质量文档过滤:类似GPT-3[1],训练一个分类器给每篇文档打分,过滤分数低于阈值的文档。

3.2.2 数据去重

由于语料库中可能存在高度重叠的文档,我们采用模糊数据去重方法对过滤后的数据进行去重操作。为此,我们对MinHashLSH算法进行改良,设计了一种分布式的数据去重算法对数据集进行高效去重。

3.2.3 数据质量评估

为了对文档进行上述的自动清洗和过滤,我们需要相应的清洗规则和过滤阈值。为此,我们迭代地进行上述预处理工作:在每次预处理之后根据评估结果更新清洗规则和过滤阈值。评估结果采用人工和模型自动选择两种方式:人工随机采样评估句子的脸骨感谢和低质量内容的数量从而进行规则调整。但人工评估的范围有限,从而我们从所有数据集中选择30GB的数据训练一个小型的PANGU-350M,并采用该模型评估所有训练数据得到PPL(perplexity),PPL越低的数据质量越高,从而相应的清洗规则越好,基于该原则我们选择最好的清洗规则和阈值。

上述预处理过程之后,我们最后得到1.1TB的中文数据用于模型训练

4. 文章亮点

文章采集了大量的中文数据,且对数据集进行了手工、自动的清洗、过滤、去重,基于预处理后的1.1TB中文数据进行模型训练,得到PANGU- α \alpha α大语言模型,模型在多个中文任务上表现超过GPT-3。此外为了加速训练过程,文章提出了一种AUTO-PARALLEL的训练方法,在大规模数据训练中可作为参考。

5. 原文传送门

PANGU-α: LARGE-SCALE AUTOREGRESSIVE PRETRAINED CHINESE LANGUAGE MODELS WITH AUTO-PARALLEL COMPUTATION

6. References

[1] 论文笔记–Language Models are Few-Shot Learners

![[架构之路-204]- 常见的需求分析技术:结构化分析与面向对象分析](https://img-blog.csdnimg.cn/9355ae02c9ff42418f8d5f87968c690d.png)