此前出了目标检测算法改进专栏,但是对于应用于什么场景,需要什么改进方法对应与自己的应用场景有效果,并且多少改进点能发什么水平的文章,为解决大家的困惑,此系列文章旨在给大家解读发表高水平学术期刊中的 SCI论文,并对相应的SCI期刊进行介绍,帮助大家解答疑惑,助力科研论文投稿。解读的系列文章,本人会进行 创新点代码复现,有需要的朋友可关注私信我获取。

一、摘要

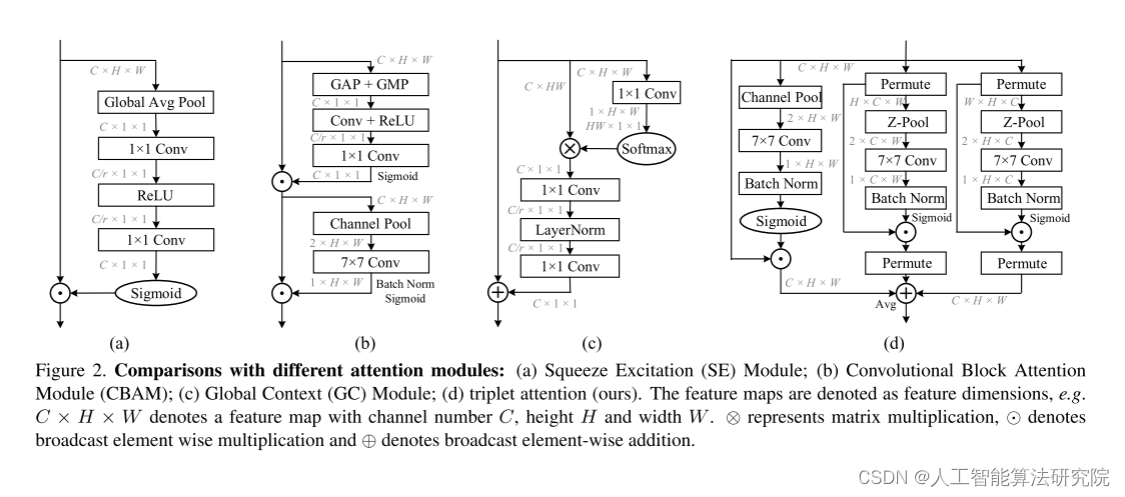

由于注意力机制能够建立通道或空间位置之间的相互依赖关系,近年来,人们对注意力机制进行了广泛的研究,并在各种计算机视觉任务中得到了广泛的应用。本文研究了轻量化但有效的注意机制,提出了一种利用三分支结构捕获跨维相互作用来计算注意权值的新方法——三重注意。对于一个输入张量,三重注意通过旋转操作和残差变换建立维度间的依赖关系,并以可以忽略不计的计算开销对通道间和空间信息进行编码。我们的方法简单而高效,可以很容易地插入到经典骨干网作为

一个附加模块。我们证明了我们的方法在各种具有挑战性的任务上的有效性,包括在ImageNet-1k上的图像分类和在MSCOCO和PASCAL VOC数据集上的目标检测。此外,我们通过可视化检查GradCAM和GradCAM++的结果,对三重注意的表现提供了广泛的见解。我们方法的经验评估支持我们的直觉,即在计算注意力权重时,跨维度捕获依赖关系的重要性。本文的代码可以在https://github上公开访问。

二、网络模型及核心创新点

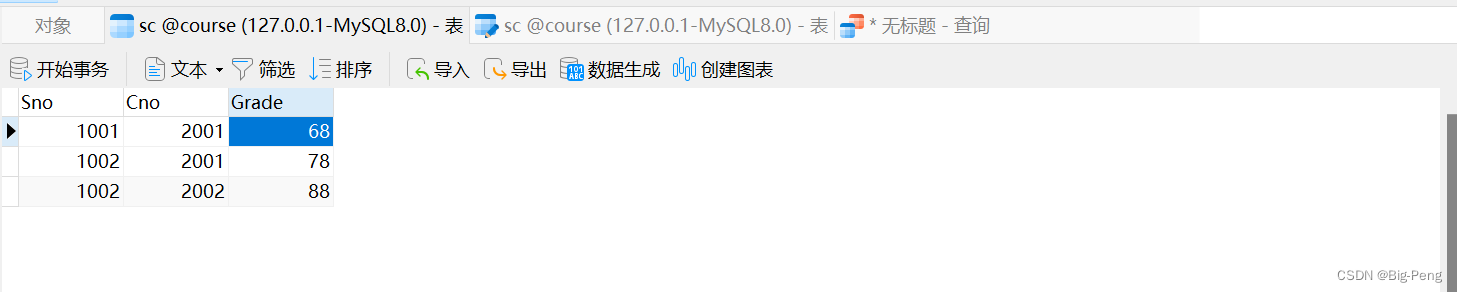

1.重新审视CBAM的渠道关注

2.三重注意

三、实验效果(部分展示)

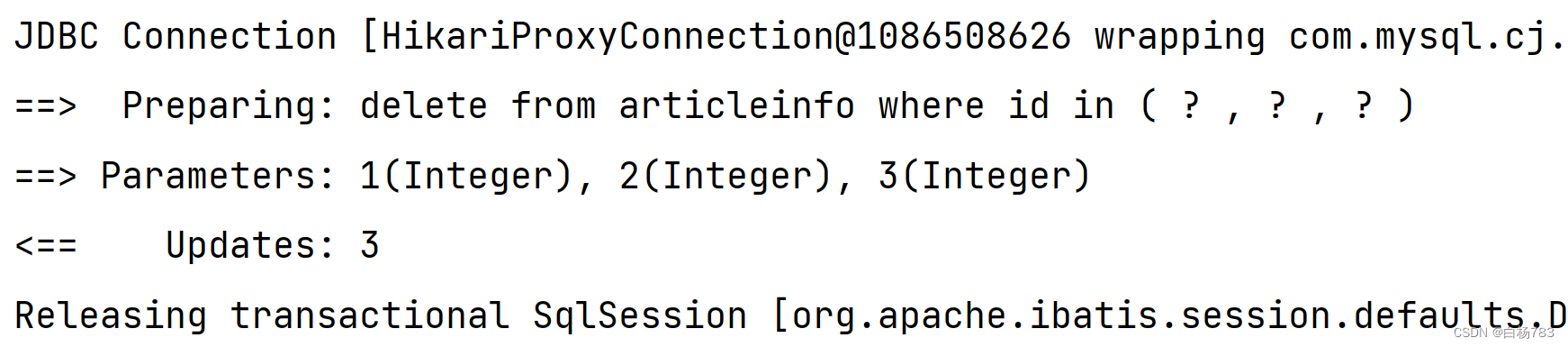

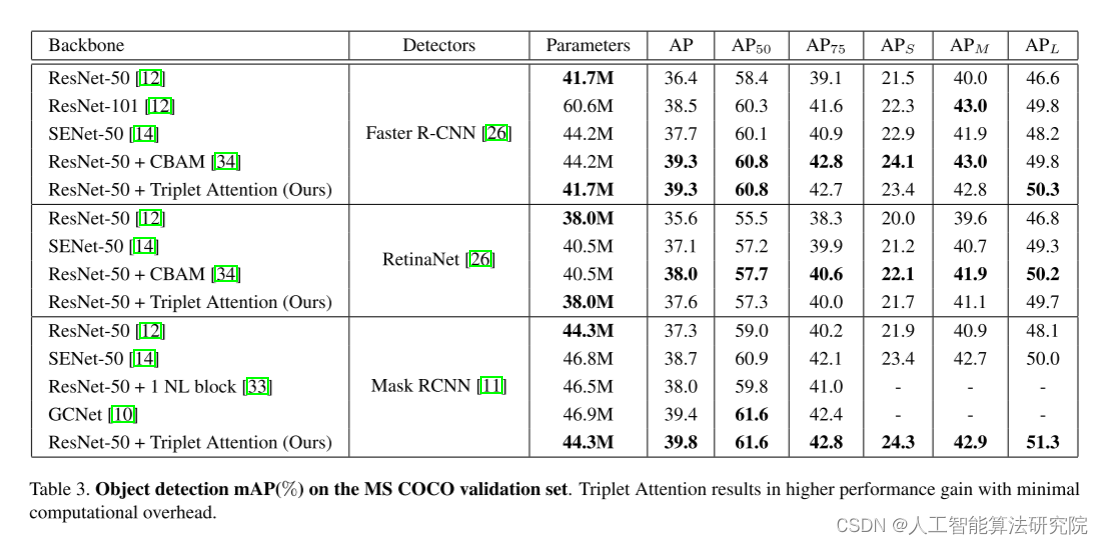

在本节中,我们将详细介绍实验和结果,这些实验和结果证明了三重注意的性能和效率,并将其与之前提出的在几个具有挑战性的计算机视觉任务(如 ImageNet-1k[7]分类和PASCAL VOC[8]和MS COCO[22]数据集上使用标准网络架构(如 ResNet-50[12]和MobileNetV2[27])上的注意机制进行比较。

为了进一步验证我们的结果,我们为样本图像提供 Grad-CAM[28]和Grad-CAM++[3]结果,以展

示三重注意捕捉更确定性特征丰富表示的能力。所有 ImageNet 模型使用 8 个 Nvidia Tesla V100 gpu 进行训练,所有对象检测模型使用 4 个Nvidia Tesla P100 gpu 进行训练。我们没有观察到基线模型和那些增加了三重注意的模型之间的总壁时间有任何实质性的差异。

(1)消融实验

我们通过消融实验进一步验证了交叉维度相互作用的重要性影响分支的三重注意模块。在表 5中,空间关闭表示第三个分支(输入张量未进行排列)被关闭,通道关闭表示涉及输入张量排列的两个分支被关闭。如图所示,结果支持了我们的直觉,即三重注意的所有三个分支都被打开,表示全部,比普通版本和它的两个对应版本表现一致。

(2)图像网络

为了训练基于ResNet[12]的模型,我们在每个瓶颈块的末尾添加了三重注意层。为了与其他方法进行一致和公平的比较,我们采用了精确的训练配置[12,14]。类似地,我们遵循[27]的方法来训练我们的基于MobileNetV2的架构。经过验证的体系结构的结果如下表5所示。

四、实验结论

在本工作中,我们提出了一种新的注意层——三重注意,它捕捉张量中跨维度特征的重要性。三重注意是一种高效的注意计算方法,不存在任何信息瓶颈。我们的实验证明了这三联体注意提高了架构的基线性能,如 ResNet 和MobileNet 的任务,如 ImageNet 上的图像分类和MS COCO上的对象检测,而只引入最小的计算开销。

希望在计算注意力时,其他新的、健壮的获取跨维度依赖关系的技术可以改善我们的结果,同时降低成本。未来,我们计划研究在更复杂的架构(如Ef- fiicientnets[31])中添加三重注意的效果,并扩展我们在3D视觉领域的直觉。

注:论文原文出自Rotate to Attend: Convolutional Triplet Attention Module本文仅用于学术分享,如有侵权,请联系后台作删文处理。

解读的系列文章,本人已进行创新点代码复现,有需要的朋友欢迎关注私信我获取 ❤ 。