文章目录

- HGFormer: Hierarchical Grouping Transformer for Domain Generalized Semantic Segmentation

- 摘要

- 本文方法

- 实验结果

HGFormer: Hierarchical Grouping Transformer for Domain Generalized Semantic Segmentation

摘要

目前的语义分割模型在独立同分布条件下取得了巨大的成功。然而,在实际应用中,测试数据可能与训练数据来自不同的领域。因此,提高模型对领域差异的鲁棒性非常重要。

本文方法

- 这项工作研究了领域泛化设置下的语义分割,其中模型仅在源领域上训练,并在看不见的目标领域上测试

- 提出了一种新的分层分组变换器(HGF-ormer),以显式地对像素进行分组,形成部分级掩码,然后形成整个part-级掩码。

- 不同规模的mask旨在将类的部分和整体分割开来。HGFormer将两个尺度上的MASK分类结果组合用于类标签预测。

代码地址

本文方法

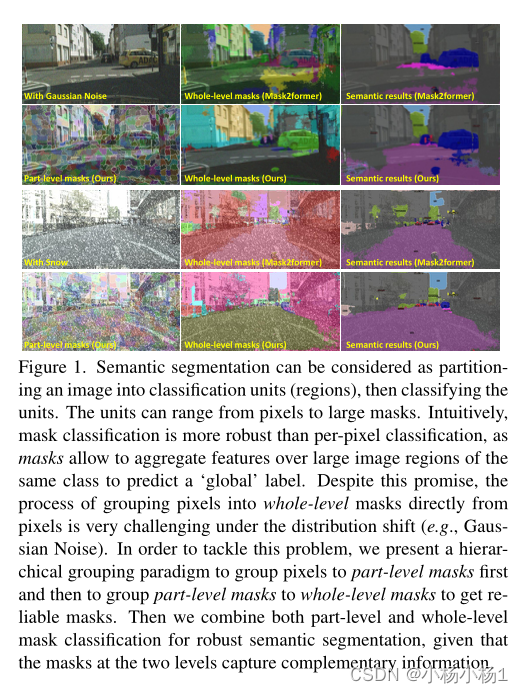

语义分割可以被认为是将图像划分为分类单元(区域),然后对这些单元进行分类。

MASK分类比每像素分类更稳健,因为MASK允许在同类的大图像区域上聚合特征,以预测“全局”标签。

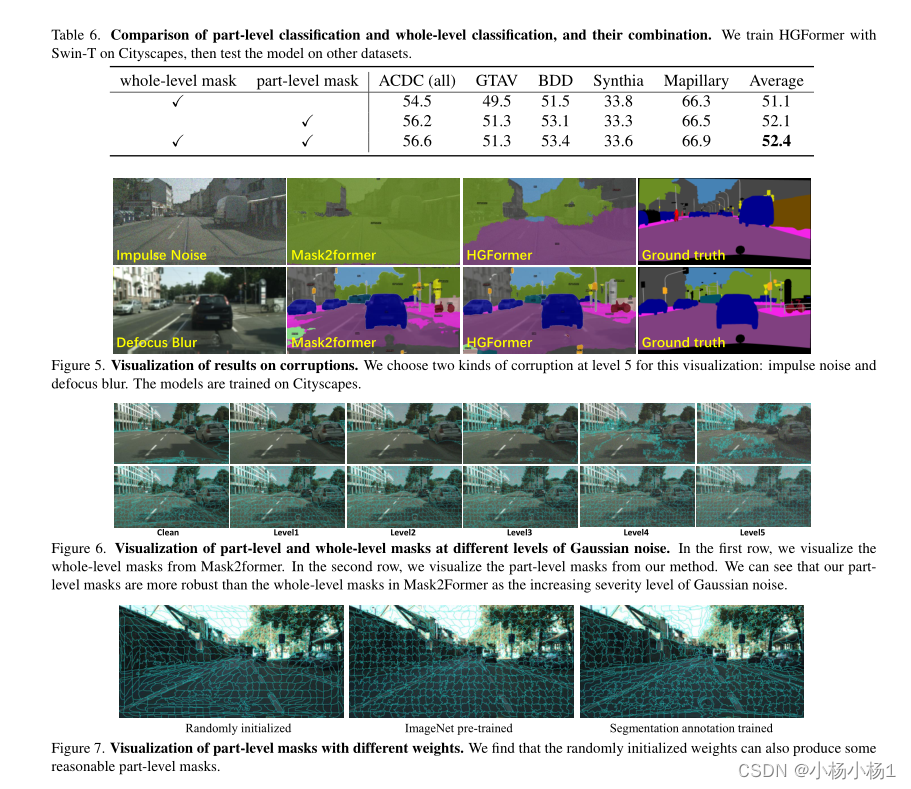

在分布偏移(例如,高斯噪声)的情况下,将像素直接从像素分组为全水平掩模的过程是非常具有挑战性的。为了解决这个问题,我们提出了一种分层分组范式,先将像素分组到部分级掩码,然后将部分级掩码分组到整体级掩码,以获得可靠的掩码。然后,考虑到两个级别的掩码捕获互补信息,我们将部分级别和整体级别的掩码分类相结合,以实现稳健的语义分割。

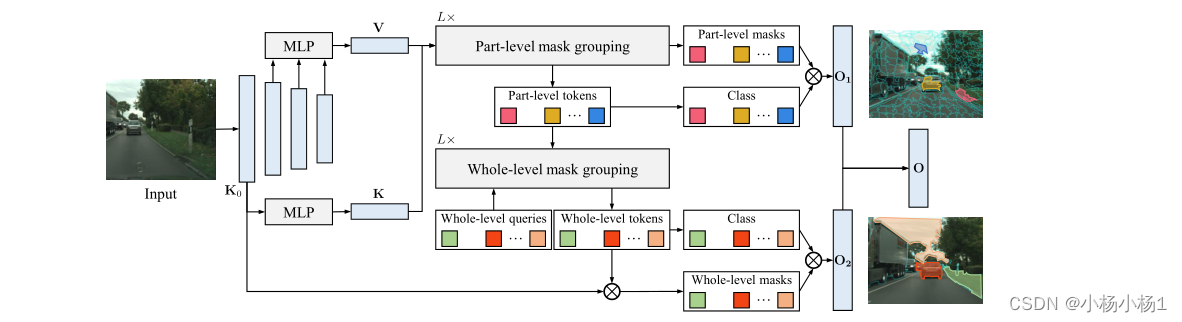

首先将图像传递到骨干网络,并获得不同分辨率的特征图。

最大的特征图K0被投影到K以用于part级分组。其他三个特征图被融合以形成用于稍后分类的part级掩模特征提取的新特征图V。

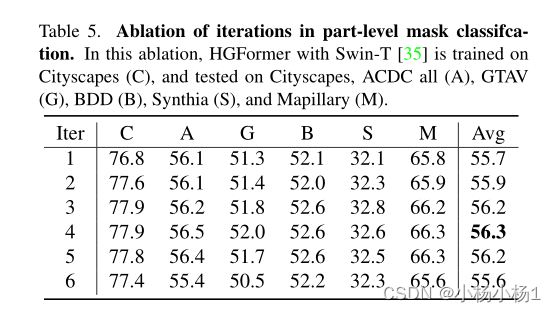

part级分组的细节可以在算法1中看到。分组过程是重复L次迭代。在每次迭代结束时,都有Np part级mask及其token。结合part级分类和part级掩码,我们可以得到语义分割结果O1。

part级别分组的最后一次迭代中的part级别token通过全级别分组聚合为全级别掩码(实际上是交叉关注层)

类似地,在整个级别分组中也有L次迭代。在每次迭代结束时,都没有完整级别的令牌。通过K0和投影的全级别掩码令牌之间的矩阵相乘来计算全级别掩码。类似地,我们可以通过结合整个级别掩码及其分类来获得语义分割结果O2。最终结果O是O1和O2的总和。

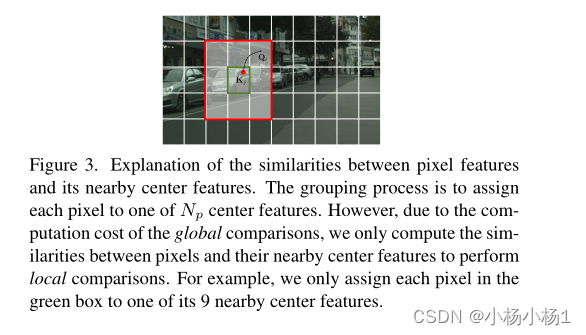

像素特征及其附近中心特征之间的相似性。分组过程是将每个像素分配给Np个中心特征中的一个。然而,由于全局比较的计算成本,我们只计算像素与其附近中心特征之间的相似性来进行局部比较。例如,我们只将绿框中的每个像素分配给其9个附近中心特征中的一个。

实验结果

![Termius使用[分屏同时操作]](https://img-blog.csdnimg.cn/8e12657597904428a5b7e23a357b919d.png)