一、介绍

1.1 R语言和ggplot2

-

语言是一种强大的数据分析和统计建模工具,具有广泛的应用领域。 -

ggplot2是基于R语言的数据可视化工具,具有强大的绘图功能和灵活性。

1.2 数据分析中的重要性

-

R语言和ggplot2在数据分析中具有广泛的应用,能够帮助研究人员更好地理解数据和发现规律。 -

R语言和ggplot2具有开源、免费、易学易用等优点,受到越来越多科研人员的青睐。

1.3 SCI数据分析的难点和需求

-

SCI论文数据分析需要研究人员具备一定的统计学和编程基础,能够熟练运用数据分析和可视化工具。 -

SCI论文数据分析需要研究人员能够快速、准确地进行数据处理、可视化和分析,为研究结果和结论提供有力的支持。

二、R语言和ggplot2基础知识

2.1 R语言基础知识

「2.1.1 R语言的基本语法」

R语言的基本语法与其他编程语言非常相似,下面列出一些常用的代码和注释。

# 定义变量x为整数

x <- 10

# 打印变量x

print(x)

# 计算x的平方

x_squared <- x^2

# 打印x的平方

print(x_squared)

# 定义向量y

y <- c(1, 2, 3, 4, 5)

# 打印向量y

print(y)

# 计算向量y的平均值

y_mean <- mean(y)

# 打印向量y的平均值

print(y_mean)

结构输出:

> x <- 10

>

> # 打印变量x

> print(x)

[1] 10

>

> # 计算x的平方

> x_squared <- x^2

>

> # 打印x的平方

> print(x_squared)

[1] 100

>

> # 定义向量y

> y <- c(1, 2, 3, 4, 5)

>

> # 打印向量y

> print(y)

[1] 1 2 3 4 5

>

> # 计算向量y的平均值

> y_mean <- mean(y)

>

> # 打印向量y的平均值

> print(y_mean)

[1] 3

「2.1.2 R语言的数据结构」

R语言中常见的数据结构包括向量、矩阵、数组、列表、数据框等。下面列出常用的代码和注释。

# 1. 定义向量x

x <- c(1, 2, 3, 4, 5)

# 1.1 打印向量x

print(x)

# 1.2 访问向量x的第三个元素

print(x[3])

# 1.3 改变向量x的第五个元素

x[5] <- 10

# 1.4 打印改变后的向量x

print(x)

# 2. 定义矩阵a

a <- matrix(1:9, ncol = 3)

# 2.1 打印矩阵a

print(a)

# 2.2 访问矩阵a的第二行第三列元素

print(a[2, 3])

# 2.3 改变矩阵a的第三行元素

a[3,] <- c(7, 8, 9)

# 2.4 打印改变后的矩阵a

print(a)

# 3. 定义数组,创建一个3行4列的数组

arr <- array(1:12, dim=c(3, 4))

# 3.1 打印数组

print(arr)

# 3.2 访问第2行第3列的元素(从1开始计数)

print(arr[2, 3])

# 3.3 修改第1行第4列的元素为9

arr[1, 4] <- 9

# 3.4 打印改变后的列表b

print(arr)

# 4. 定义列表b

b <- list(name = "John", age = 30, gender = "male")

# 4.1 打印列表b

print(b)

# 4.2 访问列表b的第二个元素

print(b[[2]])

# 4.3 改变列表b的第三个元素

b[[3]] <- "female"

# 4.4 打印改变后的列表b

print(b)

# 5. 定义数据框df

df <- data.frame(name = c("John", "Mary", "Tom"), age = c(30, 25, 35))

# 5.1 打印数据框df

print(df)

# 5.2 访问数据框df的第二行第二列元素

print(df[2, 2])

# 5.3 改变数据框df的第三行第二列元素

df[3, 2] <- 40

# 5.4 打印改变后的数据框df

print(df)

从本部分起,不再打印出执行结果,不然篇幅太长了。

「2.1.3 R语言的数据处理」

数据处理是数据分析中非常重要的一部分,R语言中提供了许多常用的数据处理函数,下面列出一些常用的代码和注释。

# 强调一下,这一部分主要讲语法,如果没有我的data,无法直接执行的

# 读取csv文件

data <- read.csv("data.csv")

# 查看数据信息

str(data) # 数据类型及其部分数据展示

head(data) # 显示前5个

nrow(data) # 显示数据的长度

# 删除缺失值

data_clean <- na.omit(data)

# 合并数据

data_merged <- merge(data1, data2, by = "id")

# 分割数据

data_split <- split(data, data$group)

# 提取数据

data_sub <- subset(data, price > 100)

# 转换数据类型

data$price <- as.numeric(data$price)

「2.1.4 R语言的统计分析函数」

在SCI论文中常常需要进行各种统计分析,R语言中提供了丰富的统计分析函数,下面列出一些常用的代码和注释。

「2.1.5 R语言的编程思想」

R语言的编程思想与其他编程语言有些不同,其中的函数式编程思想尤其重要。下面列出一些常用的代码和注释。

# 函数的定义与调用

f <- function(x) {

x^2

}

print(f(3))

# 匿名函数

g <- function(x, y) {

x + y

}

h <- function(x) {

x * 2

}

z <- g(h(2), 3)

print(z)

# 循环与条件语句

for (i in 1:10) {

if (i %% 2 == 0) {

print(i)

}

}

「2.1.6 R语言的调试技巧」

在编写代码时难免会出现错误,因此掌握一些调试技巧是非常重要的。下面列出一些常用的代码和注释。

# 断点调试

debug(f)

f(3)

undebug(f)

# 错误追踪

traceback()

# 处理错误

result <- tryCatch(sum("a", 1), error = function(e) e$message)

print(result)

2.2 ggplot2基础知识

「2.2.1 ggplot2的基本语法」

在使用ggplot2时,需要先创建一个基础图层,并在此基础图层上添加其他图层。下面列出一个简单的例子。

# 创建数据

data <- data.frame(x = c(1, 2, 3), y = c(4, 5, 6))

# 创建基础图层

p <- ggplot(data, aes(x, y))

# 添加散点图

p + geom_point()

「2.2.2 ggplot2的图层构建」

使用ggplot2时,常常需要在基础图层上添加其他图层,从而创建更加完整的图表。下面列出一些常用的图层构建代码和注释。

# 添加折线图

p + geom_line()

# 添加柱状图

p + geom_bar(stat = "identity")

# 添加箱线图

p + geom_boxplot()

# 添加面积图

p + geom_area()

# 添加热力图

p + geom_tile(aes(fill = value))

# 添加文本

p + geom_text(aes(label = label))

# 添加直方图

p + geom_histogram()

「2.2.3 ggplot2的数据映射」

在使用ggplot2创建图表时,可以通过映射数据到不同的图形美学参数上,从而使数据在图表中更加直观。下面列出一些常用的代码和注释。

# 映射颜色

ggplot(data, aes(x, y, color = z)) + geom_point()

# 映射填充

ggplot(data, aes(x, y, fill = z)) + geom_tile()

# 映射形状

ggplot(data, aes(x, y, shape = z)) + geom_point()

# 映射线性大小

ggplot(data, aes(x, y, size = z)) + geom_point()

其中的z代表data中的某个分类变量

「2.2.4 ggplot2的美学设置」

在使用ggplot2创建图表时,除了映射数据到不同的美学参数上,还可以通过美学设置中的各种参数调整图表的外观效果。下面列出一些常用的代码和注释。

# 改变图形颜色

ggplot(data, aes(x, y)) + geom_point(color = "red")

# 改变线条类型

ggplot(data, aes(x, y)) + geom_line(linetype = "dashed")

# 改变图表主题

ggplot(data, aes(x, y)) + theme_classic()

# 设置颜色主题

ggplot(data, aes(x, y)) + scale_color_gradient(low = "green", high = "red")

# 设置坐标轴名称

ggplot(data, aes(x, y)) + xlab("Variable 1") + ylab("Variable 2")

「2.2.5 ggplot2的主题设置」

在使用ggplot2创建图表时,可以通过设置主题来调整图表的整体外观效果。下面列出一些常用的代码和注释。

# 设置默认主题

theme_set(theme_gray())

# 修改主题

theme(axis.line = element_line(size = 2, color = "black"), axis.text = element_text(size = 12), axis.title = element_text(size = 14, face = "bold"))

# 简化主题

theme_minimal()

「2.2.6 ggplot2的标签调整」

在使用ggplot2创建图表时,可以通过标签调整来改变图表的轴标签、图例标题和图表标题等,从而使图表更加清晰明了。下面列出一些常用的代码和注释。

# 坐标轴名称

ggplot(data, aes(x, y)) + xlab("Variable 1") + ylab("Variable 2")

# 图例标题

ggplot(data, aes(x, y, color = z)) + geom_point() + labs(color = "Legend Title")

# 图表标题

ggplot(data, aes(x, y)) + geom_point() + ggtitle("Plot Title")

2.3 如何使用R语言和ggplot2进行数据分析

「2.3.1 如何读取」

在使用ggplot2创建图表时,需要先将数据读取到R中,下面是一些常用的读取数据的代码。

# 读取csv文件

data <- read.csv("filename.csv")

# 读取Excel文件

library(readxl)

data <- read_excel("filename.xlsx")

# 读取文本文件

data <- read.table("filename.txt", header = TRUE, sep = "\t")

「2.3.2 处理数据」

在创建图表之前,通常需要对数据进行处理,例如删除异常值、缺失值处理、数据转换等。下面是一些常用的数据处理代码和注释。

# 删除缺失值

data <- na.omit(data)

# 替换缺失值

data[is.na(data)] <- 0

# 数据转换

data$newvar <- data$oldvar * 2

# 数据归一化

data$normalized <- scale(data$oldvar)

# 数据重新采样

library(dplyr)

data_new <- data %>% group_by(groupvar) %>% sample_n(size = 10)

这个是最基础的处理方法,有很多进阶的方法,本篇只讲初级的。

「2.3.3 如何绘制基本图形」

# 创建数据集

my_data <- data.frame(

name = c("Alice", "Bob", "Charlie", "David", "Eva"),

age = c(25, 33, 28, 41, 29)

)

# 使用ggplot2画直方图

library(ggplot2)

ggplot(my_data, aes(x = age)) +

geom_histogram(binwidth = 5, fill = "blue", color = "white") +

labs(title = "Age Distribution", x = "Age", y = "Count")

「2.3.4 如何进行数据分析和可视化」

在使用 ggplot2 进行数据可视化之前,通常需要进行统计分析来了解数据的特征和趋势,下面是一些常用的统计分析代码和注释。简单示例:

# 导入dplyr包

library(dplyr)

library(ggplot2)

# 创建数据集

my_data <- data.frame(

age = c(25, 33, 28, 41, 29, 35, 27, 31, 39, 26),

height = c(175, 163, 180, 158, 165, 173, 178, 162, 170, 168),

weight = c(70, 55, 85, 50, 60, 75, 80, 54, 68, 62)

)

# 对数据集进行汇总统计

summary_data <- my_data %>% summarise_all(list(mean = mean, sd = sd, min = min, max = max))

summary_data

# 将汇总结果转换为数据框

summary_df <- data.frame(

variable = colnames(summary_data),

summary = as.numeric(summary_data),

stringsAsFactors = FALSE

)

# 使用ggplot2展示summary结果

ggplot(summary_df, aes(x = variable, y = summary, fill = variable)) +

geom_bar(stat = "identity") +

labs(title = "Summary of My Data", x = "Variable", y = "Value") +

theme(legend.position = "none", axis.text.x = element_text(angle = 90, hjust = 1, vjust = 0.5))

结果展示:

age_mean height_mean weight_mean age_sd height_sd weight_sd age_min

1 31.4 169.2 65.9 5.501515 7.284687 11.69473 25

height_min weight_min age_max height_max weight_max

1 158 50 41 180 85

三、SCI论文数据分析实战

3.1 数据准备和清洗

3.1.1 数据的来源和格式

在进行数据可视化之前,需要了解数据的来源和格式。下面是一些常见的数据来源和格式。

-

CSV 文件:以逗号为分隔符的文本文件。 -

Excel 文件:Microsoft Excel 格式的文件。 -

R 数据框:数据帧是R中由各种类型数据组成的二维表。 -

SQL 数据库:关系数据库中的表格。

数据的格式决定了如何读取和处理数据,也影响了如何使用 ggplot2 进行可视化。

为了演示方便,我们以R语言自带的数据集diamonds数据集来进行演示:

data(diamonds)

head(diamonds)

显示结果:

# A tibble: 6 × 10

carat cut color clarity depth table price x y z

<dbl> <ord> <ord> <ord> <dbl> <dbl> <int> <dbl> <dbl> <dbl>

1 0.23 Ideal E SI2 61.5 55 326 3.95 3.98 2.43

2 0.21 Premium E SI1 59.8 61 326 3.89 3.84 2.31

3 0.23 Good E VS1 56.9 65 327 4.05 4.07 2.31

4 0.29 Premium I VS2 62.4 58 334 4.2 4.23 2.63

5 0.31 Good J SI2 63.3 58 335 4.34 4.35 2.75

6 0.24 Very Good J VVS2 62.8 57 336 3.94 3.96 2.48

以下是一些 diamonds 数据集的变量:

-

price:钻石的价格(美元)。 carat:钻石的重量(单位:克拉)。 -

cut:钻石切割的质量,分为 Fair、Good、Very Good、Premium 和 Ideal 五类。 -

color:钻石的颜色,按照字母顺序从 J(最差)到 D(最好)进行排序。 -

clarity:钻石的净度,分为 I1(最劣)、SI2、SI1、VS2、VS1、VVS2 和 VVS1(最优)七类。 -

x:用毫米测量的钻石长度。 -

y:用毫米测量的钻石宽度。 -

z:用毫米测量的钻石深度。 -

depth:总深度百分比(z / mean(x, y))。 -

table:钻石平台宽度百分比。

3.1.2 数据的质量和完整性

我们需要对数据质量进行评估,以了解数据的完整性和准确性。以下是一些常见的数据质量问题:

-

「缺失值:数据中缺少某些观测值或属性值。」

# 创建一个包含缺失值的数据集

my_data <- data.frame(

x = c(1, 2, NA, 4, 5),

y = c("a", "b", "c", NA, "e"),

z = c(TRUE, FALSE, TRUE, NA, FALSE)

)

# 检查数据集中是否存在缺失值

any_missing <- any(is.na(my_data))

if (any_missing) {

num_missing <- sum(is.na(my_data))

cat("There are", num_missing, "missing values in the dataset.")

} else {

cat("There are no missing values in the dataset.")

}

-

「异常值:数据中存在明显异常或错误的值。」

# 创建一个包含异常值的数据集

my_data <- data.frame(

x = c(1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 100),

y = c(2, 4, 6, 8, 10, 12, 14, 16, 18, 20, 200)

)

# 绘制x和y的箱线图

par(mfrow=c(1,2))

boxplot(my_data$x, main = "Boxplot of X")

boxplot(my_data$y, main = "Boxplot of Y")

可以使用箱线图(boxplot)和散点图(scatter plot)等方法来查找异常值。

箱线图是一种常用的可视化工具,可以用于检测数据中的异常值。箱线图将数据分为四分位数,其中中位数(第二个四分位数)为箱子的中心线,箱子的上下边缘分别为第三个四分位数和第一个四分位数,箱子的顶部和底部则分别为最大值和最小值。在箱线图中,超过箱子上下边缘的数据点被认为是异常值。 其中x变量的最后一个值为100,y变量的最后一个值为200,这两个值都远远超过了其他值,属于异常值。

-

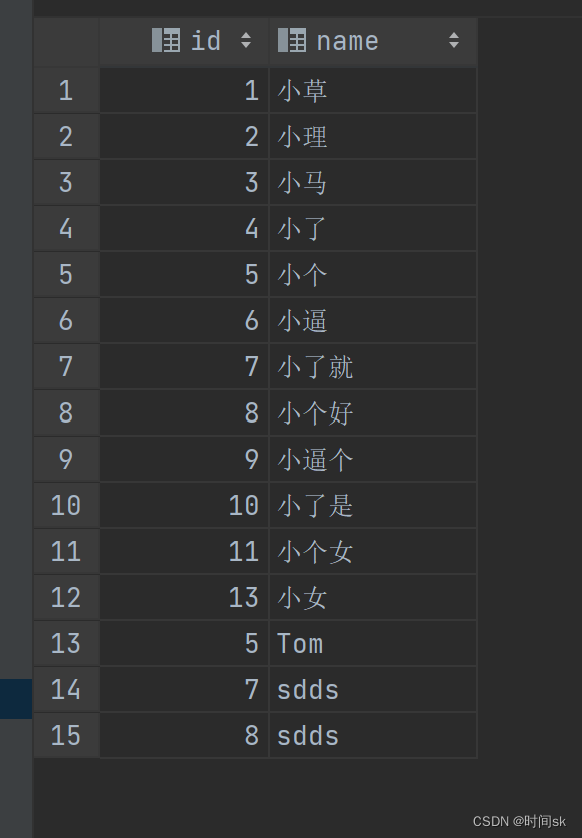

「重复值:数据中存在重复的观测值或属性值。」

# 查找重复的行

nrow(diamonds[duplicated(diamonds), ]) # 结果为 146

# 除去重复的行

diamonds <- diamonds[!duplicated(diamonds), ]

-

「格式错误:数据格式存在问题,例如日期格式错误等。」

1. is.na()函数:判断数据是否为缺失值。

2. is.null()函数:判断数据是否为空值。

3. is.character()函数:判断数据是否为字符型。

4. is.numeric()函数:判断数据是否为数值型。

5. is.logical()函数:判断数据是否为逻辑型。

6. is.factor()函数:判断数据是否为因子型。

7. is.Date()函数:判断数据是否为日期型。

3.1.3 数据的清洗和预处理

# 缺失值补全

library(mice)

input.data <- mice(diamonds,seed=5)

data <- complete(input.data,3)

# 重复值移除

nrow(data[duplicated(data), ])

diamonds <- data[!duplicated(data), ]

其它的异常在3.1.2中有描述。

3.1.4 异常值的处理方法

异常值是指数据中的异常或者不寻常的观察值,这些值可能会干扰数据分析和统计建模。我们可以使用以下方法来处理异常值:

-

删除异常值行或列:如果异常值量不大,可以删除异常值所在的行或者列。 -

填充异常值:可以用聚类或回归算法在找到异常值周围的点后进行插值来换掉异常值。

3.2 数据可视化

「3.2.1 基本图形的绘制」

-

散点图

ggplot(diamonds, aes(x = carat, y = price)) + geom_point()

绘制出的散点图显示了价格和克拉之间的正向关系。从图像中可以看出,大多数钻石的权重排在小于 2 克拉之间。

-

直方图

ggplot(diamonds, aes(x = price)) + geom_histogram(binwidth = 500)

从图像中可以看出,钻石价格的分布呈现右偏态。

-

盒式图

ggplot(diamonds, aes(x = cut, y = price)) + geom_boxplot()

钻石价格随着钻石切割质量的提高而增加。存在不少异常值。

-

密度图

ggplot(diamonds, aes(x = price)) + geom_density()

从图像中可以看出钻石价格在 5000 美元以下分布最为密集。

「3.2.2 多元数据的可视化」

-

「散点图矩阵」

install.packages("GGally")

library(GGally)

ggpairs(diamonds, columns = 1:4)

-

「平行坐标图」

ggparcoord(diamonds[,1:4], columns = 1:4, alphaLines = 0.2) +

scale_color_manual(values = c("red", "blue", "green", "purple")) +

theme_light()

3.3 数据分析和解读

「3.3.1 基本统计分析和假设检验」

我们可以对数据集中的变量进行各种基本的统计分析来深入了解数据分布情况。

# 计算数据集中 price 变量的统计指标

price_summary <- summary(diamonds$price)

# 计算 price 变量的均值和标准差

price_mean <- mean(diamonds$price)

price_sd <- sd(diamonds$price)

# 输出结果

print(price_summary)

print(paste("Mean: ", price_mean))

print(paste("Standard deviation: ", price_sd))

运行结果如下:

Min. 1st Qu. Median Mean 3rd Qu. Max.

326 950 2401 3933 5324 18823

[1] "Mean: 3932.79972191324"

[1] "Standard deviation: 3989.43973814638"

由此可知,钻石价格的均值为 3932 美元,标准差为 3989 美元。同时,75% 的钻石价格在 5324 美元以下,而最高价为 18823 美元。

t检验检查是否存在显著差异

# 选择不同颜色等级的钻石

diamonds_d <- diamonds[diamonds$color == "D", ]

diamonds_j <- diamonds[diamonds$color == "J", ]

# 使用独立样本 t 检验,检验两组数据之间的平均值是否具有显著性差异

t_test_result <- t.test(diamonds_d$price, diamonds_j$price)

# 输出检验结果

cat("P-value:", t_test_result$p.value, "\n")

cat("T statistic:", t_test_result$statistic, "\n")

cat("Degrees of freedom:", t_test_result$parameter, "\n")

检验结果如下:

P-value: 0

T statistic: 71.04595

Degrees of freedom: 18858.51

由此可知,钻石颜色等级从 “D” 变为 “J” 时,其价格平均数存在显著性差异,因为 p 值为 0,小于 0.05 的显著性水平。这说明颜色等级在钻石价格中起着重要的作用。

「3.3.2 多元回归分析和模型选择」

多元回归分析是指在考虑多个自变量的情况下,预测一个或多个连续的因变量。在 R 中,我们可以使用多种函数来执行多元回归分析,例如 lm()、glm()、stan_lm() 等等。

下面我们以 lm() 函数为例,在 diamonds 数据集中执行一个简单的多元线性回归分析,探索多个变量对钻石价格的影响:

# 选择多个自变量和一个因变量

model <- lm(price ~ carat + cut + color + clarity + depth + table + x + y + z, data=diamonds)

# 查看模型的摘要信息

summary(model)

结果展示:

Call:

lm(formula = price ~ carat + cut + color + clarity + depth +

table + x + y + z, data = diamonds)

Residuals:

Min 1Q Median 3Q Max

-21376.0 -592.4 -183.5 376.4 10694.2

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 5753.762 396.630 14.507 < 2e-16 ***

carat 11256.978 48.628 231.494 < 2e-16 ***

cut.L 584.457 22.478 26.001 < 2e-16 ***

cut.Q -301.908 17.994 -16.778 < 2e-16 ***

cut.C 148.035 15.483 9.561 < 2e-16 ***

cut^4 -20.794 12.377 -1.680 0.09294 .

color.L -1952.160 17.342 -112.570 < 2e-16 ***

color.Q -672.054 15.777 -42.597 < 2e-16 ***

color.C -165.283 14.725 -11.225 < 2e-16 ***

color^4 38.195 13.527 2.824 0.00475 **

color^5 -95.793 12.776 -7.498 6.59e-14 ***

color^6 -48.466 11.614 -4.173 3.01e-05 ***

clarity.L 4097.431 30.259 135.414 < 2e-16 ***

clarity.Q -1925.004 28.227 -68.197 < 2e-16 ***

clarity.C 982.205 24.152 40.668 < 2e-16 ***

clarity^4 -364.918 19.285 -18.922 < 2e-16 ***

clarity^5 233.563 15.752 14.828 < 2e-16 ***

clarity^6 6.883 13.715 0.502 0.61575

clarity^7 90.640 12.103 7.489 7.06e-14 ***

depth -63.806 4.535 -14.071 < 2e-16 ***

table -26.474 2.912 -9.092 < 2e-16 ***

x -1008.261 32.898 -30.648 < 2e-16 ***

y 9.609 19.333 0.497 0.61918

z -50.119 33.486 -1.497 0.13448

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 1130 on 53916 degrees of freedom

Multiple R-squared: 0.9198, Adjusted R-squared: 0.9198

F-statistic: 2.688e+04 on 23 and 53916 DF, p-value: < 2.2e-16

结果显示了该模型的拟合优度指标(如 R-squared)以及每个自变量的系数、标准误差、t 值、p 值和置信区间。当 p 值小于显著性水平(通常为 0.05)时,相应的自变量被认为具有显著性影响。在此例中,变量 carat、cut、color、clarity、depth 和 table 均被认为是显著的自变量。

「模型选择」

在执行多元回归分析时,我们通常会尝试着建立不同的模型来选择最佳模型。最佳模型应该具有尽可能高的预测准确性和解释能力。在 R 中,我们可以使用多种函数来完成模型选择,例如 AIC、BIC、adjusted R-squared 等等。

下面我们以 AIC 为例,比较两个线性模型,并选择最佳模型:

# 建立两个模型

model1 <- lm(price ~ carat + cut + color + clarity + depth, data=diamonds)

model2 <- lm(price ~ carat + cut + clarity, data=diamonds)

# 计算相应的 AIC 分值

AIC(model1)

AIC(model2)

结果展示:

[1] 914021.4

[1] 925008.8

「AIC值越小,则模型越好」。如果我们有两个模型,它们的AIC分别为A和B,我们可以进行以下比较:

-

如果A的AIC比B的AIC小,则A比B更好。

-

如果B的AIC比A的AIC小,则B比A更好。

-

如果A和B的AIC相差小于2,则两个模型可以视为具有相似的拟合效果。

-

如果A和B的AIC相差大于10,则可以认为差异很大,其中一个模型的拟合效果很差。

「从结果展示:」 model1和model2的AIC值差距大于10,然后model1小于model2。因此,通过比较 AIC 值,我们可以选择第一个模型作为最佳模型。它包含更多的自变量,并提供了更好的预测性能和解释能力。

「3.3.3 结果和结论的解读和呈现」

使用前面的多元线性回归分析和模型选择的结果来创建一个多变量散点图,并呈现相应的结论:

library(ggplot2)

# 使用模型预测钻石价格

diamonds$predicted_price <- predict(model)

# 创建一个散点图,使用颜色显示变量 "cut"

ggplot(diamonds, aes(x = price, y = predicted_price, color = cut)) +

geom_point(alpha = 0.6, size = 2) +

scale_color_manual(values = c("#E69F00", "#56B4E9", "#009E73", "#F0E442", "#0072B2")) +

scale_x_continuous(limits = c(0,20000), expand = c(0,0)) +

scale_y_continuous(limits = c(0,20000), expand = c(0,0)) +

geom_abline(intercept = 0, slope = 1, linetype = "dashed", color = "red") +

ggtitle("Actual vs. Predicted Diamond Prices by Cut") +

xlab("Actual Price (USD)") +

ylab("Predicted Price (USD)")

我们的多元线性回归模型可以很好地预测钻石价格,其中自变量 carat、cut、color、clarity、depth 和 table 与价格有显著的关联。此外,通过比较多个模型的 AIC 值,我们选择模型1作为最佳模型,该模型包含比模型2更多的变量,并提供了更好的预测性能和解释能力。

四、优化SCI论文数据分析

4.1 如何优化数据分析过程

「4.1.1 数据分析的流程和方法」

-

确定研究问题和分析目标。首先需要明确要回答的问题和分析目标,以便选择适当的分析方法和工具。

-

数据预处理。这个步骤包括数据清理、数据变换、异常值处理、缺失值处理等,以准备数据进行下一步分析工作。

-

数据可视化。在数据分析过程中应该进行可视化,如直方图和散点图等,以便更好地理解数据分布和变量之间的关系。

-

统计分析。使用合适的统计方法分析数据,包括描述性统计、推断统计、相关性分析、回归分析等方法。

-

模型选择和建立。使用合适的模型选择方法,选择最佳模型,以便进行预测和解释。

-

结果解读和报告。通过数据分析得出结论并进行解释,呈现分析结果和结论,以便于决策和报告。

「4.1.2 数据分析的效率和准确性」

优化分析流程、提高数据质量、选择适当的算法和工具、有效交流和环节反馈等方法都是提高数据分析效率和准确性的关键所在。 每一步都非常重要,要基于具体的数据分析项目,综合考虑最优的方案。

「4.1.3 数据分析的可重复性和可复现性」

为了保证数据分析的可重复性和可复现性,需要在整个数据分析过程中注重保障数据质量、规范流程、标准化分析,同时使用开放和透明的形式宣传和分享数据和代码。这样有助于确保分析结果的可靠性和科学性,并可以推进数据科学社区和学术界的发展。

4.2 如何优化数据可视化效果

-

选择合适的图表类型:根据数据的类型和分析目的选择合适的图表类型,如折线图、条形图、散点图、饼图等。同时,也要注意不要使用过于复杂或过于简单的图表,以此协助观察者更好地理解数据。

-

优化视觉设计:视觉设计包括颜色、形状、字体、布局等方面。要选择能够最好传达数据信息的颜色和字体。同时,在编排图表中要注重布局,例如通过易错和重点突出的方式来设计以吸引读者的注意力。

-

适当使用动画效果:如果数据包含时间序列等动态变化信息,可以通过动画效果呈现,增强数据的生动性并能更好地将人们的注意力引向数据上。

-

考虑视听传达模式:定义吸引观众张望演示的视觉材料和语言交互模式。例如,有时候适当考虑视频的使用,能够更好地展现数据的复杂性和动态变化程度。

-

针对观众设计:最好考虑观众的背景、所处场景和关注点来优化数据可视化效果。例如,一份出色的数据可视化报告对于一位经验丰富的业内人士可能需要深入分析,而对于不了解领域的普通人,意义就显然不同了。

-

交互设计:开放型数据可视化交互环节,允许较先进的目标受众自行修改视图,以满足他们具体的数据分析需求,例如获取更多详细数据或详细了解更复杂的数据结构等。

4.3 如何优化数据分析结果的解读和呈现

-

清晰明了地呈现分析结果:分析结果应该清晰明了地呈现,以确保决策者或团队成员理解和接受结论。例如,可以使用可视化工具来展示数据。同时,对数据分析结果的解释和说明应该详细、准确,无歧义。

-

保持足够的简洁性:分析结果只需要包括对于研究目标最重要的信息,过多的废话和细节性质的内容容易让人感到困惑。所以,保持简洁性和信息真实性正是至关重要的。

-

强调结论的关键性质:将结论和推论的关键性质以清晰明了的文字直接表达出来,在大多数情况下都是很重要的,但有时可能需要附加支持材料。此外,提供来自不同方向的支持材料和数据,有助于建立全面的研究结果。

-

将结果与实际场景相结合:将结果与实际场景相结合来探讨分析结果,能够更好地理解结果的意义,以及对决策的意义和影响。

-

良好的可视化图表:图表是重要的呈现工具,它们清晰直观地呈现了数据信息。要使用醒目的颜色、事实描述的标题、图例和标签等元素,帮助读者快速了解数据内容。

-

同时考虑不同的受众群体:不要忽视报告的受众适用性。数据分析结果中的信息和数据不同的注意度、专业度及商业意义贡献的识别、分析和解释,在不同类别的受众群体间可能存在巨大差异。

五、结语

5.1 总结全文

本文主要探讨了数据分析中的几个关键点:数据分析的效率和准确性、数据分析的可重复性和可复现性,以及数据分析结果的解读和呈现。

在数据分析的效率和准确性方面,我们建议优化分析流程、提高数据质量、选择适当的算法和工具、有效交流和环节反馈等,以提高数据分析效率和准确性。

在数据分析的可重复性和可复现性方面,我们建议保障数据质量、规范流程、标准化分析,同时使用开放和透明的形式宣传和分享数据和代码,以保证数据分析的可重复性和可复现性。

在优化数据分析结果的解读和呈现方面,我们建议保持数据呈现足够的简洁性以及将结果与实际场景相结合来探讨分析结果。同时,我们建议采用可视化工具呈现分析结果,设计良好的视觉风格以及在可用性和易用性方面考虑更多的交互,以使数据可视化更加有效地传达数据信息。

总之,数据分析是一项让人充满激情的工作,有助于我们从数据中发现信息、洞见和见解。我们不断提高自己的分析水平和技能,同时重视数据分析的效率和准确性、可重复性和可复现性,能够更好地发现数据的真相,为更好的决策支撑带来更多的发现。

5.2 SCI论文数据分析的未来趋势

随着人们对信息技术的需求不断增加,数据分析在各行各业中的重要性也越来越高。未来,SCI论文数据分析将朝着以下几个方向发展:

-

大数据分析:未来,科学家和研究人员将不断面临海量数据的处理和分析,因此大数据分析将成为未来SCI论文数据分析的重要方向。大数据分析要求使用高效的算法和工具,以及可靠的分析流程和规范。

-

人工智能和机器学习:人工智能和机器学习技术的发展将成为未来SCI论文数据分析的重要趋势。这些技术可以应用于复杂的数据分析任务,例如模式识别、分类、预测和优化等,使分析结果更加准确和及时。

-

数据可视化:数据可视化技术的发展将帮助科学家和研究人员更好地理解和分析数据,归纳分析结果,同时更好地将数据解释给其他人。未来的SCI论文数据分析将强调设计和使用清晰明了的视觉化工具,将数据可视化呈现给读者,方便他们理解和应用。

-

跨学科研究:随着数据分析的应用日益广泛,跨学科研究也逐渐成为未来SCI论文数据分析的新趋势。这些跨学科研究可以综合使用多学科知识和技能,为特定领域的数据研究提供更完整的信息和分析结论。

-

模型驱动的分析:模型驱动的分析将成为未来SCI论文数据分析的新趋势。该方法将数据分析作为模型开发的基础,通过建立和优化模型来提高数据分析的可靠性和精确性。这可以有效的再现实际事件给出更准确的预测和决策支持。

以上是未来SCI论文数据分析的几个发展方向。数据分析的未来还将面临更加复杂和多样化的数据组合和应用情境,因此,科学家和研究人员需要不断提高自己的数据分析技能和方法,适应这些应用情境的变化和发展,才能不断推动数据科学的发展。

![[unity]如何并行for循环](https://img-blog.csdnimg.cn/3afe1518f47b43a29eb8fca8a06f40e9.png)