目录

中文分词器ik分词器

介绍

安装

使用分词器

Ik分词器配置文件

Mysql 热更新词库

中文分词器ik分词器

介绍

中文分词器按照中文进行分词,中文应用最广泛的是ik分词器

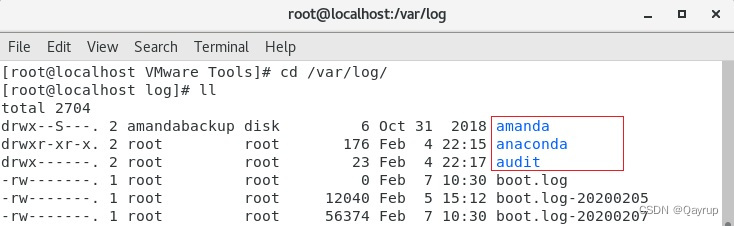

安装

官网下载对应版本zip

下载 放到 plugins 目录 新建 ik文件夹 考入解析zip

重启 es

//分成小单词

使用分词器

ik_max_word分成小单词

get /_analyze

{

"analyzer":"ik_max_word",

"text":"周日没顾上看"

}

//分成小句子

get /_analyze

{

"analyzer":"ik_smart",

"text":"周日没顾上看"

}

//存储用小单词存储查询用句子分词器查询

Put /myindex

{

“mappings”:{

“properties”:{

“text”:{

“type”:”text”,

“analyzer”:”ik_max_word”,

“search_analyzer”:”ik_smart”

}

}

}

}

put /myindex/_doc/1

{“text”:”中华人民共和国大会堂”}

Get /myindex/_search?q=text

:中华人民共和国大会堂

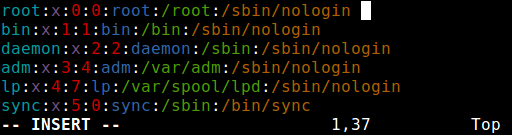

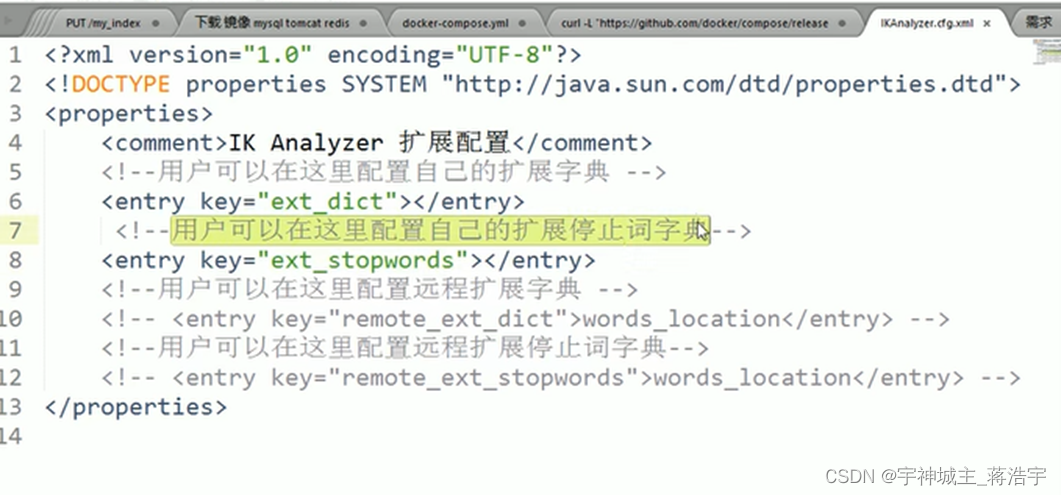

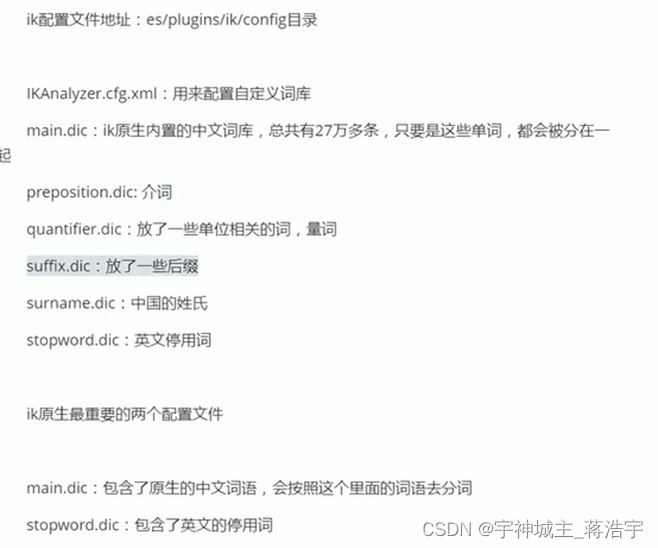

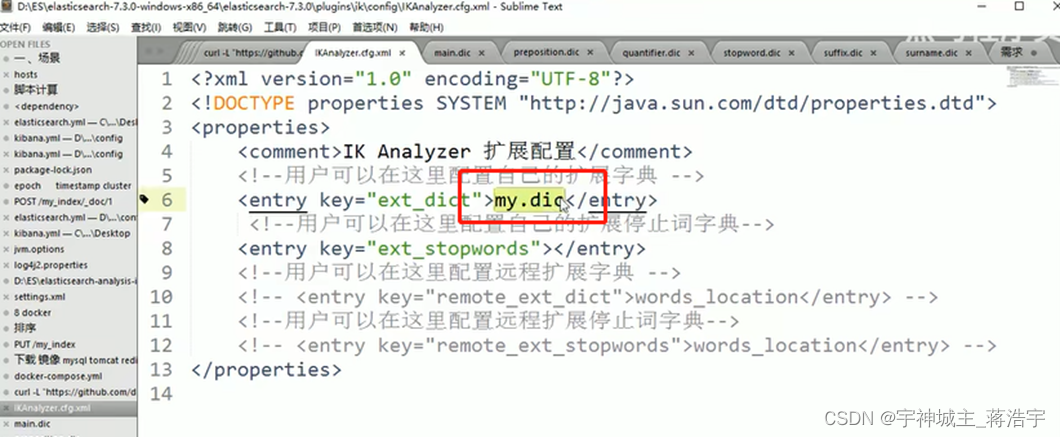

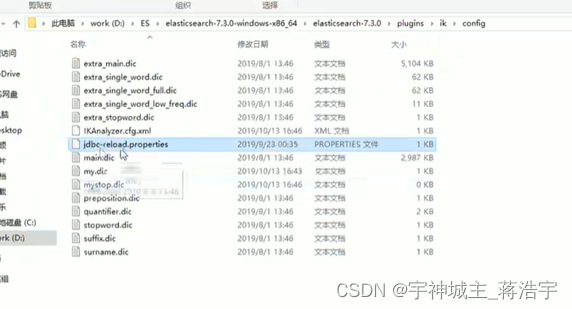

Ik分词器配置文件

Ikkarayzer.cfg.xml

可以配置常用值,和停用值

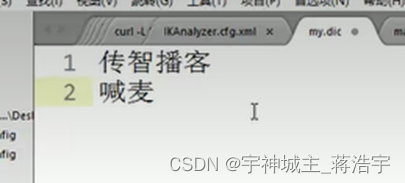

自定义新词文件,可加 新索引词,和停止字典词,重启即可

建立 my.dic 文件写入

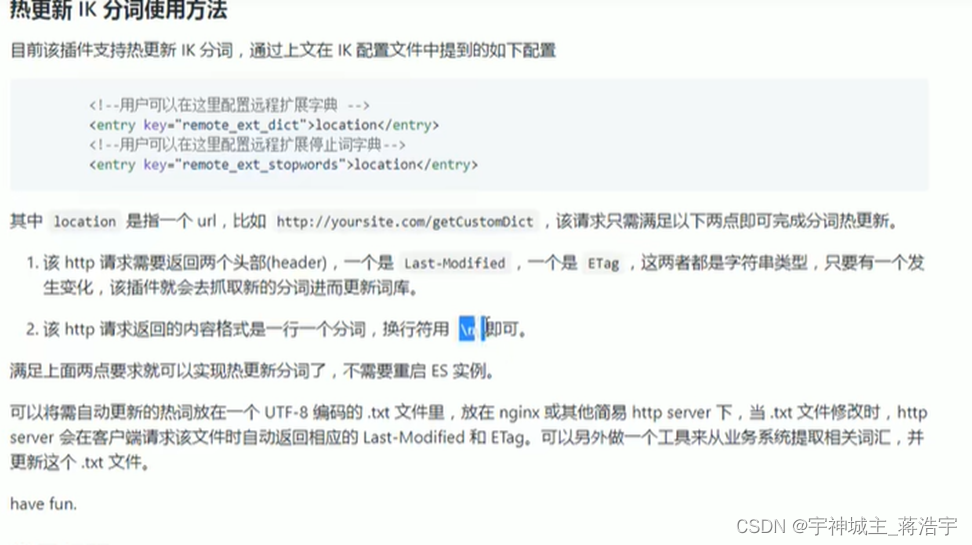

Mysql 热更新词库

因为普通的更新词库需要重启es 不合适

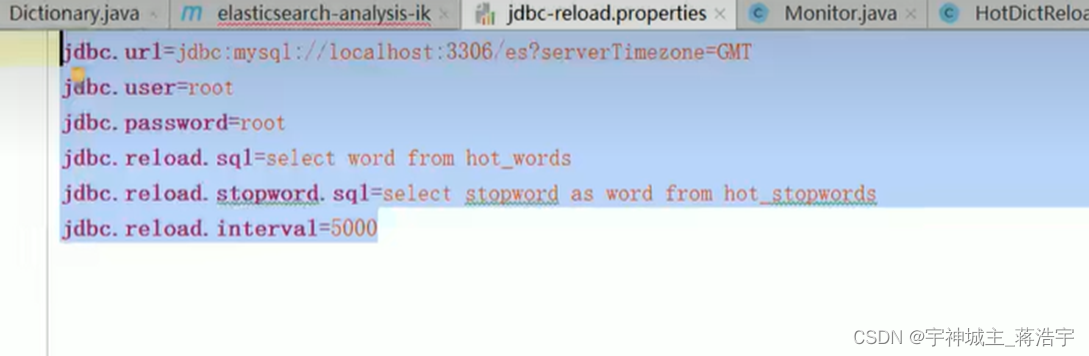

后端写一个接口服务,在配置中配置上远程获取服务接口

官方推荐实现改ik源码实现

官方推荐直接修改源码读取数据库数据

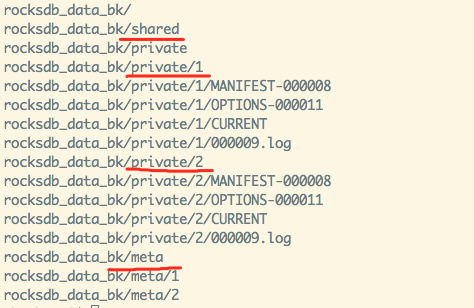

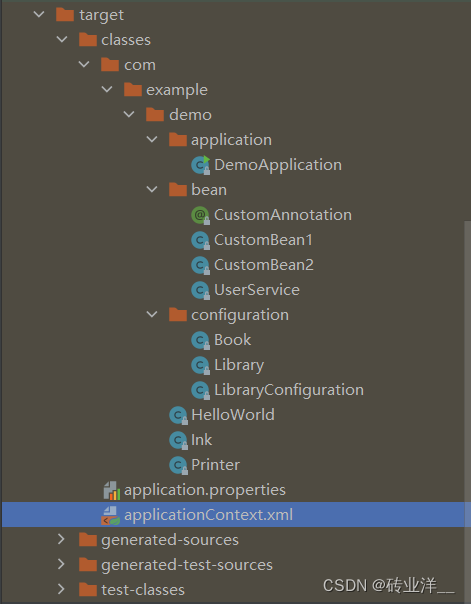

下载源码

Idea 导入项目mvaen

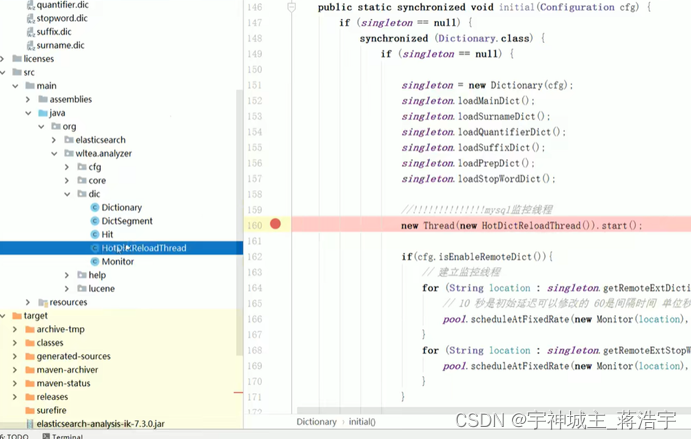

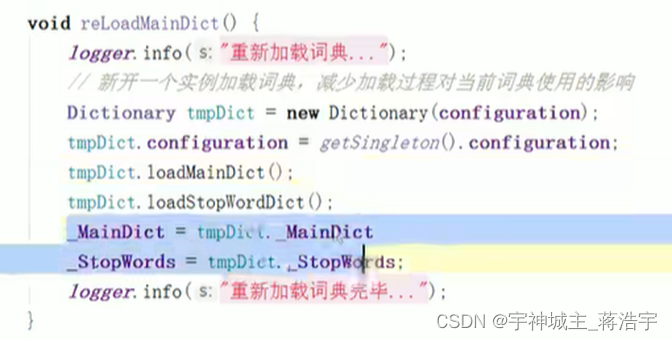

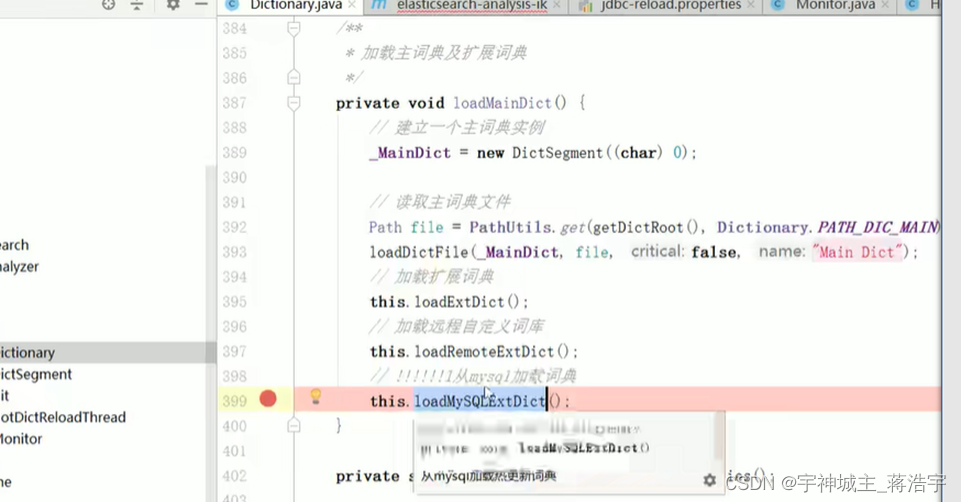

改源码

Org.witea.analyzer.dic.Dictionary 160 行代码

加载主词典和停用词典

加载mysql 词典

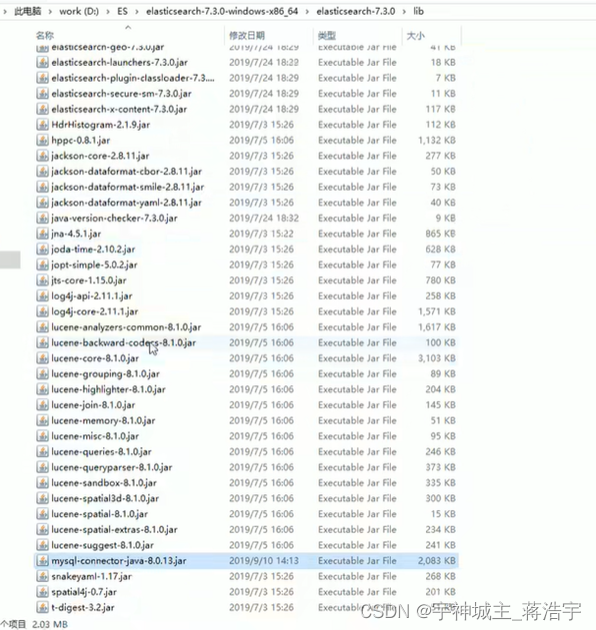

加载mysql驱动

加载mysql.pom配置依赖

获取数据

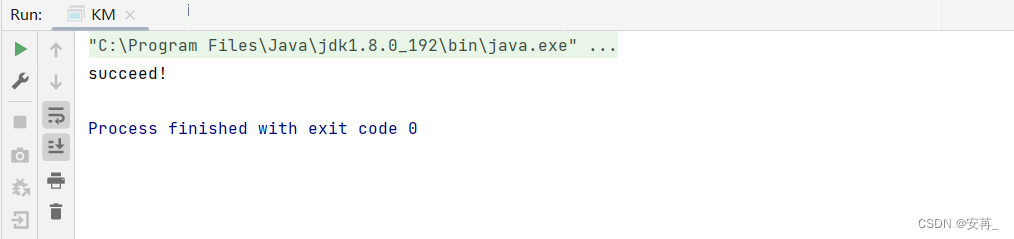

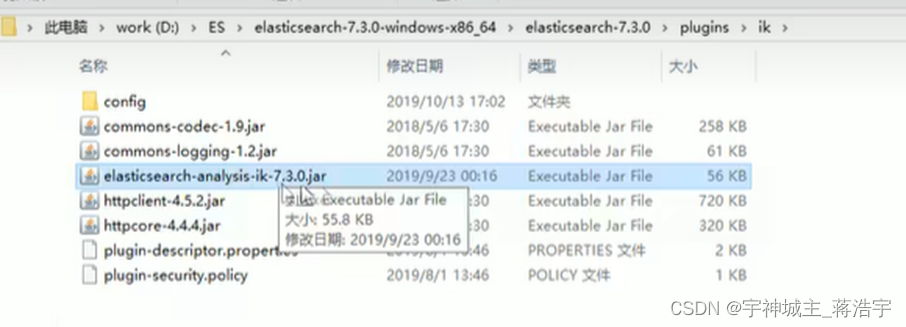

打包替换jar

配置文件拷贝

Mysql驱动包拷贝

ok

持续更新

![C嘎嘎~~[谈谈C++的一些优化]](https://img-blog.csdnimg.cn/1cccbf4aa678484d99688c8cbb146379.png)