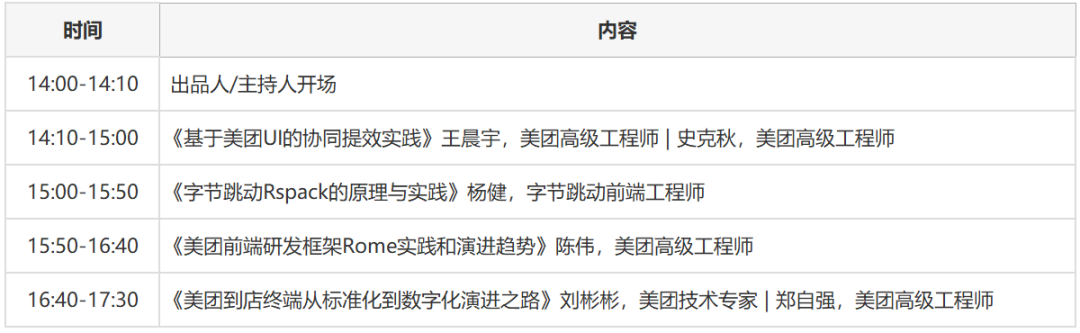

数据智能产业创新服务媒体

——聚焦数智 · 改变商业

随着人工智能的飞速发展,尤其是大型AI模型、AIGC的崛起,对AI算力产生了巨大的需求。以GPU为核心的算力供给,已经成为大模型、AIGC乃至整个智能产业发展的关键基础设施。因此,对于有志于在大模型产业掘金的企业,寻找到合适的算力合作伙伴,是其发展业务的重要基础。那么,应该如何筛选GPU算力合作伙伴呢?

作为全球云计算巨头的谷歌云,在GPU算力供应方面有三大优势:算力供应充足,在全球主要区域都有GPU现货;能提供多款高端GPU,包括A100、L4等;价格实惠,能帮用户节省超过50%的成本。

全球大量GPU现货,多款高端GPU

进入2023年,ChatGPT为代表的大模型应用以极快的速度渗透进各行各业,极大的增加了对AI算力的需求,“算力荒”现象日益凸显,甚至出现GPU“一芯难求”的困境。全球各个互联网巨头、云厂商、AI企业等都加入了抢购GPU的行列,典型的如马斯克紧急抢购1万块GPU。就国内市场来看,国内云厂商拥有超过1万枚GPU的企业预计不超过5家,然而有GPU算力需求的企业则早已超过10万家,且这个数据还在快速增长。快速膨胀的算力需求,让云厂商的GPU算力供应捉襟见肘。巨头的处境尚且如此,中小型AI企业尤其是创业公司的算力短缺现象则更加严重。

在这样的算力短缺环境中,拥有大量GPU储备的谷歌云无疑是一个很好的合作伙伴。目前,谷歌云可以提供共7种类型的英伟达GPU,涵盖A100、L4、T4、V100、K80、P100、P4,可满足多样化的应用需求。

谷歌云所支持的英伟达GPU类型

并且,谷歌云的GPU不仅种类丰富,供应能力也全球领先。以A100 GPU的A2机型为例,谷歌云可覆盖亚太、欧洲、北美的8个Region,15个zone;其他类型GPU则可覆盖21个region,51个zone。对于有出海需求的企业,谷歌云可在全球为其提供充足的GPU算力供应,支撑其业务的全球化布局。

谷歌云的全球计算资源分布

需要指出的是,要更好推动大模型、AIGC产业的发展,GPU不仅要量足,还要质优,即不断提升GPU计算性能。谷歌云在提供先进AI算力方面,一直走在行业前列。2023年4月4日,谷歌云率先发布业界首个由英伟达最新型号L4 Tensor Core GPU驱动的云虚拟机G2,专为AIGC等大型推理AI工作负载而构建。

根据测算,如果从英伟达T4 GPU切换到L4 GPU,可以获得2 -4倍的性能提升;通过从英伟达A10G GPU切换到具有L4 GPU的G2实例,用户可以节省40%的成本。作为通用GPU产品,G2实例还有助于加速其他工作负载,在HPC、视频转码方面、模型训练和应用方面提供显著的性能改进。此外,谷歌云持续构建HPC云上解决方案,为用户的高性能计算业务提供澎湃的算力支持。

极致性价比,可为用户节省超50%算力成本

无论是大模型的训练还是推理应用,都异常的“烧钱”。以引爆市场的ChatGPT为例,其模型训练需要用到上万块GPU,耗资上亿美元。此外,在其日常运营过程中,据半导体研究公司SemiAnalysis的首席分析师Dylan Patel测算,ChatGPT每天的运营成本预计高达70万美元。依据国盛证券发布的《ChatGPT需要多少算力》报告,训练一次大模型的成本介于200万美元至1200万美元之间,这对于大模型、AIGC创业公司以及其他AI应用公司而言,是一个不可忽视的门槛。

为了推动AI应用尤其是大模型应用的发展,谷歌云在降低GPU算力成本方面做了大量的工作,可以帮助用户大幅节省算力成本。

那么,谷歌云是如何实现如此大幅度的成本节省的呢?具体来看,谷歌云通过自定义实例规格、Spot实例选用、多种折扣模式等方式,来帮助客户降低算力成本。

1、灵活配置GPU资源,自定义机型、实例规格

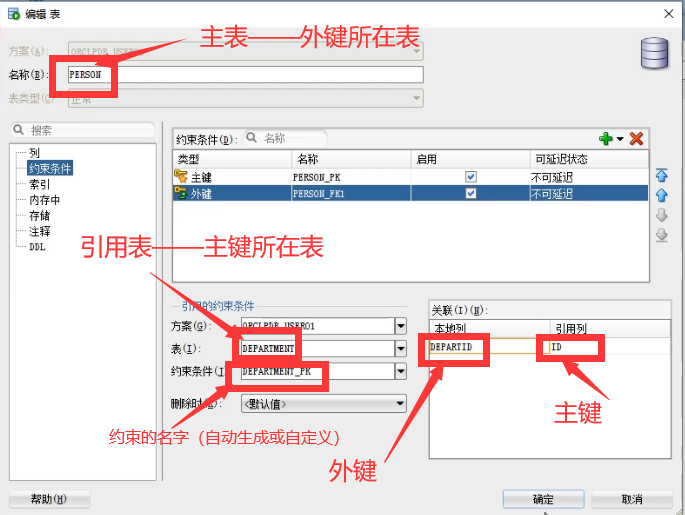

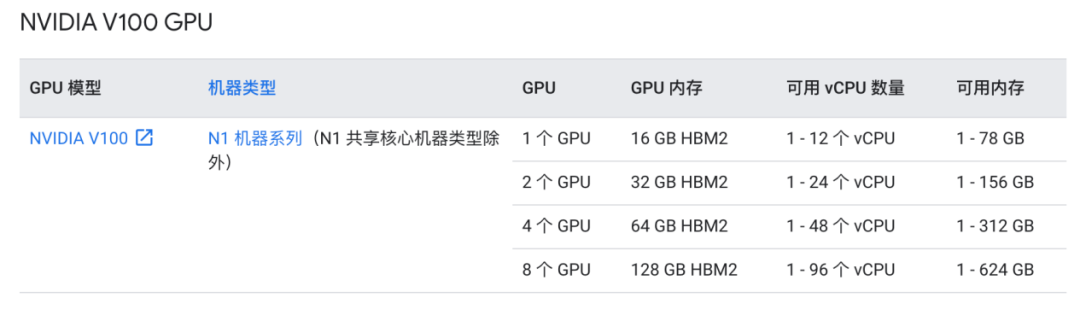

与其他云厂商将GPU与云主机进行了封装和绑定不同,谷歌云以直通模式将GPU提供给用户,以便用户直接控制GPU及其关联的内存,也实现了GPU与Compute Engine解耦。除了A100和L4系列外任何类型的GPU,均可与N1系列的所有规格进行自定义搭配,可实现高达96vCPU、624GB算力内的任意选择,灵活满足不同规模用户的需求。

谷歌云 英伟达 V100类型主机可用规格

V100 GPU资源灵活选择示例

谷歌云除A2与G2以外配备GPU的云主机,均可以自定义实例规格,使得用户可以根据实际需求来定制CPU和内存的规格。用户在进行算力选择时,不局限于比率,也不必选择超过实际需求的较高规格,从而避免额外费用。

谷歌云主机自定义规格界面示例

2、Spot实例选用

谷歌云提供Spot实例选用服务,Spot 虚拟机使用过剩的 Compute Engine 容量,提供与常规计算实例相同的机器类型、选项和性能。Spot是一种适合批处理作业和容错工作负载的计算实例,对于Stable Diffusion类可容错型应用,可以承受可能的实例抢占,使用Spot虚拟机可以节省高达91% 的费用。

3、多种折扣模式

为了进一步降低用户的算力成本,谷歌云还为用户提供多种折扣模式。具体来看,谷歌云推出持续使用折扣、基于资源的承诺使用折扣、灵活承诺使用折扣三种模式,三种模式均无需预付,并且可以叠加使用。

持续使用折扣模式下,Compute Engine 为使用时间超过结算月份的 25% 且未获得任何其他折扣的资源,提供持续使用折扣 (SUD),该折扣随着使用量的增加而增加。对于运行整个月的虚拟机实例,通过持续使用折扣可以获得高达30%的资源成本净折扣。

对于Compute Engine,虚拟机实例在购买1年期或3年期的承诺后,谷歌云还提供基于资源的承诺使用折扣、灵活承诺使用折扣两种方式。

基于资源的承诺使用折扣(或基于资源的 CUD),适用于资源使用量稳定、可预测的用户和场景,该折扣适用于 vCPU、内存、GPU、本地 SSD、单租户节点和软件许可。通过基于资源的承诺使用折扣,用户的硬件最高可获得70%的折扣,软件最高可获得79%的折扣。

Compute Engine 灵活承诺使用折扣,基于支出金额的 CUD,灵活CUD不限制该 Cloud Billing 帐号内的项目和区域,适用于任何通用和计算优化机器类型的 vCPU 和内存。通过灵活承诺使用折扣,用户1年期承诺的每小时支出金额可享受 28% 的折扣,3 年期承诺的每小时支出金额可享受 46% 的折扣。

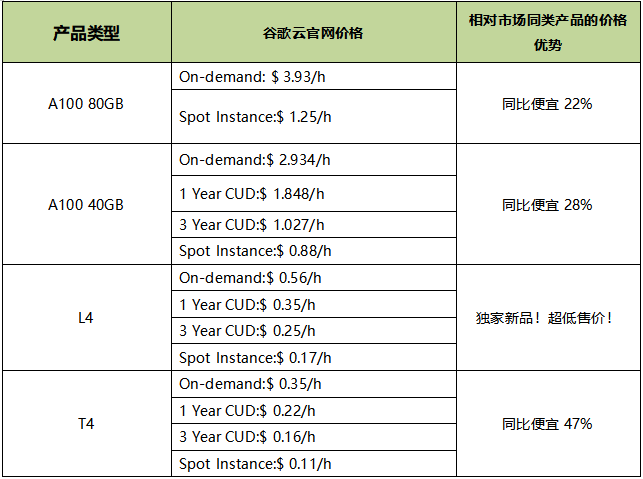

企业客户可以综合应用谷歌云提供的各种优惠策略,来降低其算力成本。据测算,相对于市场上其他云厂商提供的同类GPU产品,谷歌云提供的GPU服务价格普遍要低几十个百分点。例如,谷歌云的A100 80GB产品同比便宜22%;A100 40GB产品同比便宜28%;T4产品同比便宜47%。此外,谷歌云还独家提供L4产品,并且也维持了超低售价。

此外,谷歌云的Compute Engine会根据 Cloud Monitoring在过去8天中收集的系统指标,自动生成成本优化建议,用户可以采用这些建议来调整实例机器类型的容量,帮助优化虚拟机实例的资源利用率,将成本优化做到极致。

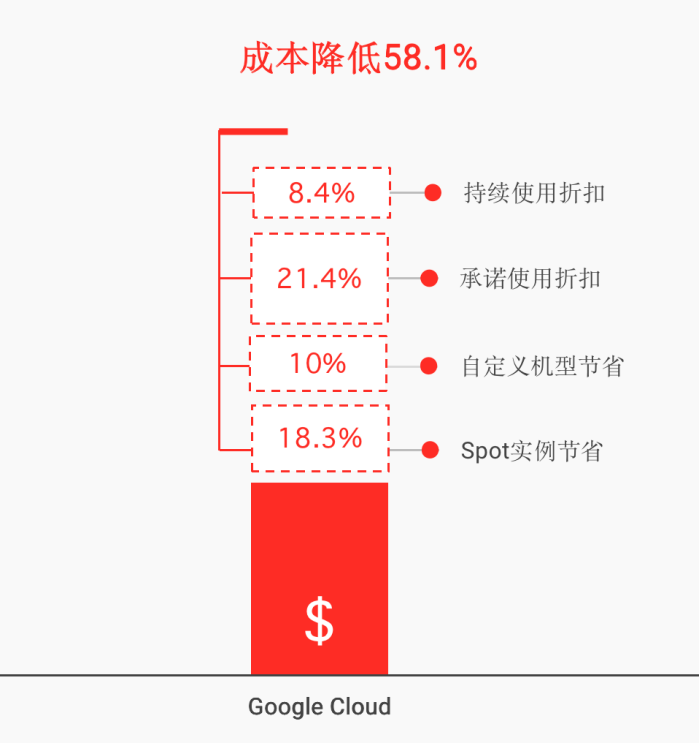

以谷歌云的某客户为例,据测算,基于谷歌云的成本节省策略,该客户整体可节省58.1%的成本。其中,通过Spot实例可节省18.3%的成本,通过自定义机型可节省10%的成本,通过承诺使用折扣可节省21.4%的成本,通过持续使用折扣可节省8.4%的成本。

谷歌云Compute Engine成本优化参考模型

4、通过WebEye购买GPU,可获得专属折扣。

值得指出的是,除了上面提到的成本节省策略外,用户还可通过WebEye得到专属GPU算力购买折扣,获得比谷歌云官网更优惠的价格。

WebEye是谁,凭什么有这个“特权”呢?

WebEye作为业界领先的数据智能企业,可为客户提供多样化的公有云及其生态资源服务,包括上云咨询、云迁移、运维托管、云转售等。WebEye是中国大陆地区率先获得Google Cloud Managed Service Provider(MSP)资质的合作伙伴,并获得2021 Google Cloud年度最佳突破伙伴奖。

为了进一步降低算力成本,使得更多的企业和研究机构有能力参与到AI的开发和应用中来,推动AI技术的普及和应用,WebEye与谷歌云携手合作,通过WebEye可以获得更优惠的价格。

例如,通过WebEye购买谷歌云资源,A2标准机器类型的SPOT价格低至1.1美元/小时、A2 Ultra机器类型价格低至1.58美元/小时、G2标准机器类型价格低至0.21美元/小时;NI标准器类型价格低至0.13美元/小时。

更多惊喜,敬请扫描下图海报二维码或点击文末“阅读原文”,获得更多优惠大礼包。

文:月满西楼 / 数据猿