0 介绍

Apache Hudi(Hadoop Upserts Delete and Incremental)是下一代流数据湖平台。Apache Hudi将核心仓库和数据库功能直接引入数据湖。Hudi提供了表、事务、高效的upserts/delete、高级索引、流摄取服务、数据集群/压缩优化和并发,同时保持数据的开源文件格式。

Apache Hudi不仅非常适合于流工作负载,而且还允许创建高效的增量批处理管道。

Apache Hudi可以轻松地在任何云存储平台上使用。Hudi的高级性能优化,使分析工作负载更快的任何流行的查询引擎,包括Apache Spark、Flink、Presto、Trino、Hive等。

1 环境准备

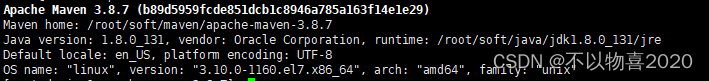

1.1 安装maven

要求maven版本3.3.1版本及以上

修改setting.xml,指定为阿里仓库地址

<!-- 添加阿里云镜像-->

<mirror>

<id>nexus-aliyun</id>

<mirrorOf>central</mirrorOf>

<name>Nexus aliyun</name>

<url>http://maven.aliyun.com/nexus/content/groups/public</url>

</mirror>

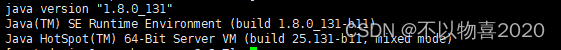

1.2 安装JDK

要求jdk8及以上的版本

1.3 Git

主要用于获取hudi源码

1.4 下载hudi源码

https://github.com/apache/hudi/releases/

2 Hudi源码编译

2.1 修改pom文件

修改hudi-0.12.0/pom.xml文件

1)新增repository加速依赖下载

<repository>

<id>nexus-aliyun</id>

<name>nexus-aliyun</name>

<url>http://maven.aliyun.com/nexus/content/groups/public/</url>

<releases>

<enabled>true</enabled>

</releases>

<snapshots>

<enabled>false</enabled>

</snapshots>

</repository>

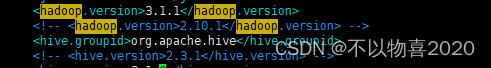

2)修改依赖的组件版本

根据需要适配的组件修改相应的版本号,默认的hadoop版本为2.10.1。hive默认版本为2.3.1,修改为当前自己使用的版本

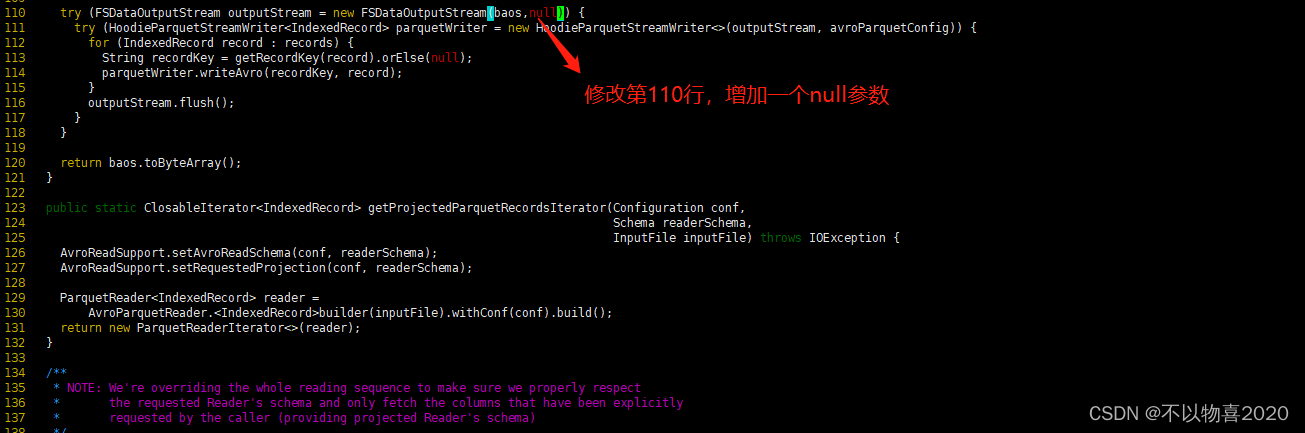

2.2 修改代码

Hudi默认依赖的hadoop2,要兼容hadoop3,除了修改版本,还需要修改如下代码:

hudi-0.12.0/hudi-common/src/main/java/org/apache/hudi/common/table/log/block/HoodieParquetDataBlock.java

否则会因为hadoop2.x和3.x版本兼容问题.

2.3 修改kafka依赖

有几个kafka的依赖需要手动安装,否则编译报错如下:

1)下载jar包

通过网址下载:http://packages.confluent.io/archive/5.3/confluent-5.3.4-2.12.zip

解压后找到以下jar包,上传服务器

common-config-5.3.4.jar

common-utils-5.3.4.jar

kafka-avro-serializer-5.3.4.jar

kafka-schema-registry-client-5.3.4.jar

2)install到maven本地仓库

mvn install:install-file -DgroupId=io.confluent -DartifactId=common-config -Dversion=5.3.4 -Dpackaging=jar -Dfile=./common-config-5.3.4.jar

mvn install:install-file -DgroupId=io.confluent -DartifactId=common-utils -Dversion=5.3.4 -Dpackaging=jar -Dfile=./common-utils-5.3.4.jar

mvn install:install-file -DgroupId=io.confluent -DartifactId=kafka-avro-serializer -Dversion=5.3.4 -Dpackaging=jar -Dfile=./kafka-avro-serializer-5.3.4.jar

mvn install:install-file -DgroupId=io.confluent -DartifactId=kafka-schema-registry-client -Dversion=5.3.4 -Dpackaging=jar -Dfile=./kafka-schema-registry-client-5.3.4.jar

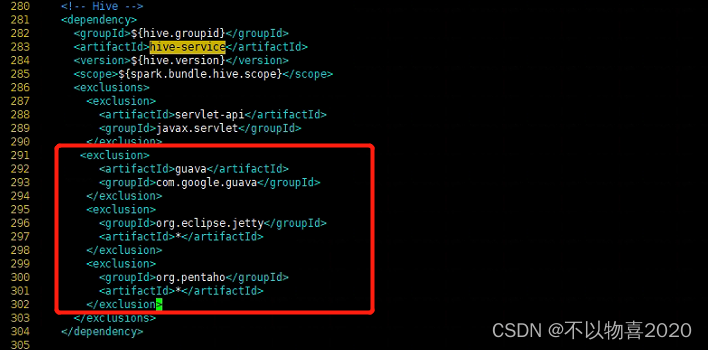

2.4 解决spark模块依赖冲突

修改了Hive版本为3.1.0,其携带的jetty是0.9.3,hudi本身用的0.9.4,存在依赖冲突

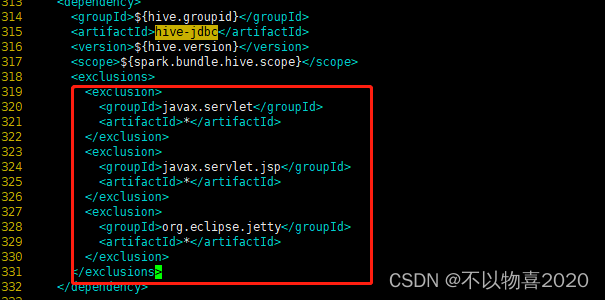

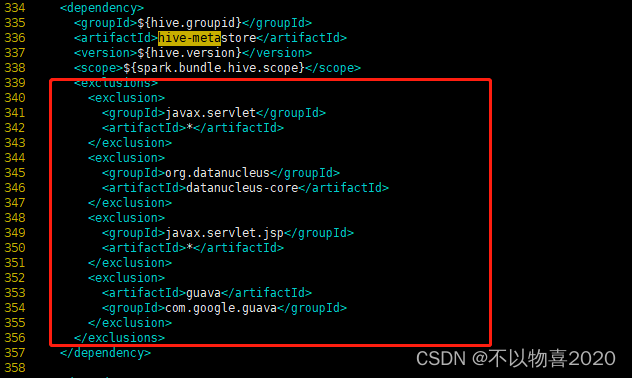

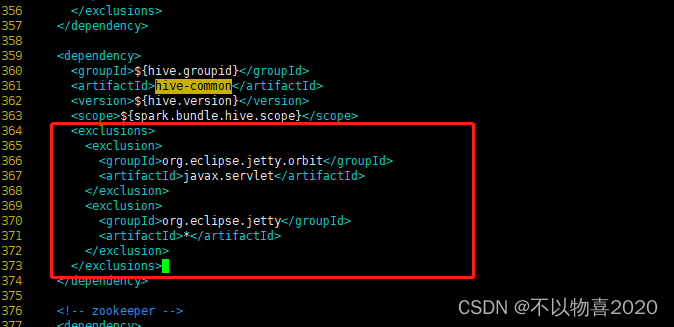

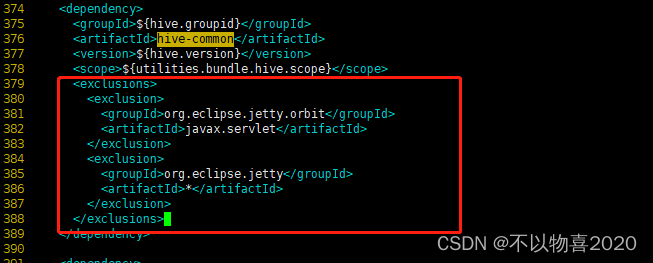

1)修改hudi-spark-bundle的pom文件,排除低版本jetty,添加hudi指定版本的jetty:

hudi-0.12.0/packaging/hudi-spark-bundle/pom.xml

在280行的位置,添加内容如下:

<!-- Hive -->

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-service</artifactId>

<version>${hive.version}</version>

<scope>${spark.bundle.hive.scope}</scope>

<exclusions>

<exclusion>

<artifactId>guava</artifactId>

<groupId>com.google.guava</groupId>

</exclusion>

<exclusion>

<groupId>org.eclipse.jetty</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<groupId>org.pentaho</groupId>

<artifactId>*</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-service-rpc</artifactId>

<version>${hive.version}</version>

<scope>${spark.bundle.hive.scope}</scope>

</dependency>

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-jdbc</artifactId>

<version>${hive.version}</version>

<scope>${spark.bundle.hive.scope}</scope>

<exclusions>

<exclusion>

<groupId>javax.servlet</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<groupId>javax.servlet.jsp</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<groupId>org.eclipse.jetty</groupId>

<artifactId>*</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-metastore</artifactId>

<version>${hive.version}</version>

<scope>${spark.bundle.hive.scope}</scope>

<exclusions>

<exclusion>

<groupId>javax.servlet</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<groupId>org.datanucleus</groupId>

<artifactId>datanucleus-core</artifactId>

</exclusion>

<exclusion>

<groupId>javax.servlet.jsp</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<artifactId>guava</artifactId>

<groupId>com.google.guava</groupId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-common</artifactId>

<version>${hive.version}</version>

<scope>${spark.bundle.hive.scope}</scope>

<exclusions>

<exclusion>

<groupId>org.eclipse.jetty.orbit</groupId>

<artifactId>javax.servlet</artifactId>

</exclusion>

<exclusion>

<groupId>org.eclipse.jetty</groupId>

<artifactId>*</artifactId>

</exclusion>

</exclusions>

</dependency>

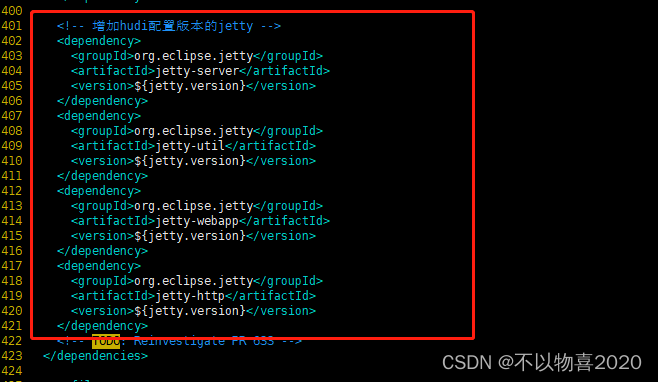

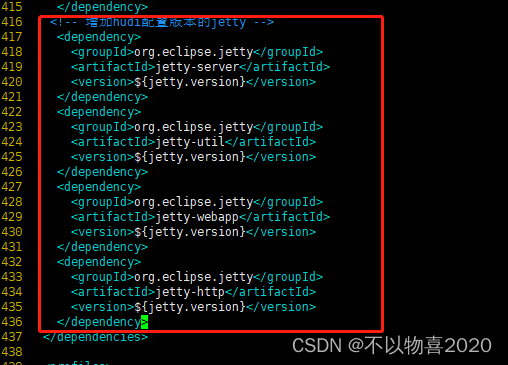

<!-- 增加hudi配置版本的jetty -->

<dependency>

<groupId>org.eclipse.jetty</groupId>

<artifactId>jetty-server</artifactId>

<version>${jetty.version}</version>

</dependency>

<dependency>

<groupId>org.eclipse.jetty</groupId>

<artifactId>jetty-util</artifactId>

<version>${jetty.version}</version>

</dependency>

<dependency>

<groupId>org.eclipse.jetty</groupId>

<artifactId>jetty-webapp</artifactId>

<version>${jetty.version}</version>

</dependency>

<dependency>

<groupId>org.eclipse.jetty</groupId>

<artifactId>jetty-http</artifactId>

<version>${jetty.version}</version>

</dependency>

hive-service

hive-jdbc

hive-metastore

hive-common

最后新增

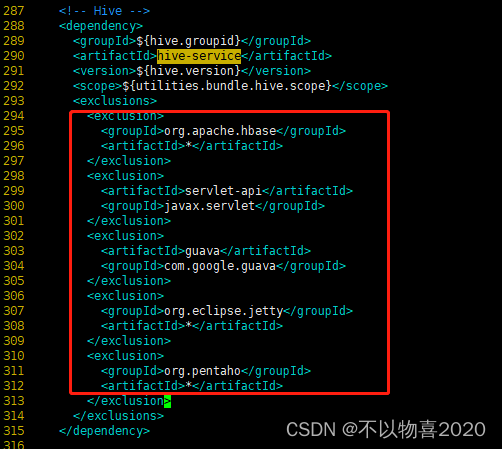

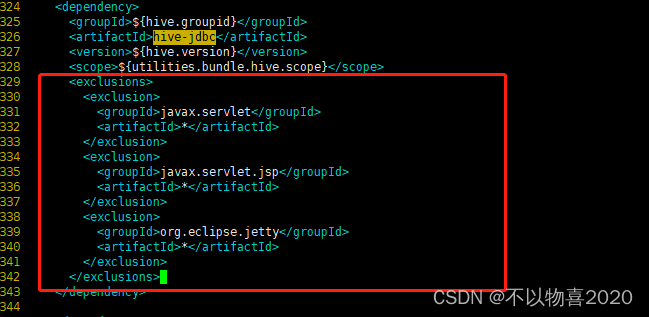

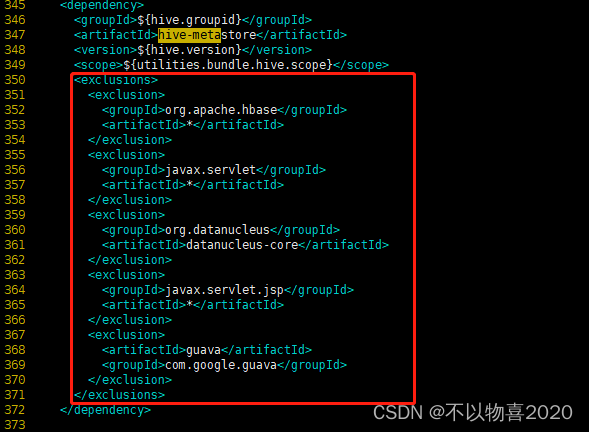

2)修改hudi-utilities-bundle的pom文件,排除低版本jetty,添加hudi指定版本的jetty:

hudi-0.12.0/packaging/hudi-utilities-bundle/pom.xml

<!-- Hoodie -->

<dependency>

<groupId>org.apache.hudi</groupId>

<artifactId>hudi-common</artifactId>

<version>${project.version}</version>

<exclusions>

<exclusion>

<groupId>org.eclipse.jetty</groupId>

<artifactId>*</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.apache.hudi</groupId>

<artifactId>hudi-client-common</artifactId>

<version>${project.version}</version>

<exclusions>

<exclusion>

<groupId>org.eclipse.jetty</groupId>

<artifactId>*</artifactId>

</exclusion>

</exclusions>

</dependency>

<!-- Hive -->

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-service</artifactId>

<version>${hive.version}</version>

<scope>${utilities.bundle.hive.scope}</scope>

<exclusions>

<exclusion>

<artifactId>servlet-api</artifactId>

<groupId>javax.servlet</groupId>

</exclusion>

<exclusion>

<artifactId>guava</artifactId>

<groupId>com.google.guava</groupId>

</exclusion>

<exclusion>

<groupId>org.eclipse.jetty</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<groupId>org.pentaho</groupId>

<artifactId>*</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-service-rpc</artifactId>

<version>${hive.version}</version>

<scope>${utilities.bundle.hive.scope}</scope>

</dependency>

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-jdbc</artifactId>

<version>${hive.version}</version>

<scope>${utilities.bundle.hive.scope}</scope>

<exclusions>

<exclusion>

<groupId>javax.servlet</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<groupId>javax.servlet.jsp</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<groupId>org.eclipse.jetty</groupId>

<artifactId>*</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-metastore</artifactId>

<version>${hive.version}</version>

<scope>${utilities.bundle.hive.scope}</scope>

<exclusions>

<exclusion>

<groupId>javax.servlet</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<groupId>org.datanucleus</groupId>

<artifactId>datanucleus-core</artifactId>

</exclusion>

<exclusion>

<groupId>javax.servlet.jsp</groupId>

<artifactId>*</artifactId>

</exclusion>

<exclusion>

<artifactId>guava</artifactId>

<groupId>com.google.guava</groupId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>${hive.groupid}</groupId>

<artifactId>hive-common</artifactId>

<version>${hive.version}</version>

<scope>${utilities.bundle.hive.scope}</scope>

<exclusions>

<exclusion>

<groupId>org.eclipse.jetty.orbit</groupId>

<artifactId>javax.servlet</artifactId>

</exclusion>

<exclusion>

<groupId>org.eclipse.jetty</groupId>

<artifactId>*</artifactId>

</exclusion>

</exclusions>

</dependency>

<!-- 增加hudi配置版本的jetty -->

<dependency>

<groupId>org.eclipse.jetty</groupId>

<artifactId>jetty-server</artifactId>

<version>${jetty.version}</version>

</dependency>

<dependency>

<groupId>org.eclipse.jetty</groupId>

<artifactId>jetty-util</artifactId>

<version>${jetty.version}</version>

</dependency>

<dependency>

<groupId>org.eclipse.jetty</groupId>

<artifactId>jetty-webapp</artifactId>

<version>${jetty.version}</version>

</dependency>

<dependency>

<groupId>org.eclipse.jetty</groupId>

<artifactId>jetty-http</artifactId>

<version>${jetty.version}</version>

</dependency>

hive-service

hive-jdbc

hive-metastore

hive-common

新增内容

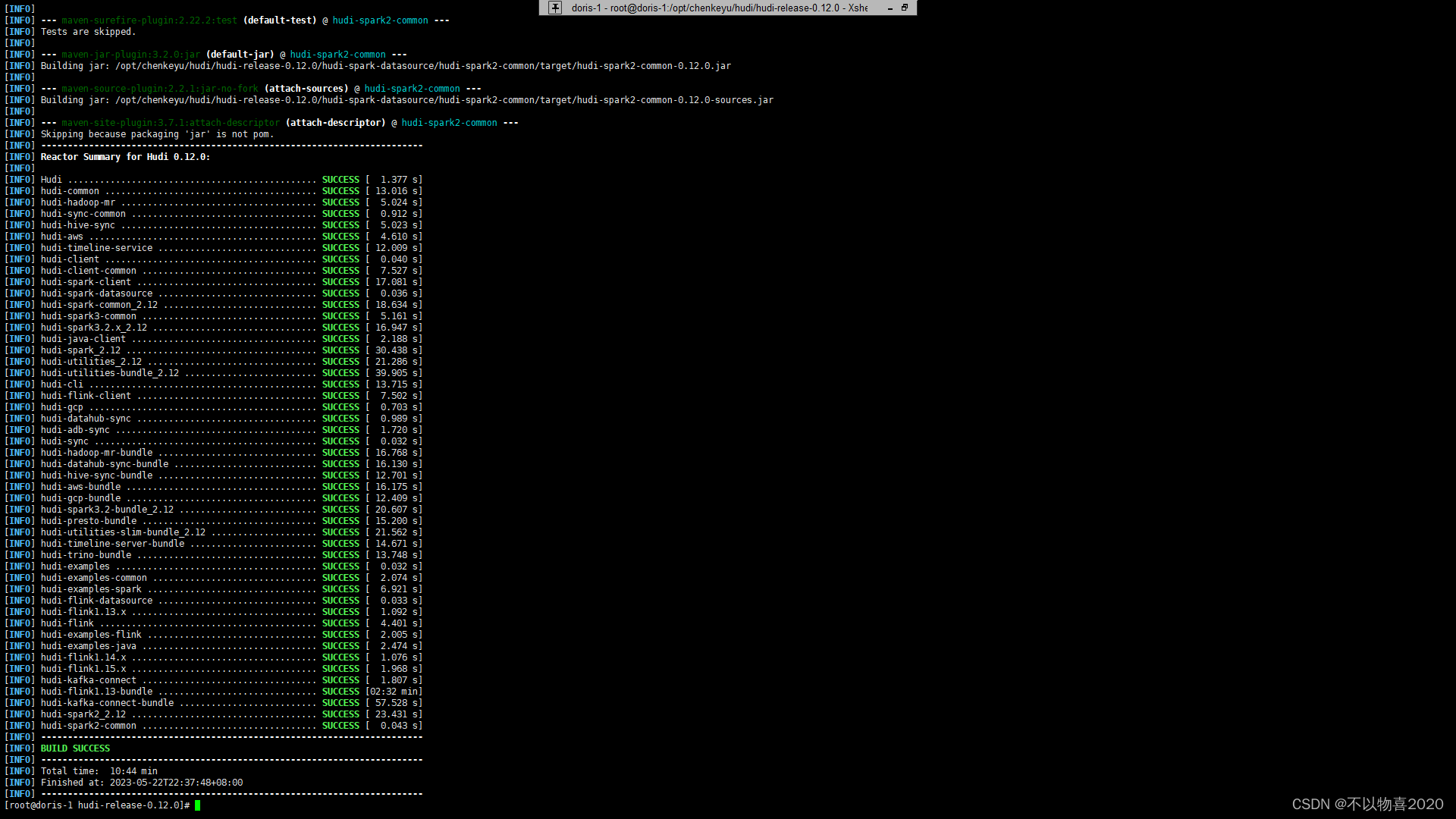

2.5 执行编译

mvn clean package -DskipTests -Dspark3.2 -Dflink1.13 -Dscala-2.12 -Dhadoop.version=3.1.1 -Pflink-bundle-shade-hive3

注:这里通过-D参数指定spark/flink组件版本,指定scala版本

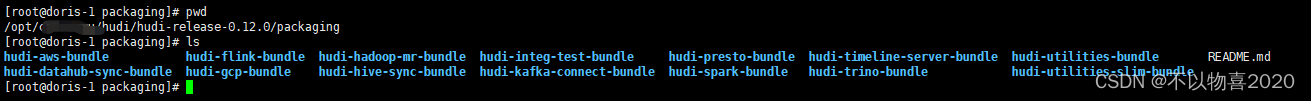

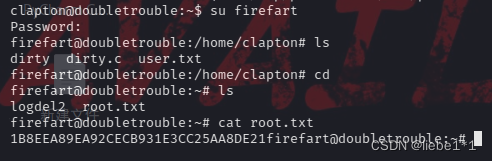

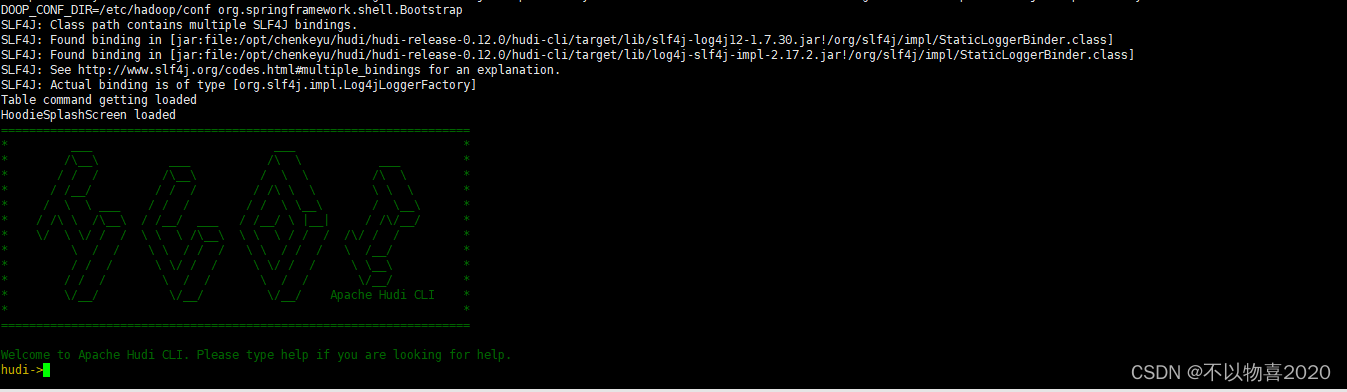

3 验证

编译成功后,进入hudi-cli说明成功

编译完成后,相关的包在packaging目录的各个模块中: