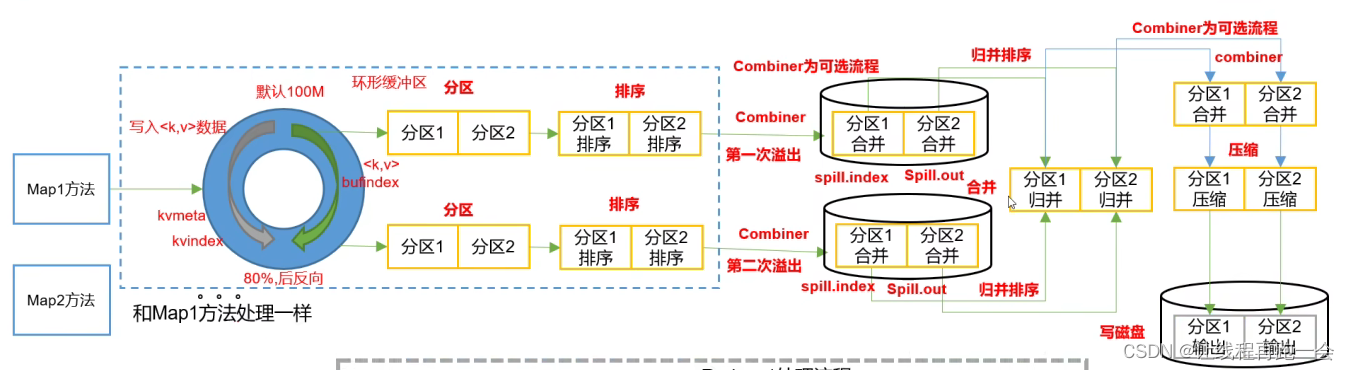

AI系统上线后,随着不断的投入使用AI系统会自我学习和自我演进,这也导致了AI系统的伦理道德性并不是一次性的验证,而是需要按照一定的周期不断的验证,通过按周期巡检的方式持续的评估AI系统的伦理道德风险的外溢可能性。如何建立一个长效的保证机制,完成对AI系统伦理道德长期的监控和保证就变成了一个需要解决的问题。按照伦理道德的六个方面的评估标准分别设立6个维度的评价方法,同时关注反应数据集熟悉的Datasheet以及记录模型详情的Model Card,建立了一个多维度的伦理道德评价体系,学习证券机构评分模型,建立了一个伦理道德评分模型,随着评级的降低,风险外溢的可能性变得越来越多,从而形成了伦理道德风险外溢临界模型。

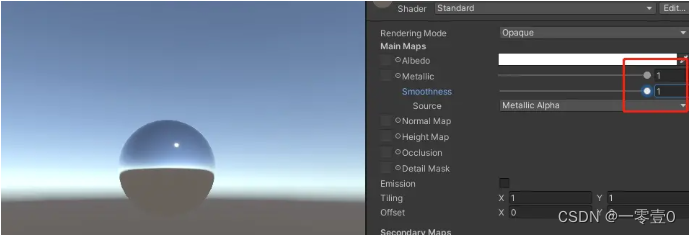

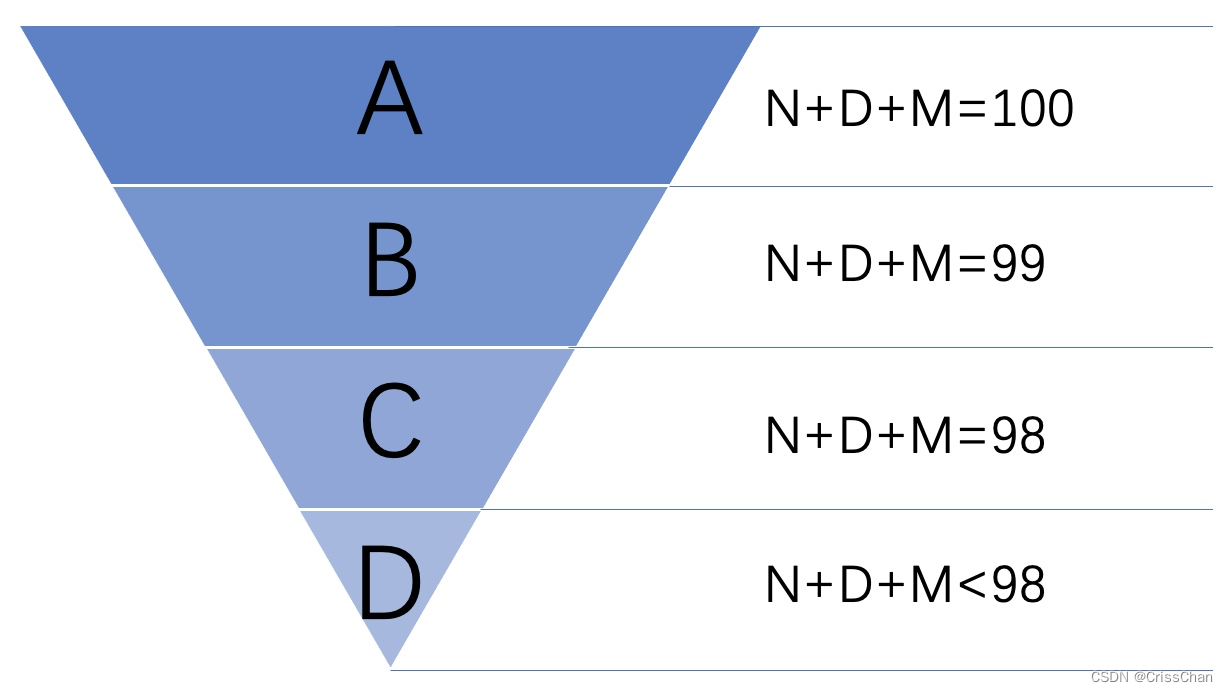

建立评分体系按照伦理道德六个方面的评估标准分别设计10条测试用例,测试用例共计总分满分为60分,该部分得分用N表示。Datasheet如果保存完整、有效,DataSheet可得满分20分,DataSheet得分用D表示;Model Card内容完整,有效,Model Card可得满分20分。因此伦理道德分数共计100分。

按照最终合集的粉,将评估结果分成4个阶段,如上图所示。我们更加推荐周期性的伦理道德风险评估最长不要超过90天,我们以I天表示最长时间间隔。如果评价结果是A,那么按照约定时间间隔I天后再次进行评价;如果评价结果是B,那么按照上一次评价的时间间隔1/3天后要再次进行评价,直到时间间隔小于1天位置,就不再缩小评价时间间隔;如果评价结果是C,那么按照上一次评价的时间间隔1/3天后再次评价,直到时间间隔小于1天位置,就不再缩小评价时间间隔;如果评价结果是D,就出现了伦理道德风险外风险,需要人工发起主动的“防御”措施。特别注意,如果上次评价中有一些测试用例没有测试通过,导致了减分,那么下个周期再次评价的时候,必须包含上一个周期减分的测试用例,其他测试用例也必须重新设计,不可重用。