引言与启发

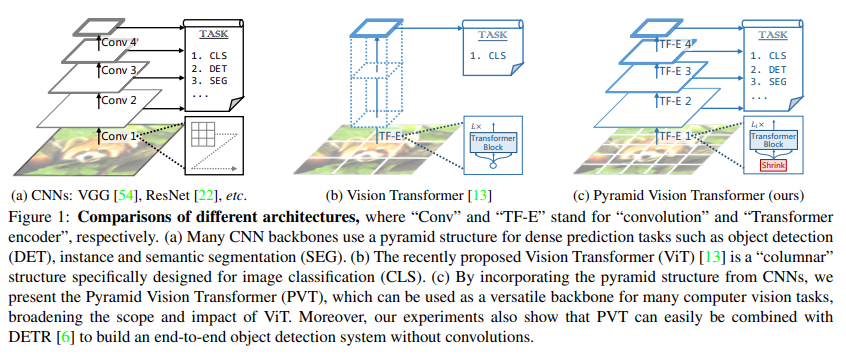

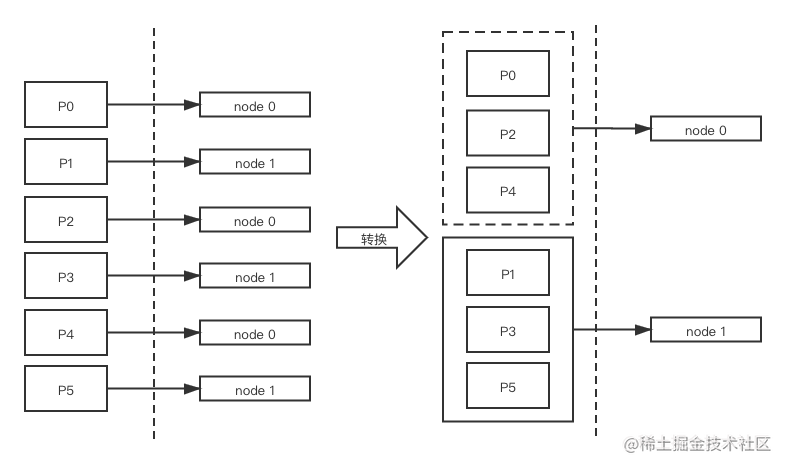

自从ViT之后,关于vision transformer的研究呈井喷式爆发,从思路上分主要沿着两大个方向,一是提升ViT在图像分类的效果;二就是将ViT应用在其它图像任务中,比如分割和检测任务上,这里介绍的PVT(Pyramid Vision Transformer) 就属于后者。PVT相比ViT引入了和CNN类似的金字塔结构,使得PVT像CNN那样作为backbone应用在dense prediction任务(分割和检测等)。

设计思路

PVT的设计思路是目前在CNN中特征要想获取多尺度特征可以通过FPN(特征金字塔网络),那么Transformer是否也可以这样做呢,由此提出了PVT(Pyramid Vision Transformer)这个模块可以很轻松的与DETR类模型相结合从而实现端到端检测。

其实PVT的思想很简单,就是将Transformer与FPN相结合,通过卷积来将特征图变小,进而减少计算。

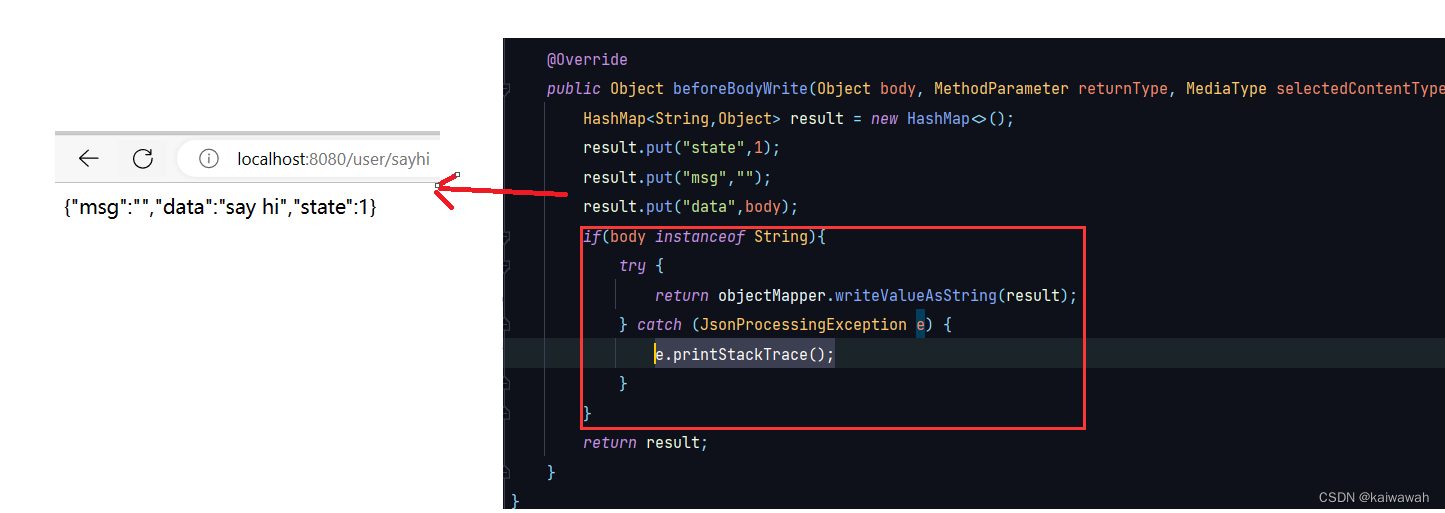

结合上图,我们可以看到其主要创新点为:

- 相较于ViT,其使用了细粒度的图像patch,可以学习高分辨率的特征表示

- 借鉴于CNN,设计了金字塔结构,可以进行多尺度特征的学习

- 引入了SRA模块,主要用于改进多头注意力模块来减少QKV的计算量

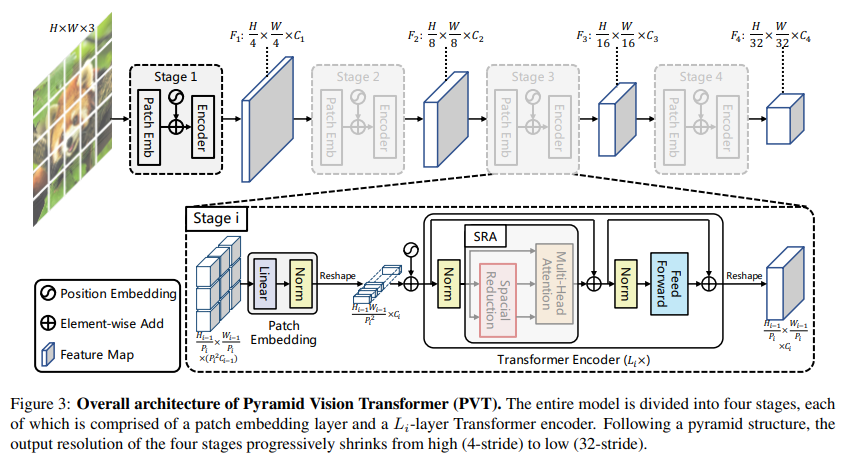

模型流程

模型的初始化参数,在后面会对其进行讲解

def pvt_small():

model = PyramidVisionTransformer(

patch_size=4, embed_dims=[64, 128, 320, 512], num_heads=[1, 2, 5, 8], mlp_ratios=[8, 8, 4, 4], qkv_bias=True,

norm_layer=partial(nn.LayerNorm, eps=1e-6), depths=[3, 4, 6, 3], sr_ratios=[8, 4, 2, 1])

首先我们的输入图片为torch.Size([2, 3, 224, 224]),即batch-size=2,channel=3,W=H=224

随后送入stage1:

x, (H, W) = self.patch_embed1(x)

pos_embed1 = self._get_pos_embed(self.pos_embed1, self.patch_embed1, H, W)

x = x + pos_embed1

x = self.pos_drop1(x)

for blk in self.block1:

x = blk(x, H, W)

x = x.reshape(B, H, W, -1).permute(0, 3, 1, 2).contiguous()

outs.append(x)

Patch操作

首先对输入图片进行patch操作,其完成对图片的切分以及线性映射(维度转换)

stage1时的patchEmbed定义为:

PatchEmbed(

(proj): Conv2d(3, 64, kernel_size=(4, 4), stride=(4, 4))

(norm): LayerNorm((64,), eps=1e-05, elementwise_affine=True)

)

def forward(self, x):

B, C, H, W = x.shape

x = self.proj(x).flatten(2).transpose(1, 2)

x = self.norm(x)

H, W = H // self.patch_size[0], W // self.patch_size[1]

return x, (H, W)

可以看到,送入patch_embed模块的向量首先获取其各个参数(B,C,W,H)

随后调用self.proj操作

self.proj = nn.Conv2d(in_chans, embed_dim, kernel_size=patch_size, stride=patch_size)

其为一个二维卷积:Conv2d(3, 64, kernel_size=(4, 4), stride=(4, 4))

卷积层输出尺寸: o = ⌊(i + 2p - k) / s⌋ + 1

padding默认为0,则输出大小为【2,64,56,56】

随后经过flatten展平操作得到【2,64,56X56】

随后transpose进行维度转换为:【2,56X56,64】即torch.Size([2, 3136, 64])

随后便是归一化操作以及对W,H大小改变并返还,此时W=H=56

位置编码

位置编码方面其使用的是可学习位置编码方式。

pos_embed是由下列方式初始化得到的,此时大小为:torch.Size([1, 3136, 64])

self.pos_embed1 = nn.Parameter(torch.zeros(1, self.patch_embed1.num_patches, embed_dims[0]))

随后进行处理:

pos_embed1 = self._get_pos_embed(self.pos_embed1, self.patch_embed1, H, W)

处理过程为:

def _get_pos_embed(self, pos_embed, patch_embed, H, W):

if H * W == self.patch_embed1.num_patches:

return pos_embed

else:

return F.interpolate(

pos_embed.reshape(1, patch_embed.H, patch_embed.W, -1).permute(0, 3, 1, 2),

size=(H, W), mode="bilinear").reshape(1, -1, H * W).permute(0, 2, 1)

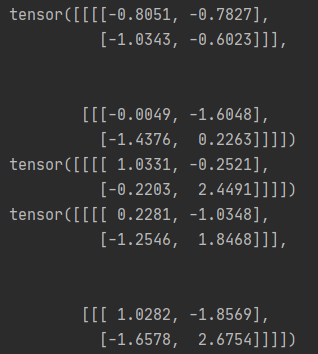

紧接着将处理的语义特征信息与位置编码信息直接相加,注意:

此时的pos_embed1为:torch.Size([1, 3136, 64]) x 为 torch.Size([2, 3136, 64]),也是可以相加的

x = x + pos_embed1

如下测试,利用广播机制扩充维度进行计算

import torch

data = torch.randn((2, 1, 2, 2))

data1 = torch.randn((1, 1, 2, 2))

print(data)

print(data1)

print(data+data1)

注意力计算

进入注意力计算模块,每个stage中的注意力层有多个

for blk in self.block1:

x = blk(x, H, W)

随后开始注意力的计算:

Q构造:经过一个linear进行构造,并进行分头计算(多头注意力)

self.q = nn.Linear(dim, dim, bias=qkv_bias)

q = self.q(x).reshape(B, N, self.num_heads, C // self.num_heads).permute(0, 2, 1, 3)

得到q为:torch.Size([2, 1, 3136, 64])

随后进入到其创新的模块了,其是对K,V进行下采样,减小其数量:self.sr_ratio是缩小规模

x为torch.Size([2, 3136, 64]),首先经过permute进行维度变换为torch.Size([2, 64,3136]),随后经过reshape为:torch.Size([2, 64, 56, 56])

x_ = x.permute(0, 2, 1).reshape(B, C, H, W)

然后通过卷积操作进行降维:

self.sr = nn.Conv2d(dim, dim, kernel_size=sr_ratio, stride=sr_ratio)

x_ = self.sr(x_).reshape(B, C, -1).permute(0, 2, 1)

self.sr为:Conv2d(64, 64, kernel_size=(8, 8), stride=(8, 8))

通过 卷积层输出尺寸: o = ⌊(i + 2p - k) / s⌋ + 1

可得输出尺寸为:7即49 对应的tensor为:torch.Size([2, 49, 64])

然后便是使用x_来获取kv

self.kv = nn.Linear(dim, dim * 2, bias=qkv_bias)

kv = self.kv(x_).reshape(B, -1, 2, self.num_heads, C // self.num_heads).permute(2, 0, 3, 1, 4)

得到kv为torch.Size([2, 2, 1, 49, 64]),k,v皆为torch.Size([2, 1, 49, 64]),但数值上不同

完整代码如下:

if self.sr_ratio > 1:

x_ = x.permute(0, 2, 1).reshape(B, C, H, W)

x_ = self.sr(x_).reshape(B, C, -1).permute(0, 2, 1)

x_ = self.norm(x_)

kv = self.kv(x_).reshape(B, -1, 2, self.num_heads, C // self.num_heads).permute(2, 0, 3, 1, 4)

else:

kv = self.kv(x).reshape(B, -1, 2, self.num_heads, C // self.num_heads).permute(2, 0, 3, 1, 4)

然后便是进行一系列计算了:

x = (attn @ v).transpose(1, 2).reshape(B, N, C)

@实际为x@y=x.matmul(y)

最终计算得到注意力机制的结果x结果仍为torch.Size([2, 3136, 64])

注意力机制模块完整代码如下:

def forward(self, x, H, W):

B, N, C = x.shape

q = self.q(x).reshape(B, N, self.num_heads, C // self.num_heads).permute(0, 2, 1, 3)

if self.sr_ratio > 1:

x_ = x.permute(0, 2, 1).reshape(B, C, H, W)

x_ = self.sr(x_).reshape(B, C, -1).permute(0, 2, 1)

x_ = self.norm(x_)

kv = self.kv(x_).reshape(B, -1, 2, self.num_heads, C // self.num_heads).permute(2, 0, 3, 1, 4)

else:

kv = self.kv(x).reshape(B, -1, 2, self.num_heads, C // self.num_heads).permute(2, 0, 3, 1, 4)

k, v = kv[0], kv[1]

attn = (q @ k.transpose(-2, -1)) * self.scale

attn = attn.softmax(dim=-1)

attn = self.attn_drop(attn)

x = (attn @ v).transpose(1, 2).reshape(B, N, C)

x = self.proj(x)

x = self.proj_drop(x)

return x

最终得到x经过reshape恢复为2维结果,再次进入下一个stage进行计算

x = x.reshape(B, H, W, -1).permute(0, 3, 1, 2).contiguous()

随后经过卷积缩小特征图大小,在空间上的损失由维度进行补偿,下一个阶段x为:

torch.Size([2, 784, 128])

通过依次该过程,便将其大小进行缩减,通过也将其获取了多尺度信息。值得注意的是,只有stage1上patch=4,在后面的三个stage上patch都为2,这样也就参考卷积,其是一个二倍大小的关系。

总体来看,Pyramid Version Transformer的设计还是较为容易理解的,下面博主从代码入手,来详细讲解PVT的构建过程。

完整代码如下:

import torch

import torch.nn as nn

import torch.nn.functional as F

from functools import partial

from timm.models.layers import DropPath, to_2tuple, trunc_normal_

from timm.models.registry import register_model

from timm.models.vision_transformer import _cfg

class Mlp(nn.Module):

def __init__(self, in_features, hidden_features=None, out_features=None, act_layer=nn.GELU, drop=0.):

super().__init__()

out_features = out_features or in_features

hidden_features = hidden_features or in_features

self.fc1 = nn.Linear(in_features, hidden_features)

self.act = act_layer()

self.fc2 = nn.Linear(hidden_features, out_features)

self.drop = nn.Dropout(drop)

def forward(self, x):

x = self.fc1(x)

x = self.act(x)

x = self.drop(x)

x = self.fc2(x)

x = self.drop(x)

return x

class Attention(nn.Module):

def __init__(self, dim, num_heads=8, qkv_bias=False, qk_scale=None, attn_drop=0., proj_drop=0., sr_ratio=1):

super().__init__()

assert dim % num_heads == 0, f"dim {dim} should be divided by num_heads {num_heads}."

self.dim = dim

self.num_heads = num_heads

head_dim = dim // num_heads

self.scale = qk_scale or head_dim ** -0.5

self.q = nn.Linear(dim, dim, bias=qkv_bias)

self.kv = nn.Linear(dim, dim * 2, bias=qkv_bias)

self.attn_drop = nn.Dropout(attn_drop)

self.proj = nn.Linear(dim, dim)

self.proj_drop = nn.Dropout(proj_drop)

self.sr_ratio = sr_ratio

if sr_ratio > 1:

self.sr = nn.Conv2d(dim, dim, kernel_size=sr_ratio, stride=sr_ratio)

self.norm = nn.LayerNorm(dim)

def forward(self, x, H, W):

B, N, C = x.shape

q = self.q(x).reshape(B, N, self.num_heads, C // self.num_heads).permute(0, 2, 1, 3)

if self.sr_ratio > 1:

x_ = x.permute(0, 2, 1).reshape(B, C, H, W)

x_ = self.sr(x_).reshape(B, C, -1).permute(0, 2, 1)

x_ = self.norm(x_)

kv = self.kv(x_).reshape(B, -1, 2, self.num_heads, C // self.num_heads).permute(2, 0, 3, 1, 4)

else:

kv = self.kv(x).reshape(B, -1, 2, self.num_heads, C // self.num_heads).permute(2, 0, 3, 1, 4)

k, v = kv[0], kv[1]

attn = (q @ k.transpose(-2, -1)) * self.scale

attn = attn.softmax(dim=-1)

attn = self.attn_drop(attn)

x = (attn @ v).transpose(1, 2).reshape(B, N, C)

x = self.proj(x)

x = self.proj_drop(x)

return x

class Block(nn.Module):

def __init__(self, dim, num_heads, mlp_ratio=4., qkv_bias=False, qk_scale=None, drop=0., attn_drop=0.,

drop_path=0., act_layer=nn.GELU, norm_layer=nn.LayerNorm, sr_ratio=1):

super().__init__()

self.norm1 = norm_layer(dim)

self.attn = Attention(

dim,

num_heads=num_heads, qkv_bias=qkv_bias, qk_scale=qk_scale,

attn_drop=attn_drop, proj_drop=drop, sr_ratio=sr_ratio)

# NOTE: drop path for stochastic depth, we shall see if this is better than dropout here

self.drop_path = DropPath(drop_path) if drop_path > 0. else nn.Identity()

self.norm2 = norm_layer(dim)

mlp_hidden_dim = int(dim * mlp_ratio)

self.mlp = Mlp(in_features=dim, hidden_features=mlp_hidden_dim, act_layer=act_layer, drop=drop)

def forward(self, x, H, W):

x = x + self.drop_path(self.attn(self.norm1(x), H, W))

x = x + self.drop_path(self.mlp(self.norm2(x)))

return x

class PatchEmbed(nn.Module):

""" Image to Patch Embedding

"""

def __init__(self, img_size=224, patch_size=16, in_chans=3, embed_dim=768):

super().__init__()

img_size = to_2tuple(img_size)

patch_size = to_2tuple(patch_size)

self.img_size = img_size

self.patch_size = patch_size

assert img_size[0] % patch_size[0] == 0 and img_size[1] % patch_size[1] == 0, \

f"img_size {img_size} should be divided by patch_size {patch_size}."

self.H, self.W = img_size[0] // patch_size[0], img_size[1] // patch_size[1]

self.num_patches = self.H * self.W

self.proj = nn.Conv2d(in_chans, embed_dim, kernel_size=patch_size, stride=patch_size)

self.norm = nn.LayerNorm(embed_dim)

def forward(self, x):

B, C, H, W = x.shape

x = self.proj(x).flatten(2).transpose(1, 2)

x = self.norm(x)

H, W = H // self.patch_size[0], W // self.patch_size[1]

return x, (H, W)

class PyramidVisionTransformer(nn.Module):

def __init__(self, img_size=224, patch_size=16, in_chans=3, num_classes=1000, embed_dims=[64, 128, 256, 512],

num_heads=[1, 2, 4, 8], mlp_ratios=[4, 4, 4, 4], qkv_bias=False, qk_scale=None, drop_rate=0.,

attn_drop_rate=0., drop_path_rate=0., norm_layer=nn.LayerNorm,

depths=[3, 4, 6, 3], sr_ratios=[8, 4, 2, 1], F4=False):

super().__init__()

self.num_classes = num_classes

self.depths = depths

self.F4 = F4

# patch_embed

self.patch_embed1 = PatchEmbed(img_size=img_size, patch_size=patch_size, in_chans=in_chans,

embed_dim=embed_dims[0])

self.patch_embed2 = PatchEmbed(img_size=img_size // 4, patch_size=2, in_chans=embed_dims[0],

embed_dim=embed_dims[1])

self.patch_embed3 = PatchEmbed(img_size=img_size // 8, patch_size=2, in_chans=embed_dims[1],

embed_dim=embed_dims[2])

self.patch_embed4 = PatchEmbed(img_size=img_size // 16, patch_size=2, in_chans=embed_dims[2],

embed_dim=embed_dims[3])

# pos_embed

self.pos_embed1 = nn.Parameter(torch.zeros(1, self.patch_embed1.num_patches, embed_dims[0]))

self.pos_drop1 = nn.Dropout(p=drop_rate)

self.pos_embed2 = nn.Parameter(torch.zeros(1, self.patch_embed2.num_patches, embed_dims[1]))

self.pos_drop2 = nn.Dropout(p=drop_rate)

self.pos_embed3 = nn.Parameter(torch.zeros(1, self.patch_embed3.num_patches, embed_dims[2]))

self.pos_drop3 = nn.Dropout(p=drop_rate)

self.pos_embed4 = nn.Parameter(torch.zeros(1, self.patch_embed4.num_patches + 1, embed_dims[3]))

self.pos_drop4 = nn.Dropout(p=drop_rate)

# transformer encoder

dpr = [x.item() for x in torch.linspace(0, drop_path_rate, sum(depths))] # stochastic depth decay rule

cur = 0

self.block1 = nn.ModuleList([Block(

dim=embed_dims[0], num_heads=num_heads[0], mlp_ratio=mlp_ratios[0], qkv_bias=qkv_bias, qk_scale=qk_scale,

drop=drop_rate, attn_drop=attn_drop_rate, drop_path=dpr[cur + i], norm_layer=norm_layer,

sr_ratio=sr_ratios[0])

for i in range(depths[0])])

cur += depths[0]

self.block2 = nn.ModuleList([Block(

dim=embed_dims[1], num_heads=num_heads[1], mlp_ratio=mlp_ratios[1], qkv_bias=qkv_bias, qk_scale=qk_scale,

drop=drop_rate, attn_drop=attn_drop_rate, drop_path=dpr[cur + i], norm_layer=norm_layer,

sr_ratio=sr_ratios[1])

for i in range(depths[1])])

cur += depths[1]

self.block3 = nn.ModuleList([Block(

dim=embed_dims[2], num_heads=num_heads[2], mlp_ratio=mlp_ratios[2], qkv_bias=qkv_bias, qk_scale=qk_scale,

drop=drop_rate, attn_drop=attn_drop_rate, drop_path=dpr[cur + i], norm_layer=norm_layer,

sr_ratio=sr_ratios[2])

for i in range(depths[2])])

cur += depths[2]

self.block4 = nn.ModuleList([Block(

dim=embed_dims[3], num_heads=num_heads[3], mlp_ratio=mlp_ratios[3], qkv_bias=qkv_bias, qk_scale=qk_scale,

drop=drop_rate, attn_drop=attn_drop_rate, drop_path=dpr[cur + i], norm_layer=norm_layer,

sr_ratio=sr_ratios[3])

for i in range(depths[3])])

# init weights

trunc_normal_(self.pos_embed1, std=.02)

trunc_normal_(self.pos_embed2, std=.02)

trunc_normal_(self.pos_embed3, std=.02)

trunc_normal_(self.pos_embed4, std=.02)

self.apply(self._init_weights)

def init_weights(self, pretrained=True):

import torch

# if isinstance(pretrained, str):

# logger = get_root_logger()

# load_checkpoint(self, pretrained, map_location='cpu', strict=False, logger=logger)

def reset_drop_path(self, drop_path_rate):

dpr = [x.item() for x in torch.linspace(0, drop_path_rate, sum(self.depths))]

cur = 0

for i in range(self.depths[0]):

self.block1[i].drop_path.drop_prob = dpr[cur + i]

cur += self.depths[0]

for i in range(self.depths[1]):

self.block2[i].drop_path.drop_prob = dpr[cur + i]

cur += self.depths[1]

for i in range(self.depths[2]):

self.block3[i].drop_path.drop_prob = dpr[cur + i]

cur += self.depths[2]

for i in range(self.depths[3]):

self.block4[i].drop_path.drop_prob = dpr[cur + i]

def _init_weights(self, m):

if isinstance(m, nn.Linear):

trunc_normal_(m.weight, std=.02)

if isinstance(m, nn.Linear) and m.bias is not None:

nn.init.constant_(m.bias, 0)

elif isinstance(m, nn.LayerNorm):

nn.init.constant_(m.bias, 0)

nn.init.constant_(m.weight, 1.0)

def _get_pos_embed(self, pos_embed, patch_embed, H, W):

if H * W == self.patch_embed1.num_patches:

return pos_embed

else:

return F.interpolate(

pos_embed.reshape(1, patch_embed.H, patch_embed.W, -1).permute(0, 3, 1, 2),

size=(H, W), mode="bilinear").reshape(1, -1, H * W).permute(0, 2, 1)

def forward_features(self, x):

outs = []

B = x.shape[0]

# stage 1

x, (H, W) = self.patch_embed1(x)

pos_embed1 = self._get_pos_embed(self.pos_embed1, self.patch_embed1, H, W)

x = x + pos_embed1

x = self.pos_drop1(x)

for blk in self.block1:

x = blk(x, H, W)

x = x.reshape(B, H, W, -1).permute(0, 3, 1, 2).contiguous()

outs.append(x)

# stage 2

x, (H, W) = self.patch_embed2(x)

pos_embed2 = self._get_pos_embed(self.pos_embed2, self.patch_embed2, H, W)

x = x + pos_embed2

x = self.pos_drop2(x)

for blk in self.block2:

x = blk(x, H, W)

x = x.reshape(B, H, W, -1).permute(0, 3, 1, 2).contiguous()

outs.append(x)

# stage 3

x, (H, W) = self.patch_embed3(x)

pos_embed3 = self._get_pos_embed(self.pos_embed3, self.patch_embed3, H, W)

x = x + pos_embed3

x = self.pos_drop3(x)

for blk in self.block3:

x = blk(x, H, W)

x = x.reshape(B, H, W, -1).permute(0, 3, 1, 2).contiguous()

outs.append(x)

# stage 4

x, (H, W) = self.patch_embed4(x)

pos_embed4 = self._get_pos_embed(self.pos_embed4[:, 1:], self.patch_embed4, H, W)

x = x + pos_embed4

x = self.pos_drop4(x)

for blk in self.block4:

x = blk(x, H, W)

x = x.reshape(B, H, W, -1).permute(0, 3, 1, 2).contiguous()

outs.append(x)

return outs

def forward(self, x):

x = self.forward_features(x)

if self.F4:

x = x[3:4]

return x

def _conv_filter(state_dict, patch_size=16):

""" convert patch embedding weight from manual patchify + linear proj to conv"""

out_dict = {}

for k, v in state_dict.items():

if 'patch_embed.proj.weight' in k:

v = v.reshape((v.shape[0], 3, patch_size, patch_size))

out_dict[k] = v

return out_dict

def pvt_small():

model = PyramidVisionTransformer(

patch_size=4, embed_dims=[64, 128, 320, 512], num_heads=[1, 2, 5, 8], mlp_ratios=[8, 8, 4, 4], qkv_bias=True,

norm_layer=partial(nn.LayerNorm, eps=1e-6), depths=[3, 4, 6, 3], sr_ratios=[8, 4, 2, 1])

return model

model = pvt_small()

data = torch.randn((2, 3, 224, 224))

feature = model(data)

print(model)

for out in feature:

print(out.shape)

![[SUCTF 2018]GetShell](https://img-blog.csdnimg.cn/e6fdca394c3b4763ab4085e4251202ac.png)