文章目录

- 一、前言

- 二、评价指标的一些概念

- 2.1.一些概念

- 2.2.概念介绍

- 2.3.MAP求解

- 三、理解CoCo的评价指标

- 四、总结

- 五、学习视频、Coco官方地址

一、前言

前面学习了coco数据集但是不知道它的评价指标,所以写下来作为自己的笔记,以后还是直接在这写好再保存到自己的本地笔记中。

二、评价指标的一些概念

2.1.一些概念

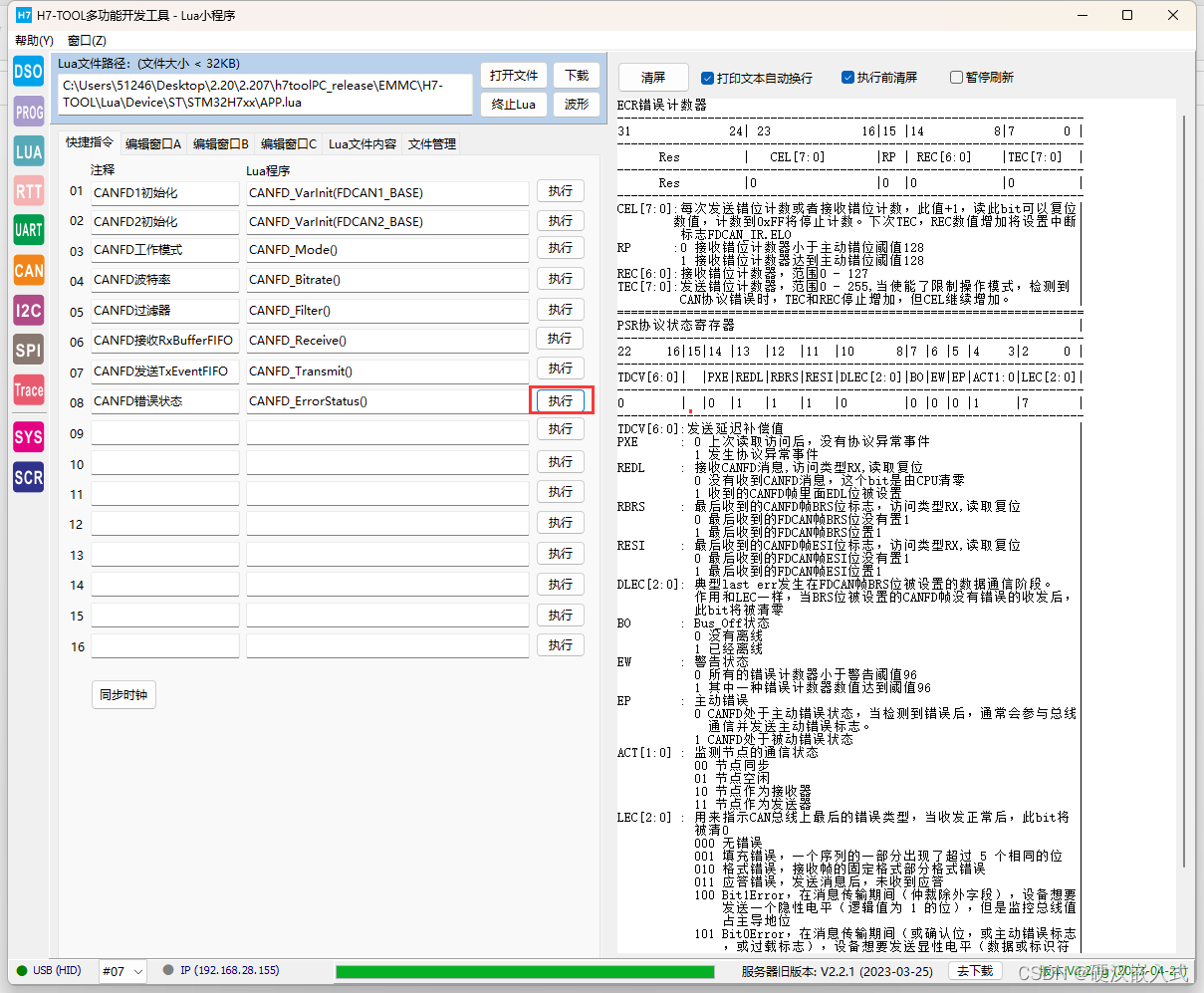

2.2.概念介绍

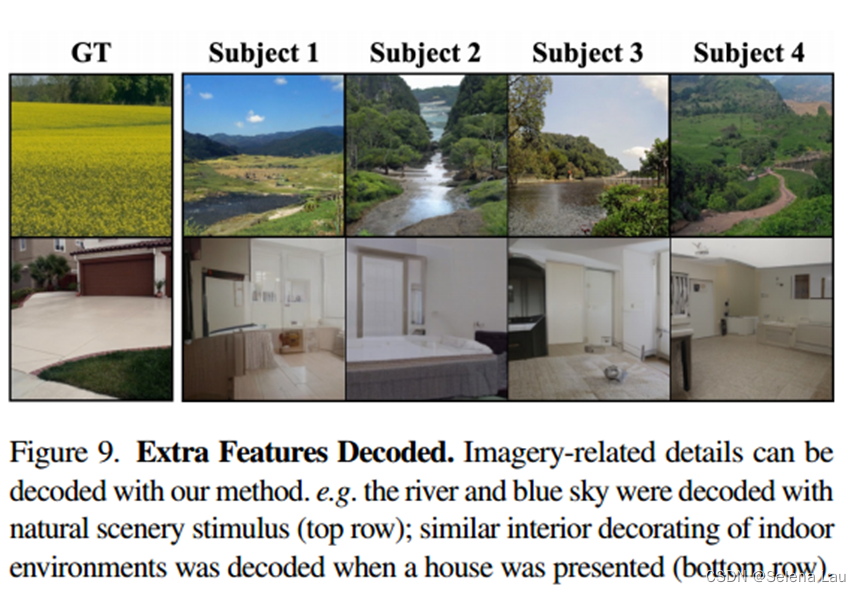

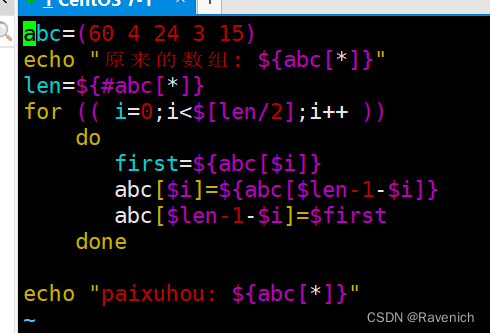

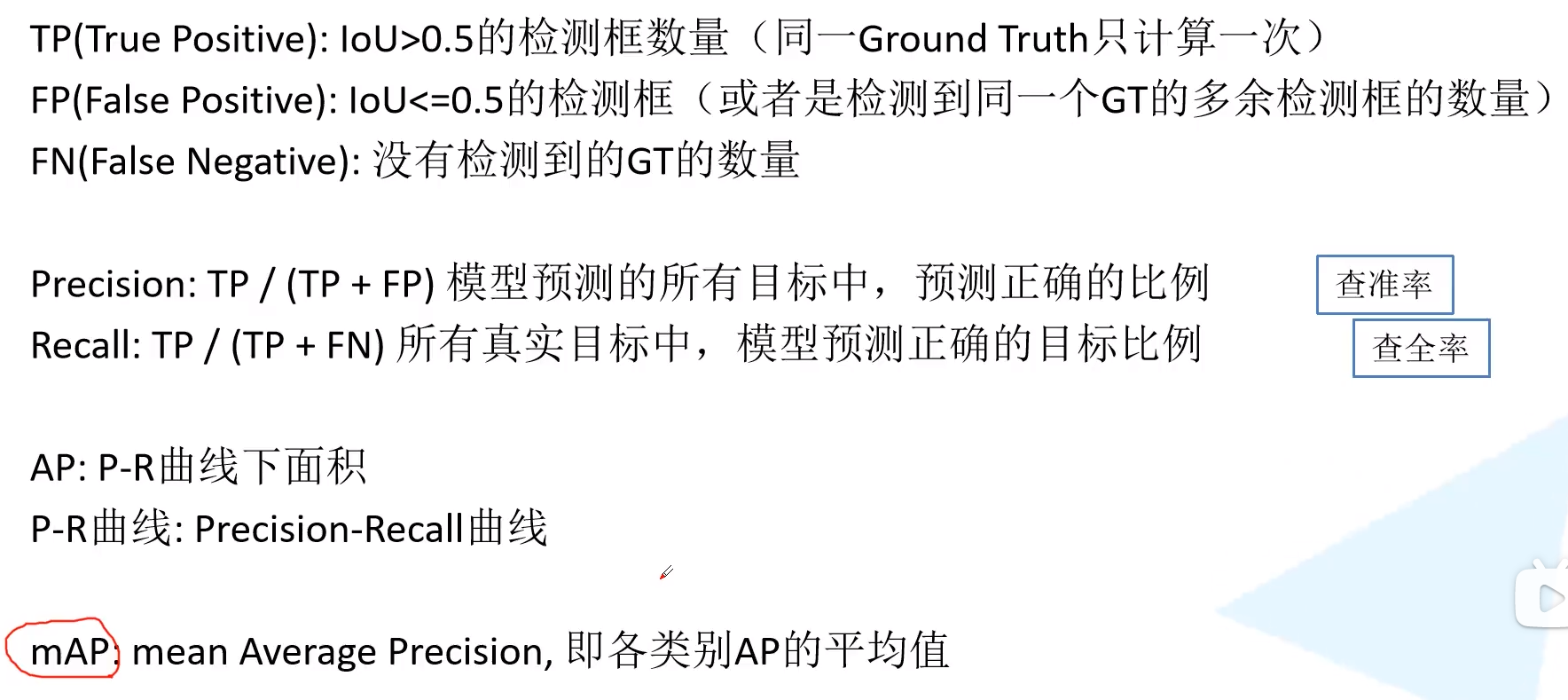

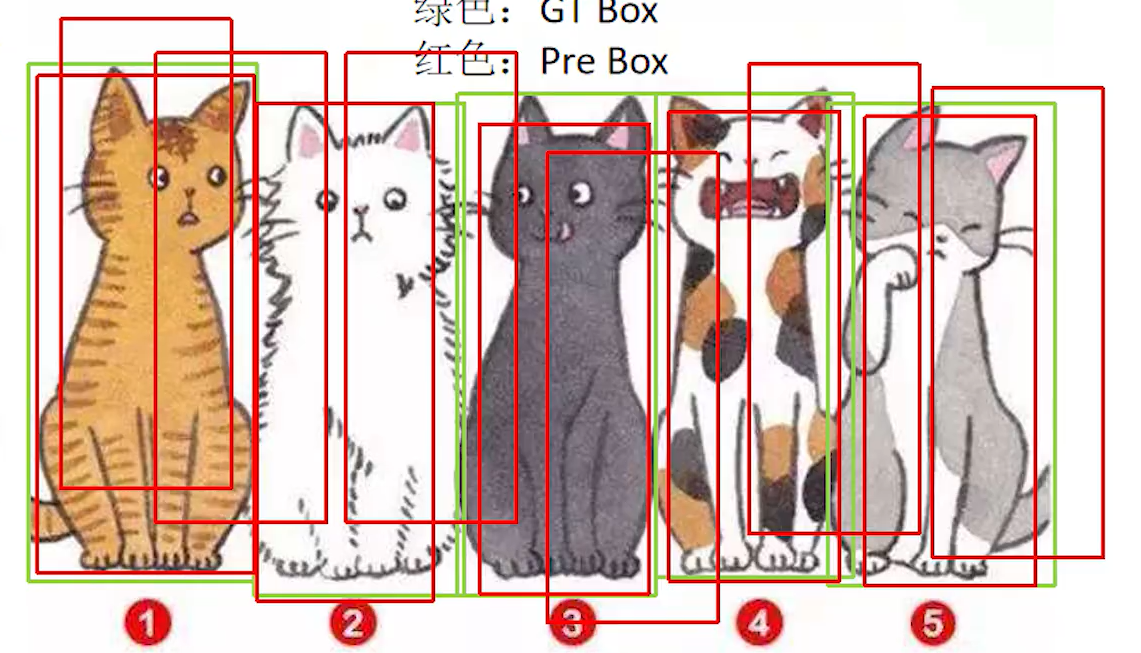

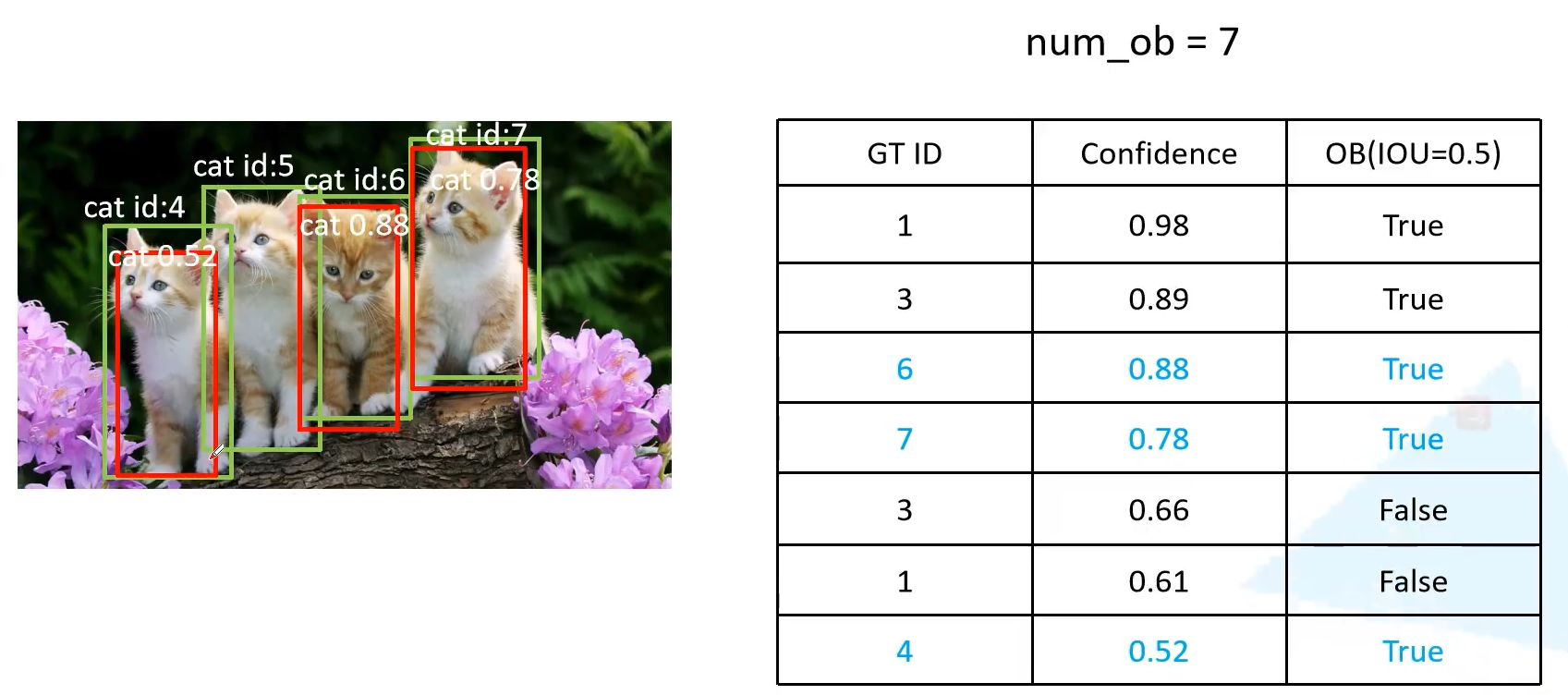

举例,在如下图中:

只有IOU大于0.5的才会被计算为TP检测框,在上图中cat0.9的框与Ground Truth的IOU大于0.5,所以可以记录为TP,而相反cat0.3的框与Ground Truth的IOU小于0.5,因此只能计算为FP。对于右下角的ground truth并没有框检测到这个cat,因此应该记为FN。

查准率Percision是用来衡量模型预测的所有目标中预测正确的比例,但是单独一个它还不能作为目标检测的评价指标,例如因为当检测一张图里的五个目标时,如果只有一个IOU>0.5的框,这也会使查准率为100%但显然这是不合理的。

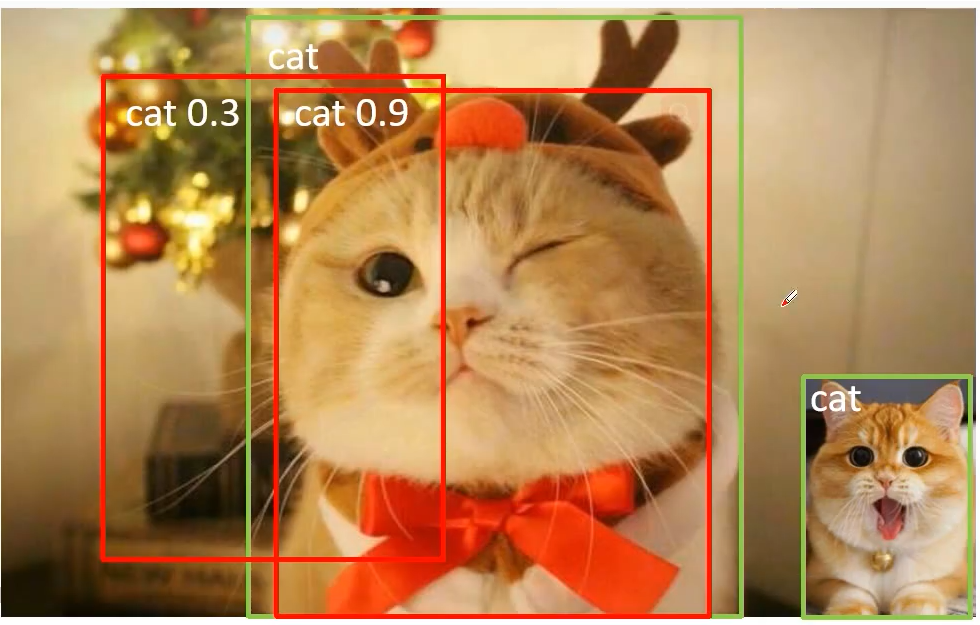

查全率Recall是用来衡量所有真实目标中,模型预测的正确比例。同样的单独使用Recall也不能单独作为评估指标。例如,在下图中有很多个框没有漏检,查全率为100%,这显然也不可以单独作为评估指标。

因此必须同时使用两个指标来衡量。P-R曲线下面会介绍,我们先通过一个案例来求解MAP。MAP是多个类别AP的平均值。

2.3.MAP求解

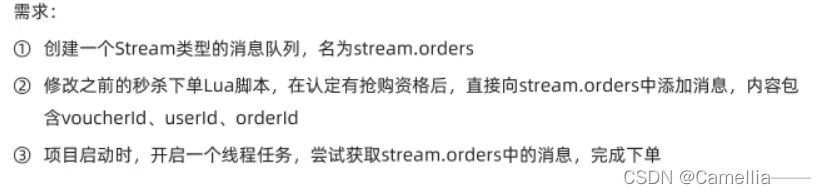

假设我们需要评估的三张图片如上,对于猫这个类别,我们可以计算它的AP有:

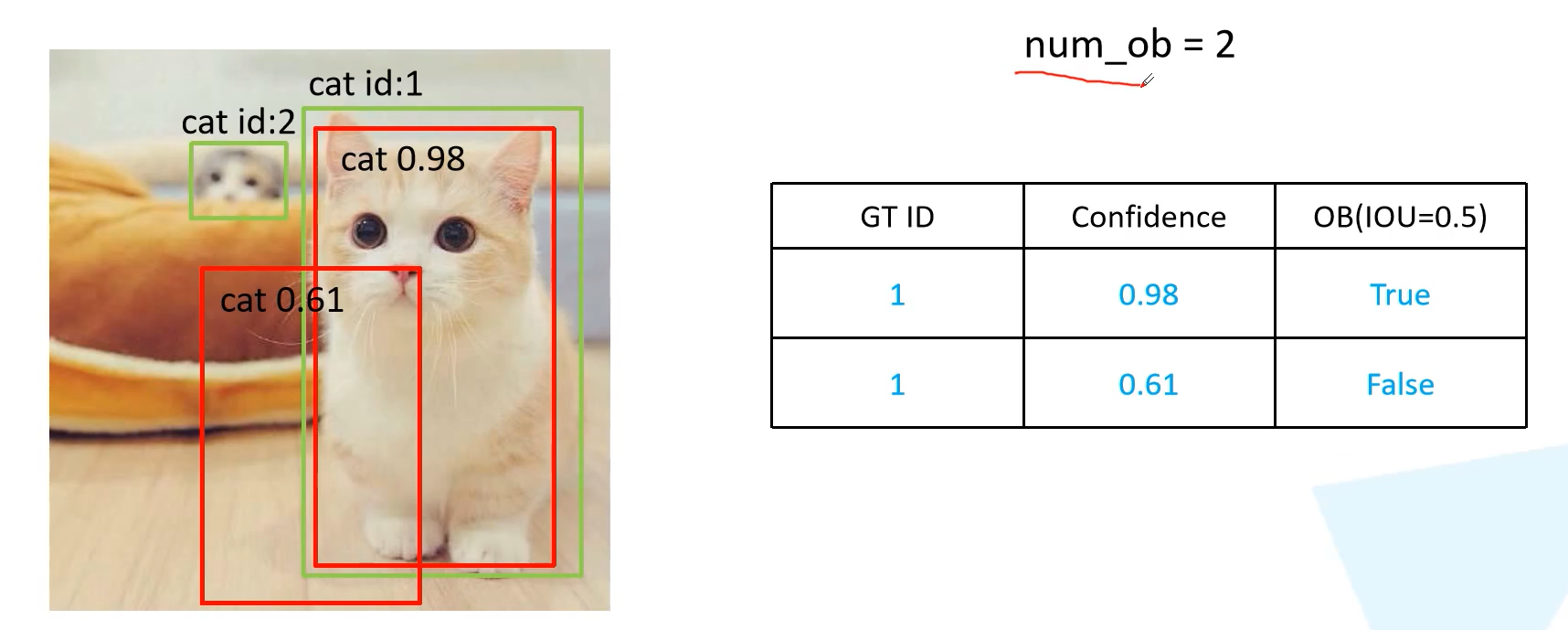

1)第一张图片预测结果

对于这张图片有两个预测的目标,GTID表示预测的目标ID,confindence表示预测的概率,OB为GTbox与Predicted box的IOU。

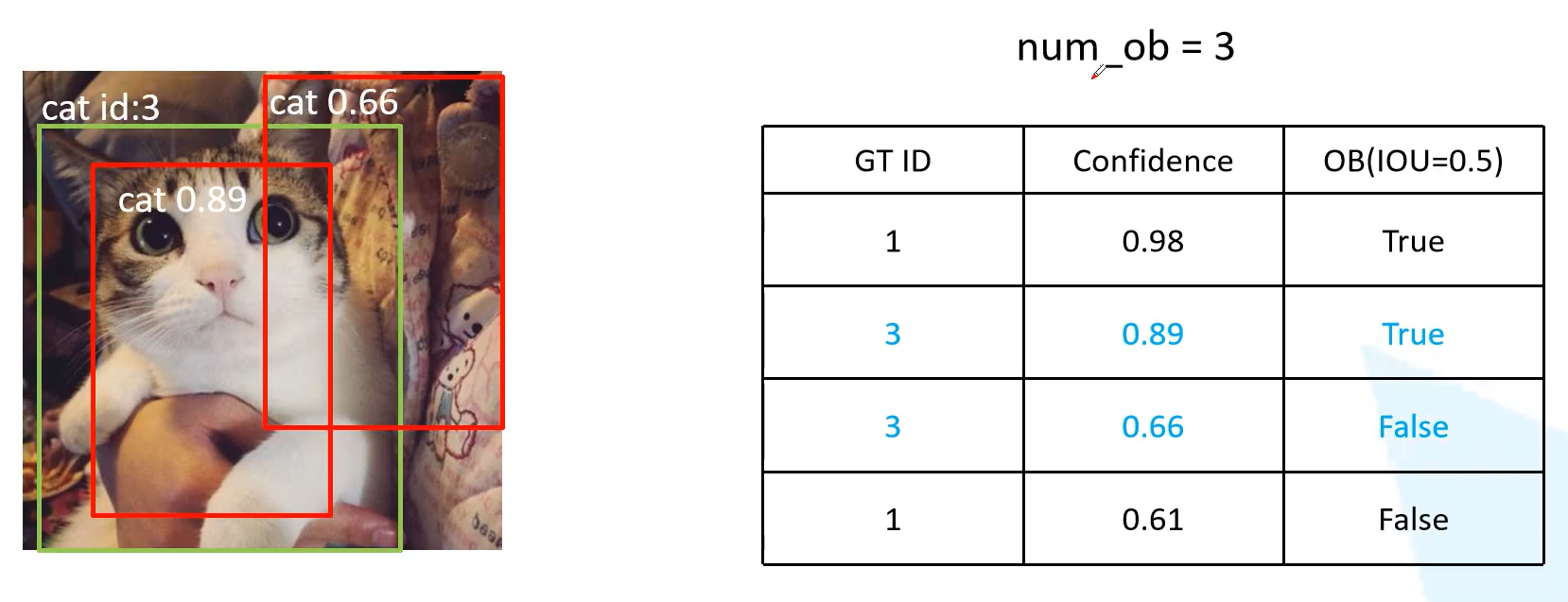

2)第二张图预测结果

num_ob是预测的对象个数,叠加得到,因为前面图像中有两个对象加上这张图的一个叠加为3个。表格是根据Confidence从大到小排序的。

3)第三张图预测结果

最终得到三张图里面共七个对象的统计结果。

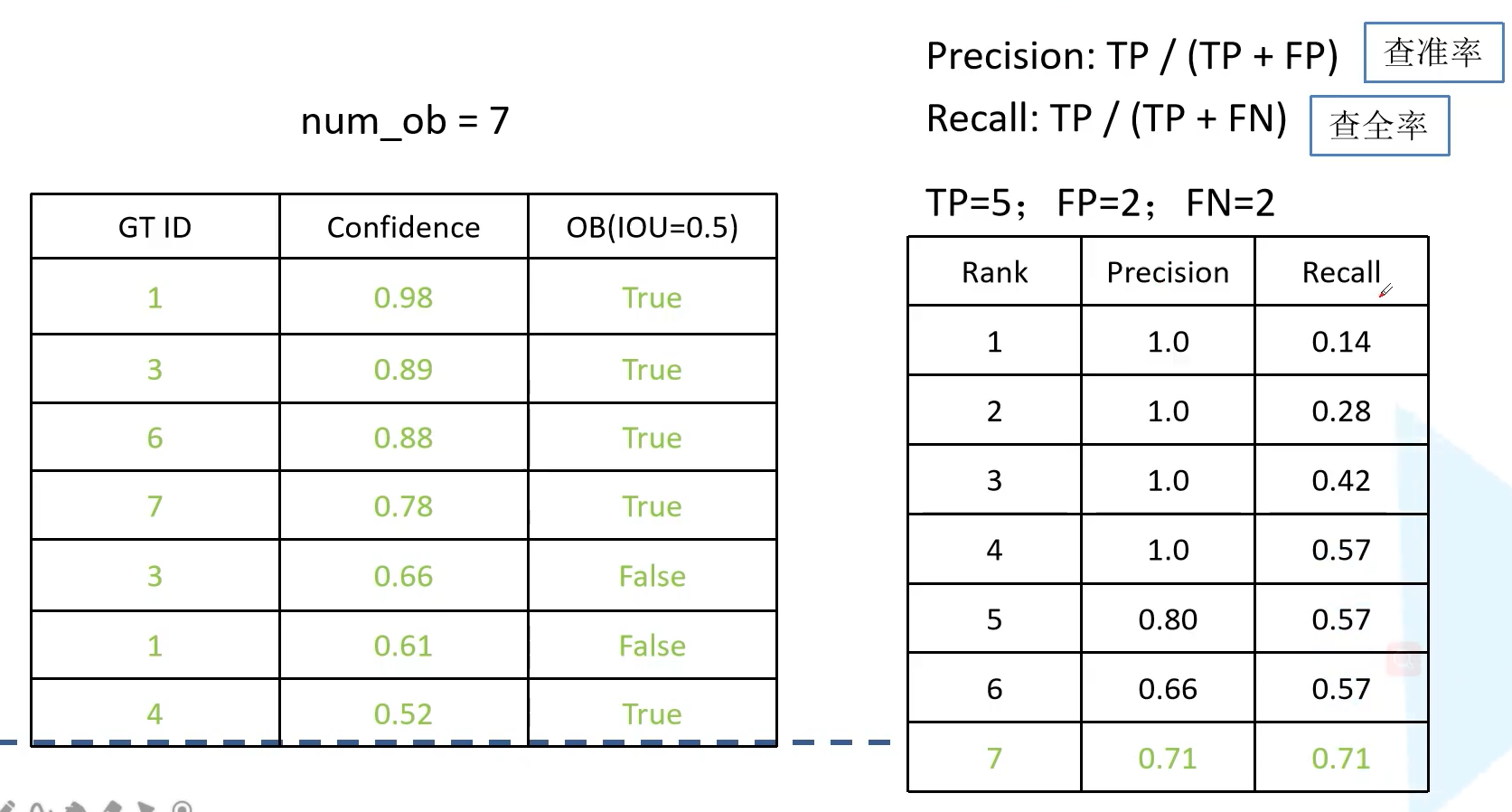

根据设置不同的Confidence,来求Percision and recall。

分别设置不同的Confidence得到结果,例如,如果以预测概率大于0.66的框代表检测到,则有:总共有5个框满足条件,其中TP = 4, FP为1, FN为7-4 = 3

最终得到:

接下来以Recall为横坐标,precision为纵坐标画图,这就是前面提到的P-R曲线,可以计算它的面积。

PS: 相同的Recall只会保留最大的Precision的那一个,也就是只会保留图中所示有方框的5个点。最后计算面积即可,有一点注意就是实际上计算的是每一个小矩形的面积,宽为相邻的两个点的recall差,高为从该点开始往后的所有的precision最大的值。

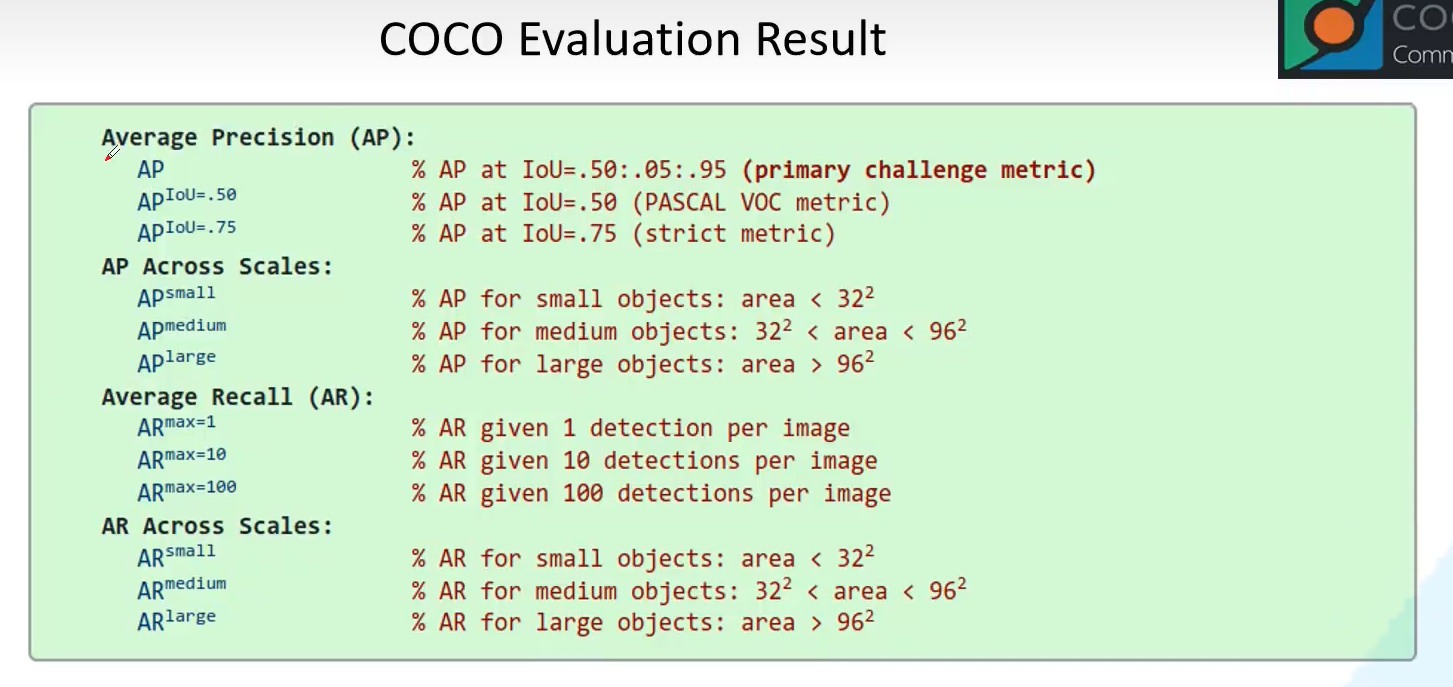

三、理解CoCo的评价指标

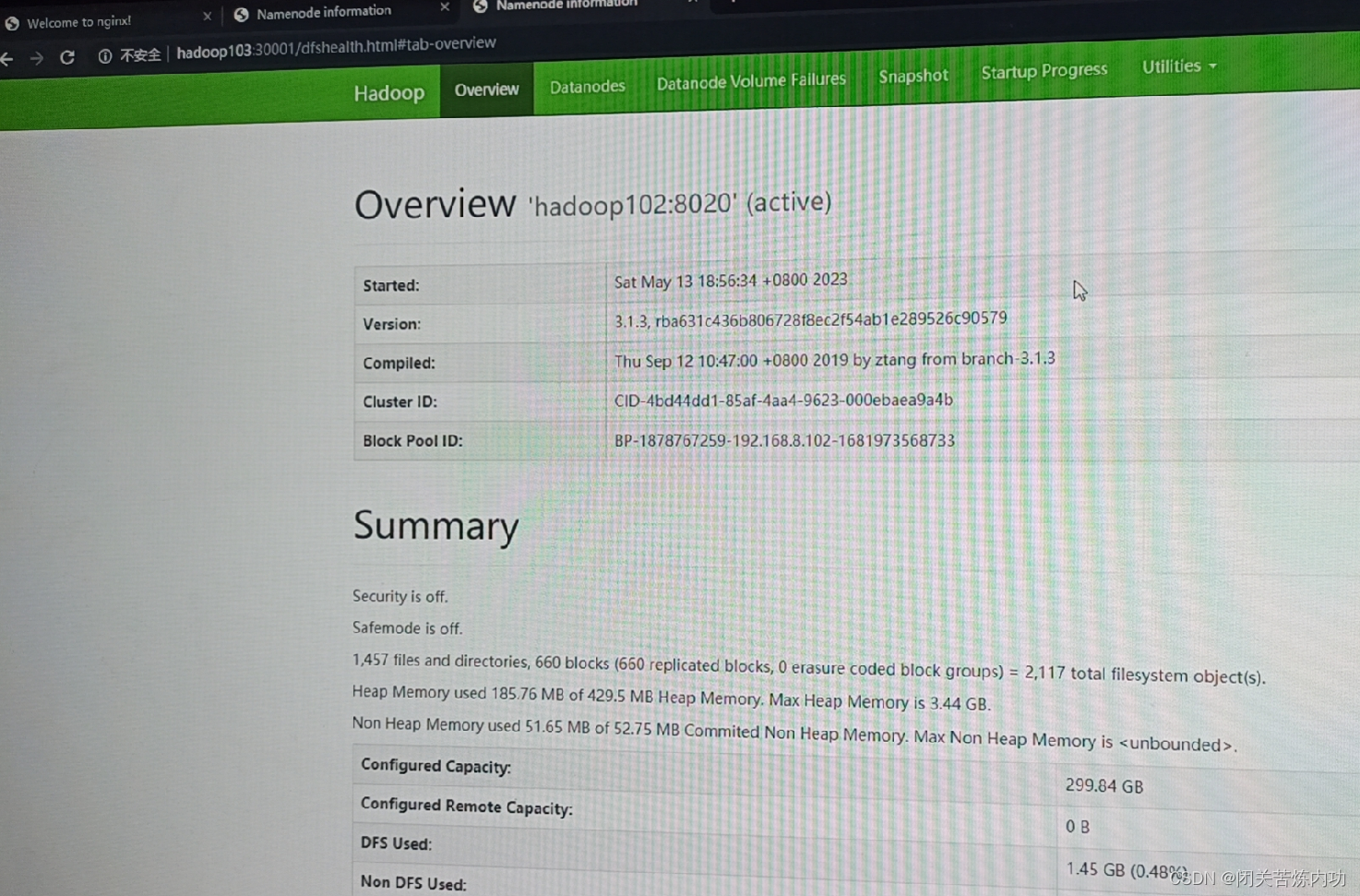

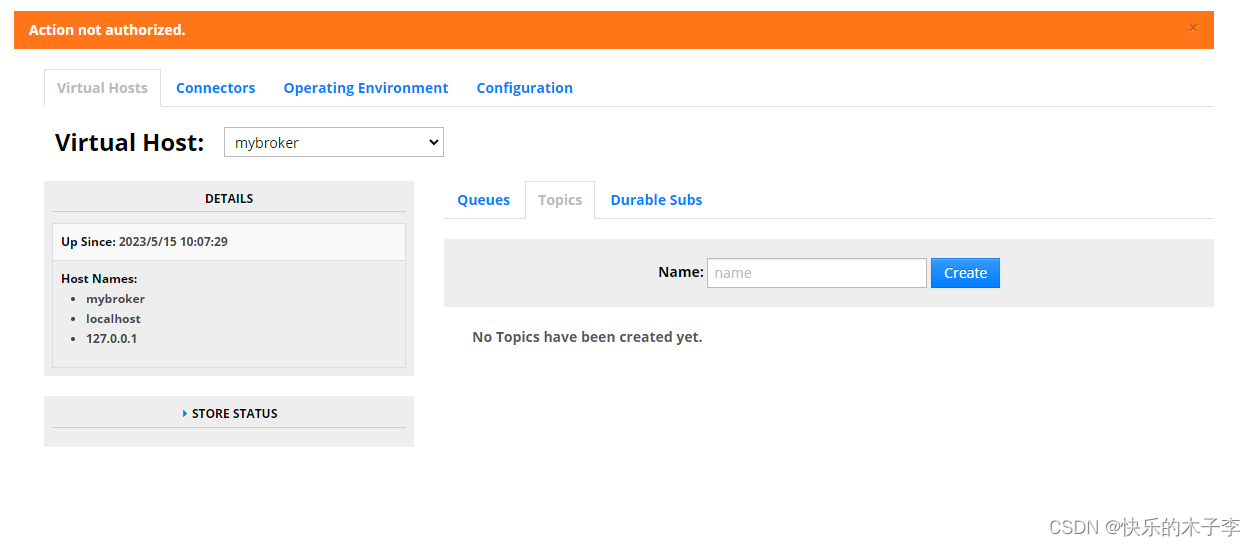

以上为官方评估标准

对于Average Precision(AP) 在CoCo数据集中,Average Precision主要使用的是第一个AP,也即计算IOU从0.5到0.95,间隔0.05的十个IOU来计算十个MAP,再取平均值得到CoCo的主要评估指标AP。PASCAL VOC以IOU为0.5对应的是第二个指标,第三个是以IOU为0.75的指标,更加严格。

对于AP Across Scales 是用来统计大小不同的目标的,根据他们的大小来统计。

对于Average Recall 主要用来限定一张图像里面可以检测到的目标数。

其他的更多的可以到CoCo的官方网站进行查看。

四、总结

主要是学习B站导师霹雳吧啦WzUP主的视频讲解做的笔记,方便自己可以不看视频更加方便的及时巩固复习。

五、学习视频、Coco官方地址

B站导师霹雳吧啦WzUP主的视频地址:https://www.bilibili.com/video/BV1ez4y1X7g2/?spm_id_from=333.999.0.0&vd_source=6f62aba02fc9ac56aa9063bbce87d3a7

CoCo官方地址:

https://cocodataset.org/#detection-eval

![[Orillusion]-使用 -windwos-4行命令](https://img-blog.csdnimg.cn/56682b33d1474df980127fb763abf4cf.png)