说明:这是一个机器学习实战项目(附带数据+代码+文档+视频讲解),如需数据+代码+文档+视频讲解可以直接到文章最后获取。

1.项目背景

2019年Heidari等人提出哈里斯鹰优化算法(Harris Hawk Optimization, HHO),该算法有较强的全局搜索能力,并且需要调节的参数较少的优点。

本项目通过HHO哈里斯鹰优化算法寻找最优的参数值来优化LightGBM回归模型。

2.数据获取

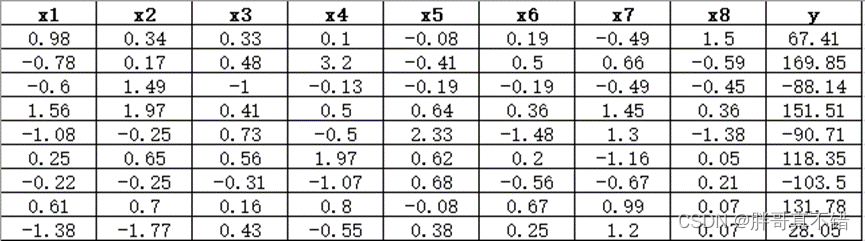

本次建模数据来源于网络(本项目撰写人整理而成),数据项统计如下:

数据详情如下(部分展示):

3.数据预处理

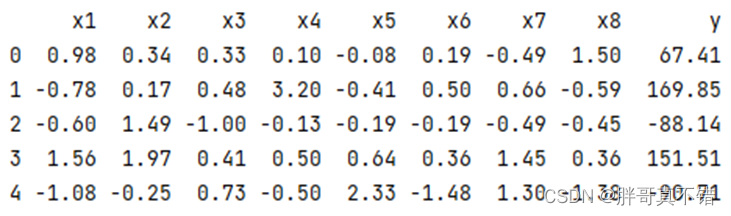

3.1 用Pandas工具查看数据

使用Pandas工具的head()方法查看前五行数据:

关键代码:

3.2数据缺失查看

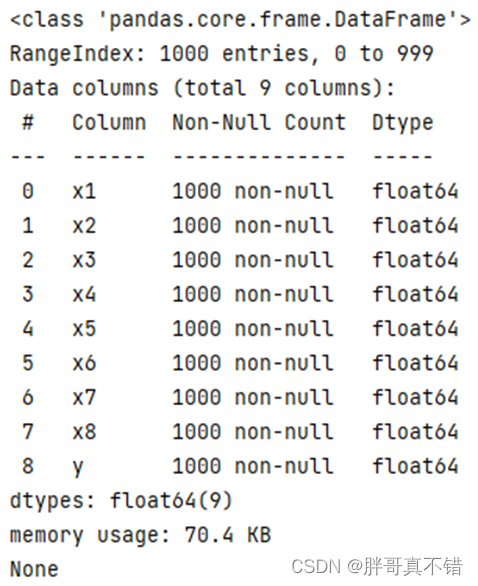

使用Pandas工具的info()方法查看数据信息:

从上图可以看到,总共有9个变量,数据中无缺失值,共1000条数据。

关键代码:

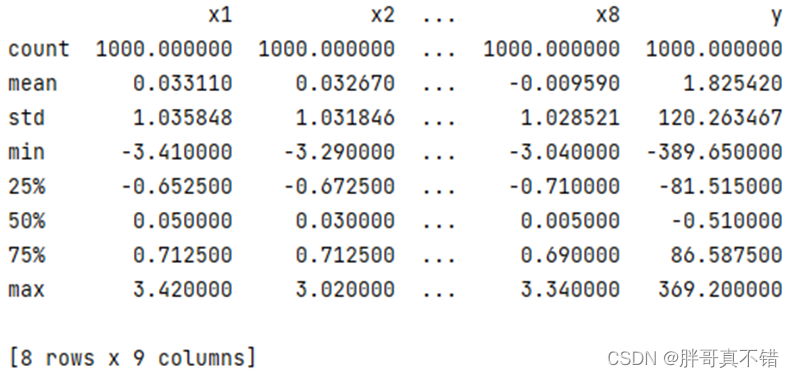

3.3数据描述性统计

通过Pandas工具的describe()方法来查看数据的平均值、标准差、最小值、分位数、最大值。

关键代码如下:

4.探索性数据分析

4.1 y变量直方图

用Matplotlib工具的hist()方法绘制直方图:

从上图可以看到,y变量主要集中在-300~300之间。

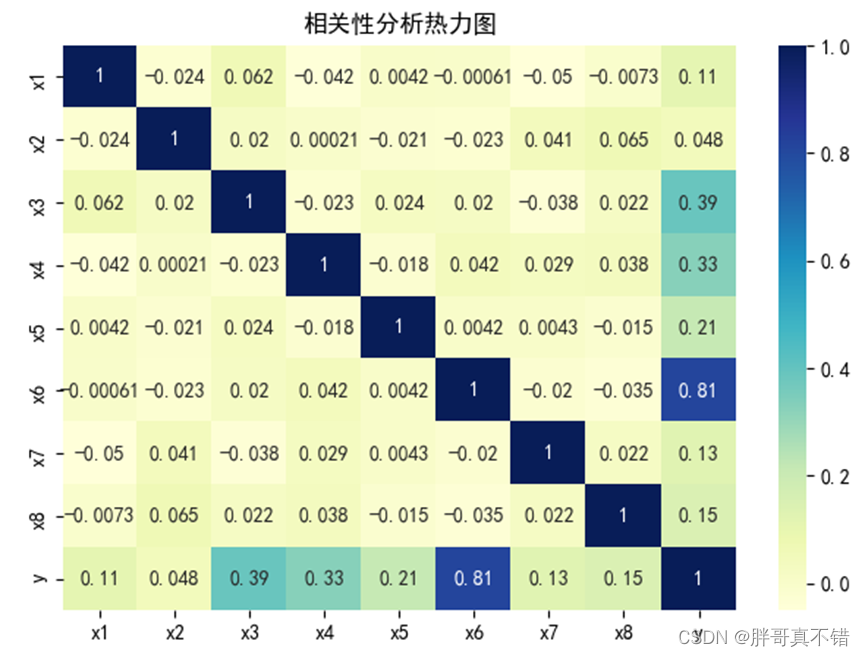

4.2 相关性分析

从上图中可以看到,数值越大相关性越强,正值是正相关、负值是负相关。

5.特征工程

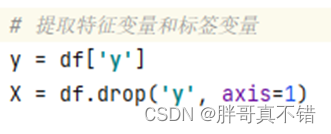

5.1 建立特征数据和标签数据

关键代码如下:

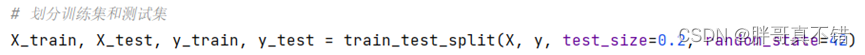

5.2 数据集拆分

通过train_test_split()方法按照80%训练集、20%测试集进行划分,关键代码如下:

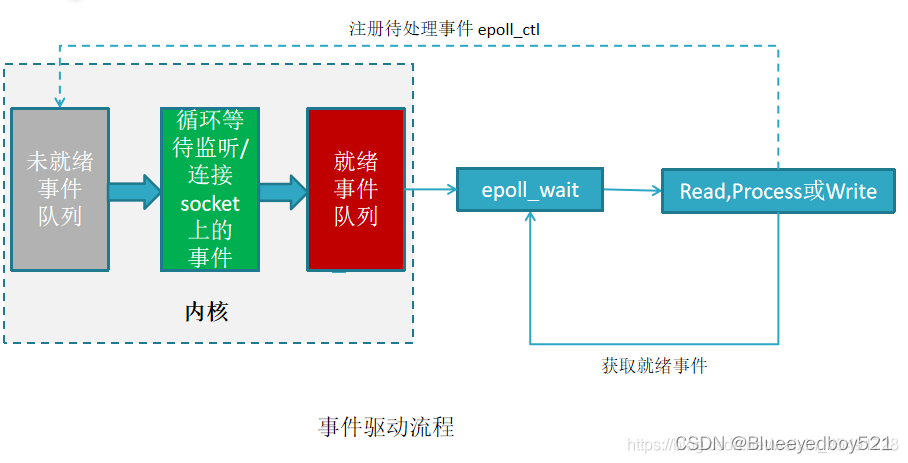

6.构建HHO哈里斯鹰优化算法优化LightGBM回归模型

主要使用HHO哈里斯鹰优化算法优化LightGBM回归算法,用于目标回归。

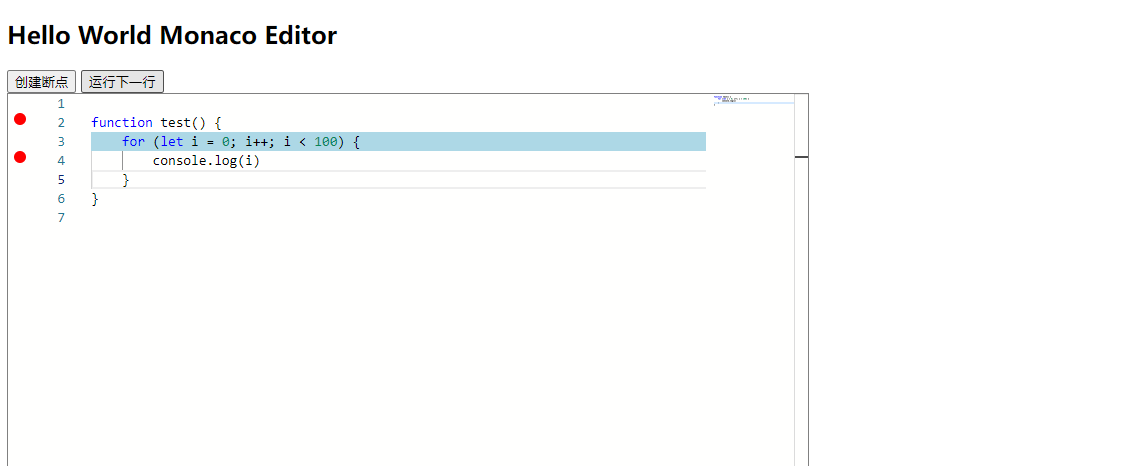

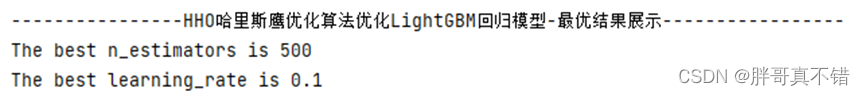

6.1 HHO哈里斯鹰优化算法寻找的最优参数

关键代码:

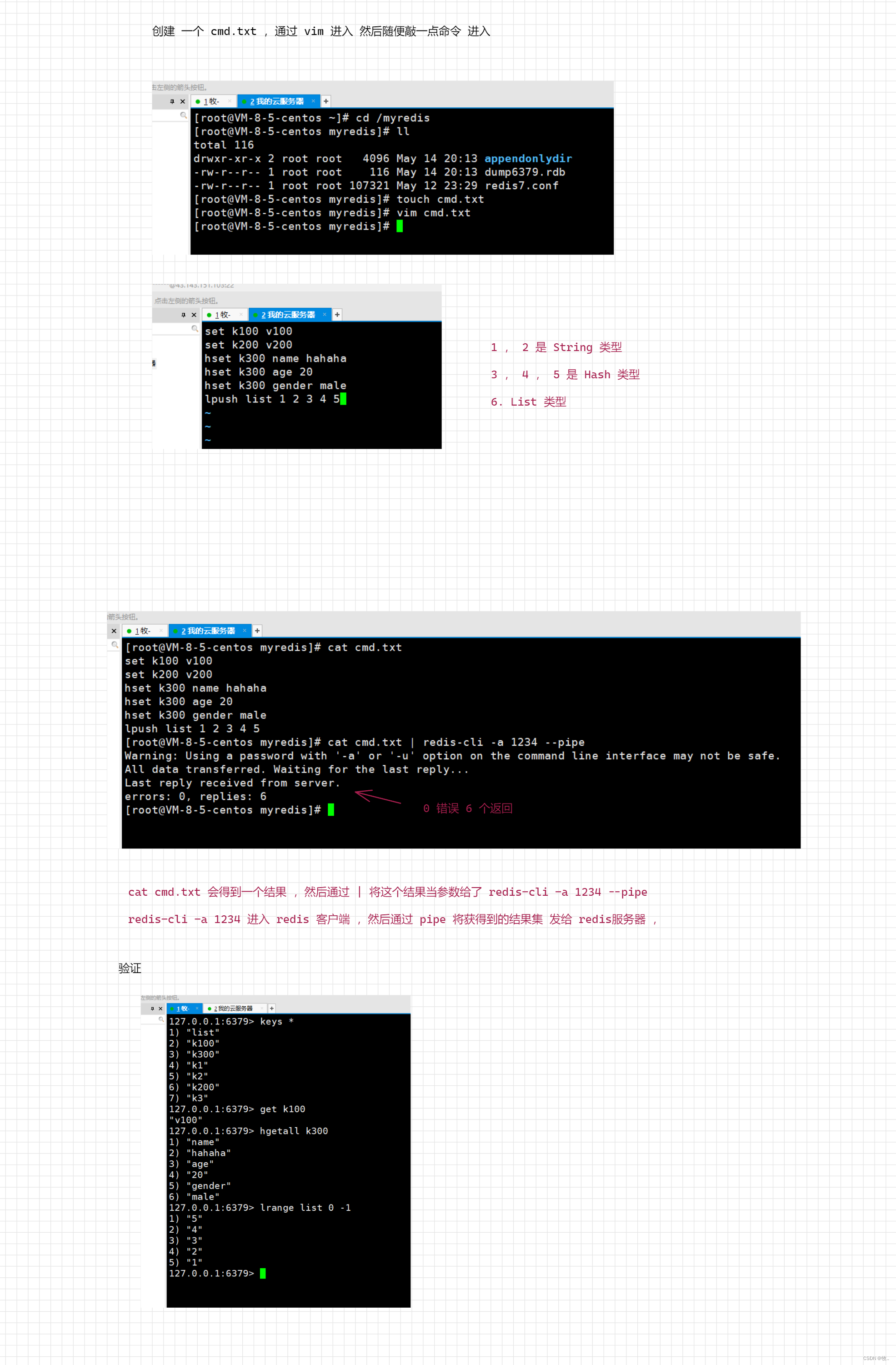

每次迭代的过程数据:

最优参数:

最优参数:

6.2 最优参数值构建模型

7.模型评估

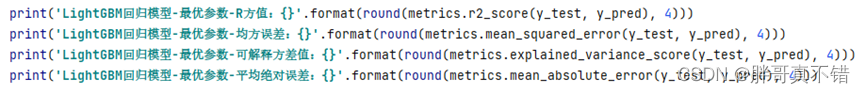

7.1 评估指标及结果

评估指标主要包括可解释方差值、平均绝对误差、均方误差、R方值等等。

从上表可以看出,R方0.9597,为模型效果良好。

关键代码如下:

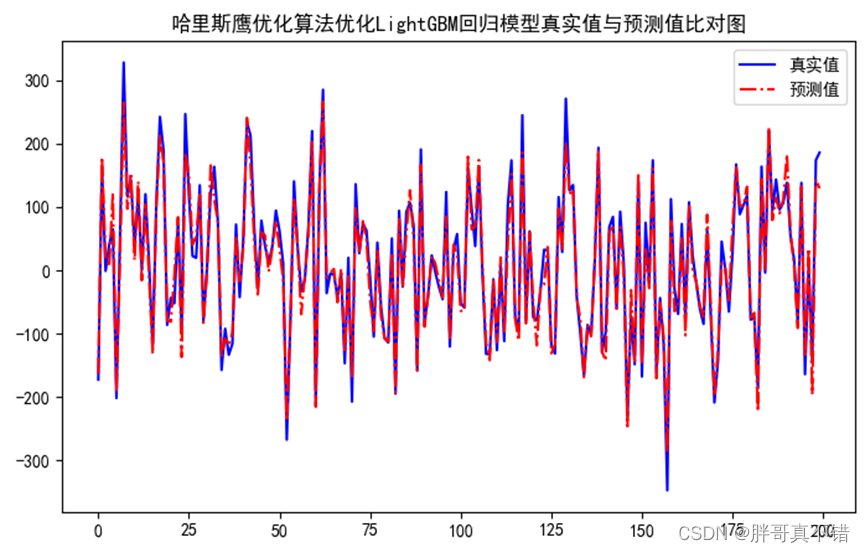

7.2 真实值与预测值对比图

7.2 真实值与预测值对比图

从上图可以看出真实值和预测值波动基本一致,模型拟合效果良好。

8.结论与展望

综上所述,本文采用了HHO哈里斯鹰优化算法寻找LightGBM回归模型的最优参数值来构建回归模型,最终证明了我们提出的模型效果良好。此模型可用于日常产品的预测。

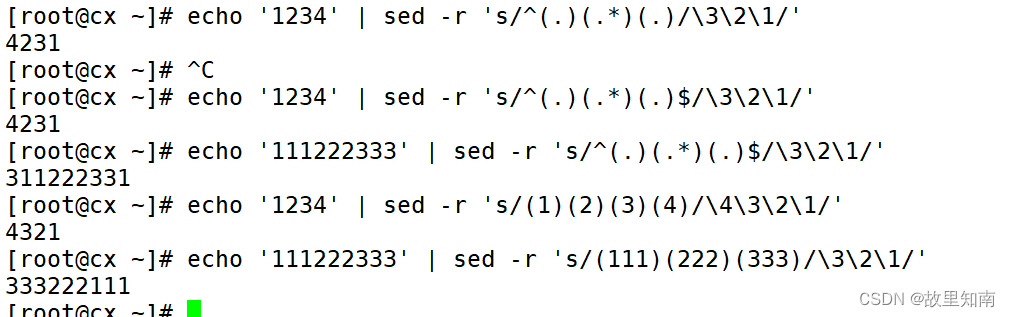

# 定义转换函数

def binary_conversion(X, thres, N, dim):

Xbin = np.zeros([N, dim], dtype='int') # 位置初始化为0

for i in range(N): # 循环

for d in range(dim): # 循环

if X[i, d] > thres: # 判断

Xbin[i, d] = 1 # 赋值

else:

Xbin[i, d] = 0 # 赋值

return Xbin # 返回数据

# ******************************************************************************

# 本次机器学习项目实战所需的资料,项目资源如下:

# 项目说明:

# 链接:https://pan.baidu.com/s/1c6mQ_1YaDINFEttQymp2UQ

# 提取码:thgk

# ******************************************************************************

# 定义错误率计算函数

def error_rate(X_train, y_train, X_test, y_test, x, opts):

if abs(x[0]) > 0: # 判断取值

n_estimators = int(abs(x[0])) + 100 # 赋值

else:

n_estimators = int(abs(x[0])) + 100 # 赋值

if abs(x[1]) > 0: # 判断取值

learning_rate = (int(abs(x[1])) + 1) / 10 # 赋值

else:

learning_rate = (int(abs(x[1])) + 1) / 10 # 赋值更多项目实战,详见机器学习项目实战合集列表:

机器学习项目实战合集列表_机器学习实战项目_胖哥真不错的博客-CSDN博客