目录

- 1. aiohttp库安装

- 2. 代码解析

- 3. 实现代码

- 总结

欢迎关注 『python爬虫』 专栏,持续更新中

欢迎关注 『python爬虫』 专栏,持续更新中

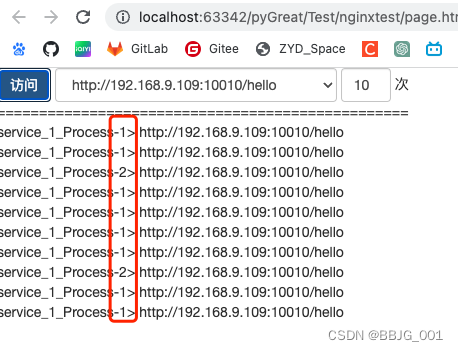

通过爬取下载得到图片

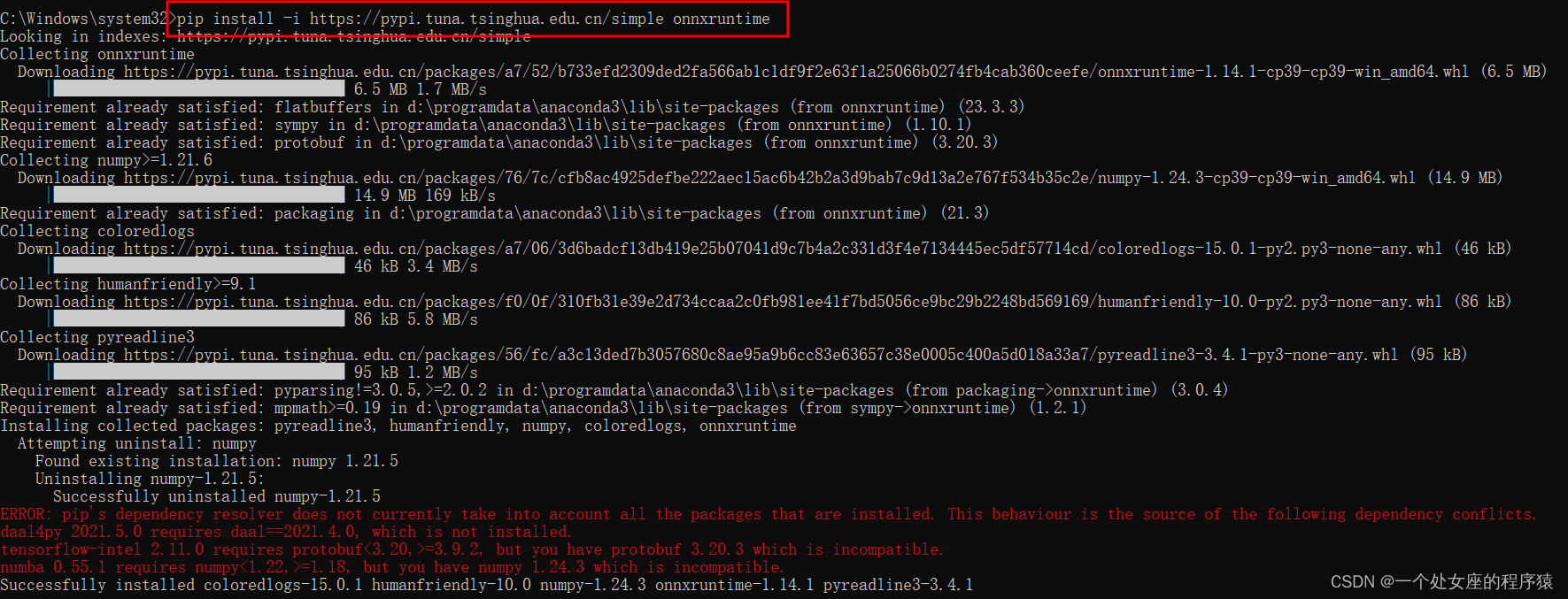

1. aiohttp库安装

pip install aiohttp

这个库的作用基本上和request一致,理解为协程中的request。

2. 代码解析

协程实现的session aiohttp.ClientSession()

这里用with表示在这个结构结束后自动关闭我们的aiohttp.ClientSession(),主要是为了省这一行代码,下面的with同理

async with aiohttp.ClientSession() as session: # requests的session

内容···

注意读取内容是异步的. 需要await挂起, 如果后面用到resp.text()也是同样的

with open(name, mode="wb") as f: # 创建文件

f.write(await resp.content.read()) # 读取内容是异步的. 需要await挂起, resp.text()

上面保存文件的代码也可以用另一个库aiofiles库(协程中的文件管理库)实现

3. 实现代码

注意你可能会遇到报错,但是图片正常爬取,想要了解详情可看文章

【Python】aiohttp库报错:raise RuntimeError(‘Event loop is closed‘) RuntimeError: Event loop is closed

# requests.get() 同步的代码 -> 异步操作aiohttp

# pip install aiohttp

import asyncio

import aiohttp

# 事先准备好的图片url列表

urls = [

"http://kr.shanghai-jiuxin.com/file/2020/1031/191468637cab2f0206f7d1d9b175ac81.jpg",

"http://kr.shanghai-jiuxin.com/file/2020/1031/563337d07af599a9ea64e620729f367e.jpg",

"http://kr.shanghai-jiuxin.com/file/2020/1031/774218be86d832f359637ab120eba52d.jpg"

]

async def aiodownload(url):

# 发送请求.

# 得到图片内容

# 保存到文件

name = url.rsplit("/", 1)[1] # 从右边切, 切一次. 得到[1]位置的图片名称-> 774218be86d832f359637ab120eba52d.jpg

async with aiohttp.ClientSession() as session: # requests的session

async with session.get(url) as resp: # resp = requests.get() 每次都request请求得到图片

# 请求回来了. 写入文件

# 写入文件的部分可以不自己写,用 aiofiles库(协程中的文件管理库)实现

with open(name, mode="wb") as f: # 创建文件

f.write(await resp.content.read()) # 读取内容是异步的. 需要await挂起, resp.text()

print(name, "图片爬取结束")

async def main():

tasks = []

for url in urls:

tasks.append(aiodownload(url))

await asyncio.wait(tasks)#提交任务

if __name__ == '__main__':

# raise RuntimeError('Event loop is closed')

# RuntimeError: Event loop is closed

# 如果出现上面的报错,取消注释下一行代码

# asyncio.set_event_loop_policy(asyncio.WindowsSelectorEventLoopPolicy())

asyncio.run(main())

总结

大家喜欢的话,给个👍,点个关注!给大家分享更多计算机专业学生的求学之路!

版权声明:

发现你走远了@mzh原创作品,转载必须标注原文链接

Copyright 2023 mzh

Crated:2023-3-1

欢迎关注 『python爬虫』 专栏,持续更新中

欢迎关注 『python爬虫』 专栏,持续更新中

『未完待续』