对抗训练方法:保卫人工智能的盾牌

在当今人工智能技术迅猛发展的时代,保护模型的鲁棒性和安全性变得尤为重要。对抗训练方法应运而生,作为一种有效的防御手段,能够使模型在面对各种攻击和噪声时保持高度的稳定性和准确性。本文将详细介绍对抗训练方法的原理,结合代码讲解,同时探讨其在NLP领域的应用,以及面临的挑战和解决方案。

1. 对抗训练方法的背景和意义

在过去的几年里,人工智能模型在各个领域取得了重大突破,但同时也面临着安全性的挑战。恶意攻击者可以通过添加微小的扰动或针对模型的攻击样本来欺骗模型,使其产生误导性的预测结果。对抗训练方法的出现为我们提供了一种保护模型免受攻击的手段。其基本思想是通过在训练过程中引入对抗性样本,使模型能够学习到如何正确识别和抵御攻击。

2. 对抗训练方法在NLP领域的应用

对抗训练方法在自然语言处理(NLP)领域具有广泛的应用。例如,对抗性样本可以用于对抗针对文本分类任务的攻击,如对抗性文本生成和输入扰动攻击。此外,对抗训练方法还可用于对抗机器翻译模型中的攻击,如翻译错误注入和输入干扰攻击。对抗训练方法的应用为NLP模型提供了更高的鲁棒性和可靠性,使其能够在面对各种攻击和干扰时保持高效和准确。

3. 对抗训练方法的基本思想和原理

对抗训练方法的基本思想是通过在模型的训练数据中添加对抗性样本,迫使模型在学习过程中对这些攻击进行识别和防御。对抗性样本是通过对原始输入样本进行微小的扰动来生成的,这些扰动通常是在人类视觉上不可察觉的。对抗训练方法依赖于生成对抗性样本的对抗生成网络(GANs)或者对抗性训练的优化算法来实现。

对抗训练方法的原理是通过最小化模型的损失函数来优化模型的参数,同时最大化对抗性样本与原始样本之间的差异,以增加模型对对抗性样本的鲁棒性。具体而言,对抗训练方法通常包括两个关键组成部分:生成器和判别器。

生成器负责生成对抗性样本,其目标是生成看似真实但具有对抗性的样本,以迷惑判别器。生成器通常基于GANs或者其他生成模型,如变分自编码器(VAEs),来生成样本。生成器会通过反向传播来更新自身的参数,以使生成的样本能够愈发接近真实样本。

判别器是一个用于判断输入样本是真实样本还是对抗性样本的模型。判别器的目标是最大化对抗性样本与真实样本之间的差异,以增加对抗性样本的识别能力。判别器也会通过反向传播来更新自己的参数,以更好地区分真实样本和对抗性样本。

对抗训练方法通常通过交替训练生成器和判别器来达到平衡。在每个训练迭代中,生成器生成对抗性样本,并将其与真实样本一起输入判别器。判别器根据输入样本的特征判断其真实性,并计算损失函数。生成器根据判别器的反馈和损失函数来更新自己的参数,以生成更具对抗性的样本。通过多次迭代训练,生成器和判别器逐渐优化,模型能够适应对抗性样本的特征,提高鲁棒性。

4. 对抗训练方法的挑战和解决方案

尽管对抗训练方法在增强模型的鲁棒性方面表现出很大的潜力,但它们仍然面临一些挑战。其中一项主要挑战是生成对抗性样本的效率和质量。生成对抗性样本需要大量的计算资源和时间来训练生成器,同时还需要确保生成的样本与真实样本的质量相当,以使训练过程有效。

另一个挑战是对抗性样本的转移能力。模型在对抗性训练中学习到的对抗性样本可能仅在特定的攻击或扰动情况下有效,而在其他攻击或扰动下失效。这种缺乏泛化能力可能导致模型在面对新的攻击时易受攻击。

为了解决这些挑战,研究人员提出了一些解决方案。其中之一是改进生成对抗网络的结构和训练算法,以提高对抗性样本的生成效率和质量。例如,研究人员使用更复杂的生成模型、采用增强学习技术或者引入额外的正则化项来改进生成器的训练。

另一个解决方案是多样性对抗训练,即使用多个生成器和判别器来训练模型。多样性对抗训练可以提高模型对不同类型攻击的适应能力,增强模型的鲁棒性。通过引入多个生成器和判别器,模型可以从不同的视角对对抗性样本进行学习和评估,从而提高模型的整体性能。

此外,数据增强和模型蒸馏也是应对对抗训练方法挑战的有效策略。数据增强可以通过对训练数据进行扩充和扰动,引入更多的对抗性样本,从而增强模型的鲁棒性。模型蒸馏则是通过训练一个辅助模型来辅助主模型的训练,提高模型的鲁棒性和泛化能力。

5. 总结

对抗训练方法作为保护人工智能模型免受攻击的有效手段,具有重要的意义。它通过引入对抗性样本和对抗性训练来提高模型的鲁棒性和安全性。在NLP领域,对抗训练方法广泛应用于文本分类、机器翻译等任务,提供了更高的鲁棒性和可靠性。然而,对抗训练方法仍然面临着挑战,包括对抗性样本的生成效率和质量以及对新攻击的泛化能力。通过改进生成网络的结构和训练算法、多样性对抗训练、数据增强和模型蒸馏等策略,可以有效应对这些挑战,进一步提升对抗训练方法的效果和应用范围。

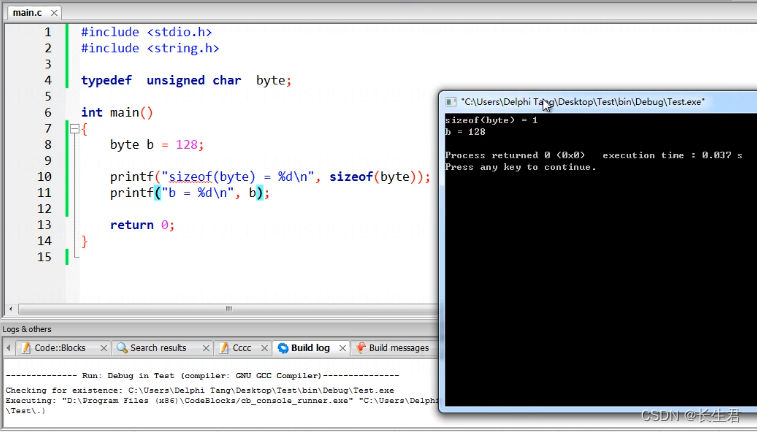

参考代码示例:

import torch

import torch.nn as nn

import torch.optim as optim

# 定义生成器和判别器模型

class Generator(nn.Module):

def __init__(self, input_dim, output_dim):

super(Generator, self).__init__()

self.fc = nn.Linear(input_dim, output_dim)

self.relu = nn.ReLU()

def forward(self, x):

x = self.fc(x)

x = self.relu(x)

return x

class Discriminator(nn.Module):

def __init__(self, input_dim):

super(Discriminator, self).__init__()

self.fc = nn.Linear(input_dim, 1)

self.sigmoid = nn.Sigmoid()

def forward(self, x):

x = self.fc(x)

x = self.sigmoid(x)

return x

# 定义对抗训练函数

def adversarial_training(generator, discriminator, data, num_epochs, lr):

criterion = nn.BCELoss()

optimizer_g = optim.Adam(generator.parameters(), lr=lr)

optimizer_d = optim.Adam(discriminator.parameters(), lr=lr)

for epoch in range(num_epochs):

for real_data in data:

# 训练判别器

optimizer_d.zero_grad()

real_labels = torch.ones(real_data.size(0), 1)

real_outputs = discriminator(real_data)

real_loss = criterion(real_outputs, real_labels)

fake_data = generator(torch.randn(real_data.size(0), 100))

fake_labels = torch.zeros(real_data.size(0), 1)

fake_outputs = discriminator(fake_data.detach())

fake_loss = criterion(fake_outputs, fake_labels)

d_loss = real_loss + fake_loss

d_loss.backward()

optimizer_d.step()

# 训练生成器

optimizer_g.zero_grad()

fake_outputs = discriminator(fake_data)

g_loss = criterion(fake_outputs, real_labels)

g_loss.backward()

optimizer_g.step()

# 打印损失

print(f"Epoch [{epoch+1}/{num_epochs}], Generator Loss: {g_loss.item():.4f}, Discriminator Loss: {d_loss.item():.4f}")

# 调用对抗训练函数

input_dim = 100

output_dim = 784

num_epochs = 100

lr = 0.0002

generator = Generator(input_dim, output_dim)

discriminator = Discriminator(output_dim)

data = torch.randn(1000, output_dim) # 替换为实际数据集

adversarial_training(generator, discriminator, data, num_epochs, lr)

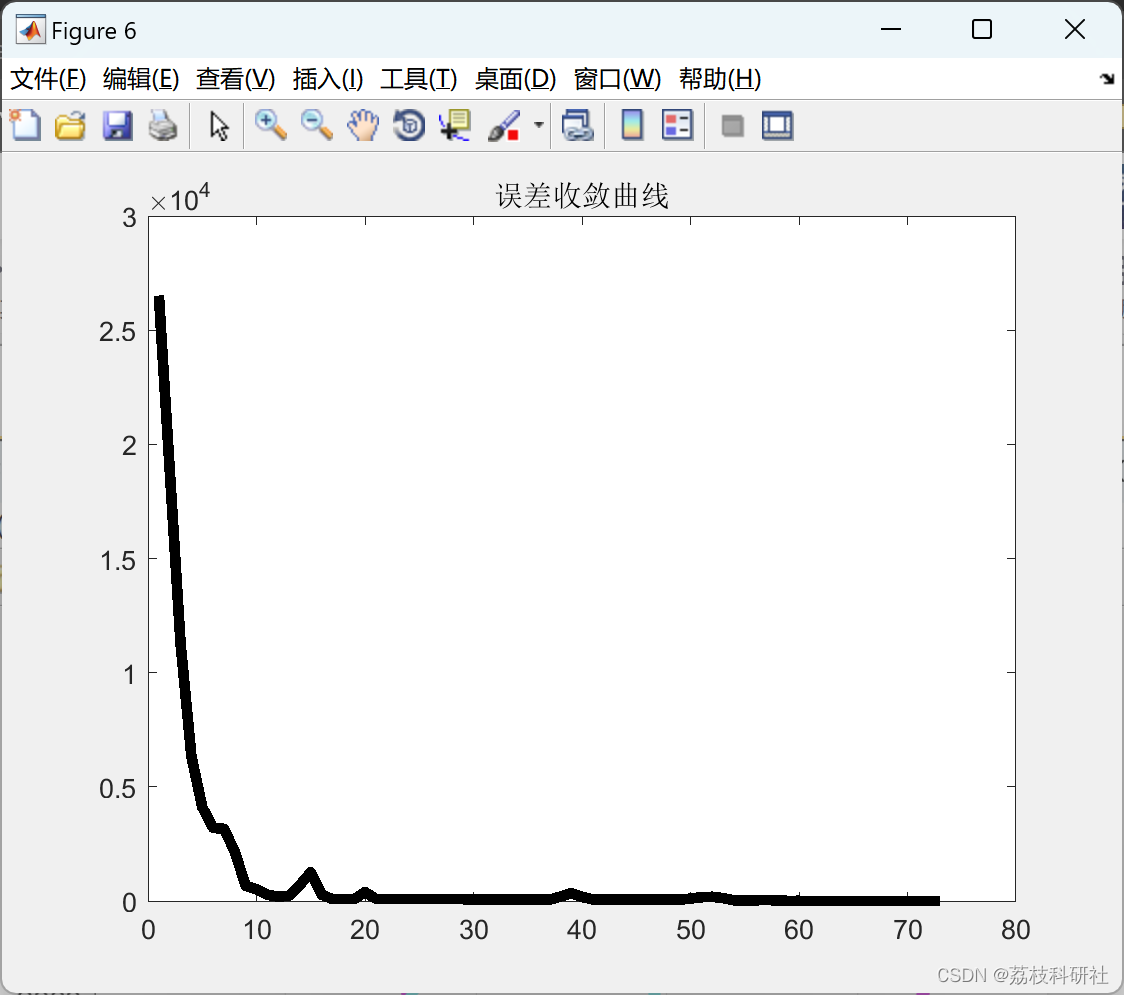

以上是一个简化的对抗训练示例,用于生成手写数字图像。其中生成器使用全连接层进行图像生成,判别器使用全连接层进行真假判断。在对抗训练过程中,生成器和判别器通过交替的优化来提高模型的性能。通过训练生成器生成逼真的手写数字图像,同时训练判别器来区分真实图像和生成图像。经过多次迭代训练后,生成器可以生成更具对抗性的图像,判别器可以更准确地判断图像的真实性。

这仅是一个简单的示例,实际应用中可能需要根据具体任务和数据集的特点进行相应的调整和改进。对抗训练方法的实现涉及到更复杂的网络结构和优化算法,如深度卷积神经网络(CNN)和更复杂的生成对抗网络(GANs)。此外,还可以采用更高级的对抗性样本生成技术,如基于进化算法的方法、对抗生成网络的变种(如CycleGAN、Pix2Pix等)等。

对抗训练方法的发展还涉及到一系列的研究方向,如对抗样本的检测和防御、对抗训练的理论分析和优化方法等。这些研究方向的探索有助于进一步提升对抗训练方法的效果和应用范围,并推动人工智能模型的安全性和鲁棒性发展。

对抗训练方法的应用和研究将进一步推动人工智能模型的安全性和鲁棒性发展。通过持续的研究和改进,我们可以期待对抗训练方法在更广泛的领域和任务中发挥重要作用,为人工智能技术的应用和发展提供更可靠的保护。