在本文中,研究者提出了一个完全稀疏且以体素为基础的3D物体检测和跟踪框架VoxelNeXt。它采用简单的技术,运行快速,没有太多额外的成本,并且可以在没有NMS后处理的情况下以优雅的方式工作。VoxelNeXt在大规模数据集nuScenes、Waymo和Argoverse2上表现出很好的速度和精度;在Argoverse2 3D检测和nuScenes 3D LiDAR跟踪上取得了SOTA的结果。

想要关注该项工作的更多内容?欢迎查看来自本文作者陈玉康带来的Talk分享!

正在上传…重新上传取消![]() https://mp.weixin.qq.com/s?__biz=MzAxMzc2NDAxOQ==&mid=2650447242&idx=1&sn=91d75e69b9486ccbe0818123a3c079e4&scene=21#wechat_redirect

https://mp.weixin.qq.com/s?__biz=MzAxMzc2NDAxOQ==&mid=2650447242&idx=1&sn=91d75e69b9486ccbe0818123a3c079e4&scene=21#wechat_redirect

论文链接:https://arxiv.org/abs/2303.11301

代码链接:https://github.com/dvlab-research/VoxelNeXt

一、摘要

目前,自动驾驶场景的3D检测方法大多采用稠密特征的检测头,而3D点云数据本身是稀疏的,这无疑是一种低效和浪费计算量的做法。我们提出了一种全稀疏的3D 检测框架 VoxelNeXt. 该方法可以直接从稀疏的体素特征来预测3D物体,无需借助成anchor, center, voting等中间状态的媒介。

此外,该方法在取得检测速度优势的同时,还能很好地帮助多目标跟踪。VoxelNeXt在大规模公开数据集nuScenes、Waymo、Argoverse2上都取得了很好的效果,并在Argoverse2 LiDAR 检测和nuScenes LiDAR多目标跟踪上取得SOTA。此外,VoxelNeXt由于其全稀疏的特性,能够很好地结合 Segment Anything [1],在点击图像的同时不仅能获得2D mask,还能获得 3D box,可以在很大程度上方便3D物体的标注https://github.com/dvlab-research/3D-Box-Segment-Anything。

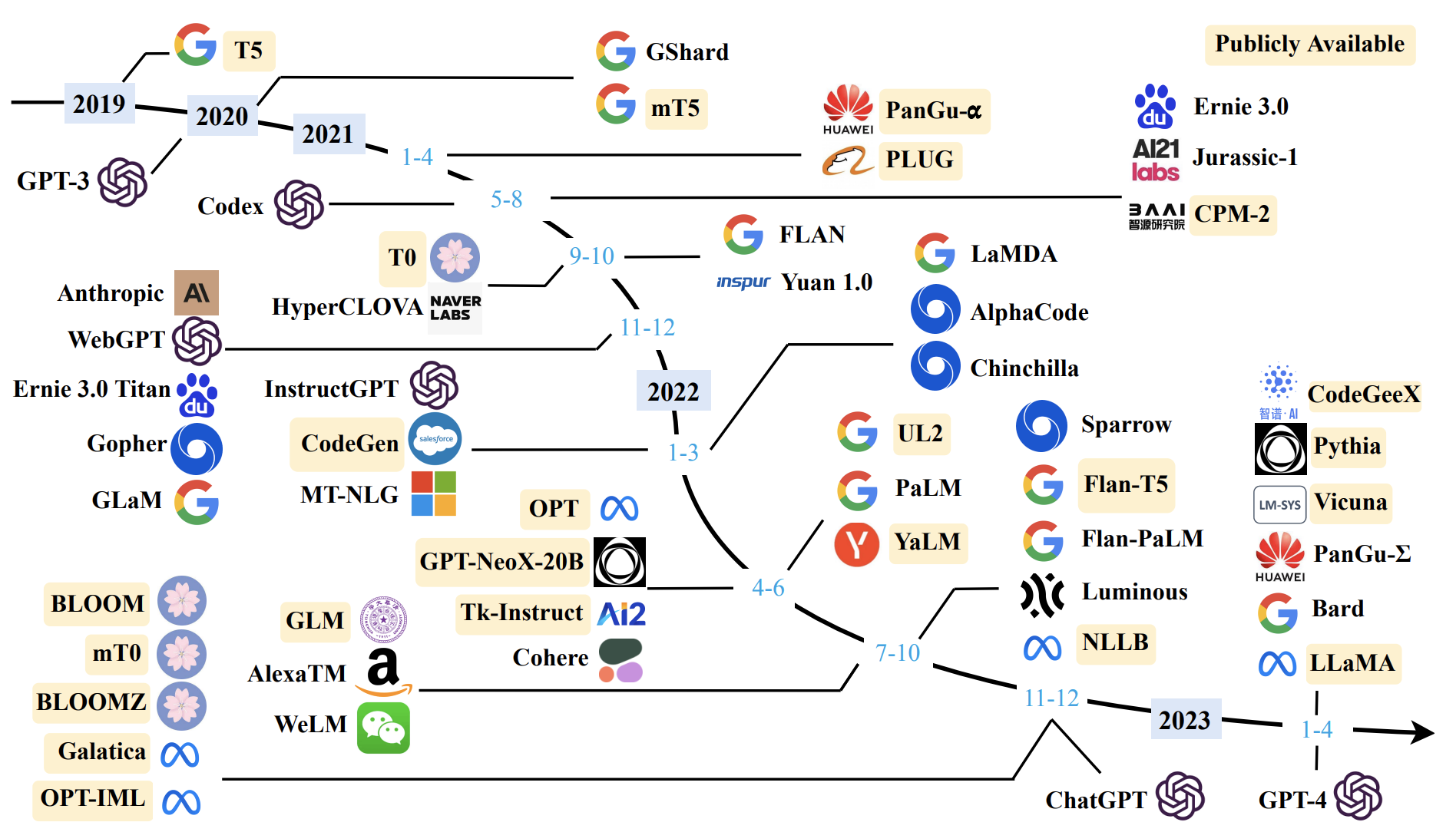

二、背景介绍

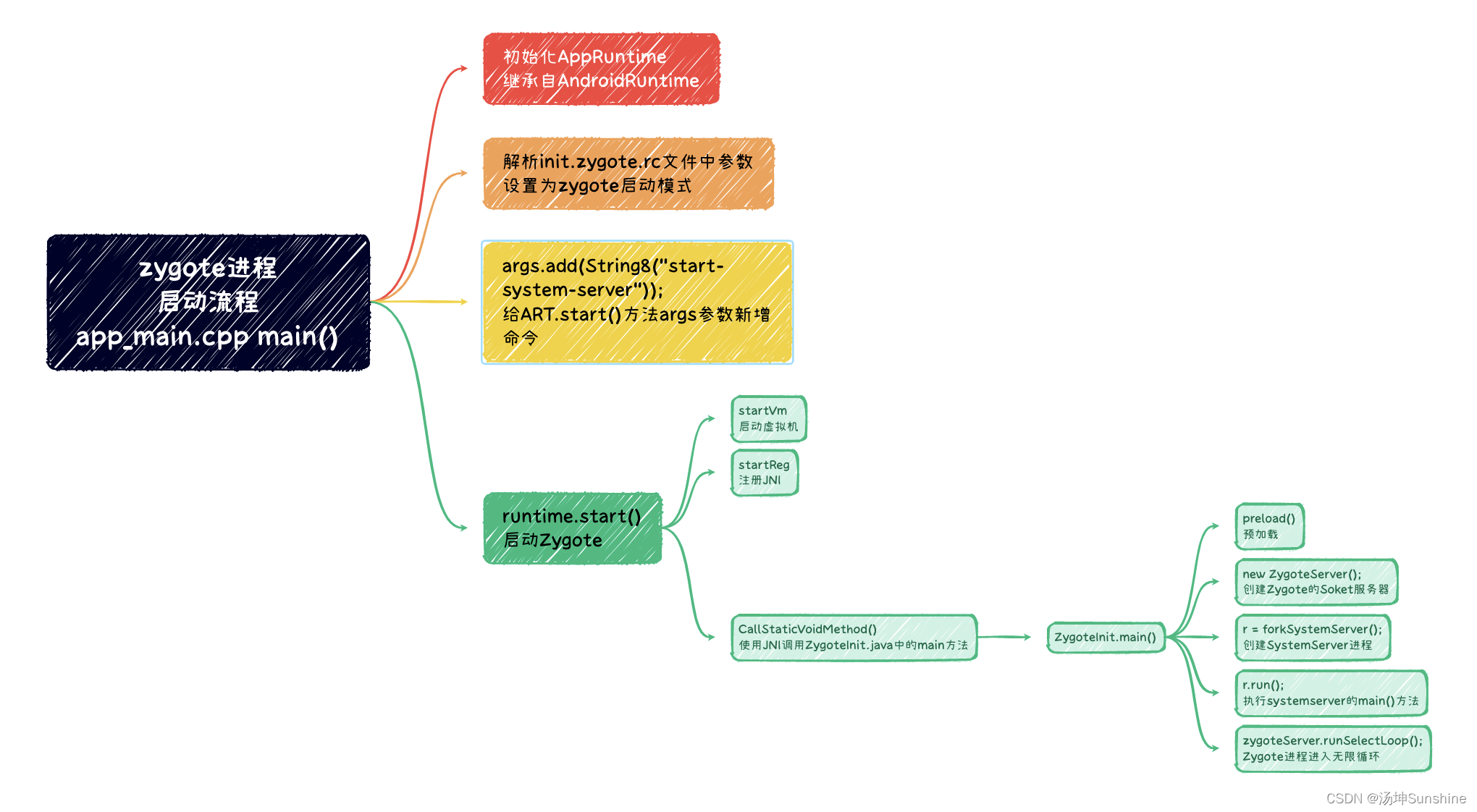

3D感知是自主驾驶系统中的一个基本组成部分。3D检测网络以稀疏点云或体素作为输入。大多数3D目标检测器[2, 3, 4]通常使用稀疏卷积网络(Sparse CNNs)[5]进行特征提取,因其效率高。受2D目标检测框架启发,现有的方法通常用锚点[2, 3]或中心点[4]来预测,即CenterPoint [4]中的密集点锚点。它们都是手工制作的,作为3D对象的中间代理。

然而,锚点和中心点设计初衷是针对常规和网格结构的图像数据,并不考虑三维数据的稀疏性和不规则性。为了使用这些代理表示法,主流的检测器将3D稀疏特征转换为二维密集特征,以构建有序锚点或中心的密集检测头。虽然有用,但这种dense head的方式显然是不够高效的。

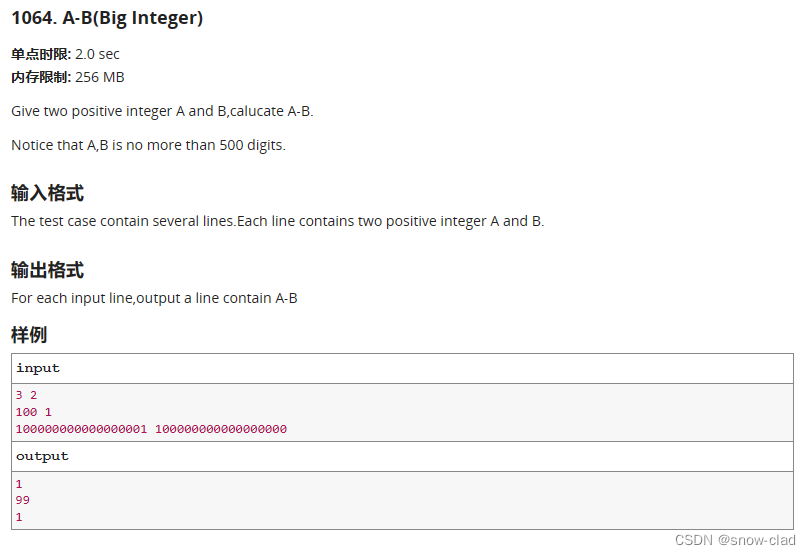

图 1 CenterPoint 点云输入和BEV heatmap

在图1中,我们展示了CenterPoint[4]中的热力图。很明显,大部分空间几乎没有预测得分。由于固有的稀疏性和许多背景点,只有少数点有响应,在nuScenes验证集上Car类平均少于1%的点。然而,现有的检测头会在特征图中所有位置进行计算,它们不仅浪费了很多计算资源,还用冗余的预测使检测管道变得更加复杂。需要使用非极大值抑制(NMS)之类的后处理方法来消除重复的检测结果。这些限制促使我们寻求替代的稀疏检测解决方案。

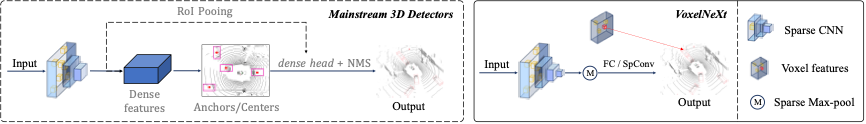

图 2 VoxelNeX和主流检测框架结构对比

三 、方法介绍

在本文中,我们提出了VoxelNeXt。它是一种简单,高效且无需后处理的3D物体检测器。我们设计的核心是直接从体素特征中预测3D物体,使用一种强大的完全稀疏卷积网络。如图2所示,我们方法的关键优势在于,可以摆脱锚点代理,稀疏转密集,区域建议网络和其他复杂的组件。

图 3 VoxelNeXt 框架具体细节

VoxelNeXt 包含了4个实现细节:1) 多下采样两次,2) 将3D稀疏体素压缩成2D 稀疏体素,3)sparse max pooling (可以和NMS替代),4)用3x3 sparse conv或FC来预测物体。

图 4 多下采样两次对于预测结果和感受野的影响

其中,“多下采样两次”是对于效果来说最重要的操作。想实现“从稀疏的体素直接预测物体”的前提是体素特征需要有足够大的感受野。而“多下采样两次”刚好弥补了感受野的不足,如图4所示。且非常好实现,也不会增加太多额外的计算量。

四 、实验分析

我们统计了用于预测物体的体素 (query voxel) 和相应预测框之间的关系表格,如表1所示。可以看出,大多数的物体都是基于靠近物体边界的体素预测出来的,而非靠近中心的体素。对于一些比较小的物体,如Pedestrian,甚至可以用物体以外的体素进行预测,如图5所示。

表 1 预测物体的体素和预测框之间的位置关系

图 5 预测物体的体素(query voxel)和预测框

我们还对比了和基于中心点预测的传统方法CenterPoint的结果,发现VoxelNeXt相比于CenterPoint的优势主要来自于在物体方向(Orientation)上的精准预测。相比于中心点,靠近物体边界的体素可能对物体方向有着更好的把控。

此外,我们还在Argoverse2数据集上进行了实验。相比于Waymo, nuScenes等75m半径的检测范围,Argoverse2最大的检测范围是200m半径。如图6所示,CenterPoint这种稠密的检测头会随着检测范围的增加而急剧增加。而FSD [5] 和 VoxelNeXt 这类全稀疏的检测器速度恒定,其中VoxelNeXt由于其简洁性,速度快。

图 6 在Argoverse2数据集上,不同检测范围消耗的计算时间

五 、结合 Segment Anything

图 7 结合Segment Anything和VoxelNeXt进行 promtable 3D检测

我们在 Segment Anything 的基础上加入了VoxelNeXt 3D物体检测。可以直接点击图像,不仅能获得2D mask,还能获得3D框。这样的结合把3D检测变成了promtable的,可以在很大程度上方便3D物体的标注。

六 、后记

我们提出了一个完全稀疏且以体素为基础的3D物体检测和跟踪框架VoxelNeXt。它采用简单的技术,运行快速,没有太多额外的成本,并且可以在没有NMS后处理的情况下以优雅的方式工作。我们首次展示了直接基于体素的预测是可行和有效的。因此,锚点或中心以及密集头变得不必要。VoxelNeXt在大规模数据集nuScenes [7]、Waymo [8] 和Argoverse2 [9] 上表现出很好的速度和精度。VoxelNeXt在Argoverse2 3D检测和nuScenes 3D LiDAR跟踪上取得了SOTA的结果。

参考文献

[1] Alexander Kirillov, Eric Mintun, Nikhila Ravi, Hanzi Mao, Chloe Rolland, Laura Gustafson, Tete Xiao, Spencer Whitehead, Alexander C. Berg, Wan-Yen Lo, Piotr Doll{'a}r, Ross Girshick

[2] Shaoshuai Shi, Chaoxu Guo, Li Jiang, Zhe Wang, Jianping Shi, Xiaogang Wang, and Hongsheng Li. PV-RCNN: pointvoxel feature set abstraction for 3d object detection. In CVPR, pages 10526–10535, 2020.

[3] Jiajun Deng, Shaoshuai Shi, Peiwei Li, Wengang Zhou, Yanyong Zhang, and Houqiang Li. Voxel R-CNN: towards high performance voxel-based 3d object detection. In AAAI, pages 1201–1209, 2021.

[4] Tianwei Yin, Xingyi Zhou, and Philipp Krahenbuhl. Centerbased 3d object detection and tracking. In CVPR, pages 11784–11793, 2021.

[5] Benjamin Graham, Martin Engelcke, and Laurens van der Maaten. 3d semantic segmentation with submanifold sparse convolutional networks. In CVPR, pages 9224–9232, 2018.

[6] Lue Fan, Feng Wang, Naiyan Wang, Zhaoxiang Zhang, Fully Sparse 3D Object Detection, NeurIPS 2022

[7] Holger Caesar and at.al. nuscenes: A multimodal dataset for autonomous driving. In CVPR, pages 11618–11628, 2020.

[8] Pei Sun and et. al. Scalability in perception for autonomous driving: Waymo open dataset. In CVPR, pages 2443–2451, 2020.

[9] Benjamin Wilson and et. al. Argoverse 2: Next generation datasets for self-driving perception and forecasting. In NeurIPS, 2021.

作者:陈玉康

Illustration by IconScout Store from IconScout

-The End-