theme: orange

预训练 Pre-Training 已被证明是当前人工智能范式中最重要的方面之一,大型语言模型,要转变为通用引擎,需要预训练。

什么是预训练模型

人工智能中的预训练至少部分受到人类学习方式的启发。我们不需要从零开始学习一个主题,而是将现有知识转移和重新用途,以理解新想法和应对不同任务。

在AI模型中,类似的过程也在发生。首先在某个任务或数据集上训练模型,然后使用得到的参数在另一个不同的任务或数据集上训练另一个模型。实际上,模型可以基于先前的经验来执行新任务。

预训练模型是一种已经在大量数据上进行过训练的神经网络模型,通常具有较强的特征提取能力。预训练模型可以视为一个通用的知识库,其内部权重已经学习到了许多通用的特征表示,这些特征在不同任务中具有广泛的适用性。

预训练的最关键方面之一是任务相关性,即模型最初学习的任务必须与将来要执行的任务相似。例如,一个用于物体检测的训练模型不能用于预测天气。

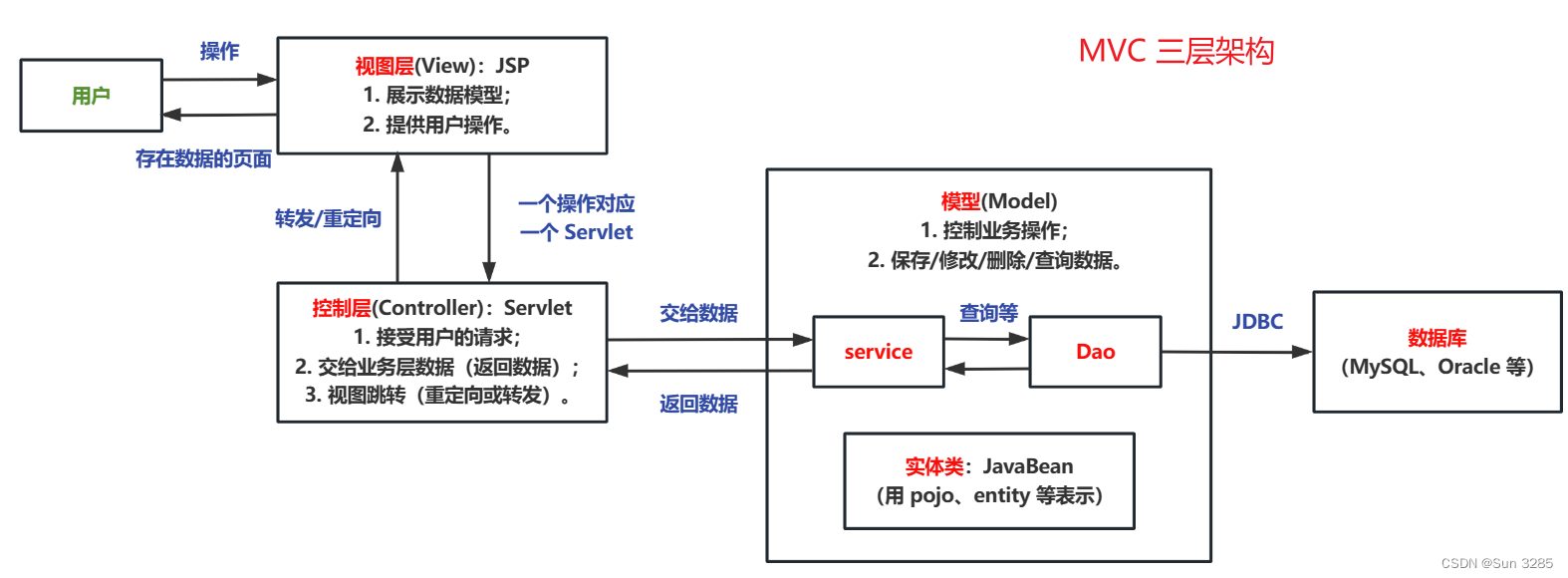

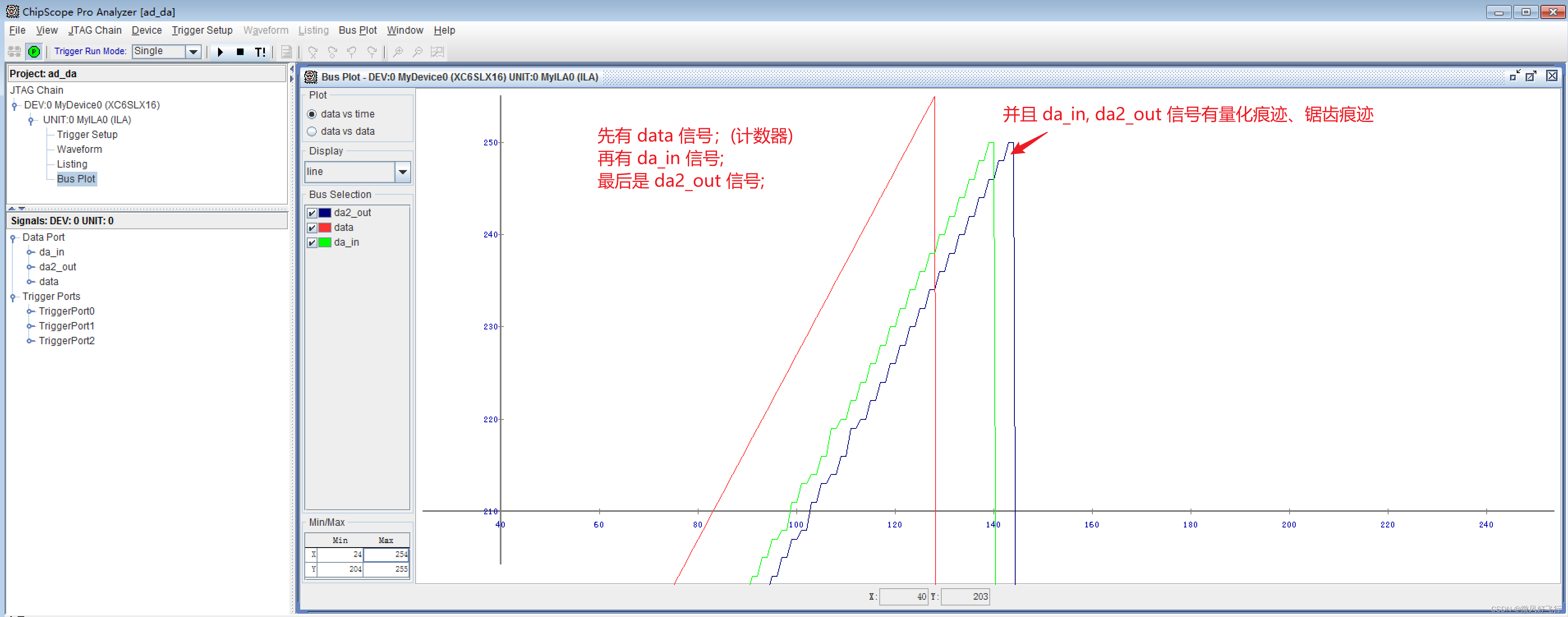

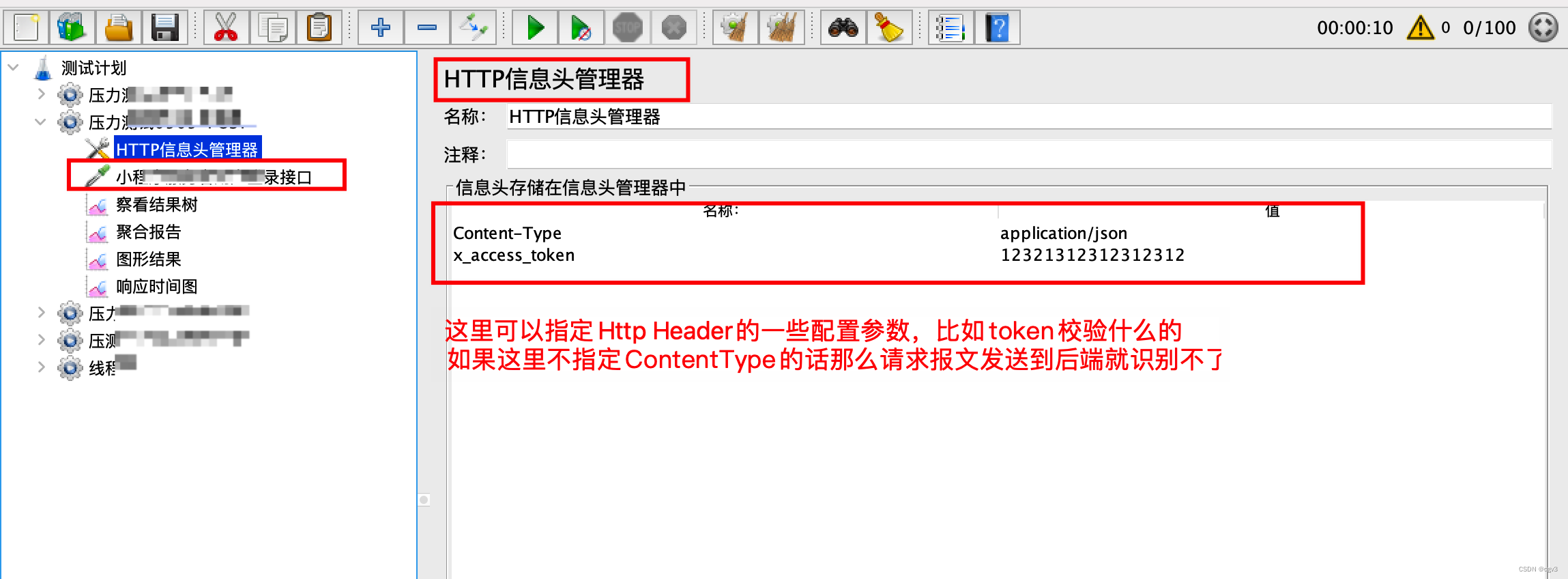

下图展示了Pre-training 和 Fine-tuning 在模型训练流程中分别所处的位置,足以表达预训练的重要性。

预训练模型的方法

以下是在自然语言处理领域进行预训练的一些方法。

Word2vec

Word2vec是由谷歌开发的一种工具,可以生成静态词嵌入,并通过衡量词与词之间的相似性在数百万词上进行训练。Word2Vec是一类训练以构建语言词语上下文的相关模型的一部分。

该模型于2013年发布,一旦经过训练,便可以检测同义词,并为部分句子提供额外的词汇建议。

GPT

GPT是基于自注意力核心前提的基于Transformer解码器的语言模型。为了计算给定输入序列的表示,模型可以关注序列的不同位置。

GPT分两个阶段进行训练。在第一阶段,创造者OpenAI使用无标签数据上的语言建模目标来学习初始参数。然后,使用相应的监督目标将这些参数调整为目标任务(又称为训练示例)。

BERT

BERT是另一个基于Transformer解码器的语言模型,首先在大量文本(如维基百科)上进行训练。

BERT是一个微调和基于编码器的模型,具有双向语言模型特征。与GPT等基于解码器的模型使用的从左到右的单词保护不同,BERT基于两个新任务进行操作。

该模型的第一个预训练任务被称为Masked Language Model(MLM),其中15%的单词被随机遮盖,BERT被要求预测它们。正如我们所提到的,BERT可以在任一方向预测词汇。

第二个任务与模型输入有关。BERT不使用词作为标记,而是使用词片段。例如,单词“working”是“work”和“ing”,而不是“working”。然后,模型添加位置嵌入以避免自注意力的弱点,即忽略词位置信息。