探索文本生成世界:原理、技术与应用

文本生成技术已经成为人工智能领域中备受关注的研究方向,它在自然语言处理、机器翻译、推荐系统等领域有着广泛的应用。本文将详细介绍文本生成的原理、技术、算法和应用,同时结合代码进行讲解,帮助读者更深入地了解和掌握文本生成技术。

1. 引言

文本生成技术是指计算机通过一定的算法和模型生成自然语言文本的过程。在自然语言处理、机器翻译、文本摘要、聊天机器人、自动作文、音乐生成、画作生成等领域中,文本生成技术已经有了广泛的应用。

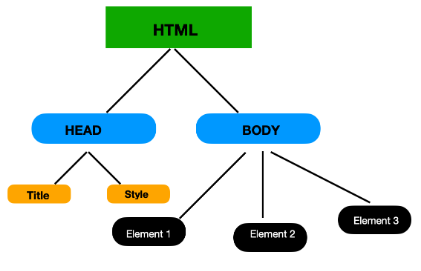

2. 原理讲解

文本生成技术的实现需要涉及到自然语言处理、深度学习、语言模型等方面的知识。其中,语言模型是文本生成的核心,它主要用来对输入的文本进行建模,通过建模学习语言的统计规律,从而实现文本生成。

在语言模型中,最常用的是n-gram模型和神经网络语言模型(NNLM)。n-gram模型是一种基于统计的语言模型,它通过计算文本中每个词出现的频率来学习语言的统计规律。而神经网络语言模型则是一种基于神经网络的语言模型,它可以学习到更加复杂的语言模式,具有更好的泛化性能。

3. 技术和算法

文本生成技术中,最常用的算法是生成式模型和判别式模型。生成式模型是指通过学习文本的概率分布,生成新的文本。判别式模型则是通过学习输入和输出之间的映射关系,生成新的输出。

常见的文本生成技术包括基于规则的文本生成、基于马尔可夫模型的文本生成、基于神经网络的文本生成等。其中,基于神经网络的文本生成技术是目前最流行的方法,它主要包括循环神经网络(RNN)、长短时记忆网络(LSTM)、门控循环单元网络(GRU)等。

4. 应用案例和代码讲解

文本生成技术的应用非常广泛,例如可以用于机器翻译、自动作文、智能客服、智能推荐等方面。在这里,我们以LSTM网络为例,来展示文本生成技术的具体应用和代码实现。

LSTM网络是一种常用的循环神经网络,它通过在每个时间步上引入门控机制,解决了传统循环神经网络中的梯度消失和梯度爆炸问题,从而更好地学习长序列数据。

下面是一个简单的LSTM文本生成模型的代码实现:

import tensorflow as tf

from tensorflow.keras.layers import Embedding, LSTM, Dense

# 定义文本序列长度和词汇表大小

seq_length = 100

vocab_size = 10000

# 构建LSTM模型

model = tf.keras.Sequential([

# 词嵌入层

Embedding(vocab_size, 256, batch_input_shape=[1, None]),

# LSTM层

LSTM(1024, return_sequences=True, stateful=True),

LSTM(1024, return_sequences=True, stateful=True),

LSTM(1024, stateful=True),

# 输出层

Dense(vocab_size, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy')

# 加载训练数据

data = ...

# 训练模型

for epoch in range(10):

for batch in data:

# 将输入序列和目标序列分别取出

inputs, targets = batch[:,:-1], batch[:,1:]

# 训练模型

loss = model.train_on_batch(inputs, targets)

# 打印损失值

print("Epoch {} Batch {} Loss {:.4f}".format(epoch+1, i, loss))

# 保存模型

model.save_weights('model_weights.h5')

上述代码中,首先我们定义了文本序列长度和词汇表大小,然后构建了一个包含三个LSTM层的文本生成模型。在编译模型之后,我们通过加载训练数据,使用train_on_batch()函数进行模型训练。在训练过程中,我们将输入序列和目标序列分别取出,然后训练模型并保存模型权重。

5. 总结

文本生成技术是人工智能领域中非常重要的一项技术,它已经在自然语言处理、机器翻译、推荐系统等领域中有着广泛的应用。本文对文本生成的原理、技术、算法和应用进行了详细的介绍,并结合了一个LSTM文本生成模型的代码实现,希望能够帮助读者更深入地了解和掌握文本生成技术。