这节可以搭配

- 【机器学习】Logistic回归(重新整理)

- 信息量(信息)

- 信息量公式的推理过程

- 香农熵

- 信息增益

【机器学习】Logistic回归(重新整理)

B站视频:“交叉熵”如何做损失函数?打包理解“信息量”、“比特”、“熵”、“KL散度”、“交叉熵”

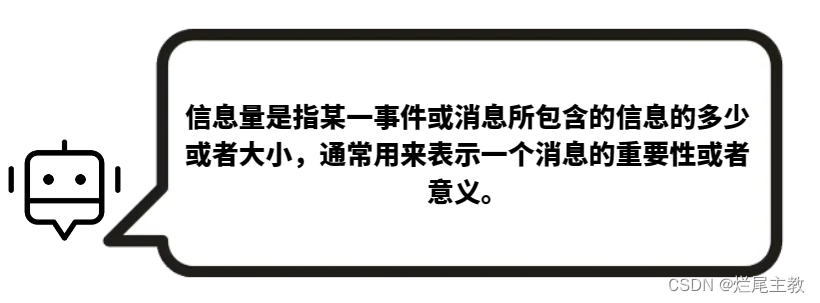

信息量(信息)

举个例子:

如果有人告诉你,今天太阳从东边出来了,那么这条信息的信息量就很低,因为每天的太阳常常从东边出来。

但是,突然某一天有人告诉你,今天太阳是从西边出来的,那么这条信息的信息量就很高,因为,在你的意识里,太阳几乎不可能从西边出来

“很高”,“很低”这些都是很模糊的形容词,那么我们怎么量化这些信息程度呢?哎嘿!这就是信息量。

信息量公式的推理过程

“日出东方”这是一个大概率事件,其携带信息量很少。而“日出西方”是一个小概率事件,它所携带的信息量就很大了。

从上面可以得出一个结论就是:信息量的高低总是和一个事件的概率负相关(片面理解)

猜想一:那么是不是

1

p

i

\frac{1}{p_i}

pi1(

p

i

p_i

pi事件i发生的概率)就可以量化的表示信息的信息量了。

答:不完全正确,虽然在一些情况下,信息量可以通过一个事件发生的概率来表示,但是

1

p

i

\frac{1}{p_i}

pi1并不能准确地表示信息量.

知识点一:在信息论中,通常使用负对数函数来计算信息量。对于一个事件 i,其信息量

I

i

I_i

Ii 可以表示为:

I

i

:

=

−

l

o

g

2

p

i

I_i:=-log_2p_i

Ii:=−log2pi

其中

p

i

p_i

pi表示事件i发生的概率

这个公式的物理意义是,当事件 i 发生的概率越小时,其所包含的信息量就越大。例如,在一组有 8 个等概率的符号中选出一个符号,它所包含的信息量为 − l o g 2 ( 1 8 ) = 3 -log_2(\frac{1}{8})=3 −log2(81)=3比特。而当在同一组符号中选出一个概率为 1 的符号时,它所包含的信息量为 − l o g 2 1 = 0 -log_21=0 −log21=0 比特。

以2为底的优势就是单位为比特,这个写进了信息量的定义,不能更改。 log的优势是可以将P(AB) = P(A)·P(B) 转化为 I(AB) = I(A)+I(B),逻辑自洽。

香农熵

给定题目:有一枚均匀的硬币 C 1 C_1 C1(正面的概率和抛反面概率都是0.5),还有一枚不均匀的硬币 C 2 C_2 C2(正面概率0.8,反面概率0.2)

- 事件A:正面

- 事件B:反面

事件(A|B)发生的难度有多大?这就是熵

简单说,就是

- 信息量:衡量某一具体事件从不确定到确定的难度大小

- 熵:衡量整个系统的所有事件从不确定到确定的难度大小

猜想二:是不是可以简单的将系统中的所有事件的信息量加和大小作为整个系统的香农熵值?

答:不完全正确。香农熵是用来衡量一个系统的不确定性或者信息量的度量方式。在信息论中,香农熵通常被定义为一个系统中所有可能事件的信息量的期望值。

知识点一:香农熵是信息论中的一个概念,通常用符号H表示。它描述的是一个离散信源所产生的信息量的平均值。具体地说,如果一个离散信源可以发出n个符号,每个符号出现的概率分别为p1,p2,…,pn,那么这个信源每产生一个符号所带来的信息量就是-log2(pi)(以2为底的对数),而香农熵就是所有符号的信息量的平均值: H = − ∑ p ( x ) ⋅ l o g 2 p ( x ) H=-\sum p(x)·log_2{p(x)} H=−∑p(x)⋅log2p(x)

如果将第一个p(x)修改为y,变化后的公式就是交叉熵。想一想为啥?提示:KL散度

结合上面例子,系统

C

1

、

C

2

C_1、C_2

C1、C2的香农熵就是

H

C

1

=

−

(

0.5

∗

l

o

g

2

(

0.5

)

+

0.5

∗

l

o

g

2

(

0.5

)

)

=

1

H_{C_1}=-(0.5*log_2(0.5)+0.5*log_2(0.5))=1

HC1=−(0.5∗log2(0.5)+0.5∗log2(0.5))=1

H

C

2

=

−

(

0.8

∗

l

o

g

2

(

0.8

)

+

0.2

∗

l

o

g

2

(

0.2

)

)

≈

0.722

H_{C_2}=-(0.8*log_2(0.8)+0.2*log_2(0.2))≈0.722

HC2=−(0.8∗log2(0.8)+0.2∗log2(0.2))≈0.722

信息增益

其公式为:

G

a

i

n

(

D

,

A

)

=

H

(

D

)

−

∑

v

=

1

V

∣

D

v

∣

D

H

(

D

v

)

Gain(D,A)=H(D)-\sum_{v=1}^{V}\frac{|D_v|}{D}H(D_v)

Gain(D,A)=H(D)−v=1∑VD∣Dv∣H(Dv)

其中

D

v

D_v

Dv为划分数据集(子集)

它表示的含义是,划分过后,新的集合相对于原集合减少了多少不确定性,比如

给定数据:

数据拟定背景:小明想出去玩?

| ID | Class | Wind | Temp | Outlook |

|---|---|---|---|---|

| 1 | Play | Weak | Hot | Sunny |

| 2 | Play | Strong | Hot | Sunny |

| 3 | Stay | Weak | Hot | Rain |

| 4 | Play | Weak | Mid | Overcast |

| 5 | Stay | Strong | Cold | Rain |

| 6 | Play | Weak | Cold | Overcast |

| 7 | Stay | Strong | Cold | Rain |

| 8 | Play | Weak | Mid | Sunny |

| 9 | Play | Weak | Cold | Sunny |

| 10 | Play | Strong | Mid | Overcast |

| 11 | Stay | Weak | Mid | Sunny |

| 12 | Stay | Strong | Mid | Rain |

| 13 | Play | Weak | Hot | Overcast |

| 14 | Play | Weak | Cold | Rain |

- 对于系统香农熵 H ( D ) H(D) H(D)

| Class | Count |

|---|---|

| play | 6 |

| stay | 4 |

H ( D ) = − ∑ p ( x ) ⋅ l o g 2 p ( x ) = − ( 9 14 l o g 2 9 14 + 5 14 l o g 2 5 14 ) = 0.94 H(D)=-\sum p(x)·log_2{p(x)}=-(\frac{9}{14}log_2\frac{9}{14}+\frac{5}{14}log_2\frac{5}{14})=0.94 H(D)=−∑p(x)⋅log2p(x)=−(149log2149+145log2145)=0.94

- 计算关于Wind的信息增益

| Weak | Strong | |

|---|---|---|

| Play | 7 | 2 |

| Stay | 2 | 3 |

H

(

D

w

e

a

k

)

=

−

(

7

9

l

o

g

2

7

9

+

2

9

l

o

g

2

2

9

)

=

0.764

H(D_{weak})=-(\frac{7}{9}log_2\frac{7}{9}+\frac{2}{9}log_2\frac{2}{9})=0.764

H(Dweak)=−(97log297+92log292)=0.764

H

(

D

s

t

r

o

n

g

)

=

−

(

2

5

l

o

g

2

2

5

+

3

5

l

o

g

2

3

5

)

=

0.970

H(D_{strong})=-(\frac{2}{5}log_2\frac{2}{5}+\frac{3}{5}log_2\frac{3}{5})=0.970

H(Dstrong)=−(52log252+53log253)=0.970

G

a

i

n

(

D

,

W

i

n

d

)

=

H

(

D

)

−

∑

v

=

1

V

∣

D

v

∣

D

H

(

D

v

)

=

H

(

D

)

−

(

9

14

H

(

D

w

e

a

k

)

+

5

14

H

(

D

s

t

r

o

n

g

)

)

=

0.102

Gain(D,Wind)=H(D)-\sum_{v=1}^{V}\frac{|D_v|}{D}H(D_v)=H(D)-(\frac{9}{14}H(D_{weak})+\frac{5}{14}H(D_{strong}))=0.102

Gain(D,Wind)=H(D)−v=1∑VD∣Dv∣H(Dv)=H(D)−(149H(Dweak)+145H(Dstrong))=0.102

- 计算关于Temperature的信息增益

| Hot | Mid | Cold | |

|---|---|---|---|

| Play | 3 | 3 | 3 |

| Stay | 1 | 2 | 2 |

H

(

D

H

o

t

)

=

−

(

3

4

l

o

g

2

3

4

+

1

4

l

o

g

2

1

4

)

=

0.811

H(D_{Hot})=-(\frac{3}{4}log_2\frac{3}{4}+\frac{1}{4}log_2\frac{1}{4})=0.811

H(DHot)=−(43log243+41log241)=0.811

H

(

D

M

i

d

)

=

−

(

3

5

l

o

g

2

3

5

+

2

5

l

o

g

2

2

5

)

=

0.970

H(D_{Mid})=-(\frac{3}{5}log_2\frac{3}{5}+\frac{2}{5}log_2\frac{2}{5})=0.970

H(DMid)=−(53log253+52log252)=0.970

H

(

D

C

o

l

d

)

=

−

(

3

5

l

o

g

2

3

5

+

2

5

l

o

g

2

2

5

)

=

0.970

H(D_{Cold})=-(\frac{3}{5}log_2\frac{3}{5}+\frac{2}{5}log_2\frac{2}{5})=0.970

H(DCold)=−(53log253+52log252)=0.970

G

a

i

n

(

D

,

T

e

m

p

)

=

H

(

D

)

−

∑

v

=

1

V

∣

D

v

∣

D

H

(

D

v

)

=

H

(

D

)

−

(

4

14

H

(

D

H

o

t

)

+

5

14

H

(

D

M

i

d

)

+

5

14

H

(

D

C

o

l

d

)

)

=

0.008

Gain(D,Temp)=H(D)-\sum_{v=1}^{V}\frac{|D_v|}{D}H(D_v)=H(D)-(\frac{4}{14}H(D_{Hot})+\frac{5}{14}H(D_{Mid})+\frac{5}{14}H(D_{Cold}))=0.008

Gain(D,Temp)=H(D)−v=1∑VD∣Dv∣H(Dv)=H(D)−(144H(DHot)+145H(DMid)+145H(DCold))=0.008

- 计算关于Outlook的信息增益

| Sunny | Overcast | Rain | |

|---|---|---|---|

| Play | 4 | 4 | 1 |

| Stay | 1 | 0 | 4 |

H

(

D

S

u

n

n

y

)

=

−

(

4

5

l

o

g

2

4

5

+

1

5

l

o

g

2

1

5

)

=

0.722

H(D_{Sunny})=-(\frac{4}{5}log_2\frac{4}{5}+\frac{1}{5}log_2\frac{1}{5})=0.722

H(DSunny)=−(54log254+51log251)=0.722

H

(

D

O

v

e

r

c

a

s

t

)

=

−

(

4

4

l

o

g

2

4

4

+

0

4

l

o

g

2

0

4

)

=

0

H(D_{Overcast})=-(\frac{4}{4}log_2\frac{4}{4}+\frac{0}{4}log_2\frac{0}{4})=0

H(DOvercast)=−(44log244+40log240)=0

H

(

D

R

a

i

n

)

=

−

(

1

5

l

o

g

2

1

5

+

4

5

l

o

g

2

4

5

)

=

0.722

H(D_{Rain})=-(\frac{1}{5}log_2\frac{1}{5}+\frac{4}{5}log_2\frac{4}{5})=0.722

H(DRain)=−(51log251+54log254)=0.722

G

a

i

n

(

D

,

O

u

t

l

o

o

k

)

=

H

(

D

)

−

∑

v

=

1

V

∣

D

v

∣

D

H

(

D

v

)

=

H

(

D

)

−

(

5

14

H

(

D

S

u

n

n

y

)

+

4

14

H

(

D

O

v

e

r

c

a

s

t

)

+

5

14

H

(

D

R

a

i

n

)

)

=

0.424

Gain(D,Outlook)=H(D)-\sum_{v=1}^{V}\frac{|D_v|}{D}H(D_v)=H(D)-(\frac{5}{14}H(D_{Sunny})+\frac{4}{14}H(D_{Overcast})+\frac{5}{14}H(D_{Rain}))=0.424

Gain(D,Outlook)=H(D)−v=1∑VD∣Dv∣H(Dv)=H(D)−(145H(DSunny)+144H(DOvercast)+145H(DRain))=0.424

- 信息增益汇总

| wind | Temp | Outlook | |

|---|---|---|---|

| 信息增益 | 0.102 | 0.008 | 0.424 |

不难看出,小明去不去玩啊,温度只能减少0.008的不确定性,但是天气景观(Outlook)可以减少0.424的不确定性,那我们是不是说Outlook更重要一些,更适合作为重要决策节点。