诸神缄默不语-个人CSDN博文目录

本文主要以模型被提出的时间为顺序,系统性介绍各种预训练模型的理论(尤其是相比之前工作的创新点)、调用方法和表现效果。

最近更新时间:2023.5.10

最早更新时间:2023.5.10

- Bert

- Roberta

- XLNet

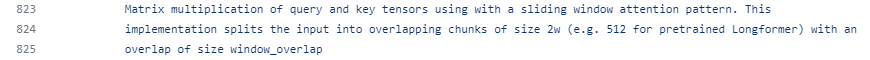

- Longformer

序列长度必须是512的整数倍1- 中文版:ValkyriaLenneth/Longformer_ZH

tokenizer必须要用BertTokenizer2

- 中文版:ValkyriaLenneth/Longformer_ZH

- UniLM

【论文解读】UniLM:一种既能阅读又能自动生成的预训练模型 - SciBert

- RPT

- NEZHA

- ERNIE-百度

- ERNIE-清华

- DistilledBert

- Bart

- CPT

- Pegasus

- GPT-2

- GPT-3

- GPT-3.5

- ChatGPT

- InstructGPT

- CodeX

- ChatGPT技术解析系列之:赋予GPT写代码能力的Codex - 知乎

- pass@k

- 文心一言

- Bard

见https://github.com/huggingface/transformers/blob/main/src/transformers/models/longformer/modeling_longformer.py:

↩︎

↩︎参考我在该项目下提出的issue:如直接使用LongformerTokenizer会报此错,是否需要使用BertTokenizer? · Issue #2 · ValkyriaLenneth/Longformer_ZH ↩︎