图神经网络(GNN)作为图表示学习的模型,建立在MLP架构之上,具有额外的消息传递,以允许特征在节点之间流动。作者通过引入一个被称为P-MLP的中间模型,将GNN性能增益的主要来源定位为其内在的泛化能力,P-MLP在训练中与标准MLP相同,但在测试中采用了GNN的体系结构。有趣的是,观察到P-MLP的表现一直与GNN持平(甚至超过),同时在训练中效率更高。这一发现为理解GNN的学习行为提供了一个新的视角。

来自:GRAPH NEURAL NETWORKS ARE INHERENTLY GOOD GENERALIZERS: INSIGHTS BY BRIDGING GNNS AND MLPS

作为一种经典的神经网络架构,多层感知器(MLP)将具有非线性的多个前馈(FF)层堆叠以近似函数。后来,图神经网络(GNNs)建立在MLP的基础上,通过在FF层中插入额外的消息传递(MP)操作来适应节点之间的相互依赖性。

深度学习研究的两个基本概念是模型的表示能力和泛化能力:

- 表征或拟合能力:指模型拟合观测数据的能力,通常可以由训练误差反映;

- 泛化能力:指模型泛化到新数据上的能力,通常可以由测试集误差与训练误差之间的差距反映。

目前的工作集中于研究GNN的表示能力,而GNN的泛化性以及与MLP的联系远没有得到很好的研究。

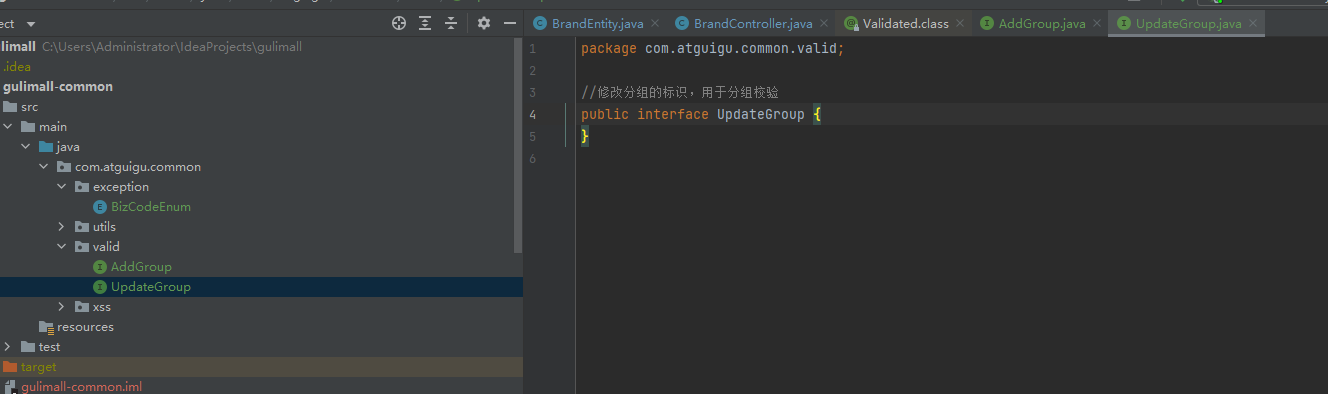

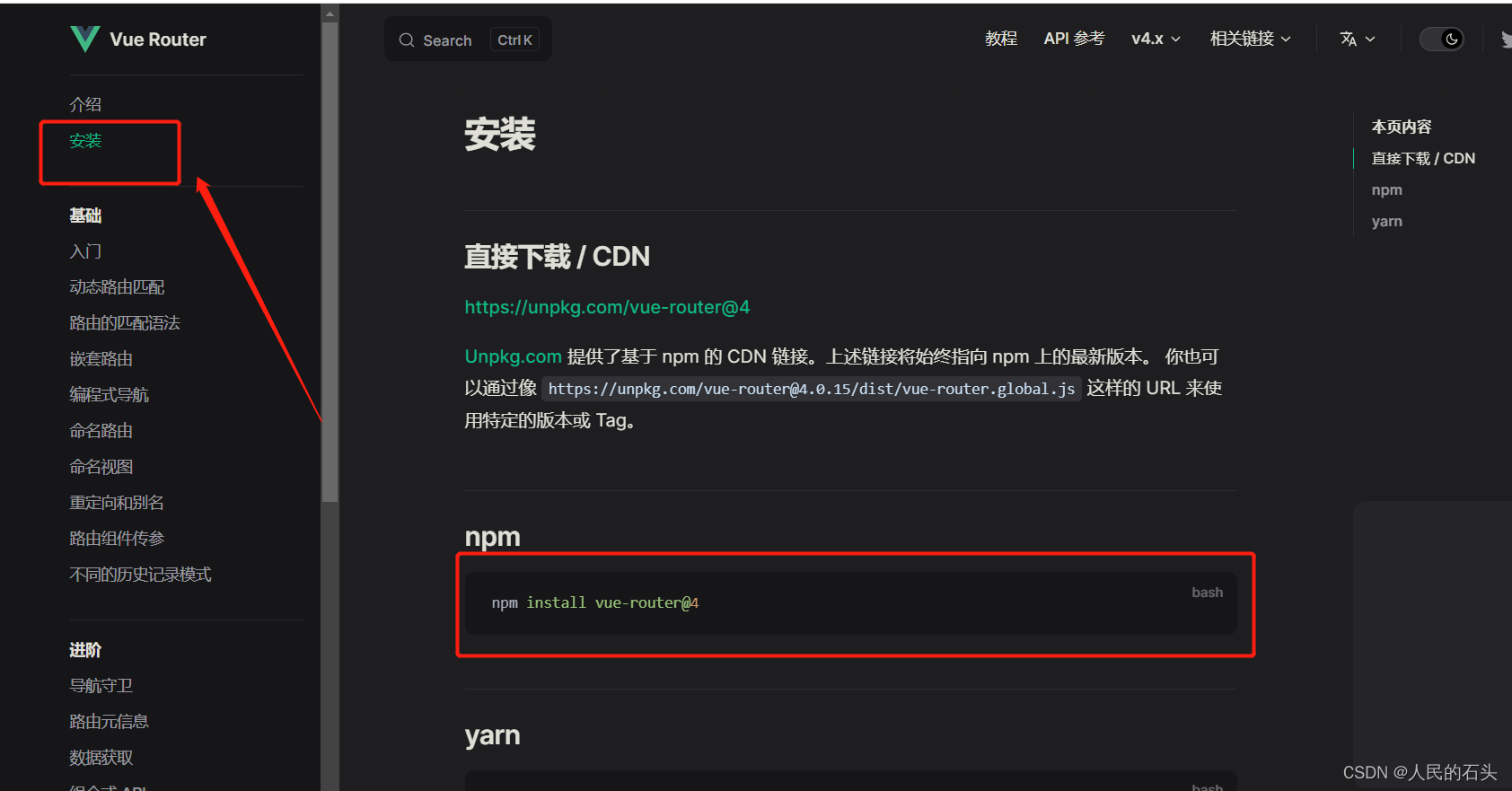

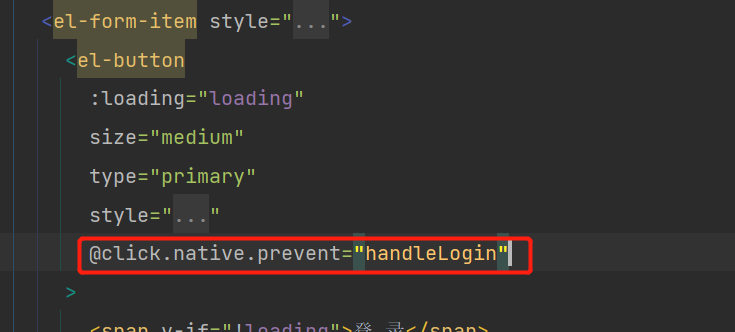

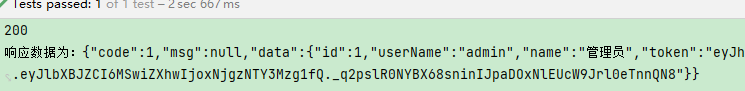

因此,在这项工作中,作者通过引入一个称为P-MLP的中间模型来桥接GNN和MLP。在训练期间,PMLP与标准MLP完全相同,例如:相同的架构、用于训练的数据、初始化、损失函数、优化算法。在测试阶段,PMLP在FF层中额外插入无参数的MP层,如图1a所示,以与各种GNN架构对齐。

- 图1a:MLP、GNN(比如GCN)和PMLP的模型说明。所提出的PMLP是一个中间模型,通过在训练中使用MLP架构和在测试中使用GNN架构来桥接MLP和GNN。

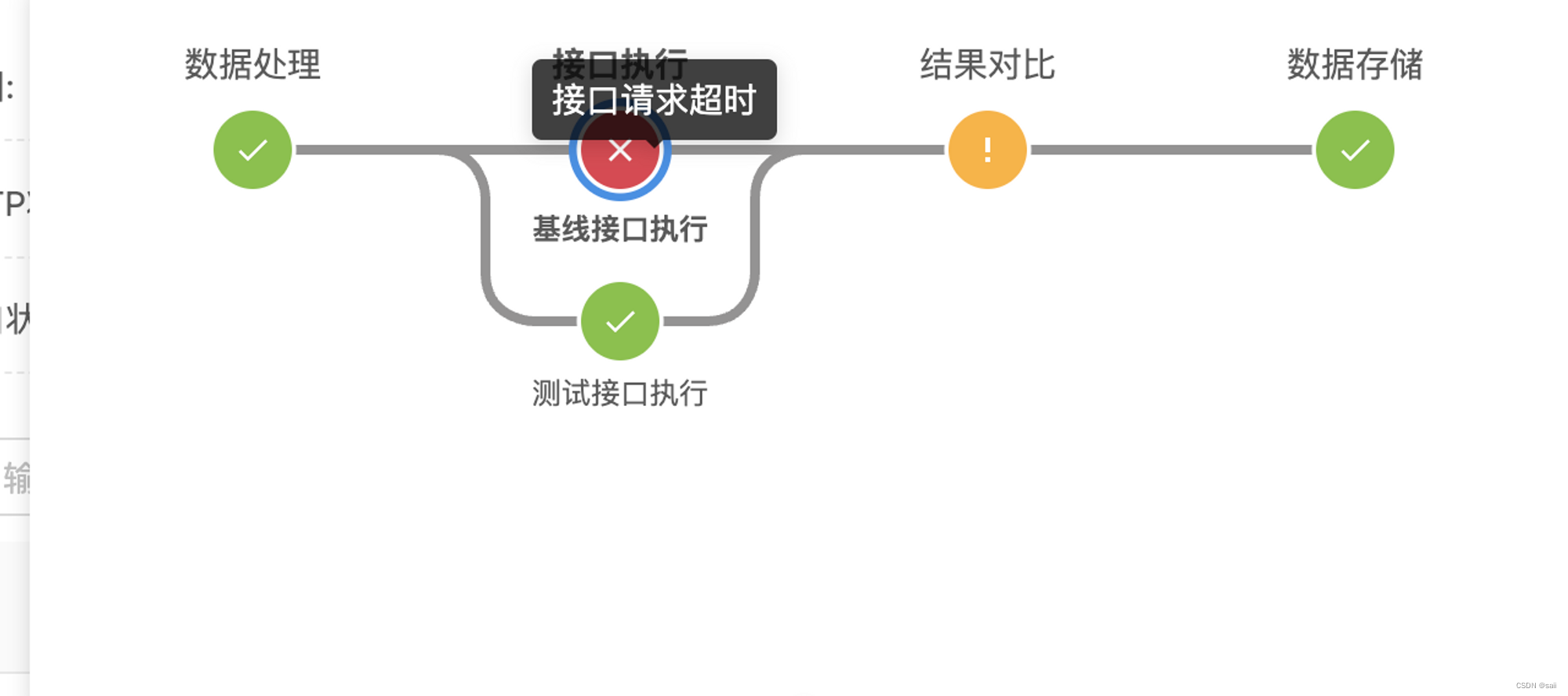

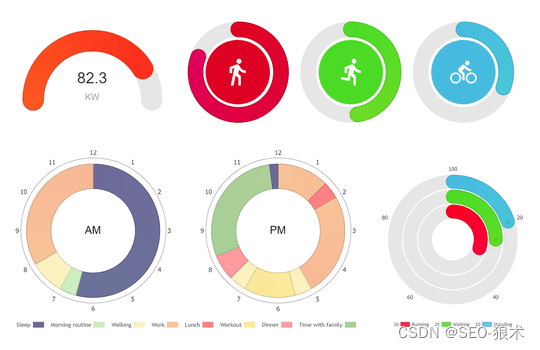

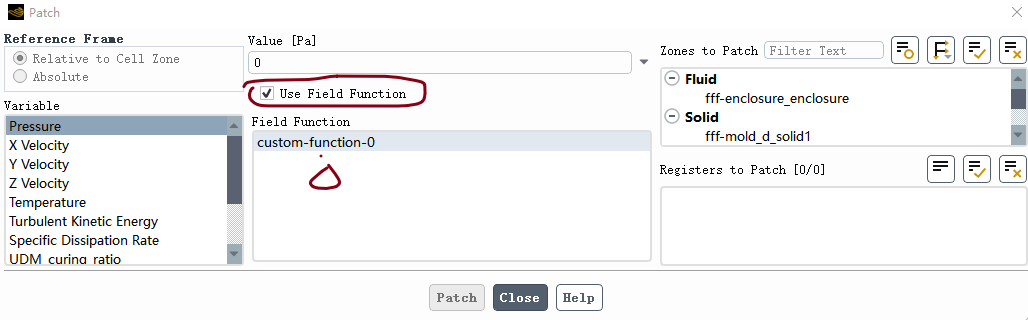

- 图1b:Cora上节点分类的学习曲线描绘了一个典型的现象:MLP和GNN都具有足够的表征能力,可以在训练中实现几乎零损失,而在测试中使用消息传递操作的PMLP和GNN具有更好的测试准确性。

- 图1c:GNN的固有泛化性:用于PMLP和原始GNN推理的GNN架构固有地鼓励较低的泛化差异。

- 图1d:MLP和PMLP都倾向于在训练数据支持之外线性化( • • •为训练样本, ◦ ◦ ◦为测试样本),而PMLP(和GNN)传输更平稳,从而在分布变化下具有更大的潜力推广到训练数据支持附近的测试样本。