文本的清洗和标准化:如何处理混乱的数据?

在现代社会,我们每天都处理大量的文本数据。然而,这些数据常常是混乱的、不一致的,包含着各种各样的错误和噪声。如果我们想要从这些数据中提取有用的信息,首先需要进行文本的标准化和清洗。

本文将详细介绍文本的标准化和清洗的原理,并结合代码进行讲解,帮助读者更好地理解如何处理混乱的文本数据。

1. 文本的标准化

文本的标准化是指将不同格式、不同来源的文本数据转化为统一的格式和标准。这个过程可以包括以下几个方面:

1.1 字符集的转换

在不同的计算机系统中,字符集的编码方式可能不同。为了确保文本的一致性和可读性,我们需要将不同编码方式的字符转换为相同的编码方式。在 Python 中,我们可以使用 encode() 和 decode() 方法实现字符集的转换。

1.2.单词的统一化

文本数据中常常包含各种形式的单词,包括大小写不同、缩写形式、不同时态等。为了方便文本的处理和分析,我们需要将这些不同形式的单词转化为统一的形式。在 Python 中,我们可以使用 lower() 方法将所有单词转化为小写形式,或者使用正则表达式进行更为复杂的处理。

1.3 标点符号和特殊字符的处理

文本中常常包含各种标点符号和特殊字符,如逗号、句号、换行符等。这些字符在文本分析和处理中通常是无用的,需要被删除或替换为特定的符号。在 Python 中,我们可以使用 replace() 和正则表达式来实现这个过程。

1.4 时间和日期的统一化

在一些文本数据中,可能包含时间和日期的信息,如 2022 年 5 月 6 日或 2022-05-06。为了方便时间的处理和比较,我们需要将这些时间信息转化为统一的格式,如 ISO 格式。在 Python 中,我们可以使用 datetime 模块来实现时间和日期的处理。

2. 文本的清洗

文本的清洗是指通过删除无用的信息、修复错误和噪声等方式,将文本数据变得更加整洁和规范。这个过程可以包括以下几个方面:

2.1 去除 HTML 标签和特殊字符

在一些文本数据中,可能包含 HTML 标签和特殊字符,如 <、>等。这些标签和字符在文本分析和处理中是无用的,需要被删除或替换为特定的符号。在 Python 中,我们可以使用第三方库,如 Beautiful Soup 和 lxml,来去除 HTML 标签。而对于特殊字符,我们可以使用 replace() 方法或正则表达式来替换。

2.2 删除停用词

停用词是指在文本中频繁出现但不具有实际意义的单词,如“的”、“了”等。这些单词会占用计算资源,降低文本处理的效率,因此需要被删除。在 Python 中,我们可以使用第三方库,如 NLTK 和 spaCy,来删除停用词。

2.3 处理拼写错误

在一些文本数据中,可能包含拼写错误的单词。这些错误可能是由于打字错误、自动纠错等原因造成的。为了提高文本分析的准确性,我们需要对这些拼写错误进行处理。在 Python 中,我们可以使用第三方库,如 PyEnchant 和 autocorrect,来修正拼写错误。

2.4 处理缩写和语气词

在一些社交媒体和聊天应用中,人们经常使用缩写和语气词,如“LOL”、“OMG”、“哈哈”等。这些缩写和语气词在文本分析中可能会导致误解,因此需要进行处理。在 Python 中,我们可以使用正则表达式或自然语言处理技术来识别和处理这些缩写和语气词。

3. 代码示例

下面是一段 Python 代码示例,展示了如何对文本数据进行标准化和清洗:

import re

from bs4 import BeautifulSoup

import nltk

from nltk.corpus import stopwords

from autocorrect import Speller

# 定义文本数据

text = "This is a sample text, which contains HTML tags and stop words like the, and, of, etc. It also has some spelling mistakes and slang words like lmao and wtf."

# 去除 HTML 标签

soup = BeautifulSoup(text, 'html.parser')

text = soup.get_text()

# 转换为小写形式

text = text.lower()

# 去除标点符号和特殊字符

text = re.sub(r'[^\w\s]', ' ', text)

# 去除停用词

nltk.download('stopwords')

stop_words = set(stopwords.words('english'))

text_tokens = nltk.word_tokenize(text)

filtered_words = [word for word in text_tokens if word not in stop_words]

text = ' '.join(filtered_words)

# 处理拼写错误

spell = Speller(lang='en')

text_tokens = nltk.word_tokenize(text)

corrected_words = [spell(word) for word in text_tokens]

text = ' '.join(corrected_words)

# 处理缩写和语气词

abbreviations = {

"lmao": "laughing my ass off",

"wtf": "what the fuck"

}

for abbr, full in abbreviations.items():

text = text.replace(abbr, full)

# 输出处理后的文本数据

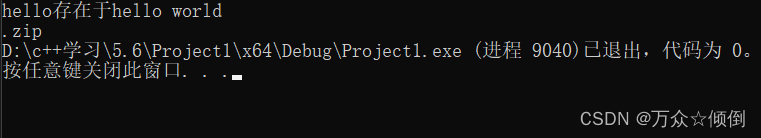

print(text)

这段代码首先使用 Beautiful Soup 库去除 HTML 标签,然后将文本数据转换为小写形式,并去除标点符号和特殊字符。接下来,使用 NLTK 库去除停用词,并使用 autocorrect 库处理拼写错误。最后,使用正则表达式和字典对缩写和语气词进行处理。

4. 总结

文本的标准化和清洗是文本分析和处理的重要步骤。通过将不同格式、不同来源的文本数据转化为统一的格式和标准,并通过删除无用的信息、修复错误和噪声等方式,可以使文本数据更加整洁和规范,提高文本分析的准确性和效率。

在 Python 中,我们可以使用多种第三方库和工具来实现文本的标准化和清洗。需要根据实际情况选择适合的工具和方法,进行处理和优化。