学习目标:

如果我要学习幂法及反幂法,我会遵循以下步骤:

1. 学习理论知识:首先我会找到可靠的教材或者网上资源,学习幂法及反幂法的理论知识,包括其原理、公式、算法流程、收敛性等方面的内容。这些知识可以帮助我理解幂法及反幂法的基本原理,以及如何正确应用这些方法解决实际问题。

2. 阅读范例及练习题:为了更好地掌握幂法及反幂法,我会寻找大量的范例及练习题来练习和检验自己的理解程度。通过模仿和实践,我可以更好地理解幂法及反幂法的具体应用过程,学会如何通过幂法及反幂法求解矩阵特征值和特征向量。

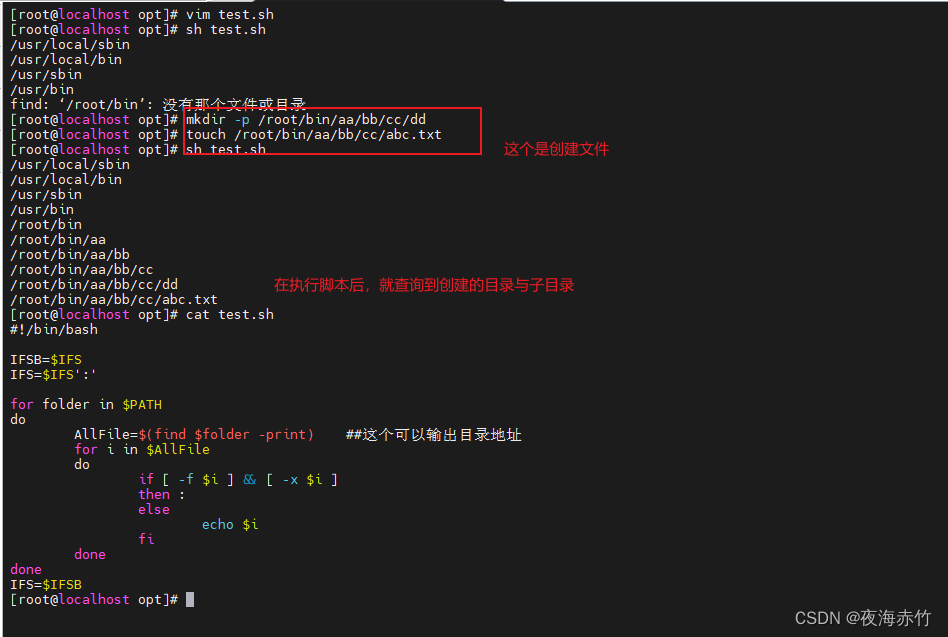

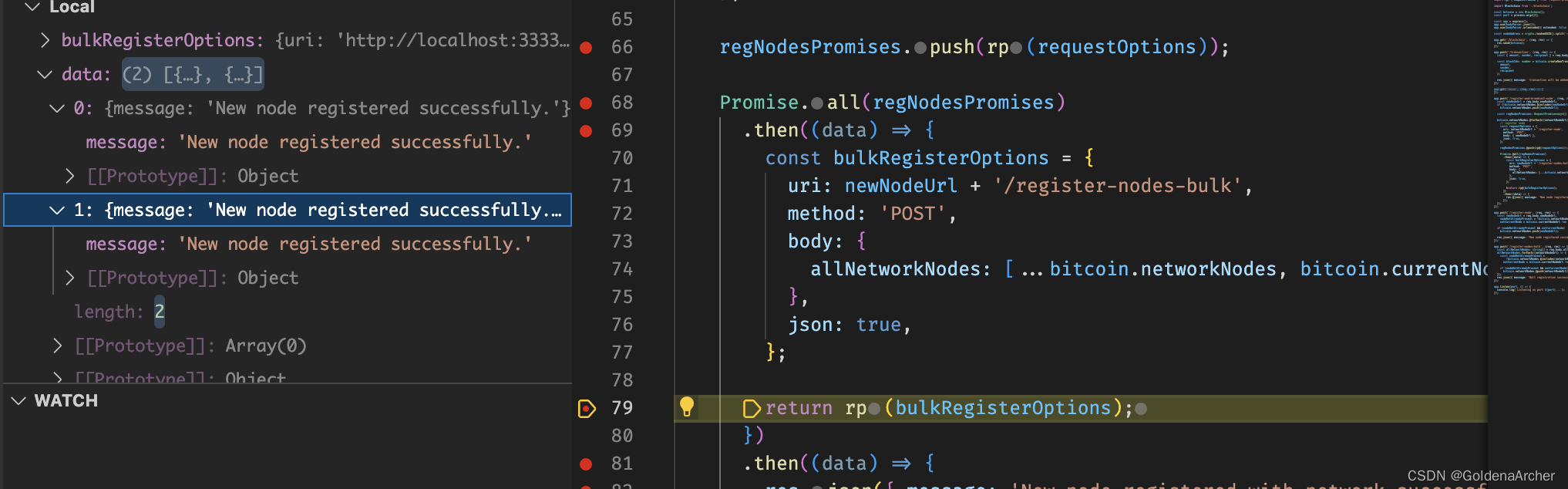

3. 编写代码实现:为了更好地掌握幂法及反幂法的实际应用,我会尝试编写代码来实现这些算法,以验证我的理解程度。通过编写代码,我可以更好地理解算法的细节和实现过程,发现其中的问题并加以解决。

4. 实践应用:最后,我会通过实践应用,将幂法及反幂法应用于实际问题中。这样我就可以更好地理解这些方法的实际应用价值,发现其中的问题并加以解决,同时提高自己的实际能力和应用水平。

什么是幂法和反幂法

幂法和反幂法是求解矩阵最大特征值及其对应特征向量和最小特征值及其对应特征向量的常用数值方法。

幂法是求解矩阵最大特征值和特征向量的方法,其基本思想是:假设矩阵 $A$ 的最大特征值是 $\lambda_1$,对应的特征向量是 $x_1$,则对于任意一个非零向量 $v_0$,通过不断地将 $A^k v_0$ 归一化,即 $\frac{A^k v_0}{\|A^k v_0\|}$,可以得到一个序列 $x_k$,当 $k$ 趋近于无穷大时,$x_k$ 趋近于 $x_1$,同时 $\lambda_1$ 可以通过计算 $\frac{\|A^k v_0\|}{\|v_0\|}$ 的极限得到。

反幂法是求解矩阵最小特征值和特征向量的方法,其基本思想是:假设矩阵 $A$ 的最小特征值是 $\lambda_n$,对应的特征向量是 $x_n$,则对于任意一个非零向量 $v_0$,通过不断地将 $(A - \mu I)^{-1} v_0$ 归一化,即 $\frac{(A - \mu I)^{-1} v_0}{\|(A - \mu I)^{-1} v_0\|}$,可以得到一个序列 $x_k$,当 $k$ 趋近于无穷大时,$x_k$ 趋近于 $x_n$,同时 $\lambda_n$ 可以通过计算 $\frac{1}{\|(A - \mu I)^{-1} v_0\|} + \mu$ 的极限得到,其中 $\mu$ 是一个足够接近 $\lambda_n$ 的数。

需要注意的是,幂法和反幂法都需要满足一些条件才能得到正确的结果,比如矩阵 $A$ 需要是实对称矩阵或者正定矩阵,向量 $v_0$ 需要是非零向量等等。另外,这些方法的收敛速度也会受到很多因素的影响,比如矩阵的条件数、特征值之间的差距等等,需要在实际应用中进行评估和调优。

改进幂法:

改进幂法是对幂法的改进,旨在解决幂法在存在特征值重复或者特征值接近时的不稳定性问题。改进幂法在每次迭代后都对向量进行归一化,同时在迭代中加入了位移参数,使得迭代更快地收敛到最大特征值对应的特征向量。

可以这样理解改进幂法的过程:首先选取一个非零的向量 $x^{(0)}$,假设 $A$ 的最大特征值为 $\lambda_1$,相应的特征向量为 $v_1$。在幂法的基础上,加入一个位移 $\mu$,则 $A-\mu I$ 的最大特征值为 $\lambda_1-\mu$,相应的特征向量为 $v_1$。然后通过迭代来求出 $(A-\mu I)^{-1}$ 的最大特征值 $\beta$,相应的特征向量 $y$,则 $\lambda_1-\mu$ 的估计值为 $\beta+\mu$,对应的特征向量为 $v_1$。重复进行迭代,直到收敛到所需精度。

改进幂法的优点是可以快速、准确地求出最大特征值及其对应的特征向量。其缺点是需要知道一个近似的位移参数 $\mu$,这对于某些问题而言可能比较困难。同时,在存在多个特征值接近或者特征值重复时,可能需要多次迭代才能收敛到正确的结果。

原点平移法

原点平移法是一种用于求解矩阵特征值和特征向量的数值计算方法,也被称为Wilkinson平移法。

其基本思想是通过平移矩阵中心点的位置,将矩阵中心移到新的坐标系原点上,从而将矩阵分解为原矩阵与平移矩阵两部分的和,使得平移后的矩阵具有更好的特征值分布和收敛性能。

具体而言,对于一个$n\times n$的矩阵$A$,其特征值和特征向量可以通过如下步骤求解:

1. 选取一个非零向量$x_0$作为初始向量,并进行归一化处理。

2. 对初始向量进行原点平移,即将$x_0$替换为$x_0-\mu$,其中$\mu$为一个适当的平移量。

3. 通过幂法或反幂法等迭代算法,迭代求解平移后的矩阵的最大特征值和对应的特征向量。

4. 将求得的特征向量还原为平移前的向量。

5. 重复2-4步骤,直到收敛为止。

需要注意的是,选择合适的平移量对于算法的收敛速度和精度至关重要。一般来说,可通过最大模值或均值等方式选取适当的平移量。

怎么用幂法和反幂法求解特征值

幂法和反幂法是求解矩阵特征值的两种基本方法。

1. 幂法(Power Method)

幂法是一种迭代方法,用于求解矩阵的最大特征值和对应的特征向量。其基本思想是对于任意一个非零向量x0,迭代求解x(k+1) = A x(k),其中A是待求矩阵,x(k)是第k次迭代后的向量。在迭代过程中,向量x(k)的模长会趋于最大特征值的模长,特征向量则可以通过归一化向量x(k)来获得。

具体步骤如下:

- 选择一个初始向量x0,并归一化为单位向量x0/||x0||;

- 迭代求解:x(k+1) = A x(k),其中A是待求矩阵;

- 计算模长:||x(k+1)||;

- 判断是否满足精度要求,若不满足,则重复2-4步,直到满足精度要求。

最终,x(k)的模长会趋于最大特征值的模长,特征向量则可以通过归一化向量x(k)来获得。

2. 反幂法(Inverse Power Method)

反幂法是一种迭代方法,用于求解矩阵的最小特征值和对应的特征向量。其基本思想是对于任意一个非零向量x0,迭代求解x(k+1) = (A - λI)^(-1) x(k),其中A是待求矩阵,λ是近似的特征值,x(k)是第k次迭代后的向量。在迭代过程中,向量x(k)的模长会趋于最小特征值的模长,特征向量则可以通过归一化向量x(k)来获得。

具体步骤如下:

- 选择一个初始向量x0,并归一化为单位向量x0/||x0||;

- 对于近似的特征值λ,计算矩阵A - λI的逆;

- 迭代求解:x(k+1) = (A - λI)^(-1) x(k);

- 计算模长:||x(k+1)||;

- 判断是否满足精度要求,若不满足,则重复2-4步,直到满足精度要求。

最终,x(k)的模长会趋于最小特征值的模长,特征向量则可以通过归一化向量x(k)来获得。

需要注意的是,当矩阵A有多个特征值时,需要多次应用幂法或反幂法来求解不同的特

总结:

在使用幂法和反幂法求解矩阵特征值时,有一些需要注意的重点、难点和易错点,下面简单介绍一下。

1. 重点

(1)选择初始向量:选择一个合适的初始向量对于迭代结果的收敛速度和准确性都有很大的影响,一般来说应该选取一个与特征向量接近的向量作为初始向量。

(2)计算特征值:在进行幂法和反幂法迭代时,需要计算向量的模长,这是计算特征值的关键。由于矩阵特征值可能为复数,因此需要使用复数的模长来计算实部和虚部,从而得到特征值的近似值。

2. 难点

(1)多重特征值:当矩阵有多个特征值时,幂法和反幂法只能求解其中一个特征值,需要使用其他方法来求解其他特征值。

(2)计算矩阵逆:在反幂法中需要计算矩阵的逆,当矩阵的行列式为0时,矩阵逆不存在,此时需要使用其他方法来解决。

3. 易错点

(1)收敛速度:幂法和反幂法的迭代收敛速度与初始向量的选择有关,不同的初始向量可能会导致迭代速度的差异。

(2)精度控制:幂法和反幂法的迭代过程中需要进行精度控制,如果精度设置不当,可能会导致迭代结果的不准确。

(3)特征值取值:幂法和反幂法只能求解近似的特征值,因此需要根据实际问题来选择是否需要进一步取整或者四舍五入。同时需要注意特征值的正负性,可以根据特征向量的符号来确定特征值的符号。

总的来说,使用幂法和反幂法求解特征值需要考虑多个因素,包括初始向量的选择、精度控制、特征值取值等。在实际应用中需要灵活掌握这些因素,以获得准确和高效的求解结果。