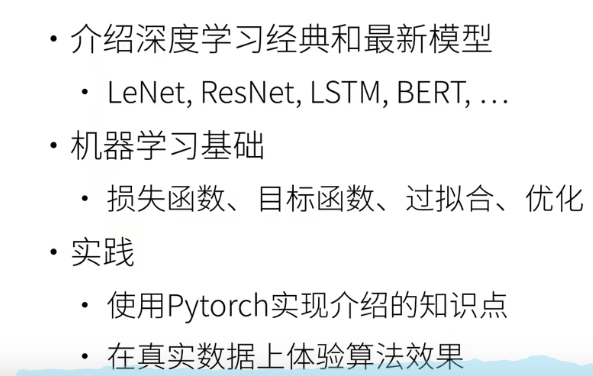

1.概述

- 这门课程主要介绍深度学习经典和最新模型。从最简单、最老的80年代的Lenet,讲到计算机视觉比较流行的Resnet,以及经典的时序模型LSTM以及最近比较流行的BERT。

- 当然我们在讲深度学习时,我们离不开机器学习,机器学习的很多基础知识是我们需要的,比如

- 损失函数,目标函数,过拟合和优化等

- 实践

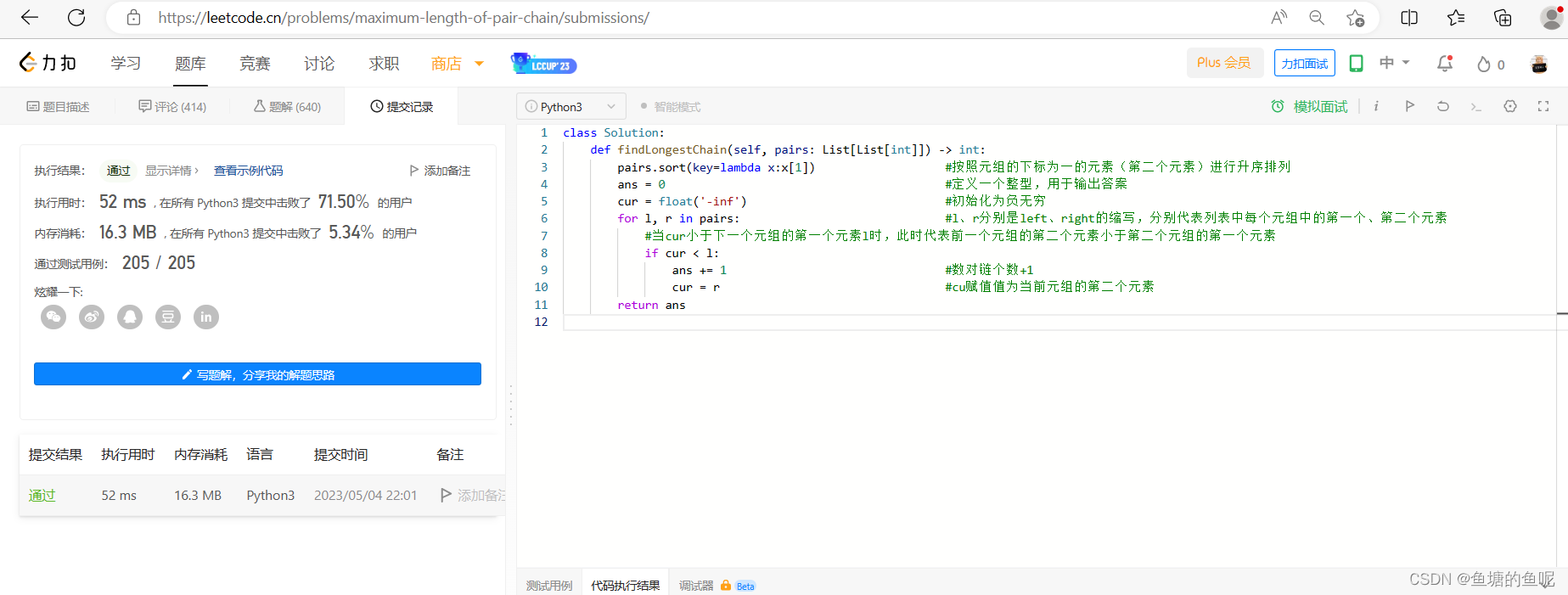

- 不仅会讲原理和数学表示,而且使用Pytorch实现介绍的知识点。

- 在真实数据上体验算法效果。

2.内容介绍

- 首先讲一下深度学习基础,大家不需要有机器学习或者深度学习的背景,我们会从头开始讲起。

- 接下来会进入深度学习的核心之一:卷积神经网络,我们从最早的Lenet开始,以及引起深度学习狂潮的Alexnet、VGG、Inception和Resnet等。

- 卷积神经网络是一个空间的神经网络,循环神经网络是时间上的神经网络,从RNN开始,到新的Seq2Seq。

- 在卷积神经网络和循环神经网络之后,注意力机制Attention是最近几年新出来的一个种类,在自然语言处理以及之外的领域都有广泛的应用。

- 当然也会介绍机器学习的基础,也就是优化算法,也就是给定模型,如何来得到你的网络。

- 因为深度学习计算量比较大,需要很多的机器来跑,是一个大力出奇迹的领域,所以也会介绍如何进行高性能的计算,怎么并行,怎么多GPU以及如何分布式。

- 最后我们会介绍两大领域,1.计算机视觉(包括目标检测,语义分割),2.自然语言处理(词嵌入,BERT)。不管是深度学习也好,人工智能也好,这是最主要的两大领域。

- 深度学习有那些技术。

- 如何实现和调参。

- 背后的背景(直觉、数学)。