这是发表在ICLR2023 workshop on Scene Representations for Autonomous Driving上的文章,目前在nuScenes的camera+Radar的3D目标检测赛道上刷到了第一,非常值得一看

一、创新点和贡献

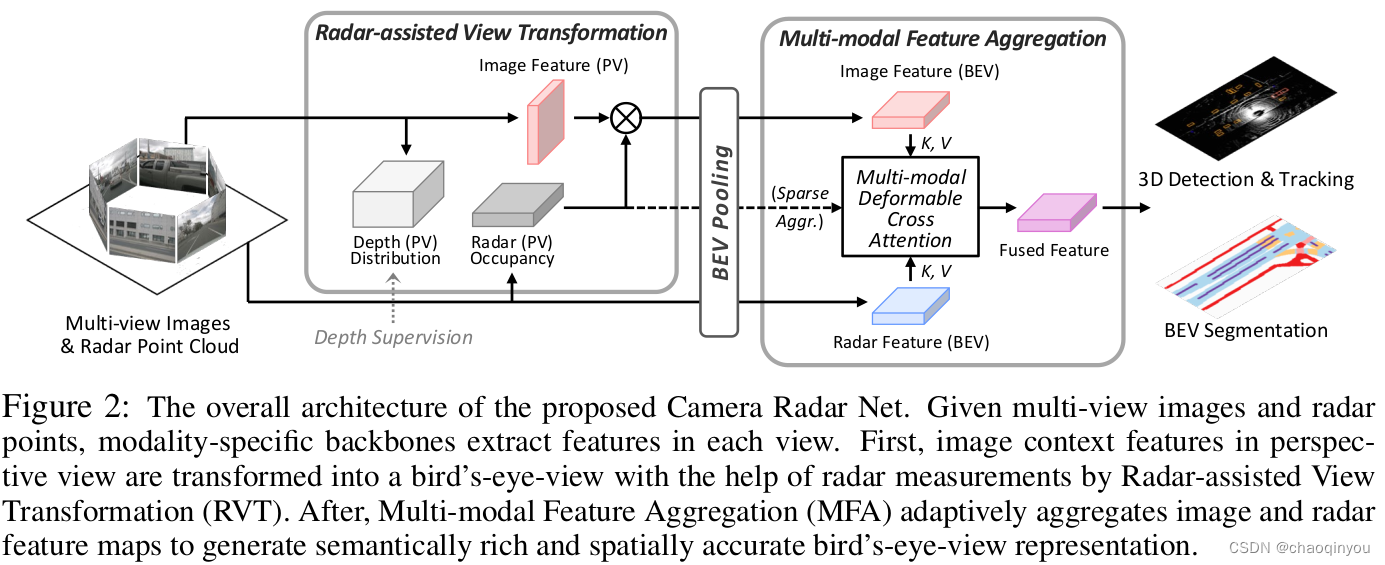

- 采用了一种两阶段的融合思路: 采用radar-assistant-view-transform(RVT)和multi-modal feature aggregation (MFA) 在bev视角下得到了语义丰富,空间位置准确的特征

- 稳健:当某种传感器失效后, 性能也不会掉很多

- 高效:20FPS的时候,仍然是SOTA的表现

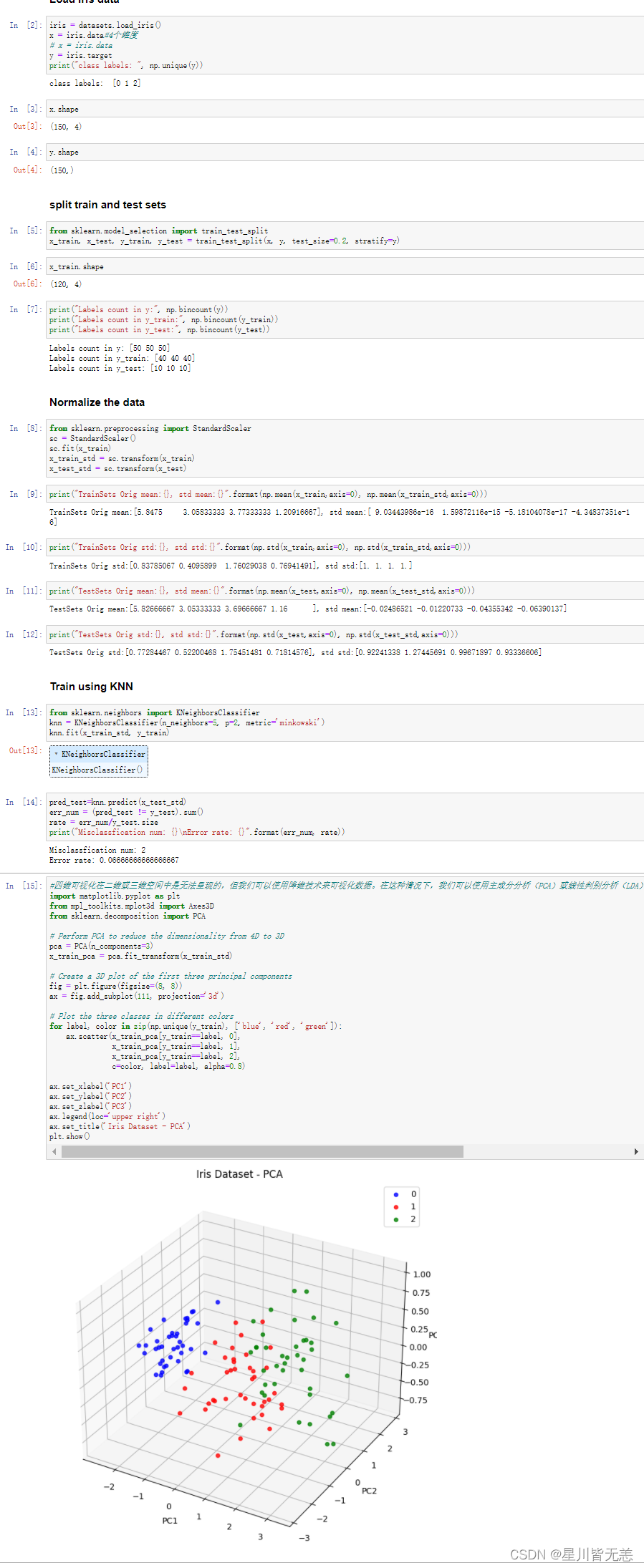

二、精度和速度

20FPS的速度的时候,NDS基本和pillar版本的CenterPoint一样了

三、实现

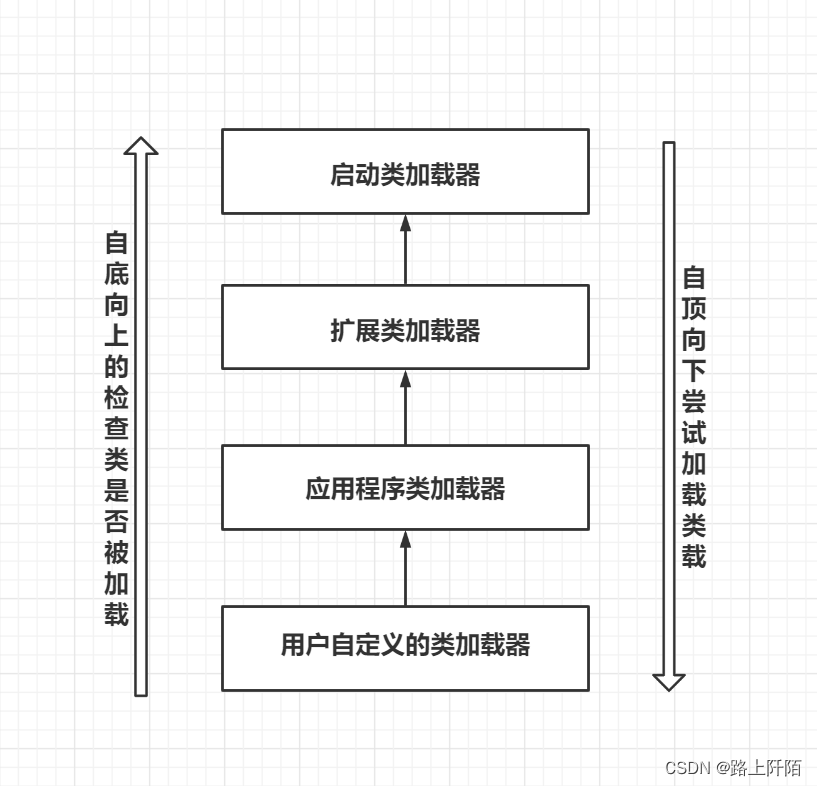

3.1 Radar-Assisted View Transformation (RVT)

主要主要创新点应该是,除了像LSS那样用单目估计的深度 lift 图片的feature外,同时也用radar在frustum坐标系下的occupancy 来lift 图片的feature;

3.2 Multi-Modal Feature Aggregation

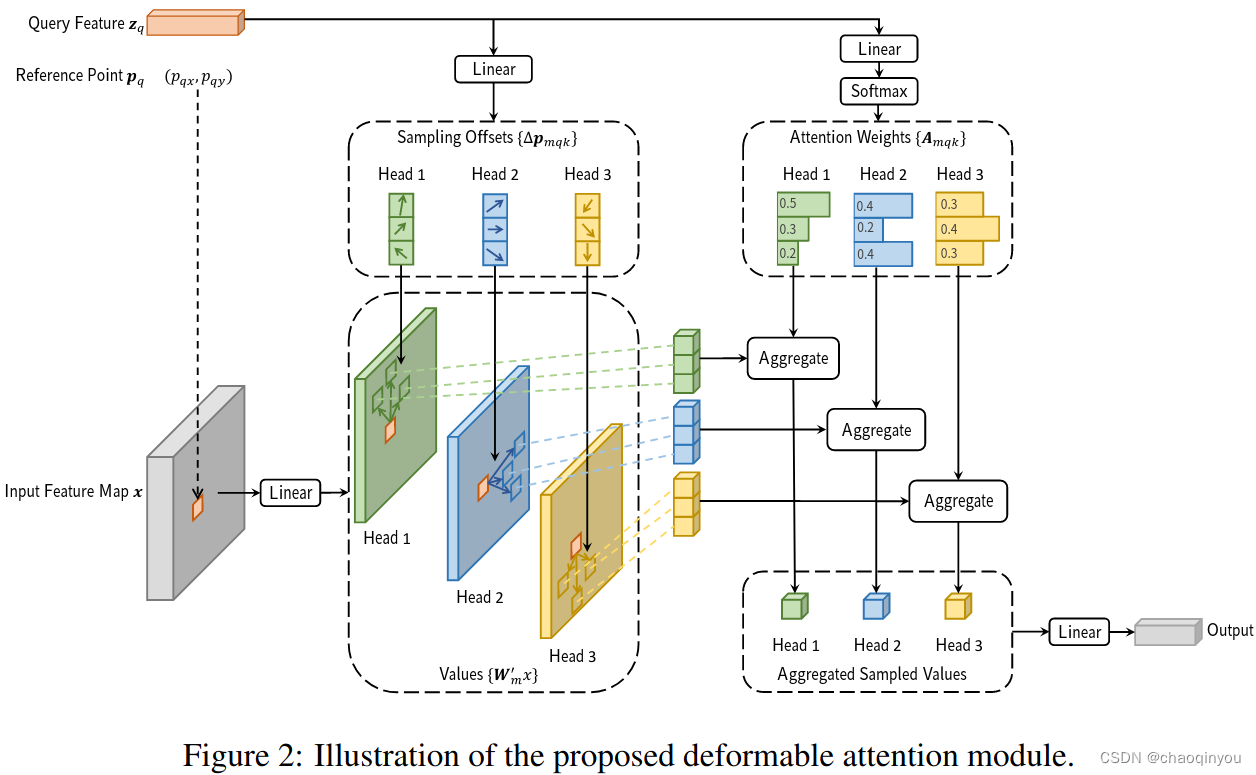

根据图片估计的深度,或者radar的occupancy,bev下面选取 top_k 个位置做多头可变形的cross attention:

deformable detr中的图也比较直观:

3.3 训练的目标函数

检测任务相关: 用CenterPoint的anchor free的方式,并通过CBGS做平衡;

图片深度估计:把激光点投影到图片上做gt

top_k:把gt 3D框外的点云去掉做深度的gt

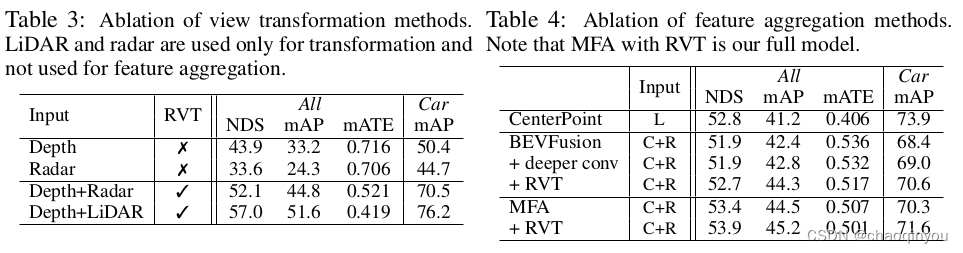

四、消融实验

五、重要的参考文献

(2023 aaai) BEVDepth: Acquisition of Reliable Depth for Multi-view 3D Object Detection

(2020, iros)GRIF Net Gated Region of Interest Fusion Network for Robust 3D Object Detection from Radar

(2021 iclr) Deformable DETR: Deformable Transformers for End-to-End Object Detection