深度学习训练营之彩色图片分类

- 原文链接

- 环境介绍

- 前置工作

- 设置GPU

- 导入数据

- 数据查看

- 构建CNN网络

- CNN网络的简单介绍

- 代码

- 进行编译

- 模型训练

- 正式训练

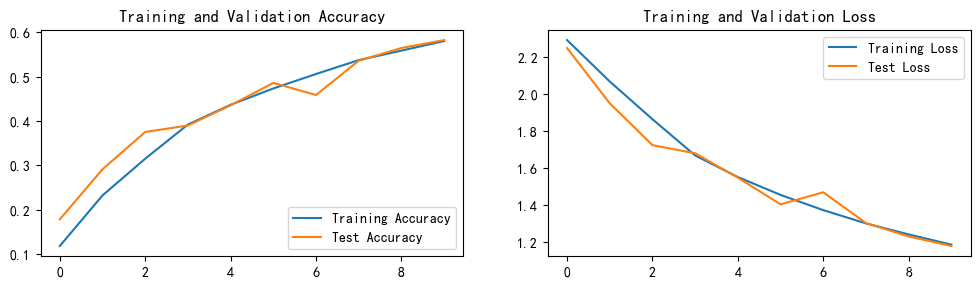

- 结果可视化

- 使用准确度和损失值进行结果的优良进行分析

原文链接

- 🍨 本文为🔗365天深度学习训练营 中的学习记录博客

- 🍦 参考文章:365天深度学习训练营-第P2周:深度学习训练营之彩色图片分类

- 🍖 原作者:K同学啊|接辅导、项目定制

环境介绍

- 语言环境:Python3.9.13

- 编译器:jupyter notebook

- 深度学习环境:TensorFlow2

前置工作

设置GPU

因为本次实验的数据量过大,所有设置多个GPU很有必要

import torch

import torch.nn as nn

import matplotlib.pyplot as plt#绘制和显示图片

import torchvision

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

#查看cuda是否存在,cuda存在就保存为cuda进行运行,否则使用cpu

device

导入数据

导入的数据是自带的,不需要自行准备

使用CIFAR10当中的数据集

使用dataloader进行下载

train_ds = torchvision.datasets.CIFAR10('data',

train=True,

transform=torchvision.transforms.ToTensor(), # 将数据类型转化为Tensor

download=True)

test_ds = torchvision.datasets.CIFAR10('data',

train=False,

transform=torchvision.transforms.ToTensor(), # 将数据类型转化为Tensor

download=True)

数据量比较大,下载的时间会比较长,这是我二次运行之后的结果

数据进行打乱操作,并设计最基本的batch_size

batch_size = 32

train_dl = torch.utils.data.DataLoader(train_ds,

batch_size=batch_size,

shuffle=True)#打乱数据

test_dl = torch.utils.data.DataLoader(test_ds,

batch_size=batch_size)

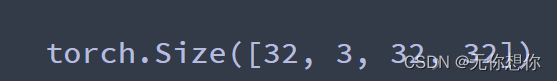

查看数据格式类型

# 取一个批次查看数据格式

# 数据的shape为:[batch_size, channel, height, weight]

# 其中batch_size为自己设定,channel,height和weight分别是图片的通道数,高度和宽度。

imgs, labels = next(iter(train_dl))

imgs.shape

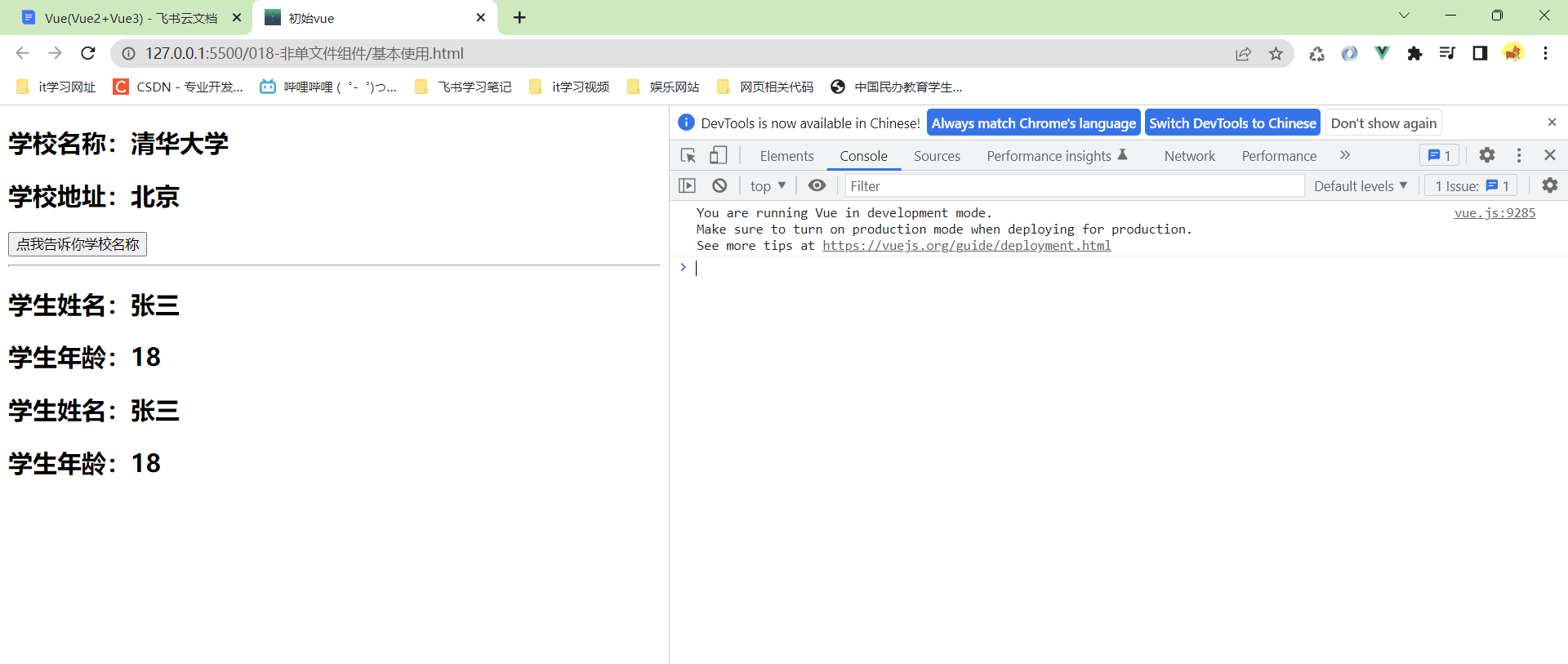

数据查看

查看一下图片

import numpy as np

# 指定图片大小,图像大小为20宽、5高的绘图(单位为英寸inch)

plt.figure(figsize=(20, 5)) #这个可以根据自己的想法进行调整

for i, imgs in enumerate(imgs[:20]):

# 维度缩减

npimg = imgs.numpy().transpose((1, 2, 0))

# 将整个figure分成2行10列,绘制第i+1个子图。

plt.subplot(2, 10, i+1)

plt.imshow(npimg, cmap=plt.cm.binary)

plt.axis('off')

构建CNN网络

CNN网络的简单介绍

对于一般的CNN网络来说,就是由特征提取网络和分类网络构成,其中特征提取网络用于提取图片的特征,分类网络用于图片进行分类

⭐1. torch.nn.Conv2d()详解

函数原型:

torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True, padding_mode='zeros', device=None, dtype=None)

关键参数说明:

- in_channels ( int ) – 输入图像中的通道数

- out_channels ( int ) – 卷积产生的通道数

- kernel_size ( int or tuple ) – 卷积核的大小

- stride ( int or tuple , optional ) – 卷积的步幅。默认值:1

- padding ( int , tuple或str , optional ) – 添加到输入的所有四个边的填充。默认值:0

- padding_mode (字符串,可选) – ‘zeros’, ‘reflect’, ‘replicate’或’circular’. 默认:‘zeros’

dilation:扩张操作,用线性代数的方法去理解,就是对原本的图片的每一个位置上对应的数乘以一个矩阵(这个矩阵会根据不同的选择有不同的结果),形成一个新的矩阵

⭐2. torch.nn.Linear()详解

函数原型:

torch.nn.Linear(in_features, out_features, bias=True, device=None, dtype=None)

关键参数说明:

- in_features:每个输入样本的大小

- out_features:每个输出样本的大小

⭐3. torch.nn.MaxPool2d()详解

函数原型:

torch.nn.MaxPool2d(kernel_size, stride=None, padding=0, dilation=1, return_indices=False, ceil_mode=False)

关键参数说明:

- kernel_size:最大的窗口大小

- stride:窗口的步幅,默认值为kernel_size

- padding:填充值,默认为0

- dilation:控制窗口中元素步幅的参数

⭐4. 关于卷积层、池化层的计算:

下面的网络数据shape变化过程为:

3, 32, 32(输入数据)

-> 64, 30, 30(经过卷积层1)-> 64, 15, 15(经过池化层1)

-> 64, 13, 13(经过卷积层2)-> 64, 6, 6(经过池化层2)

-> 128, 4, 4(经过卷积层3) -> 128, 2, 2(经过池化层3)

-> 512-> 256-> num_classes(10)(最后返回的是要进行分类的数量)

代码

import torch.nn.functional as F

num_classes = 10 # 图片的类别数

class Model(nn.Module):

def __init__(self):

super().__init__()

# 特征提取网络

self.conv1 = nn.Conv2d(3, 64, kernel_size=3) # 第一层卷积,卷积核大小为3*3

self.pool1 = nn.MaxPool2d(kernel_size=2) # 设置池化层,池化核大小为2*2

self.conv2 = nn.Conv2d(64, 64, kernel_size=3) # 第二层卷积,卷积核大小为3*3

self.pool2 = nn.MaxPool2d(kernel_size=2)

self.conv3 = nn.Conv2d(64, 128, kernel_size=3) # 第二层卷积,卷积核大小为3*3

self.pool3 = nn.MaxPool2d(kernel_size=2)

# 分类网络

self.fc1 = nn.Linear(512, 256)

self.fc2 = nn.Linear(256, num_classes)

# 前向传播

def forward(self, x):

x = self.pool1(F.relu(self.conv1(x)))

x = self.pool2(F.relu(self.conv2(x)))

x = self.pool3(F.relu(self.conv3(x)))

x = torch.flatten(x, start_dim=1)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

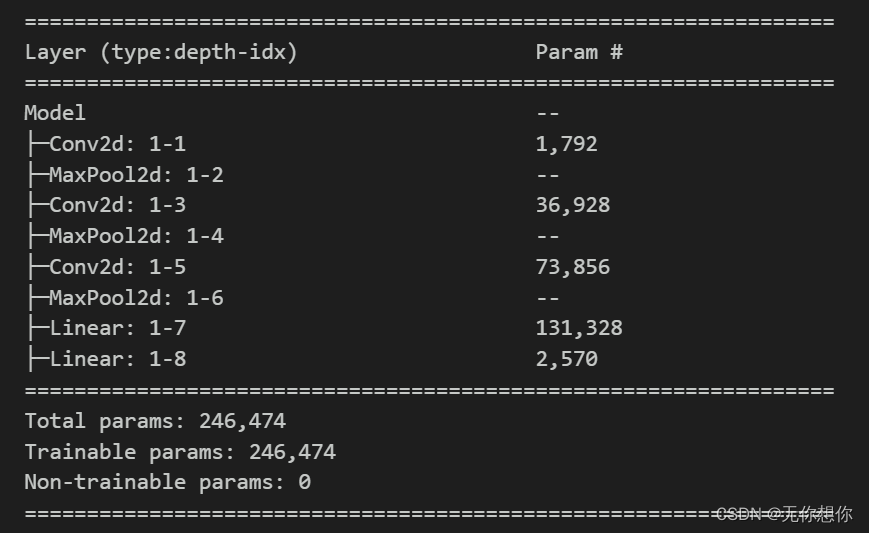

加载并打印模型

from torchinfo import summary

# 将模型转移到GPU中(我们模型运行均在GPU中进行)

model = Model().to(device)

summary(model)

进行编译

进行编译操作

设置参数

#进行编译

loss_fn = nn.CrossEntropyLoss() # 创建损失函数

learn_rate = 1e-2 # 学习率

opt = torch.optim.SGD(model.parameters(),lr=learn_rate)

模型训练

epoch设置为10,实现提高精度

# 训练循环

def train(dataloader, model, loss_fn, optimizer):

size = len(dataloader.dataset) # 训练集的大小,一共60000张图片

num_batches = len(dataloader) # 批次数目,1875(60000/32)

train_loss, train_acc = 0, 0 # 初始化训练损失和正确率

for X, y in dataloader: # 获取图片及其标签

X, y = X.to(device), y.to(device)

# 计算预测误差

pred = model(X) # 网络输出

loss = loss_fn(pred, y) # 计算网络输出和真实值之间的差距,targets为真实值,计算二者差值即为损失

# 反向传播

optimizer.zero_grad() # grad属性归零

loss.backward() # 反向传播

optimizer.step() # 每一步自动更新

#反向传播三部曲

# 记录acc与loss

train_acc += (pred.argmax(1) == y).type(torch.float).sum().item()

train_loss += loss.item()

train_acc /= size

train_loss /= num_batches

return train_acc, train_loss

def test (dataloader, model, loss_fn):

size = len(dataloader.dataset) # 测试集的大小,一共10000张图片

num_batches = len(dataloader) # 批次数目,313(10000/32=312.5,向上取整)

test_loss, test_acc = 0, 0

# 当不进行训练时,停止梯度更新,节省计算内存消耗

with torch.no_grad():

for imgs, target in dataloader:

imgs, target = imgs.to(device), target.to(device)

# 计算loss

target_pred = model(imgs)

loss = loss_fn(target_pred, target)

test_loss += loss.item()

test_acc += (target_pred.argmax(1) == target).type(torch.float).sum().item()

test_acc /= size

test_loss /= num_batches

return test_acc, test_loss

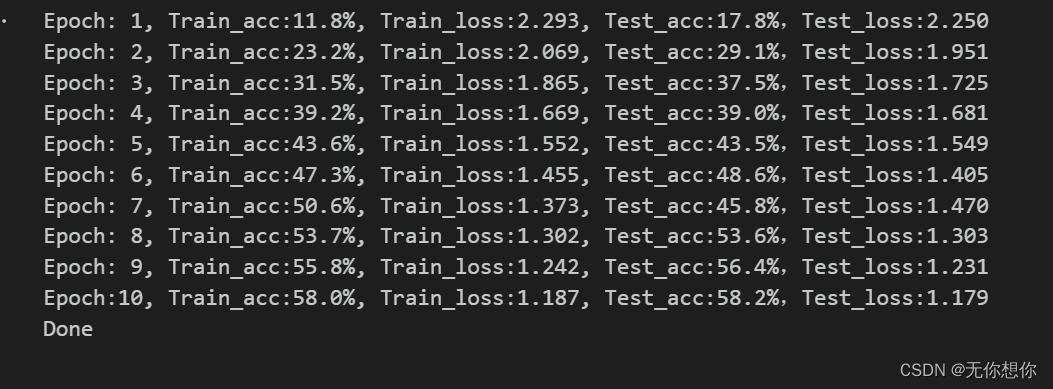

正式训练

epochs = 10

train_loss = []

train_acc = []

test_loss = []

test_acc = []

for epoch in range(epochs):

model.train()

epoch_train_acc, epoch_train_loss = train(train_dl, model, loss_fn, opt)

model.eval()

epoch_test_acc, epoch_test_loss = test(test_dl, model, loss_fn)

train_acc.append(epoch_train_acc)

train_loss.append(epoch_train_loss)

test_acc.append(epoch_test_acc)

test_loss.append(epoch_test_loss)

template = ('Epoch:{:2d}, Train_acc:{:.1f}%, Train_loss:{:.3f}, Test_acc:{:.1f}%,Test_loss:{:.3f}')

print(template.format(epoch+1, epoch_train_acc*100, epoch_train_loss, epoch_test_acc*100, epoch_test_loss))

print('Done')

结果可视化

使用准确度和损失值进行结果的优良进行分析

import matplotlib.pyplot as plt

#隐藏警告

import warnings

warnings.filterwarnings("ignore") #忽略警告信息

plt.rcParams['font.sans-serif'] = ['SimHei'] # 用来正常显示中文标签

plt.rcParams['axes.unicode_minus'] = False # 用来正常显示负号

plt.rcParams['figure.dpi'] = 100 #分辨率

epochs_range = range(epochs)

plt.figure(figsize=(12, 3))

plt.subplot(1, 2, 1)

plt.plot(epochs_range, train_acc, label='Training Accuracy')

plt.plot(epochs_range, test_acc, label='Test Accuracy')

plt.legend(loc='lower right')

plt.title('Training and Validation Accuracy')

plt.subplot(1, 2, 2)

plt.plot(epochs_range, train_loss, label='Training Loss')

plt.plot(epochs_range, test_loss, label='Test Loss')

plt.legend(loc='upper right')

plt.title('Training and Validation Loss')

plt.show()