gpt训练模型

GPT(Generative Pre-trained Transformer)是指一类以Transformer网络为基础的语言模型,可以用于自然语言生成、问答、文本分类等多个NLP任务。GPT的训练是基于预训练(pre-training)的方式进行的,即首先在大规模语料上进行无监督训练预测下一个单词是什么,从而获得语言的内在表示,然后在特定任务上进行微调(fine-tuning)。

GPT模型的训练通常分为两个阶段:预训练和微调。在预训练阶段,GPT模型通过大规模无标注的语料库,例如维基百科、新闻文章和图书等,学习语言的概率分布,从而生成对下一个单词的预测(通过Masked Language Model,MLM)。这样预训练出的模型的潜在能力可以支持多个自然语言处理任务,例如文本生成、问答、文本分类等。在微调阶段,我们使用有标签的数据集,例如情感分析任务的IMDB数据集,使模型更好地适应特定任务。

在预训练阶段,GPT使用了基于自回归的语言建模:给定前面的词作为输入,预测下一个词的概率分布。在每个时间步骤中,输入序列经过一个多头注意力机制网络和一个前馈神经网络进行处理,最后生成下一个词。在微调阶段,我们可以将该预训练模型的参数进行微调,以适应给定的任务。对于分类任务,我们可以将该模型的输出层替换为一个全连接层,并对该层进行监督式训练。对于自然语言生成任务,我们可以通过在原始序列的末尾添加自定义生成文本来完成微调。

总的来说,GPT是一种非常强大的文本生成模型,它基于大量的语料库进行预训练,可以生成高质量的文本,并且可以应用于多种自然语言处理任务。

gpt软件

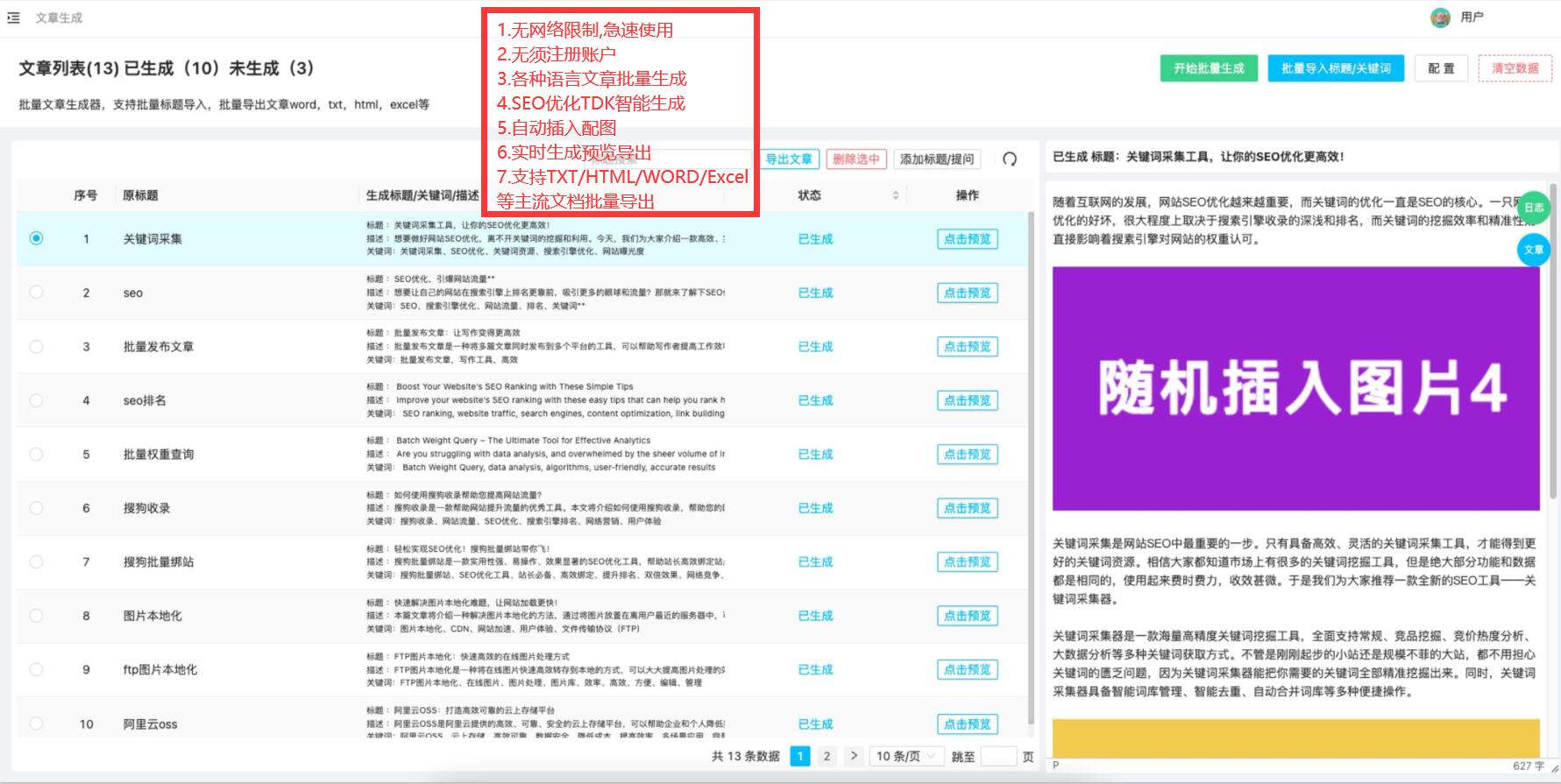

如果您正在寻找一款功能强大、易于使用且经济实惠的自然语言处理工具,那么GPT软件会是您的不二选择。GPT是一款由OpenAI开发的人工智能语言模型,可帮助您快速地生成高质量的自然语言文本,使您的工作更加高效和便捷。

GPT软件的主要优势在于其领先的自然语言处理技术。通过训练大量的语料库,GPT能够学习自然语言的语法和词汇,从而能够快速地理解您输入的内容,并生成符合语法的高质量文本。GPT还支持多种语言,包括英语、中文、法语等,使其适用范围更广。

除此之外,GPT还提供了一系列实用的功能,如生成文章摘要、自动纠错、语法检查等。这些功能可以帮助您提高工作效率,减少错误率,节约时间和精力。GPT软件为您提供专业的技术支持和维护服务,确保您的使用过程中不会遇到任何障碍,使您的工作得以顺利进行。

总之,如果您想要提高工作效率、减少工作压力,GPT软件将是您的首选。请赶快联系我们的销售团队,了解更多关于GPT软件的信息,开始享受高效、便捷和经济实惠的自然语言处理服务。