深入Hotspot源码与Linux内核理解NIO与Epoll

- 前言介绍

- Netty 的介绍

- Netty 的应用场景

- 理解阻塞和同步关键字

- 初始BIO、NIO、AIO

- BIO(Blocking IO)

- 缺点:

- 应用场景:

- NIO(Non Blocking IO)

- 应用场景:

- NIO非阻塞代码示例

- 存在的问题

- NIO 有三大核心组件:Channel(通道), Buffer(缓冲区),Selector(多路复用器)

- Epoll函数详解

- Redis线程模型

- AIO(NIO 2.0)

- BIO、 NIO、 AIO 对比:

- 为什么Netty使用NIO而不是AIO?

- 同步异步与阻塞非阻塞(段子)

前言介绍

在Java中,提供了一些关于使用IO的API,可以供开发者来读写外部数据和文件,我们称这些API为Java IO。IO是Java中比较重要知识点,且比较难学习的知识点。并且随着Java的发展为提供更好的数据传输性能,目前有三种IO共存;分别是BIO、NIO和AIO。

学习完这三种IO之后会去学习Netty,本人也是抱着学习的目标来写这些文章的。如果有任何不对的地方还望指正

Netty 的介绍

- Netty 是由 JBOSS 提供的一个 Java 开源框架,现为 Github 上的独立项目。

- Netty 是一个异步的、基于事件驱动的网络应用框架,用以快速开发高性能、高可靠性的网络 IO 程序。

- Netty 主要针对在 TCP 协议下,面向 Client 端的高并发应用,或者 Peer-to-Peer 场景下的大量数据持续传输的应用。

- Netty 本质是一个 NIO 框架,适用于服务器通讯相关的多种应用场景。

要透彻理解 Netty,需要先学习 NIO,这样我们才能阅读 Netty 的源码。

Netty 的应用场景

- 互联网行业

互联网行业:在分布式系统中,各个节点之间需要远程服务调用,高性能的 RPC 框架必不可少,Netty 作为异步高性能的通信框架,往往作为基础通信组件被这些 RPC 框架使用。

典型的应用有:阿里分布式服务框架 Dubbo 的 RPC 框 架使用 Dubbo 协议进行节点间通信,Dubbo 协议默认使用 Netty 作为基础通信组件,用于实现各进程节点之间的内部通信。

- 游戏行业

无论是手游服务端还是大型的网络游戏,Java 语言得到了越来越广泛的应用。

Netty 作为高性能的基础通信组件,提供了 TCP/UDP 和 HTTP 协议栈,方便定制和开发私有协议栈,账号登录服务器。

地图服务器之间可以方便的通过 Netty 进行高性能的通信。

- 大数据领域

经典的 Hadoop 的高性能通信和序列化组件 Avro 的 RPC 框架,默认采用 Netty 进行跨界点通信。

它的 NettyService 基于 Netty 框架二次封装实现。

理解阻塞和同步关键字

- 阻塞IO 和 非阻塞IO

这两个概念是程序级别的。主要描述的是程序请求操作系统IO操作后,如果IO资源没有准备好,那么程序该如何处理的问题: 前者等待;后者继续执行(并且使用线程一直轮询,直到有IO资源准备好了)

- 同步IO 和 非同步IO

这两个概念是操作系统级别的。主要描述的是操作系统在收到程序请求IO操作后,如果IO资源没有准备好,该如何响应程序的问题: 前者不响应,直到IO资源准备好以后;后者返回一个标记(好让程序和自己知道以后的数据往哪里通知),当IO资源准备好以后,再用事件机制返回给程序。

初始BIO、NIO、AIO

BIO(Blocking IO)

同步阻塞模型,一个客户端连接对应一个处理线程。

这种就是多个请求过来以后,只能一个一个去处理,所以是同步阻塞的。代码:

public static void main(String[] args) throws IOException {

ServerSocket serverSocket = new ServerSocket(9000);

while (true) {

System.out.println("等待连接。。");

//阻塞方法 等待客户端连接

Socket clientSocket = serverSocket.accept();

System.out.println("有客户端连接了。。");

//客户端连接后处理事件

handler(clientSocket);

}

}

private static void handler(Socket clientSocket) throws IOException {

byte[] bytes = new byte[1024];

System.out.println("准备read。。");

//接收客户端的数据,阻塞方法,没有数据可读时就阻塞

int read = clientSocket.getInputStream().read(bytes);

System.out.println("read完毕。。");

if (read != -1) {

System.out.println("接收到客户端的数据:" + new String(bytes, 0, read));

}

clientSocket.getOutputStream().write("HelloClient".getBytes());

clientSocket.getOutputStream().flush();

}

那么上面的代码有没有什么优化方式呢? 就是开启多线程,每次进来一个accept请求,都开启一个线程去处理,代码如下:

public static void main(String[] args) throws IOException {

ServerSocket serverSocket = new ServerSocket(9000);

while (true) {

System.out.println("等待连接。。");

//阻塞方法 等待客户端连接

Socket clientSocket = serverSocket.accept();

System.out.println("有客户端连接了。。");

//客户端连接后处理事件

new Thread(new Runnable() {

@Override

public void run() {

try {

handler(clientSocket);

} catch (IOException e) {

e.printStackTrace();

}

}

}).start();

}

}

客户端代码:

//客户端代码

public class SocketClient {

public static void main(String[] args) throws IOException {

Socket socket = new Socket("localhost", 9000);

//向服务端发送数据

socket.getOutputStream().write("HelloServer".getBytes());

socket.getOutputStream().flush();

System.out.println("向服务端发送数据结束");

byte[] bytes = new byte[1024];

//接收服务端回传的数据

socket.getInputStream().read(bytes);

System.out.println("接收到服务端的数据:" + new String(bytes));

socket.close();

}

}

那么我们想一下这样的BIO代码有什么问题呢?

缺点:

- IO代码里read操作是阻塞操作,如果连接不做数据读写操作会导致线程阻塞,浪费资源。

- 如果线程很多,会导致服务器线程太多,压力太大,比如C10K问题。

应用场景:

BIO 方式适用于连接数目比较小且固定的架构, 这种方式对服务器资源要求比较高, 但程序简单易理解。

NIO(Non Blocking IO)

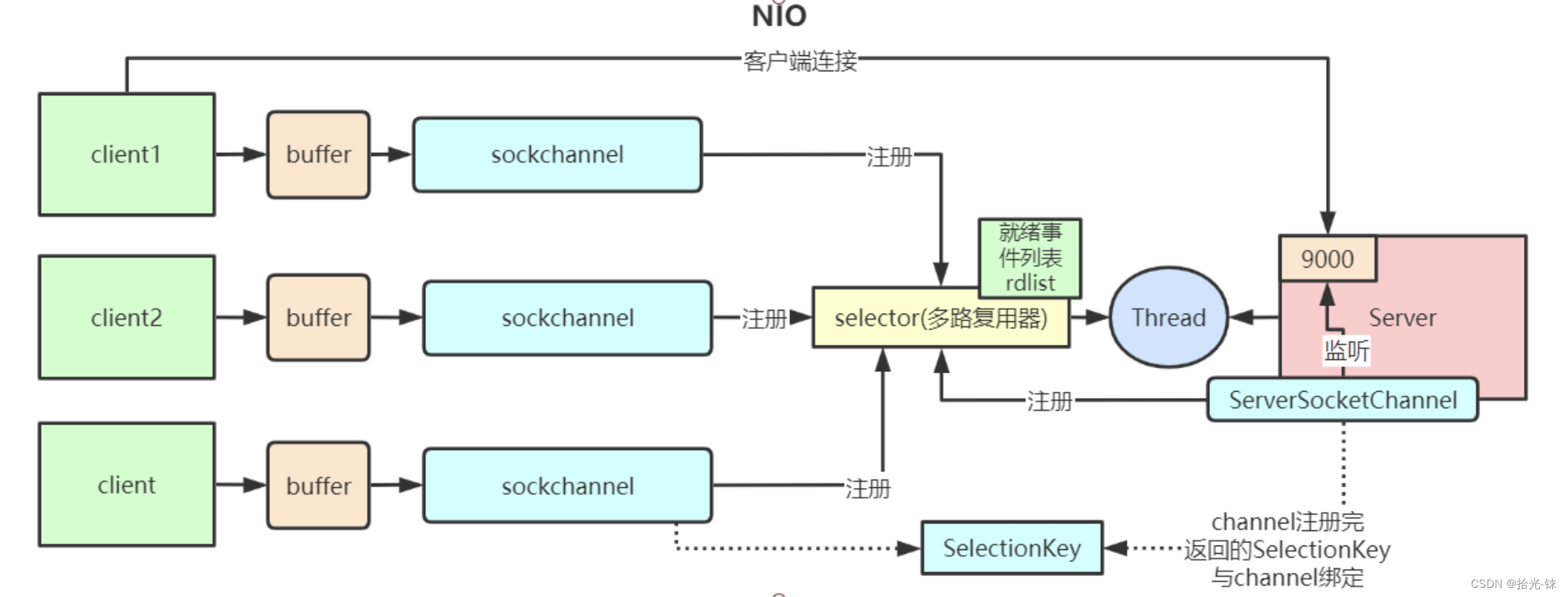

同步非阻塞,服务器实现模式为一个线程可以处理多个请求(连接),客户端发送的连接请求都会注册到多路复用器selector上,多路复用器轮询到连接有IO请求就进行处理,JDK1.4开始引入。

应用场景:

NIO方式适用于连接数目多且连接比较短(轻操作) 的架构, 比如聊天服务器, 弹幕系统, 服务器间通讯,编程比较复杂

NIO非阻塞代码示例

package com.duoduo.nio;

import java.io.IOException;

import java.net.InetSocketAddress;

import java.nio.ByteBuffer;

import java.nio.channels.ServerSocketChannel;

import java.nio.channels.SocketChannel;

import java.util.ArrayList;

import java.util.Iterator;

import java.util.List;

public class NioServer {

// 保存客户端连接

static List<SocketChannel> channelList = new ArrayList<>();

public static void main(String[] args) throws IOException {

// 创建NIO ServerSocketChannel,与BIO的serverSocket类似

ServerSocketChannel serverSocket = ServerSocketChannel.open();

serverSocket.socket().bind(new InetSocketAddress(9000));

// 设置ServerSocketChannel为非阻塞

serverSocket.configureBlocking(false);

System.out.println("服务启动成功");

while (true) {

// 非阻塞模式accept方法不会阻塞,否则会阻塞

// NIO的非阻塞是由操作系统内部实现的,底层调用了linux内核的accept函数

SocketChannel socketChannel = serverSocket.accept();

if (socketChannel != null) { // 如果有客户端进行连接

System.out.println("连接成功");

// 设置SocketChannel为非阻塞

socketChannel.configureBlocking(false);

// 保存客户端连接在List中

channelList.add(socketChannel);

}

// 遍历连接进行数据读取

Iterator<SocketChannel> iterator = channelList.iterator();

while (iterator.hasNext()) {

SocketChannel sc = iterator.next();

ByteBuffer byteBuffer = ByteBuffer.allocate(128);

// 非阻塞模式read方法不会阻塞,否则会阻塞

int len = sc.read(byteBuffer);

// 如果有数据,把数据打印出来

if (len > 0) {

System.out.println("接收到消息:" + new String(byteBuffer.array()));

} else if (len == -1) { // 如果客户端断开,把socket从集合中去掉

iterator.remove();

System.out.println("客户端断开连接");

}

}

}

}

}

在这里的serverSocket.accept()是不会阻塞的,然后主线程一直循环去调用查看有没有链接事件,如果有就加在channelList里面,然后再去循环channelList判断是否有客户端传递过来的数据,如果有的话就去处理。这就是NIO,一个线程就可以去处理上完的客户端请求。但是也存在一个很严重的问题。

存在的问题

如果连接数太多的话,会有大量的无效遍历,假如有10000个连接,其中只有1000个连接有写数据,但是由于其他9000个连接并没有断开,我们还是要每次轮询遍历一万次,其中有十分之九的遍历都是无效的,这显然不是一个让人很满意的状态。

在下面引入NIO多路复用器,也是最核心的代码:

package com.duoduo.nio;

import java.io.IOException;

import java.net.InetSocketAddress;

import java.nio.ByteBuffer;

import java.nio.channels.SelectionKey;

import java.nio.channels.Selector;

import java.nio.channels.ServerSocketChannel;

import java.nio.channels.SocketChannel;

import java.util.Iterator;

import java.util.Set;

public class NioSelectorServer {

public static void main(String[] args) throws IOException {

// 创建NIO ServerSocketChannel

ServerSocketChannel serverSocket = ServerSocketChannel.open();

serverSocket.socket().bind(new InetSocketAddress(9000));

// 设置ServerSocketChannel为非阻塞

serverSocket.configureBlocking(false);

// 打开Selector处理Channel,即创建epoll

Selector selector = Selector.open();//创建了一个epoll对象,并且返回了一个文件描述符 epfd 文件描述符就表示她是epoll对象在啊哦做系统的引用地址

// 把ServerSocketChannel注册到selector上,并且selector对客户端accept连接操作感兴趣

//这一步主要是将SocketChannel 和epoll做关联。加入集合里面,但不是redist集合

SelectionKey selectionKey = serverSocket.register(selector, SelectionKey.OP_ACCEPT);//只是将serverSocket添加到epoll里面的一个集合里面,将他们进行了关联

System.out.println("服务启动成功");

while (true) {

// 阻塞等待需要处理的事件发生

//里面会调用ctl和wait方法

selector.select();

// 获取selector中注册的全部事件的 SelectionKey 实例

Set<SelectionKey> selectionKeys = selector.selectedKeys();

Iterator<SelectionKey> iterator = selectionKeys.iterator();

// 遍历SelectionKey对事件进行处理

while (iterator.hasNext()) {

SelectionKey key = iterator.next();

// 如果是OP_ACCEPT事件,则进行连接获取和事件注册

if (key.isAcceptable()) {

ServerSocketChannel server = (ServerSocketChannel) key.channel();

SocketChannel socketChannel = server.accept();

socketChannel.configureBlocking(false);

// 这里只注册了读事件,如果需要给客户端发送数据可以注册写事件

SelectionKey selKey = socketChannel.register(selector, SelectionKey.OP_READ);

System.out.println("客户端连接成功");

} else if (key.isReadable()) { // 如果是OP_READ事件,则进行读取和打印

SocketChannel socketChannel = (SocketChannel) key.channel();

ByteBuffer byteBuffer = ByteBuffer.allocateDirect(128);

int len = socketChannel.read(byteBuffer);

// 如果有数据,把数据打印出来

if (len > 0) {

System.out.println("接收到消息:" + new String(byteBuffer.array()));

} else if (len == -1) { // 如果客户端断开连接,关闭Socket

System.out.println("客户端断开连接");

socketChannel.close();

}

}

//从事件集合里删除本次处理的key,防止下次select重复处理

iterator.remove();

}

}

}

}

这样我们就不用一直去循环了,因为在selector.select();的时候会去阻塞,当有连接或者读写事件发生的时候就会跳出阻塞,去遍历所有的selectionKeys,进一步判断是连接事件还是读写事件。

这里最核心的代码:

1.Selector.open();

2.serverSocket.register(selector, SelectionKey.OP_ACCEPT);

3.selector.select();

先记住,后面会详细解释源码的。

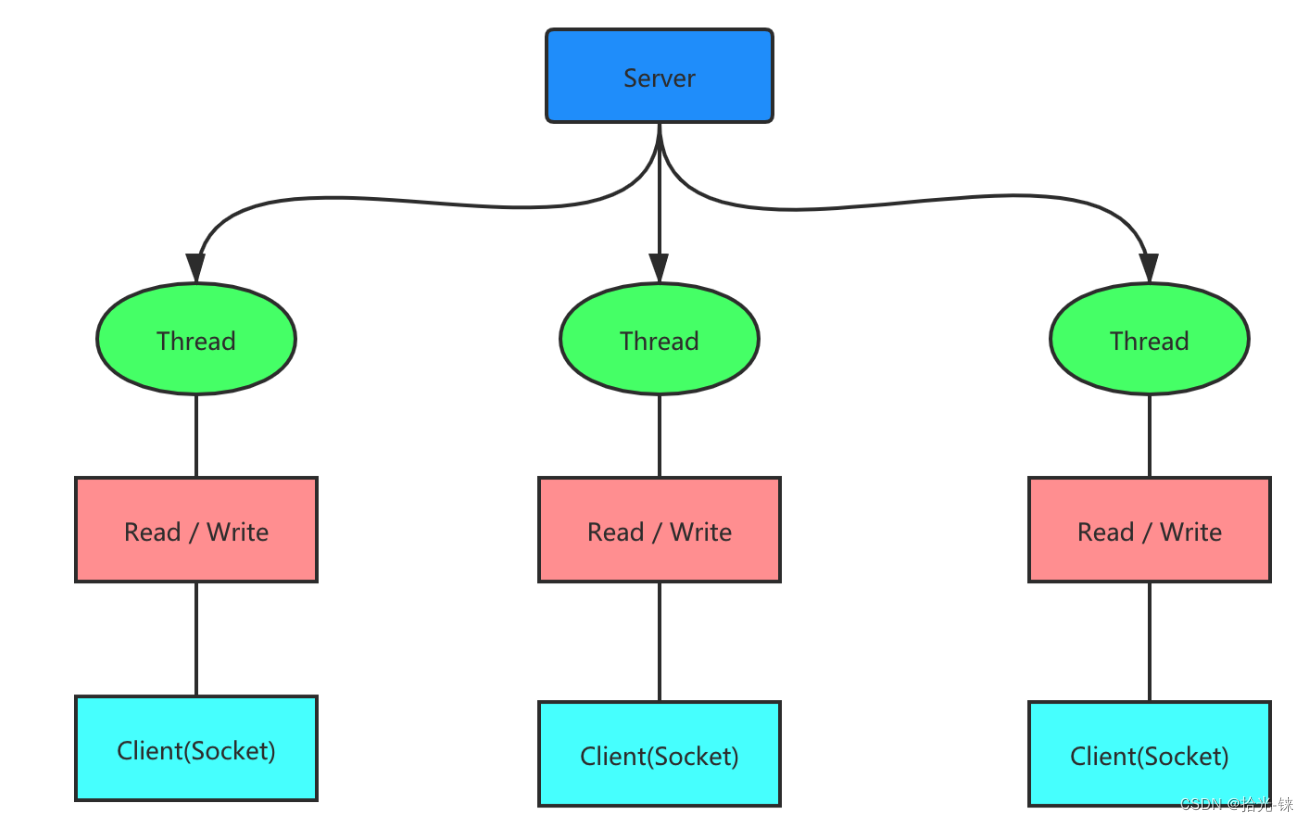

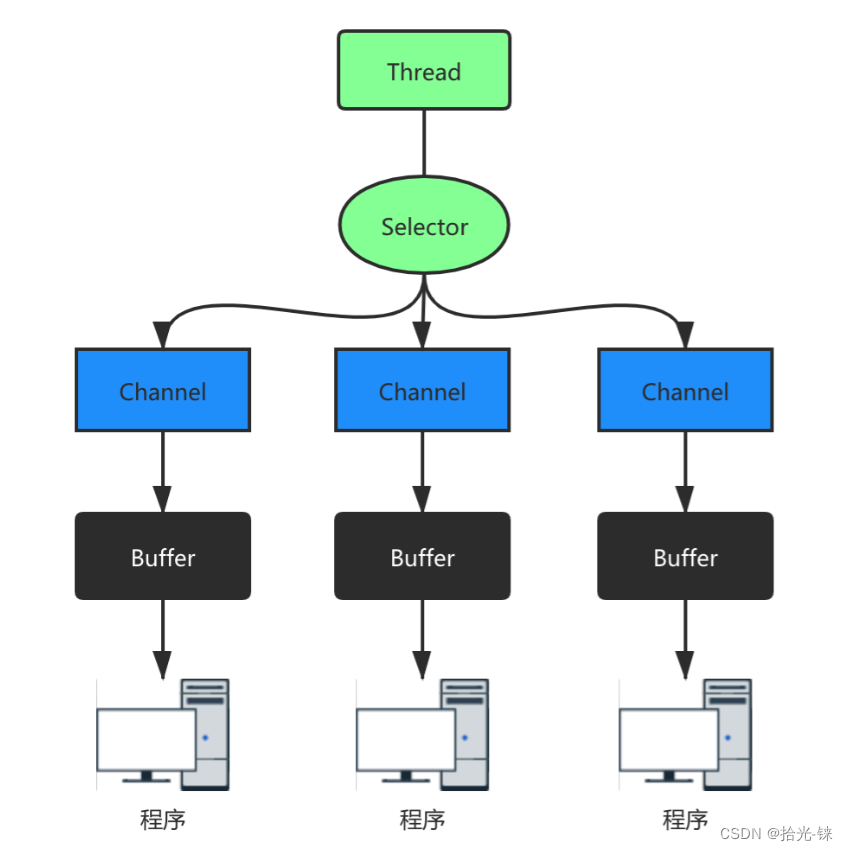

NIO 有三大核心组件:Channel(通道), Buffer(缓冲区),Selector(多路复用器)

- channel 类似于流,每个 channel 对应一个 buffer缓冲区,buffer 底层就是个数组(其实这里不是很严谨,Netty对于buffer是有做特殊处理的,为了高性能采用的零拷贝技术,使用的直接内存,后期会单独详细介绍。)

- channel 会注册到 selector 上,由 selector 根据 channel 读写事件的发生将其交由某个空闲的线程处理

- NIO 的 Buffer 和 channel 都是既可以读也可以写

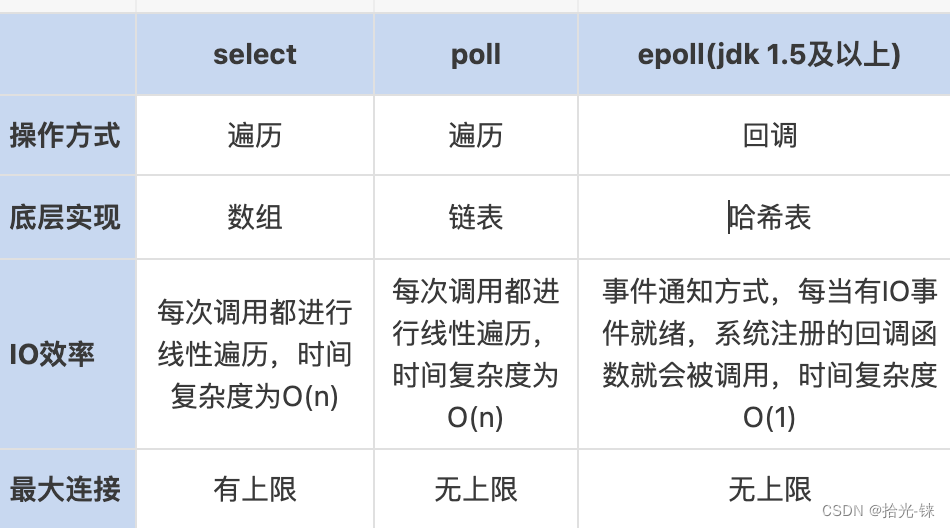

- NIO底层在JDK1.4版本是用linux的内核函数select()或poll()来实现,跟上面的NioServer代码类似,selector每次都会轮询所有的sockchannel看下哪个channel有读写事件,有的话就处理,没有就继续遍历,JDK1.5开始引入了epoll基于事件响应机制来优化NIO。

在这里epoll又依赖于计算机硬件的中断机制,如果不熟悉的可以了解一下计算机的中断机制,这样避免了多线程之间的上下文切换导致的开销。

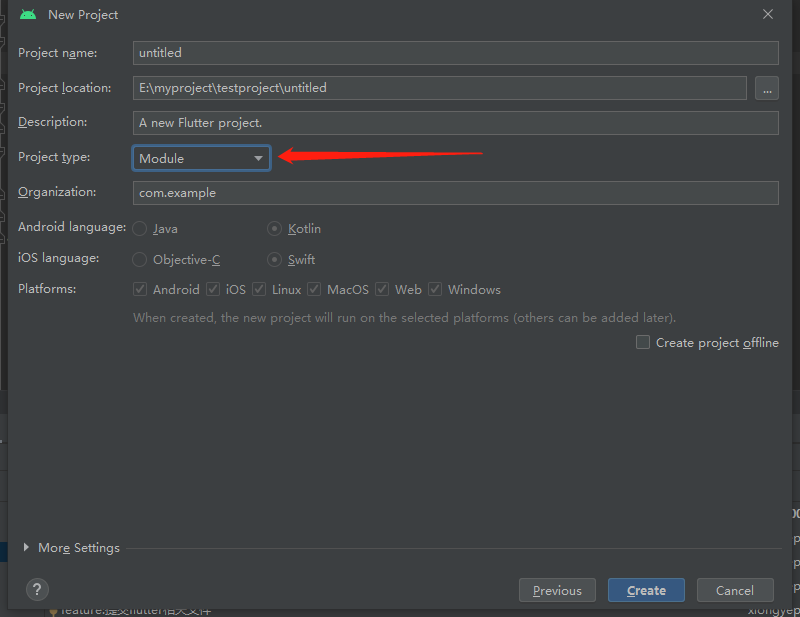

线程模型图:

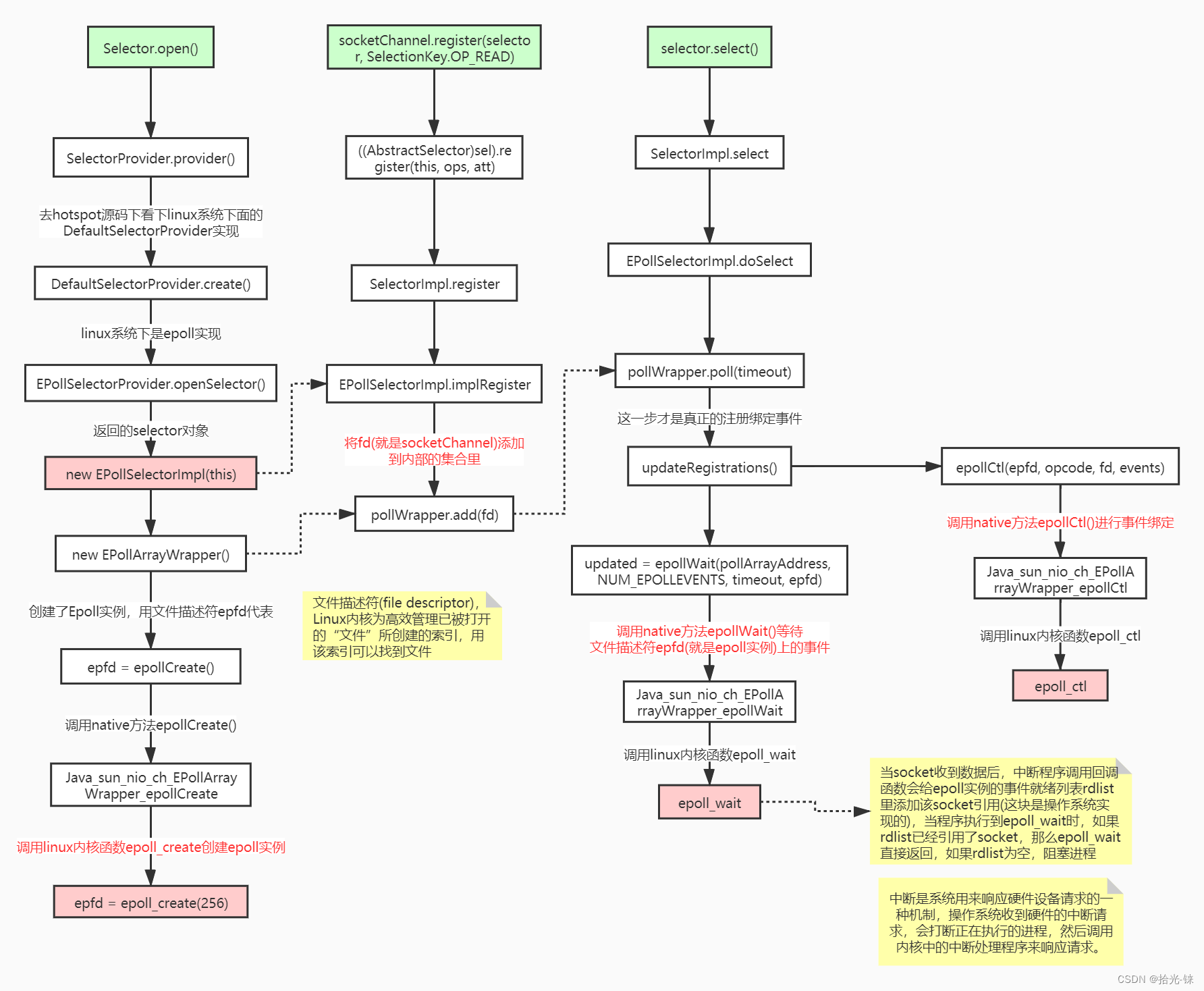

那么我们从上面提到的很重要的那三行代码,从Hotspot与Linux内核函数级别来理解下。

1.Selector.open() //创建多路复用器

2.socketChannel.register(selector, SelectionKey.OP_READ) //将channel注册到多路复用器上

3.selector.select() //阻塞等待需要处理的事件发生

- Selector.open()

public static Selector open() throws IOException {

return SelectorProvider.provider().openSelector();

}

#先看SelectorProvider.provider()做了什么

public static SelectorProvider create() {

String osname = AccessController

.doPrivileged(new GetPropertyAction("os.name"));

if (osname.equals("SunOS"))

return createProvider("sun.nio.ch.DevPollSelectorProvider");

if (osname.equals("Linux"))

return createProvider("sun.nio.ch.EPollSelectorProvider");

return new sun.nio.ch.PollSelectorProvider();

}

#其实很简单,就是根据服务器的不同,提供不同的SelectorProvider,那么在Linux中,默认返回的肯定是EPollSelectorProvider

#然后我们去看EPollSelectorProvider..openSelector()

public class EPollSelectorProvider extends SelectorProviderImpl{

//返回了一个EPollSelectorImpl对象

public AbstractSelector openSelector() throws IOException {

return new EPollSelectorImpl(this);

}

public Channel inheritedChannel() throws IOException {

return InheritedChannel.getChannel();

}

}

#下面我们看一下EPollSelectorImpl中做了什么?

EPollSelectorImpl(SelectorProvider sp) throws IOException {

super(sp);

long pipeFds = IOUtil.makePipe(false);

fd0 = (int) (pipeFds >>> 32);

fd1 = (int) pipeFds;

try {

pollWrapper = new EPollArrayWrapper();

pollWrapper.initInterrupt(fd0, fd1);

fdToKey = new HashMap<>();

} catch (Throwable t) {

***

throw t;

}

}

#创建了EPollArrayWrapper,然后我们去看他做了什么

EPollArrayWrapper() throws IOException {

// creates the epoll file descriptor

epfd = epollCreate();

// the epoll_event array passed to epoll_wait

int allocationSize = NUM_EPOLLEVENTS * SIZE_EPOLLEVENT;

pollArray = new AllocatedNativeObject(allocationSize, true);

pollArrayAddress = pollArray.address();

// eventHigh needed when using file descriptors > 64k

if (OPEN_MAX > MAX_UPDATE_ARRAY_SIZE)

eventsHigh = new HashMap<>();

}

#调用epollCreate去创建epoll实例。

#去到hotspot源码中看 其实就是调用了epoll_create

那么到这里我们就知道了。其实就是调用了Linux的内核函数epoll_create,返回了一个epfd是一个epoll实例。它是属于MAN函数指令的系统调用。

1:用户在shell环境可操作的命令或执行文件;

2:系统内核可调用的函数与工具等(epoll_create属于这里)

3:一些常用的函数(function)与函数库(library),大部分为C的函数库(libc)

4:设备文件说明,通常在/dev下的文件

5:配置文件或某些文件格式

6:游戏(games)

7:惯例与协议等,如Linux文件系统,网络协议,ASCII code等说明

8:系统管理员可用的管理命令

9:跟kernel有关的文件

- socketChannel.register(selector, SelectionKey.OP_READ)

protected void implRegister(SelectionKeyImpl ski) {

if (closed)

throw new ClosedSelectorException();

SelChImpl ch = ski.channel;

int fd = Integer.valueOf(ch.getFDVal());

fdToKey.put(fd, ski);

//在第一部初始化的EPollArrayWrapper,把当前的fd添加进去

pollWrapper.add(fd);

keys.add(ski);

}

这一步主要是将SocketChannel 和epoll做关联。加入集合里面,但不是redist集合

- selector.select()

int poll(long timeout) throws IOException {

//这一步才是真正的注册绑定事件

updateRegistrations();

updated = epollWait(pollArrayAddress, NUM_EPOLLEVENTS, timeout, epfd);

for (int i=0; i<updated; i++) {

if (getDescriptor(i) == incomingInterruptFD) {

interruptedIndex = i;

interrupted = true;

break;

}

}

return updated;

}

# updateRegistrations()

private void updateRegistrations() {

synchronized (updateLock) {

int j = 0;

while (j < updateCount) {

int fd = updateDescriptors[j];

short events = getUpdateEvents(fd);

boolean isRegistered = registered.get(fd);

int opcode = 0;

if (events != KILLED) {

if (isRegistered) {

opcode = (events != 0) ? EPOLL_CTL_MOD : EPOLL_CTL_DEL;

} else {

opcode = (events != 0) ? EPOLL_CTL_ADD : 0;

}

if (opcode != 0) {

epollCtl(epfd, opcode, fd, events);

if (opcode == EPOLL_CTL_ADD) {

registered.set(fd);

} else if (opcode == EPOLL_CTL_DEL) {

registered.clear(fd);

}

}

}

j++;

}

updateCount = 0;

}

}

updateRegistrations 又执行了一个LINUX的指令:epoll_ctl。

这个方法的主要作用就是将fd:socketChannle的那些事件注册到epoll对象上面去,将他们关联起来

epollWait->等待文件描述符epfd上的事件。

这里主要是采用的底层的内核函数。由于字数原因,我就不贴代码了,把核心流程图贴出来。大家可以根据我的流程图去看。看一下具体的代码流程图

总结:NIO整个调用流程就是Java调用了操作系统的内核函数来创建Socket,获取到Socket的文件描述符,再创建一个Selector对象,对应操作系统的Epoll描述符,将获取到的Socket连接的文件描述符的事件绑定到Selector对应的Epoll文件描述符上,进行事件的异步通知,这样就实现了使用一条线程,并且不需要太多的无效的遍历,将事件处理交给了操作系统内核(操作系统中断程序实现),大大提高了效率。

Epoll函数详解

int epoll_create(int size);

创建一个epoll实例,并返回一个非负数作为文件描述符,用于对epoll接口的所有后续调用。参数size代表可能会容纳size个描述符,但size不是一个最大值,只是提示操作系统它的数量级,现在这个参数基本上已经弃用了。

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

epfd:epoll实例对象

fd:socketChannle

op:就是那些读写事件

这个方法的主要作用就是将fd:socketChannle的那些事件注册到epoll对象上面去,将他们关联起来

使用文件描述符epfd引用的epoll实例,对目标文件描述符fd执行op操作。

参数epfd表示epoll对应的文件描述符,参数fd表示socket对应的文件描述符。

参数op有以下几个值:

EPOLL_CTL_ADD:注册新的fd到epfd中,并关联事件event;

EPOLL_CTL_MOD:修改已经注册的fd的监听事件;

EPOLL_CTL_DEL:从epfd中移除fd,并且忽略掉绑定的event,这时event可以为null;

参数event是一个结构体

struct epoll_event {

__uint32_t events; /* Epoll events */

epoll_data_t data; /* User data variable */

};

typedef union epoll_data {

void *ptr;

int fd;

__uint32_t u32;

__uint64_t u64;

} epoll_data_t;

events有很多可选值,这里只举例最常见的几个:

EPOLLIN :表示对应的文件描述符是可读的;

EPOLLOUT:表示对应的文件描述符是可写的;

EPOLLERR:表示对应的文件描述符发生了错误;

成功则返回0,失败返回-1

int epoll_wait(int epfd, struct epoll_event *events, int maxevents, int timeout);

等待文件描述符epfd上的事件。

epfd是Epoll对应的文件描述符,events表示调用者所有可用事件的集合,maxevents表示最多等到多少个事件就返回,timeout是超时时间。

I/O多路复用底层主要用的Linux 内核·函数(select,poll,epoll)来实现,windows不支持epoll实现,windows底层是基于winsock2的select函数实现的(不开源)

Redis线程模型

Redis就是典型的基于epoll的NIO线程模型(nginx也是),epoll实例收集所有事件(连接与读写事件),由一个服务端线程连续处理所有事件命令。

Redis底层关于epoll的源码实现在redis的src源码目录的ae_epoll.c文件里,感兴趣可以自行研究。

AIO(NIO 2.0)

异步非阻塞, 由操作系统完成后回调通知服务端程序启动线程去处理, 一般适用于连接数较多且连接时间较长的应用

应用场景:

AIO方式适用于连接数目多且连接比较长(重操作)的架构,JDK7 开始支持

package com.duoduo.aio;

import java.io.IOException;

import java.net.InetSocketAddress;

import java.nio.ByteBuffer;

import java.nio.channels.AsynchronousServerSocketChannel;

import java.nio.channels.AsynchronousSocketChannel;

import java.nio.channels.CompletionHandler;

public class AIOServer {

public static void main(String[] args) throws Exception {

final AsynchronousServerSocketChannel serverChannel =

AsynchronousServerSocketChannel.open().bind(new InetSocketAddress(9000));

serverChannel.accept(null, new CompletionHandler<AsynchronousSocketChannel, Object>() {

@Override

public void completed(AsynchronousSocketChannel socketChannel, Object attachment) {

try {

System.out.println("2--"+Thread.currentThread().getName());

// 再此接收客户端连接,如果不写这行代码后面的客户端连接连不上服务端

serverChannel.accept(attachment, this);

System.out.println(socketChannel.getRemoteAddress());

ByteBuffer buffer = ByteBuffer.allocate(1024);

socketChannel.read(buffer, buffer, new CompletionHandler<Integer, ByteBuffer>() {

@Override

public void completed(Integer result, ByteBuffer buffer) {

System.out.println("3--"+Thread.currentThread().getName());

buffer.flip();

System.out.println(new String(buffer.array(), 0, result));

socketChannel.write(ByteBuffer.wrap("HelloClient".getBytes()));

}

@Override

public void failed(Throwable exc, ByteBuffer buffer) {

exc.printStackTrace();

}

});

} catch (IOException e) {

e.printStackTrace();

}

}

@Override

public void failed(Throwable exc, Object attachment) {

exc.printStackTrace();

}

});

System.out.println("1--"+Thread.currentThread().getName());

Thread.sleep(Integer.MAX_VALUE);

}

}

package com.duoduo.aio;

import java.net.InetSocketAddress;

import java.nio.ByteBuffer;

import java.nio.channels.AsynchronousSocketChannel;

public class AIOClient {

public static void main(String... args) throws Exception {

AsynchronousSocketChannel socketChannel = AsynchronousSocketChannel.open();

socketChannel.connect(new InetSocketAddress("127.0.0.1", 9000)).get();

socketChannel.write(ByteBuffer.wrap("HelloServer".getBytes()));

ByteBuffer buffer = ByteBuffer.allocate(512);

Integer len = socketChannel.read(buffer).get();

if (len != -1) {

System.out.println("客户端收到信息:" + new String(buffer.array(), 0, len));

}

}

}

BIO、 NIO、 AIO 对比:

为什么Netty使用NIO而不是AIO?

在Linux系统上,AIO的底层实现仍使用Epoll,没有很好实现AIO,因此在性能上没有明显的优势,而且被JDK封装了一层不容易深度优化,Linux上AIO还不够成熟。Netty是异步非阻塞框架,Netty在NIO上做了很多异步的封装。

同步异步与阻塞非阻塞(段子)

老张爱喝茶,废话不说,煮开水。

出场人物:老张,水壶两把(普通水壶,简称水壶;会响的水壶,简称响水壶)。

- 老张把水壶放到火上,立等水开。(同步阻塞)

老张觉得自己有点傻

- 老张把水壶放到火上,去客厅看电视,时不时去厨房看看水开没有。(同步非阻塞)

老张还是觉得自己有点傻,于是变高端了,买了把会响笛的那种水壶。水开之后,能大声发出嘀~~~~的噪音。

- 老张把响水壶放到火上,立等水开。(异步阻塞)

老张觉得这样傻等意义不大

- 老张把响水壶放到火上,去客厅看电视,水壶响之前不再去看它了,响了再去拿壶。(异步非阻塞)

老张觉得自己聪明了。

所谓同步异步,只是对于水壶而言。

普通水壶,同步;响水壶,异步。

虽然都能干活,但响水壶可以在自己完工之后,提示老张水开了。这是普通水壶所不能及的。

同步只能让调用者去轮询自己(情况2中),造成老张效率的低下。

所谓阻塞非阻塞,仅仅对于老张而言。

立等的老张,阻塞;看电视的老张,非阻塞。

![[网络原理] 详解Cookie与Session](https://img-blog.csdnimg.cn/410357148cd74a068872b6481bf8fb4e.png)