Facebook的新模型称为SAM或Segment Anything Model,具有在计算机视觉行业中引起积极变革的潜力。这个突破性模型不同于以前使用的任何其他图像分割模型。

传统上,会为不同类型的图像,如人或汽车,分别训练不同的模型,但SAM通过提供通用分割解决方案,消除了需要单独模型的需求。SAM类似于自然语言处理行业中的GPT时代,具有用于各种图像分割任务的潜力,如情感分析或卫星图像分割。

Facebook慷慨地发布了SAM和用于训练它的数据集,其中包含超过1100万张图像和11亿个掩码,遵循宽松的Apache 2.0许可证。这个开源计划对计算机视觉行业做出了重大贡献。SAM对计算机视觉行业的潜在影响以及它在图像分割中的重要性是不言而喻的。

如果您有兴趣在本地环境中使用SAM,GitHub存储库文档提供了详细的入门信息。

-

代码库:https://github.com/facebookresearch/segment-anything

博客:https://ai.facebook.com/blog/segment-anything-foundation-model-image-segmentation/

论文:https://arxiv.org/abs/2304.02643

KadirNar创建了一个存储库,提供了SAM的简化(打包)版本,使我们更容易使用它:https://github.com/kadirnar/segment-anything-video

稍后,我们将使用KadirNar存储库在本地环境中使用SAM。

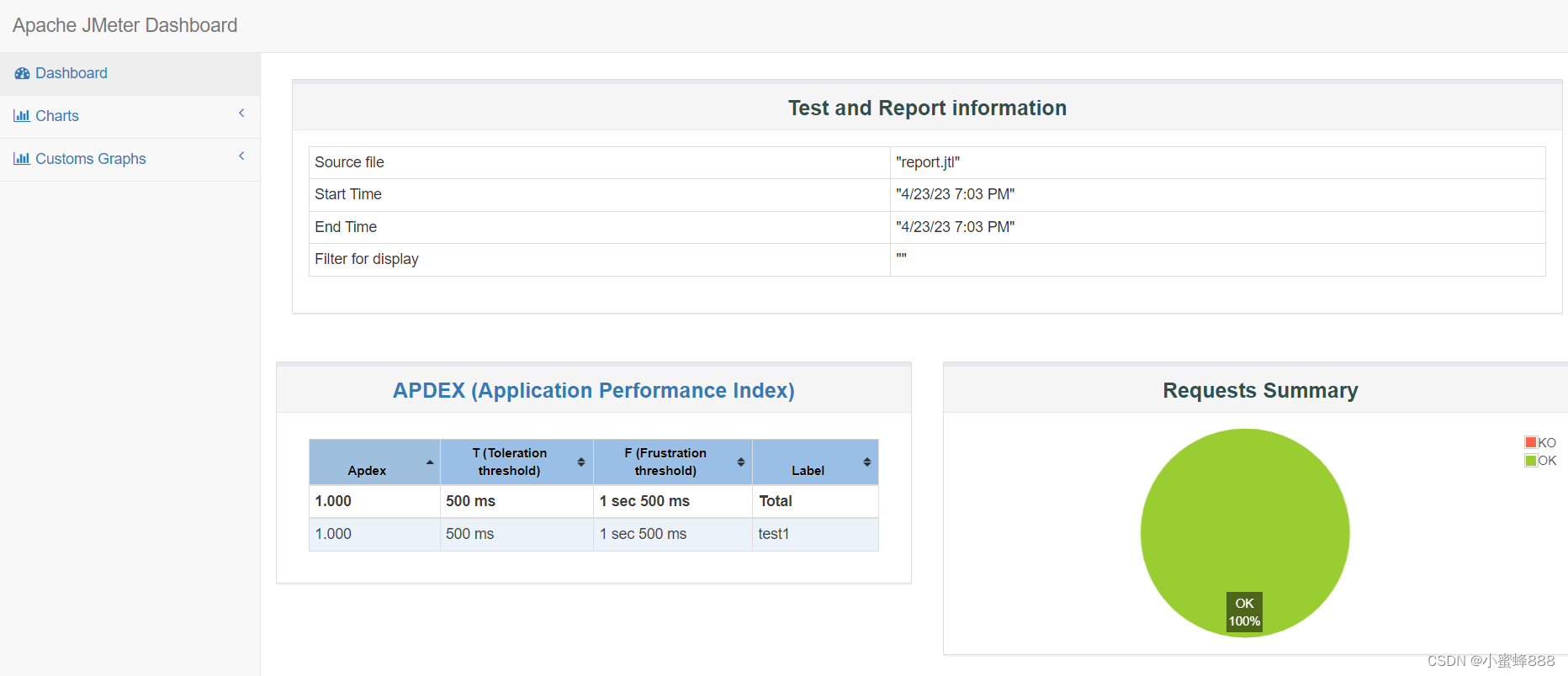

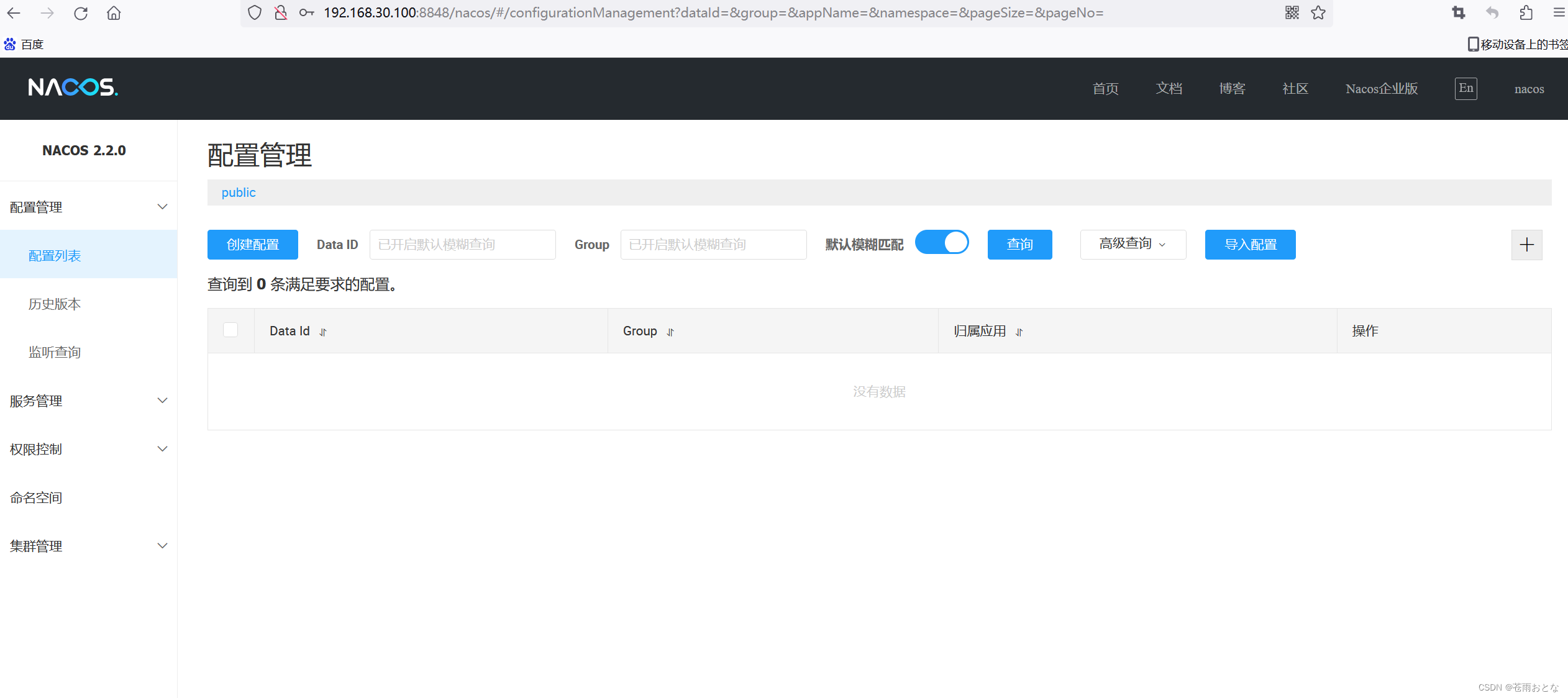

然而,在深入技术细节之前,让我们先看看Facebook提供的在线演示:https://segment-anything.com/demo。在这里,您将看到一个页面,您可以上传您喜欢的任何图像或从他们的数据集中选择。我们将选择一个随机的图像来展示演示。

一旦选择或上传了图像,SAM就会开始工作。处理图像需要几秒钟的时间,但是当它完成时,您将看到您选择的对象已经完美地分割。

下面是我们使用的图像:

让我们看看图像分割的结果:

它完美地对我们的图像进行了分割。SAM的准确性确实令人印象深刻,很容易看出为什么这个模型如此革命性。

一旦你准备好自己尝试它,GitHub仓库文档提供了如何在本地环境中使用SAM的清晰步骤。

我建议使用KadirNar仓库来尝试SAM。此外,利用Google Colab可能会更有益,因为它可以消除不同库版本可能带来的问题。

让我们看看它是如何工作的!首先,我们需要使用pip安装metaseg。

!pip install metaseg -q让我们看一下我们要处理的图像:

from IPython.display import Image

Image(“image.jpg”)输出:

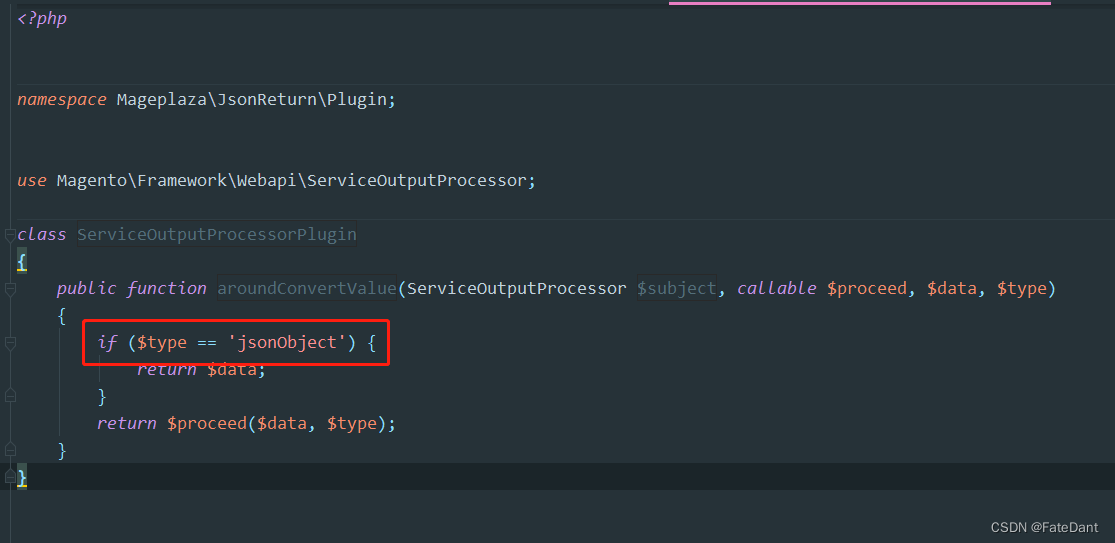

接下来,我们需要导入SegAutoMaskGenerator,它使用model_type从图像中检测分段形状。

autoseg_image = SegAutoMaskGenerator().save_image(

source="image.jpg",

model_type="vit_l", # vit_l, vit_h, vit_b

points_per_side=16,

points_per_batch=64,

min_area=0,

)参数“model_type”确定我们将使用的模型类型。

Facebook提供了三种不同的模型:

-

default或vit_h:ViT-H SAM模型

vit_l:ViT-L SAM模型

vit_b:ViT-B SAM模型

每种模型都有其优点。他们的官方博客提供了对每个模型的详细描述。

一旦运行上述代码,分割图像将保存在您的当前目录中,让我们看看结果。

from IPython.display import Image

Image(“output.jpg”)输出:

例如,在输出图像中选择任何蔬菜就是形状SAM给出的。

声明:部分内容来源于网络,仅供读者学术交流之目的。文章版权归原作者所有。如有不妥,请联系删除。

· END ·

HAPPY LIFE

![[译] 实战 React 18 中的 Suspense](https://img-blog.csdnimg.cn/img_convert/59479d008c64482f47556dd3f2924ee9.png)