本文是《Python从零开始进行AIGC大模型训练与推理》(https://blog.csdn.net/suiyingy/article/details/130169592)专栏的一部分,所述方法和步骤基本上是通用的,不局限于AIGC大模型深度学习环境。

Docker AIGC等大模型深度学习环境搭建步骤主要包含如下步骤:

- CUDA驱动更新

- Docker创建

- CUDA安装与验证

- CUDNN安装与验证

- conda Python环境安装

- ssh服务安装与配置

- 全部命令

1 CUDA驱动更新

ChatGPT、Stable Diffusion等大模型属于相对较新的模型,所以依赖的Pytorch经常为torch1.12以上版本。相应的CUDA版本则至少为CUDA 11.3,并且显卡驱动对应的CUDA版本号不能小于CUDA库的版本号。下面将以CUDA 11.8驱动安装为例。

1.1 原有版本CUDA驱动卸载

如果系统已安装低版本CUDA驱动,那么可通过如下命令进行卸载。

sudo /usr/bin/nvidia-uninstall

sudo apt-get purge nvidia*

sudo apt-get purge cuda*

sudo apt-get autoremove

sudo modprobe -r nvidia-drm#这一步不一定需要1.2 CUDA驱动下载与安装

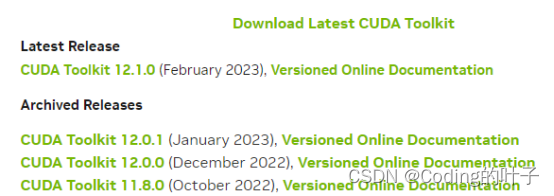

CUDA下载地址为“https://developer.nvidia.com/cuda-toolkit-archive”,页面如下所示,选择“CUDA Toolkit 11.8.0 (October 2022), Versioned Online Documentation”。

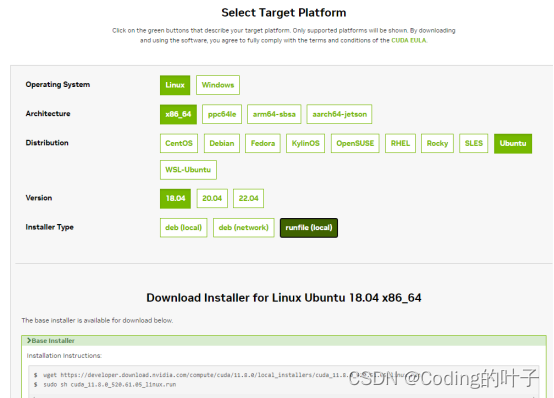

选择CUDA 11.8之后继续选择系统类型和下载文件,如下图所示。选择完成之后会显示出runfile下载地址和安装方式,即“wget https://developer.download.nvidia.com/compute/cuda/11.8.0/local_installers/cuda_11.8.0_520.61.05_linux.run”和“sudo sh cuda_11.8.0_520.61.05_linux.run”。

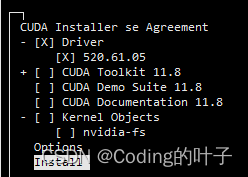

输入sudo sh cuda_11.8.0_520.61.05_linux.run安装时,在安装选项页面用回车和上下键仅选择安装驱动,不安装其他CUDA套件,如下图所示。其中,前面的“X”表示已选择的将要安装内容。

1.3 环境变量配置

待安装完成之后,采用如下命令进行环境变量设置。

export CUDA_HOME=/usr/local/cuda

export PATH=/usr/local/cuda-11.8/bin:$PATH

export LD_LIBRARY_PATH=/usr/lcoal/cuda-11.8/lib64:$LD_LIBRARY_PATH

source ~/.bashrc

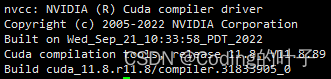

nvcc -V1.4 nvcc -V验证

运行nvcc -V命令时系统会输出如下结果,显示相应驱动版本号。如果提示“Command 'nvcc' not found, but can be installed with”,那么使用“apt install nvidia-cuda-toolkit”安装nvidia-cuda-toolkit即可。如果nvcc -V输出的版本号不对,那么请按照上一节重新设置并更新环境变量。

1.5 重启电脑

重启电脑后,运行“nvidia-smi”,如果提示“NVIDIA-SMI has failed because it couldn't communicate with the NVIDIA driver. Make sure that the latest NVIDIA driver is installed and running.”

解决方法如下:

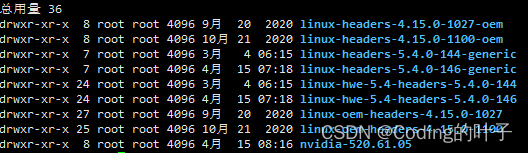

(1)先通过“ls -l /usr/src/”查看驱动版本号,如下图最后一行“nvidia -v 520.61.05”。

(2)sudo dkms install -m nvidia -v 520.61.05

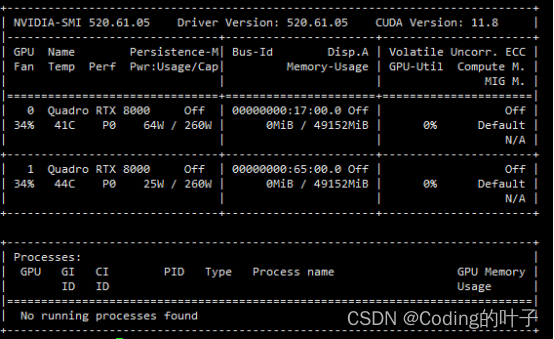

完成之后,输入nvidia-smi可查看cuda版本和GPU显存使用情况,如下图所示。

1.6 安装nvidia-container-toolkit

如果不安装nvidia-container-toolkit,那么创建docker时可能会报错“docker: Error response from daemon: could not select device driver "" with capabilities: [[gpu]].”。安装方法请参考“https://www.cnblogs.com/dan-baishucaizi/p/15102419.html”,即:

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

sudo apt-get update && sudo apt-get install -y nvidia-container-toolkit

sudo systemctl restart docker2 docker创建

docker容器是Linux下的虚拟机,并且在虚拟机下拥有root权限。这样既可以获取较高的权限,又可以避免对主机文件带来误操作。同一台主机上可以创建多个docker,并且每个docker中可安装不同版本CUDA,但是版本号不能高于主机CUDA驱动版本,否则可能会报错“CUDA driver version is insufficient for CUDA runtime version”。

2.1 docker安装

Docker命令一般需要sudo权限,即“sudo docker 命令内容”。如果系统提示没有docker命令,那么需要按照下面步骤安装docker。

# 更新

$ sudo apt-get update

# 安装最新的Docker

sudo apt-get install docker.io

# 启动

sudo systemctl enable docker

sudo systemctl start docker2.2 docker镜像

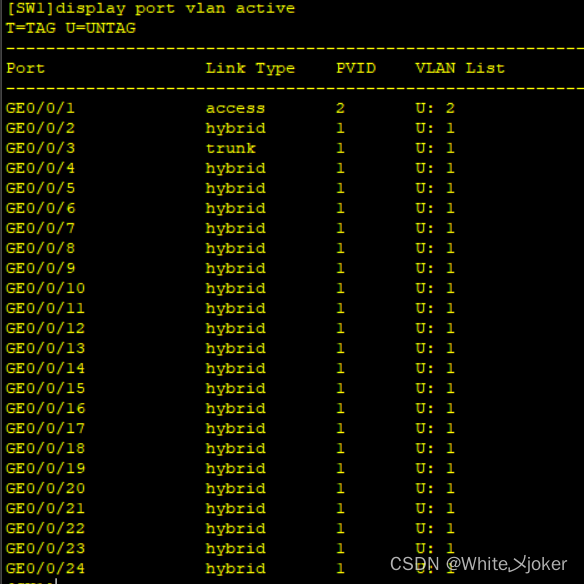

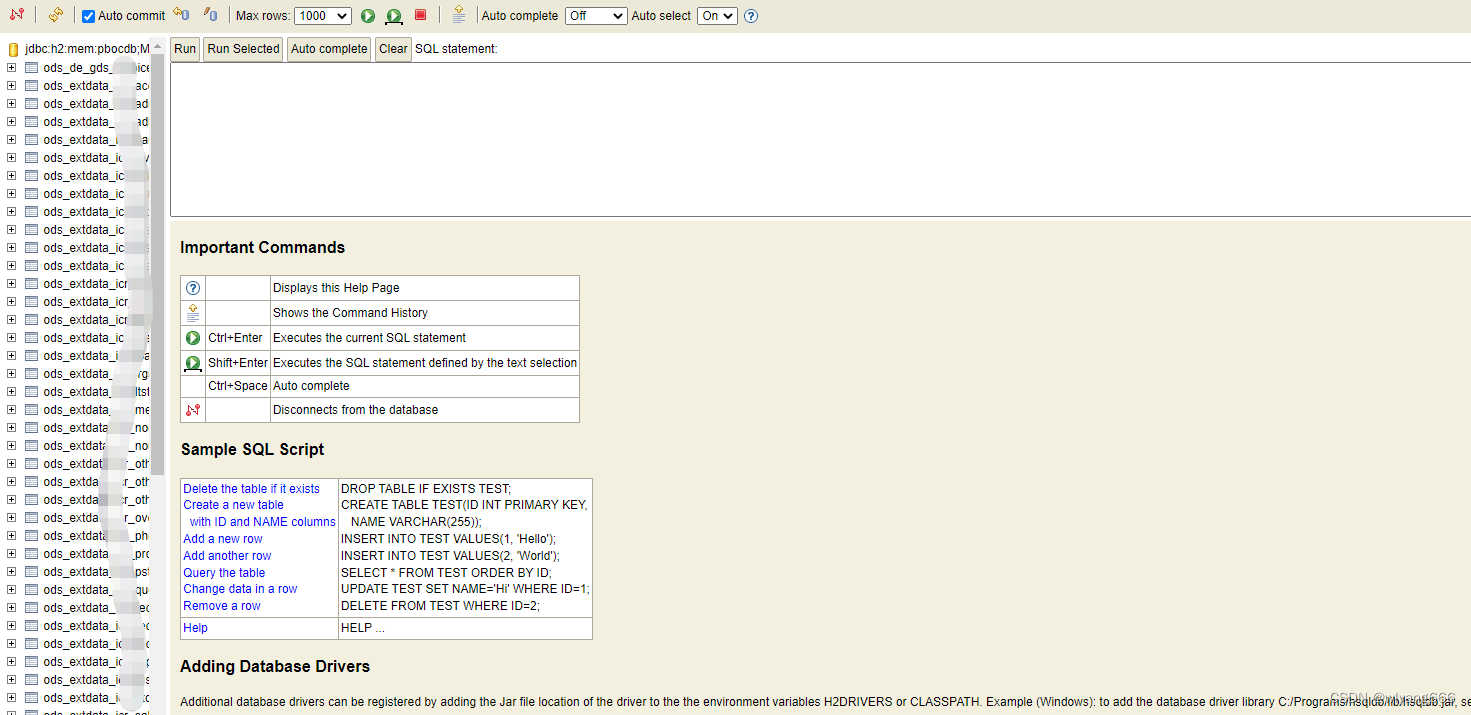

Docker查看系统镜像的方法为“docker images”,运行后会有如下页面,页面中含有镜像ID,即IMAGE ID。

![]()

我们可以通过docker pull来下载镜像,比如通过“docker pull ubuntu:18.04”下载基础的ubuntu 18.04镜像。下载完成后,可通过“docker images”命令进行查看,如上所述。

删除已有镜像的命令为“docker rmi IMAGE ID”。IMAGE ID不需要完整内容,只需输入前几个字符就可以了,例如“docker rmi 394”

2.3 docker命令

容器Container相当于是根据镜像安装的虚拟机。

(1) 我们可以使用docker images来列出本地主机上的镜像。

(2) 创建并运行docker容器:docker run -d -it -p 1088:8888 -p 1022:22 -p 1059:5900 -v /server/data:/docker/data --gpus all --shm-size="32g" ubuntu:18.04 /bin/bash

-p:docker端口映射,冒号前为主机端口号,冒号后为docker容器端口号。

-v:docker共享文件夹,冒号前为主机文件夹,冒号后为docker容器文件夹。

--gpus all:docker中可使用GPU。

--shm-size="32g":docker默认的最大内存较小,这里修改为32G内存,可根据修改自行替换为其他值。

ubuntu:18.04:镜像名称,为docker images返回中的一个,根据需要进行替换。(3) 查看docker状态:docker ps -a,可查看docker状态,以及容器ID(countainerID)。

![]()

(4) 进入docker:docker exec -it countainerID /bin/bash,countainerID一般较长,只需前几个数字就可以了,系统会自动识别,与上面删除镜像的方法类似。

(5)停止docker,docker stop countainerID。

(6)启动docker,docker start countainerID,然后运行第(4)步进入docker。

(7)删除docker,docker rm countainerID,运行前先通过第(5)步停止docker。

(8) 清除全部已停止运行的docker,docker system prune。

2.4 docker创建镜像

创建镜像是指将本地的docker环境打包成镜像,便于环境复制或部署。提交镜像的命令如下所示。

docker commit OPTIONS countainerID 自定义镜像名称:TAG说明OPTIONS说明:

(1)-a :提交的镜像作者;

(2)-c :使用Dockerfile指令来创建镜像;

(3)-m :提交时的说明文字;

(4)-p :在commit时,将容器暂停。

镜像提交示例如下:

docker commit -a "rdfast" -m "aigc base" 2c5 aigc:v12.5 docker创建与运行示例

根据前文描述,我们主要运行下面三条命令进行docker创建与运行。

docker pull ubuntu:18.04

docker run -d -it -p 1088:8888 -p 1022:22 -p 1059:5900 -v /server/data:/docker/data --gpus all --shm-size="32g" ubuntu:18.04 /bin/bash

docker exec -it countainerID /bin/bash下文各种环境的安装可以在主机上运行,也可以在docker中进行,安装步骤和方法完全一致。

3 CUDA安装与验证

ChatGPT、Stable Diffusion等大模型属于相对较新的模型,所以依赖的Pytorch经常为torch1.12以上版本。相应的CUDA版本则至少为CUDA 11.3,并且显卡驱动对应的CUDA版本号不能小于CUDA库的版本号。由于上述主机已安装CUDA 11.8驱动,docker内安装不大于11.8版本的CUDA都是可以的。下面以CUDA 11.3安装为例。

3.1 容器内基本环境安装

以上docker的容器安装了一个基础的ubuntu 18.04系统,现在需要安装一些基本环境,命令如下所示。

apt-get update

apt-get install ssh vim gcc cmake build-essential -y3.2 CUDA驱动下载与安装

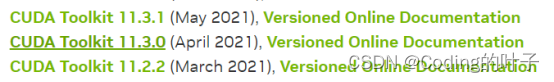

CUDA下载地址为“https://developer.nvidia.com/cuda-toolkit-archive”,页面如下所示,选择“CUDA Toolkit 11.3.0 (April 2021), Versioned Online Documentation”。

选择CUDA 11.3之后继续选择系统类型和下载文件,如下图所示。选择完成之后会显示出runfile下载地址和安装方式,即“wget https://developer.download.nvidia.com/compute/cuda/11.3.0/local_installers/cuda_11.3.0_465.19.01_linux.run”和“sudo sh cuda_11.3.0_465.19.01_linux.run”。

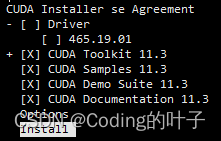

输入sh cuda_11.3.0_465.19.01_linux.run安装时,在安装选项页面用回车和上下键选择安装内容,注意不要选择驱动(驱动已经在此之前安装过了),如下图所示。其中,前面的“X”表示已选择的将要安装内容。

3.3 环境变量配置

待安装完成之后,采用如下命令进行环境变量设置。

export CUDA_HOME=/usr/local/cuda

export PATH=/usr/local/cuda-11.3/bin:$PATH

export LD_LIBRARY_PATH=/usr/lcoal/cuda-11.3/lib64:$LD_LIBRARY_PATH

source ~/.bashrc

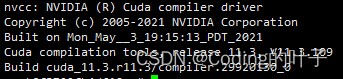

nvcc -V运行“nvcc -V”后输出如下内容。

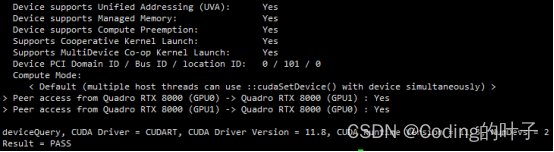

3.4 CUDA安装验证

在命令行分别输入如下内容验证CUDA是否安装成功。

(1)cd /usr/local/cuda/samples/1_Utilities/deviceQuery

(2)make

(3)./deviceQuery

运行上述命令后,终端界面会有如下输出。如果终端界面最后输出“PASS”,则表示CUDA套件已经成功安装。

如果CUDA套件版本号大于驱动版本号,则有可能提示如下错误。

cudaGetDeviceCount returned 35

-> CUDA driver version is insufficient for CUDA runtime version

Result = FAIL4 CUDNN安装与验证

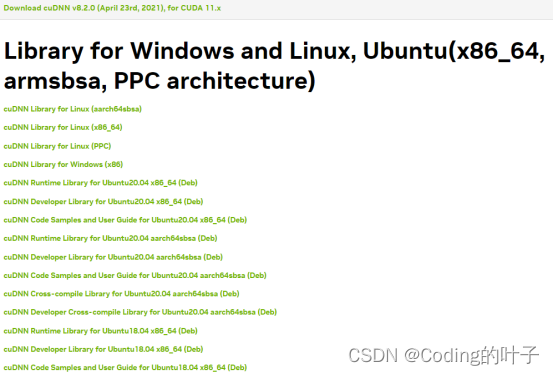

4.1 cuDNN下载

cuDNN安装文件下载官网地址为“https://developer.nvidia.com/rdp/cudnn-archive”,需要注册后才能下载。cuDNN版本依赖于CUDA架构版本,即需要与上一步安装的CUDA组件相对应。这里我们下载适合CUDA 11.3的cuDNN,即Download cuDNN v8.2.0 (April 23rd, 2021), for CUDA 11.x,并且系统版本为ubuntu 18.04(根据实际情况选择相应系统版本),如下图所示。

由于cuDNN需要注册登录账号才能下载,所以无法通过wget指令直接进行下载,需要通过浏览器页面下载对应安装文件。其中,cuDNN安装文件包括以下4个部分:

- cuDNN Library for Linux (x86_64)

- cuDNN Runtime Library for Ubuntu18.04 (Deb)

- cuDNN Developer Library for Ubuntu18.04 (Deb)

- cuDNN Code Samples and User Guide for Ubuntu18.04 (Deb)

4.2 cuDNN安装

Linux cuDNN库(cuDNN Library for Linux)是一个压缩文件,通过终端指令“tar -zxvf cudnn-11.3-linux-x64-v8.2.0.53.tgz”进行解压。cuDNN Library解压结果需要复制到CUDA安装目录,相应指令为“cp cuda/include/cudnn.h /usr/local/cuda/include/”、“cp cuda/lib64/libcudnn* /usr/local/cuda/lib64/”。复制后的库文件需进一步增加权限,其指令为“chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*”。

剩下三个Deb文件(cuDNN Runtime Library for Ubuntu18.04(Deb)、cuDNN Developer Library for Ubuntu18.04(Deb)、cuDNN Code Samples and User Guide for Ubuntu18.04(Deb))采用dpkg命令进行安装,分别输入指令“dpkg -i libcudnn8_8.2.0.53-1+cuda11.3_amd64.deb”、“dpkg -i libcudnn8-dev_8.2.0.53-1+cuda11.3_amd64.deb ”和“dpkg -i libcudnn8-samples_8.2.0.53-1+cuda11.3_amd64.deb”。

如果报如下不是软连接(not a symbolic link)的错,那么通过ln -sf命令逐一创建软连接即可。

/sbin/ldconfig.real: /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_train.so.8 is not a symbolic link

/sbin/ldconfig.real: /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_infer.so.8 is not a symbolic link

/sbin/ldconfig.real: /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn.so.8 is not a symbolic link

/sbin/ldconfig.real: /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_train.so.8 is not a symbolic link

/sbin/ldconfig.real: /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_infer.so.8 is not a symbolic link

/sbin/ldconfig.real: /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_train.so.8 is not a symbolic link

/sbin/ldconfig.real: /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_infer.so.8 is not a symbolic link解决方案如下:

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_train.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_train.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_infer.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_infer.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_train.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_train.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_infer.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_infer.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_train.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_train.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_infer.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_infer.so.84.3 cuDNN安装验证

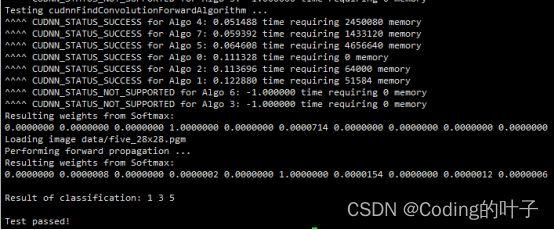

经过以上步骤,cuDNN相关文件已经全部完成安装,在命令行分别输入如下内容验证cuDNN是否安装成功。

(1)cd /usr/src/cudnn_samples_v8/mnistCUDNN/

(2)make clean && make

(3)./mnistCUDNN

运行上述命令后,终端界面会有如下输出。如果终端界面最后输出“Test passed”,则表示cuDNN套件已经成功安装。

如果提示如下错误,那么解决方法为“apt-get install libfreeimage3 libfreeimage-dev -y”。

rm -rf *orm -rf *o

rm -rf mnistCUDNN

CUDA_VERSION is 11030

Linking agains cublasLt = true

CUDA VERSION: 11030

TARGET ARCH: x86_64

HOST_ARCH: x86_64

TARGET OS: linux

SMS: 35 50 53 60 61 62 70 72 75 80 86

test.c:1:10: fatal error: FreeImage.h: No such file or directory

#include "FreeImage.h"

^~~~~~~~~~~~~

compilation terminated.

>>> WARNING - FreeImage is not set up correctly. Please ensure FreeImage is set up correctly.

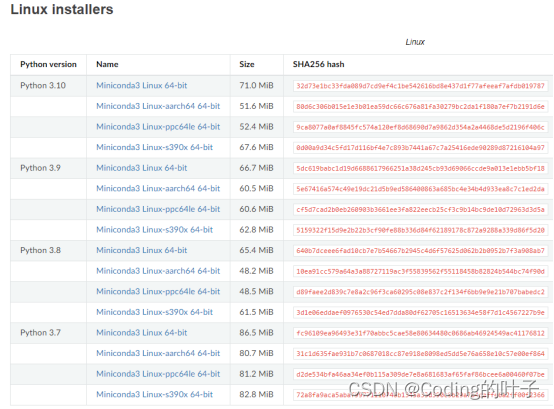

5 conda Python环境安装

5.1 Python Miniconda安装

Python环境可以通过conda进行管理,相应的安装软件有Anaconda和Miniconda。相比之下,Miniconda是一款小巧的Python环境管理工具,安装包大约只有50MB。就管理Python环境而言,Miniconda和Anaconda的使用方式几乎没有任何区别。Miniconda安装文件的下载地址为“https://docs.conda.io/en/latest/miniconda.html”。

这里选择python 3.8版本,wget下载方式为“wget https://repo.anaconda.com/miniconda/Miniconda3-py38_23.1.0-1-Linux-x86_64.sh”。安装步骤如下,安装过程需要选择“yes or no”的地方均输入“yes”。

bash Miniconda3-py38_23.1.0-1-Linux-x86_64.sh

source ~/.bashrc5.2 conda使用

(1)查看安装包:conda list

(2)查看虚拟环境:conda env list

(3)创建虚拟环境:conda create -n env_name python=3.9

(4)安装包:conda install -n env_name [package]

(5)激活环境:conda activate env_name

5.3 jupyter notebook 安装

jupyter notebook是一种基于web的Python开发环境,可通过默认可“IP:8888”或“127.0.0.1:8888”或“localhost:8888”。如果docker创建时指定了主机端口映射,如“-p 1088:8888”,那么可将端口号替换成1088进行访问。主机允许端口号防火墙的命令为“sudo ufw allow端口号”。安装步骤及配置过程如下:

(1) 安装命令为“conda install jupyter notebook”。

(2) 生成配置文件,jupyter notebook --generate-config,运行该命令后会在根目录下生成配置文件,如“/root/.jupyter/jupyter_notebook_config.py”。修改配置文件中如下内容。端口号也可以在配置文件中进行修改。

c.NotebookApp.allow_remote_access = True

c.NotebookApp.allow_root = True

c.NotebookApp.ip = '0.0.0.0'(3) 设置登录密码,jupyter notebook password。

(4) 运行命令为“jupyter notebook”,但是关闭终端时会中断运行,可以采用nohup命令来保持运行,即“nohup jupyter notebook &”。

6 ssh服务安装与配置

以上docker 容器是通过命令“docker exec -it containerID /bin/bash”进入的,配置ssh服务后,docker也可以通过ssh直接远程访问。

- 安装ssh服务:apt-get update,apt-get install ssh -y。

- 启动服务:service ssh start。

- 关闭服务:service ssh stop。

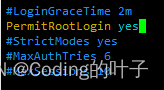

- 注意事项:将/etc/ssh/sshd_config文件中PermitRootLogin 设为yes,否则有可能出现权限问题。

- 重启服务:service ssh restart。

- 查看服务是否正常运行:service ssh status。

- 为系统设置密码,命令为“passwd”。

这样就可以通过ssh访问docker了,如果docker创建时设置了1022端口映射,那么即可通过该端口进行ssh连接。

7 全部命令

docker pull ubuntu:18.04

docker run -d -it -p 1088:8888 -p 1022:22 -p 1059:5900 -v /server/data:/docker/data --gpus all --shm-size="32g" ubuntu:18.04 /bin/bash

docker exec -it containerID /bin/bash

apt-get update

apt-get install ssh vim gcc cmake build-essential -y

wget https://developer.download.nvidia.com/compute/cuda/11.3.0/local_installers/cuda_11.3.0_465.19.01_linux.run

sh cuda_11.3.0_465.19.01_linux.run

export CUDA_HOME=/usr/local/cuda

export PATH=/usr/local/cuda-11.3/bin:$PATH

export LD_LIBRARY_PATH=/usr/lcoal/cuda-11.3/lib64:$LD_LIBRARY_PATH

source ~/.bashrc

nvcc -V

cd /usr/local/cuda/samples/1_Utilities/deviceQuery

make

./deviceQuery

tar -zxvf cudnn-11.3-linux-x64-v8.2.0.53.tgz

cp cuda/include/cudnn.h /usr/local/cuda/include/

cp cuda/lib64/libcudnn* /usr/local/cuda/lib64/

chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_train.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_train.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_infer.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_infer.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_train.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_train.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_infer.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_ops_infer.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_train.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_cnn_train.so.8

ln -sf /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_infer.so.8.2.0 /usr/local/cuda-11.3/targets/x86_64-linux/lib/libcudnn_adv_infer.so.8

dpkg -i libcudnn8_8.2.0.53-1+cuda11.3_amd64.deb

dpkg -i libcudnn8-dev_8.2.0.53-1+cuda11.3_amd64.deb

dpkg -i libcudnn8-samples_8.2.0.53-1+cuda11.3_amd64.deb

apt-get install libfreeimage3 libfreeimage-dev -y

cd /usr/src/cudnn_samples_v8/mnistCUDNN/

make clean && make

./mnistCUDNN

wget https://repo.anaconda.com/miniconda/Miniconda3-py38_23.1.0-1-Linux-x86_64.sh

bash Miniconda3-py38_23.1.0-1-Linux-x86_64.sh

source ~/.bashrc

conda install jupyter notebook

jupyter notebook --generate-config

vi /root/.jupyter/jupyter_notebook_config.py

c.NotebookApp.allow_remote_access = True

c.NotebookApp.allow_root = True

c.NotebookApp.ip = '0.0.0.0'

jupyter notebook password

nohup jupyter notebook &

apt-get update

apt-get install ssh -y

service ssh start

service ssh stop

vi /etc/ssh/sshd_config

PermitRootLogin yes

service ssh restart

service ssh status

passwd