基于 Scrapy框架实现数据持久化

前言

本文中介绍 如何基于 Scrapy 框架实现数据持久化,包括 Scrapy 数据持久化到 MySQL 数据库、MangoDB数据库和本地 csv 文件、json 文件。

正文

1、Scrapy数据持久化到MySQL数据库

-

在 settings.py 中定义 MySQL 相关变量

# 定义MySQL数据库的相关变量 MYSQL_HOST = 'xxxxxxxxx' MYSQL_USER = 'xxxx' MYSQL_PWD = 'xxxxxx' MYSQL_DB = 'xxxxx' CHARSET = 'utf8' -

pipelines.py 中导入 settings 来创建数据库连接并处理数据

import pymysql from .settings import * # 管道2:把数据存入Mysql数据库 # 提前建库建表 # create database cardb charset utf8; # use cardb; # create table cattab( # name varchar(200), # price varchar(100), # link varchar(300) # )charset=utf8; class CarMysqlPipeline(object): def __init__(self): self.db = None self.cur = None def open_spider(self, spider): """ 爬虫程序开始时,只执行一次,一般用于数据库的连接 :param spider: :return: """ self.db = pymysql.connect(host=MYSQL_HOST, user=MYSQL_USER, password=MYSQL_PWD, database=MYSQL_DB, charset=CHARSET) # 连接数据库 self.cur = self.db.cursor() # 创建游标对象 def process_item(self, item, spider): ins = 'insert into cartab values(%s,%s,%s)' li = [ item["name"].strip(), item["price"].strip(), item["link"].strip() ] self.cur.execute(ins, li) self.db.commit() # 提交到数据库执行 # 只做插入数据操作 return item def close_spider(self, spider): """ 爬虫程序结束时,只执行一次,一般用于数据库的断开 :param spider: :return: """ self.cur.close() self.db.close() -

settings.py 中添加管道

# 开启管道 ITEM_PIPELINES = { # 项目目录名.模块名.类名:优先级(1-1000不等) "CarSpider.pipelines.CarspiderPipeline": 300, "CarSpider.pipelines.CarMysqlPipeline": 400 }

2、Scrapy数据持久化到MangoDB数据库

-

在 settings.py 中定义 MangoDB 相关变量

# 定义MangoDB相关变量 MANGO_HOST = 'xxxxxxxx' MANGO_PORT = 'xxxxx' MANGO_DB = 'xxxxx' MANGO_SET = 'carset' -

pipelines.py 中导入 settings 来创建数据库连接并处理数据

# 管道3:存入MongoDB数据库管道 import pymongo from .settings import * class CarMangoPipeline(object): def __init__(self): self.conn = None self.db = None self.myset = None def open_spider(self, spider): """ 连接MangoDB数据库 :param spider: :return: """ self.conn = pymongo.MongoClient(MYSQL_HOST, MANGO_PORT) self.db = self.conn[MANGO_DB] self.myset = self.dbp[MANGO_SET] # 集合 def process_item(self, item, spider): d = dict(item) self.myset.insert_one(d) # 只做插入数据操作 return item -

settings.py 中添加管道

# Configure item pipelines # See https://docs.scrapy.org/en/latest/topics/item-pipeline.html # 开启管道 ITEM_PIPELINES = { # 项目目录名.模块名.类名:优先级(1-1000不等) "CarSpider.pipelines.CarspiderPipeline": 300, "CarSpider.pipelines.CarMangoPipeline": 400 }

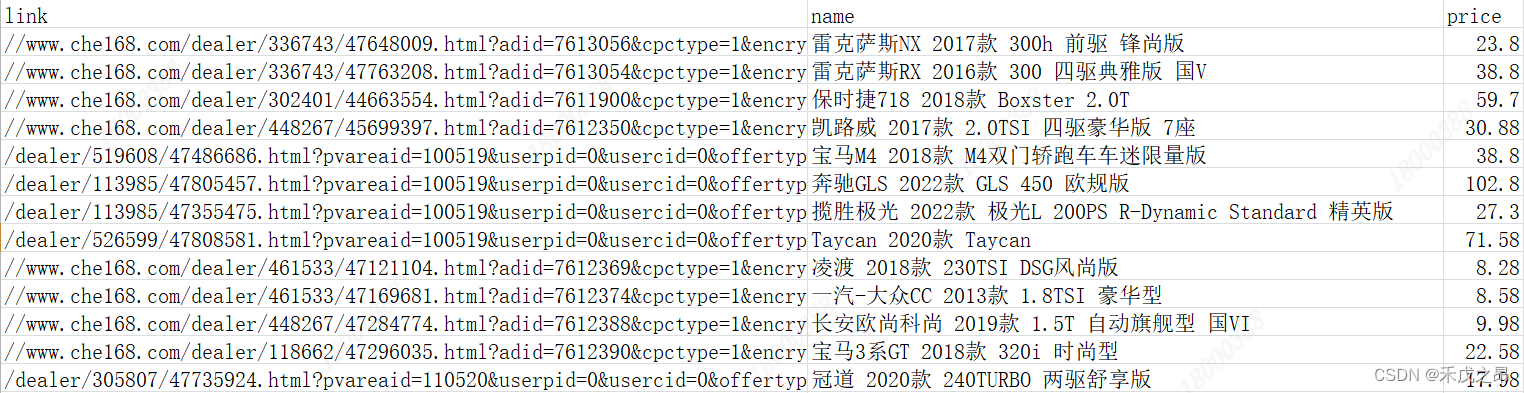

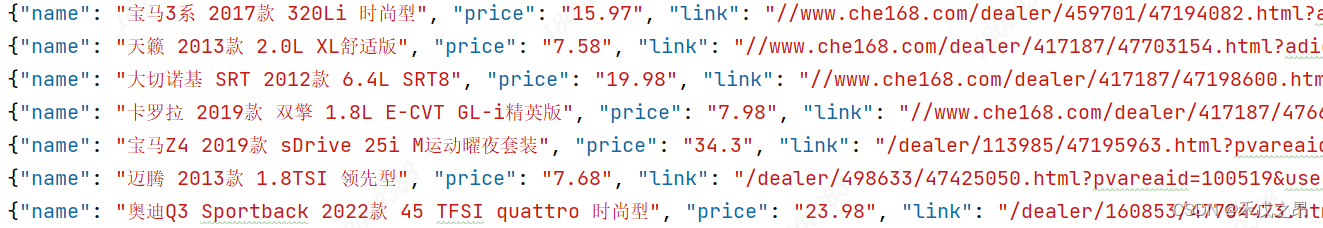

3、将数据存入本地的csv文件、json文件中

将数据存入本地的csv文件、json文件中可以直接在执行语句中添加

-

存入本地的 csv 文件:

scrapy crawl 爬虫文件名 -o 爬虫文件名.csvfrom scrapy import cmdline cmdline.execute('scrapy crawl car -o car.csv'.split()) # -o car.json : 保存json文件 # -o car.csv : 保存csv文件

-

针对 csv 文件设置导出编码:settings.py文件中添加:

FEED_EXPORT_ENCODING = "gb18030" -

存入本地的 json文件:

scrapy crawl 爬虫文件名 -o 爬虫文件名.jsonfrom scrapy import cmdline cmdline.execute('scrapy crawl car -o car.json'.split()) # -o car.json : 保存json文件 # -o car.csv : 保存csv文件

-

针对json文件设置导出编码:settings.py文件中添加:

FEED_EXPORT_ENCODING = "utf-8"

![[Java]面向对象高级篇](https://img-blog.csdnimg.cn/fdacd94b6b564c7d8a7c7a8df5f933e1.png)