一、前言

一开始用ffmpeg做的是视频流的解析,后面增加了本地视频文件的支持,到后面发现ffmpeg也是支持本地摄像头设备的,只要是原则上打通的比如win系统上相机程序、linux上茄子程序可以正常打开就表示打通,整个解码显示过程完全一样,就是打开的时候要传入设备信息,而且参数那边可以指定分辨率和帧率等,本地摄像机一般会支持多个分辨率,用户需要哪种分辨率都可以指定该分辨率进行采集。

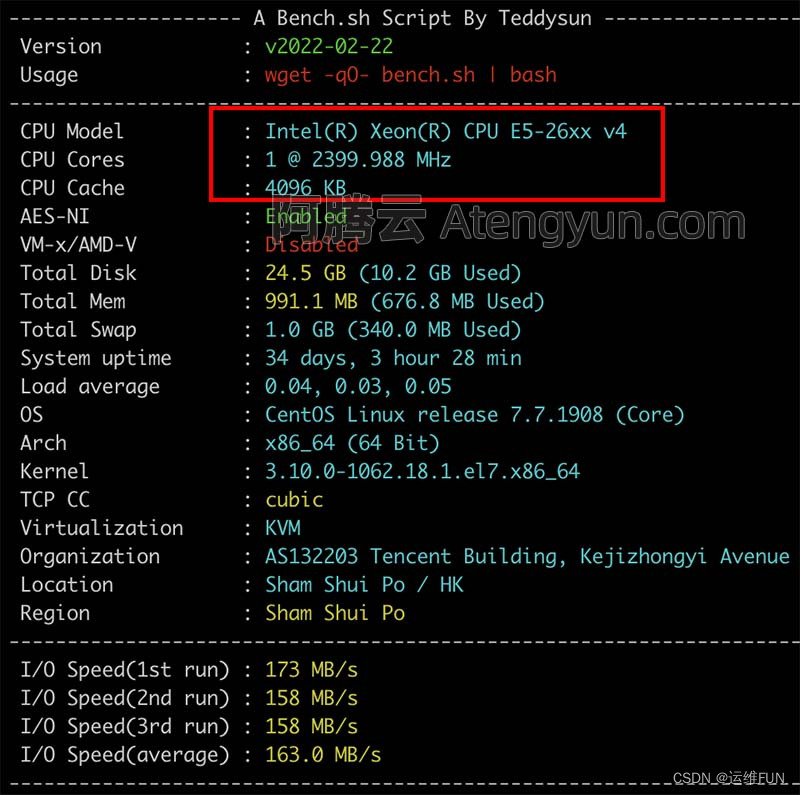

这里要说的一个小插曲就是在linux上测试这个功能的时候,发现编译期间就失败了,这就奇怪了,后面发现是静态库的原因,为了偷懒,一开始编译的ffmpeg静态库,当换成动态库的方式以后,一步跑通不要太完美,完美使用,所以如果有加载本地摄像头设备的需求的时候,尽量用动态库的方式。一鼓作气将代码移植到嵌入式linux板子上,完美,居然也可以,而且实时性挺好,可能内置了部分缓存的原因,比自己用v4l2的方式更流畅一些。

由于本地摄像头设备采集回来的数据默认的yuv422格式,显示数据那边默认是yuv420格式,当然改成绘制yuv422也是可以的,但是有需要更改绘制代码,而且存储那边也要做特殊处理,所以考虑再三决定从源头做转换,用sws_scale转换各种格式都非常方便,本来ffmpeg采集这边就需要将非yuv420格式转到yuv420格式。

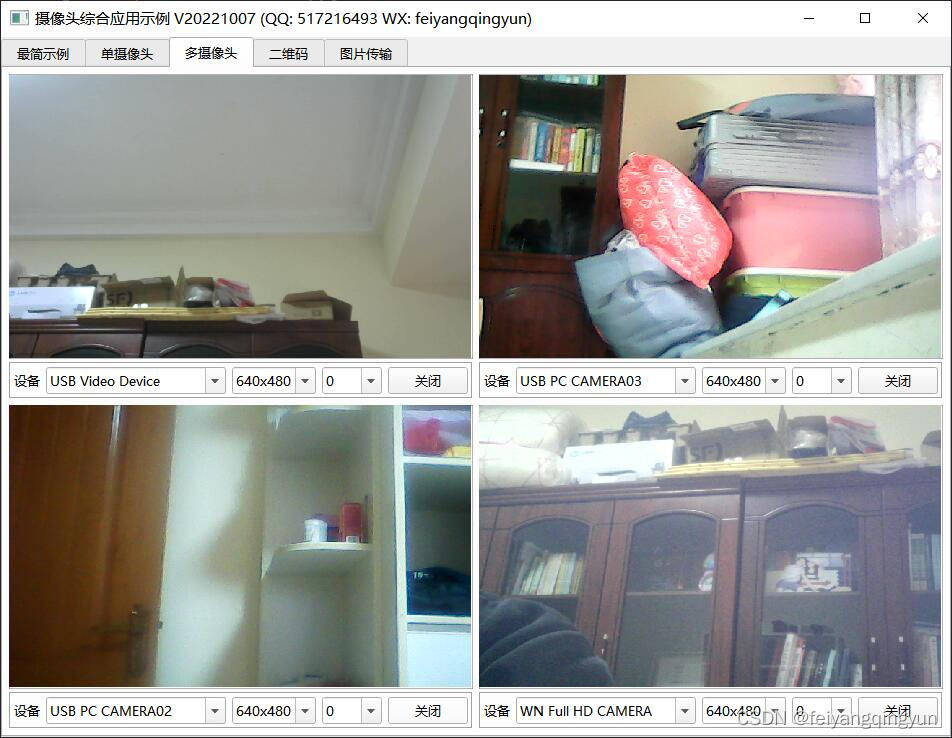

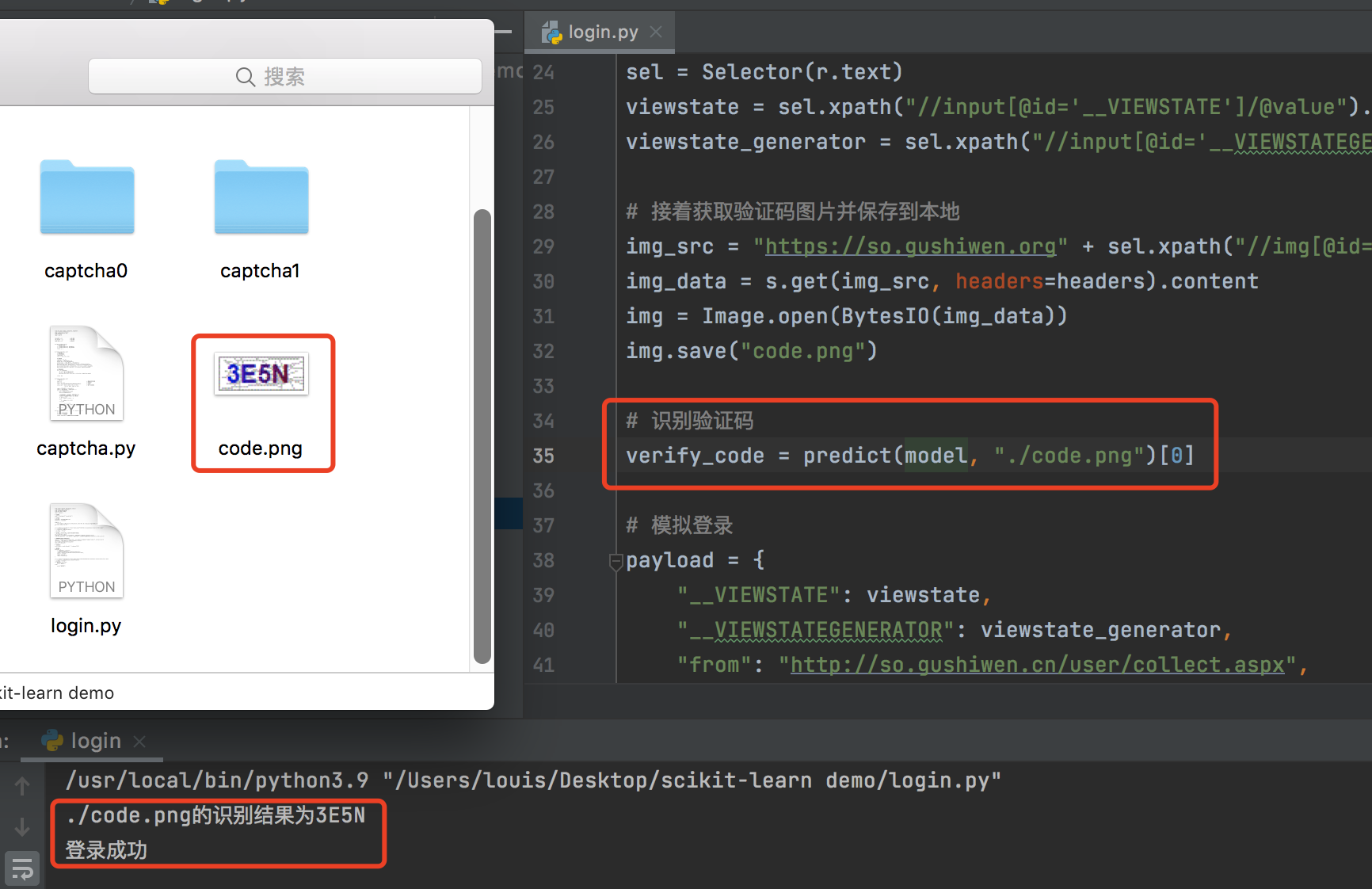

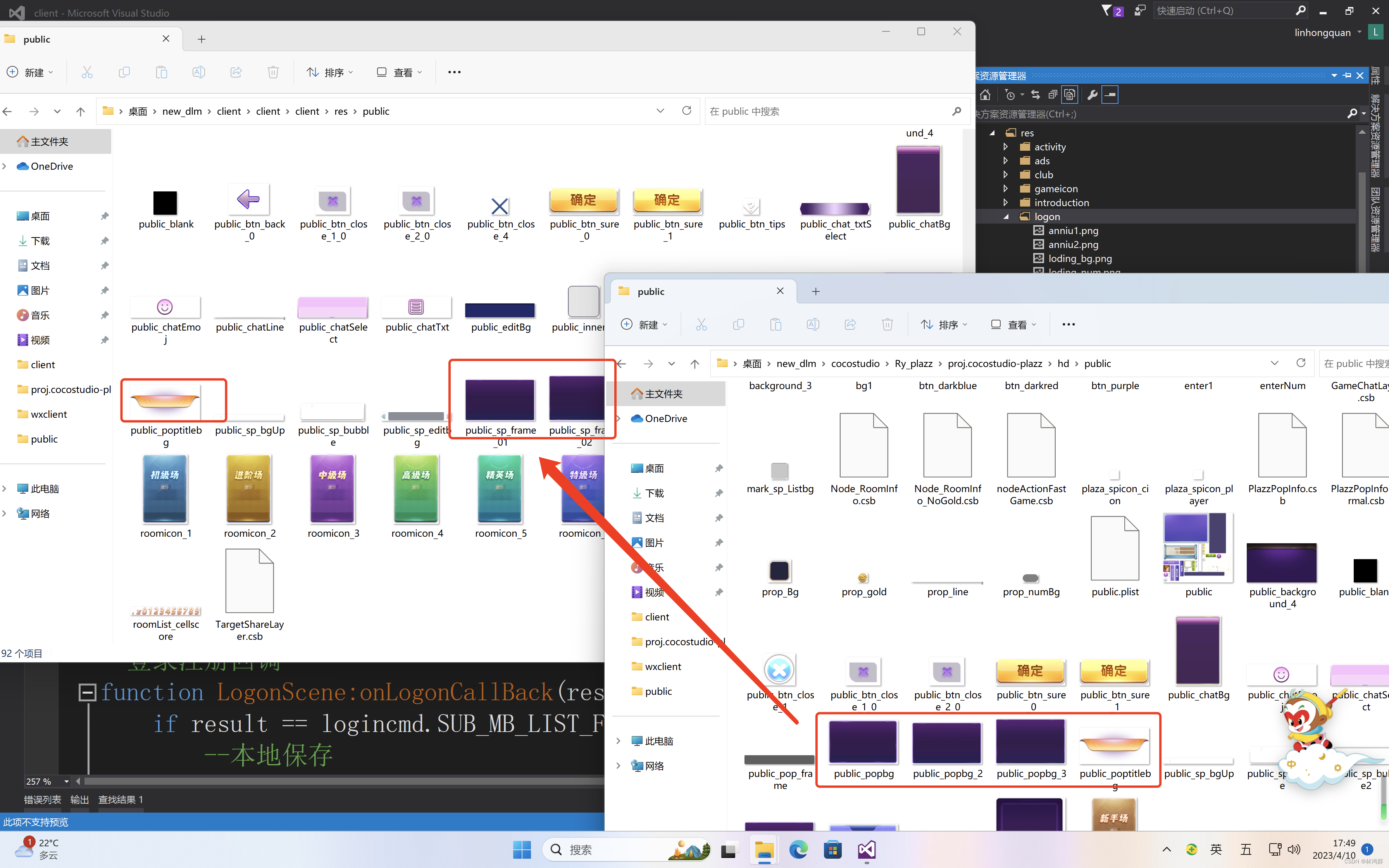

二、效果图