如何能基于prompt tuning v2训练好一个垂直领域的chatglm-6b

首先先抛出一个问题,是不是所有的文本生成数据集都适合用chatglm 6B的模型进行微调。那我们今天找到了三个数据集,分别为百科数据集、法律问答数据集、论文题目与摘要数据集、专利名称与专利摘要数据集。

官方的广告数据集是如下结构的

{

"content": "类型#上衣*版型#宽松*版型#显瘦*图案#线条*衣样式#衬衫*衣袖型#泡泡袖*衣款式#抽绳",

"summary": "这件衬衫的款式非常的宽松,利落的线条可以很好的隐藏身材上的小缺点,穿在身上有着很好的显瘦效果。领口装饰了一个可爱的抽绳,漂亮的绳结展现出了十足的个性,配合时尚的泡泡袖型,尽显女性甜美可爱的气息。"

}

官方的多轮对话数据集是如下结构的

{

"prompt": "是的。上下水管都好的",

"response": "那就要检查线路了,一般风扇继电器是由电脑控制吸合的,如果电路存在断路,或者电脑坏了的话会出现继电器不吸合的情况!",

"history": [

[

"长城h3风扇不转。继电器好的。保险丝好的传感器新的风扇也新的这是为什么。就是继电器缺一个信号线",

"用电脑能读数据流吗?水温多少"

],

[

"95",

"上下水管温差怎么样啊?空气是不是都排干净了呢?"

]

]

}

今天的所有实验都是探索单轮生成chatglm-6B上的适配性。

ptuning chatglm 6B中有两个数据集作为标准的官方微调数据集案例

我们看一下ptuning chatglm 6B中的启动参数有哪些。

PRE_SEQ_LEN=128

LR=2e-2

CUDA_VISIBLE_DEVICES=0 python3 main.py \

--do_train \

--do_eval \

--train_file AdvertiseGen/patent_train.32.128.512.json \

--validation_file AdvertiseGen/patent_dev.32.128.512.json \

--prompt_column content \

--response_column summary \

--overwrite_cache \

--model_name_or_path THUDM/chatglm-6b \

--output_dir output/patent_dev-chatglm-6b-pt-$PRE_SEQ_LEN-$LR \

--overwrite_output_dir \

--max_source_length 128 \

--max_target_length 512 \

--per_device_train_batch_size 4 \

--per_device_eval_batch_size 1 \

--gradient_accumulation_steps 16 \

--predict_with_generate \

--max_steps 3000 \

--logging_steps 10 \

--save_steps 1000 \

--learning_rate $LR \

--fp16 False\

--pre_seq_len $PRE_SEQ_LEN

PRE_SEQ_LEN 预序列长度

LR 学习率

do_train 是否进行训练

do_eval 是否进行预测

train_file 训练文件相对地址

validation_file 验证文件相对地址

prompt_column prompt 提示信息字段

response_column 响应信息字段

overwrite_cache 重写数据集缓存。

model_name_or_path 模型名称或模型地址

output_dir 训练好的模型保存的地址

per_device_train_batch_size 每个设备上的训练批次大小 在实际的训练过程中3090显卡可以把这个参数开到4。

模型的指令输入应该如何拼接才可以让chatglm更好的服务。

train.sh 中的 PRE_SEQ_LEN 和 LR 分别是 soft prompt 长度和训练的学习率,可以进行调节以取得最佳的效果。P-Tuning-v2 方法会冻结全部的模型参数,可通过调整 quantization_bit 来被原始模型的量化等级,不加此选项则为 FP16 精度加载。 在默认配置 quantization_bit=4、per_device_train_batch_size=1、gradient_accumulation_steps=16 下,INT4 的模型参数被冻结,一次训练迭代会以 1 的批处理大小进行 16 次累加的前后向传播,等效为 16 的总批处理大小,此时最低只需 6.7G 显存。若想在同等批处理大小下提升训练效率,可在二者乘积不变的情况下,加大 per_device_train_batch_size 的值,但也会带来更多的显存消耗,请根据实际情况酌情调整。

调整batch size后的学习率应该如何调整。

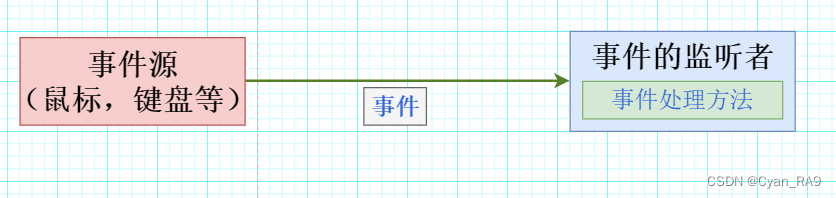

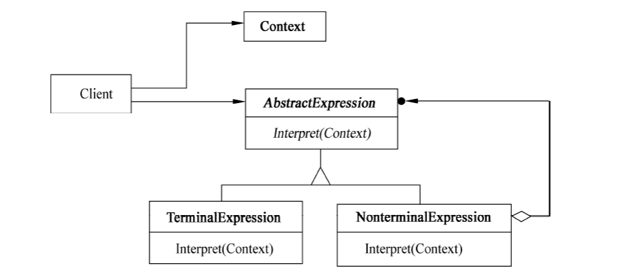

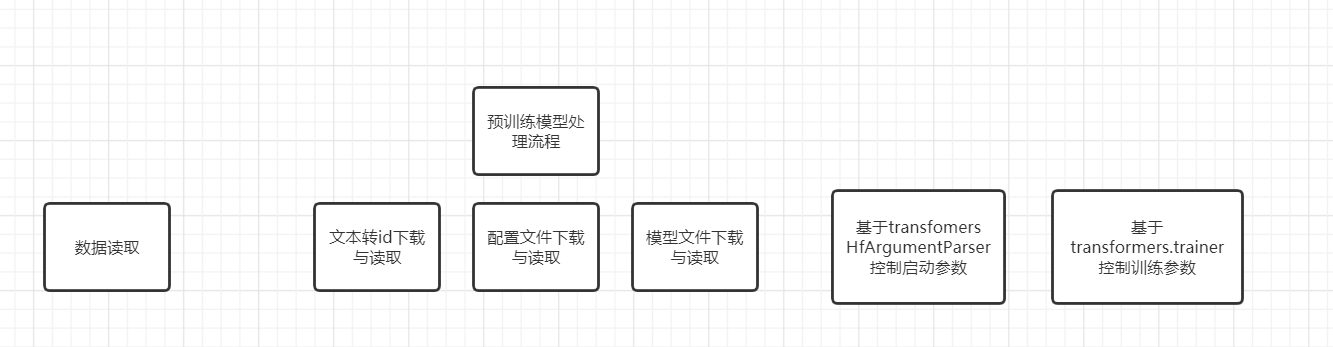

chatglm的工作流程

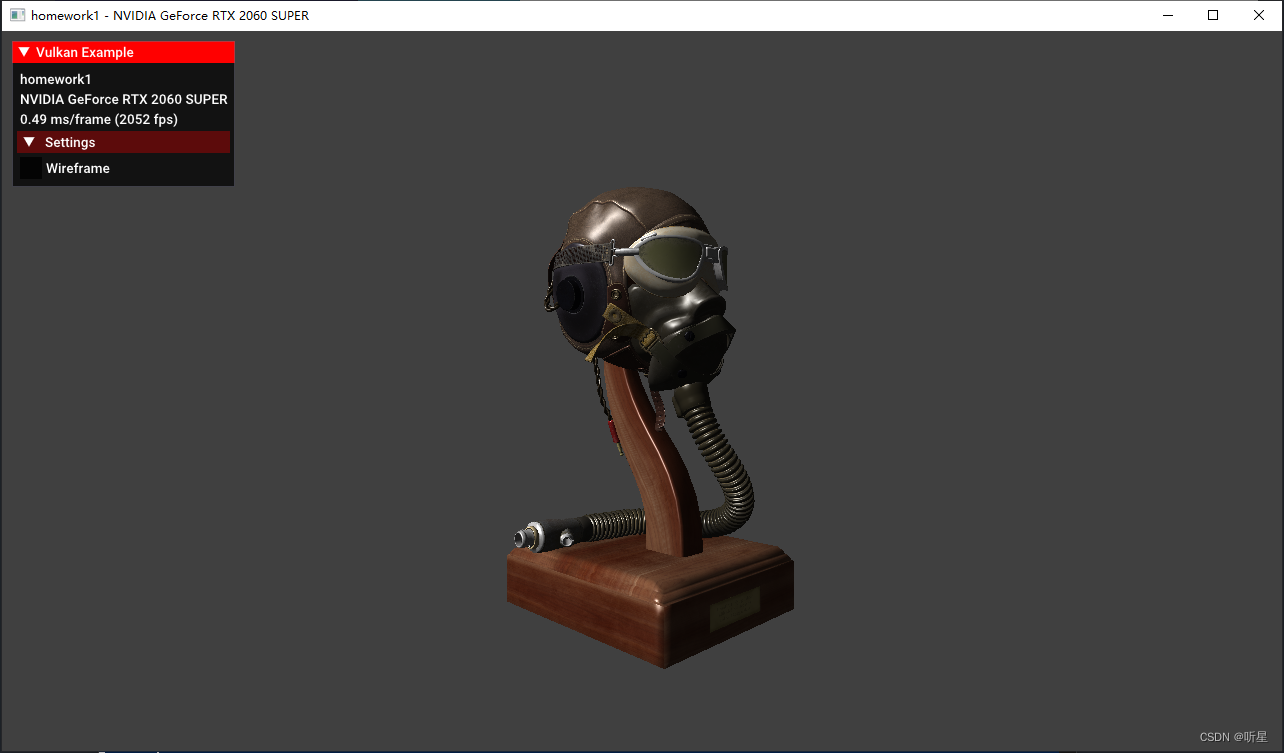

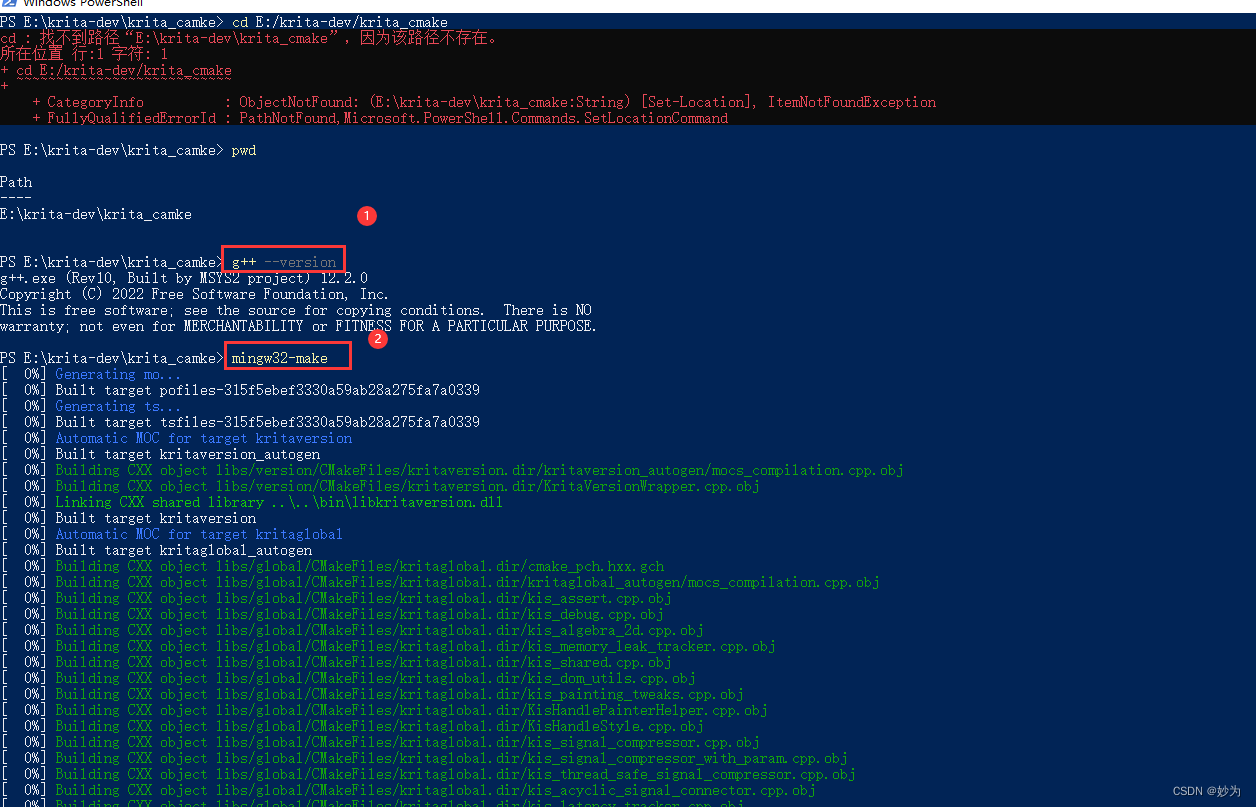

基于openbayes的3090单卡,prompt tuning v2 训练chatglm 6B模型。

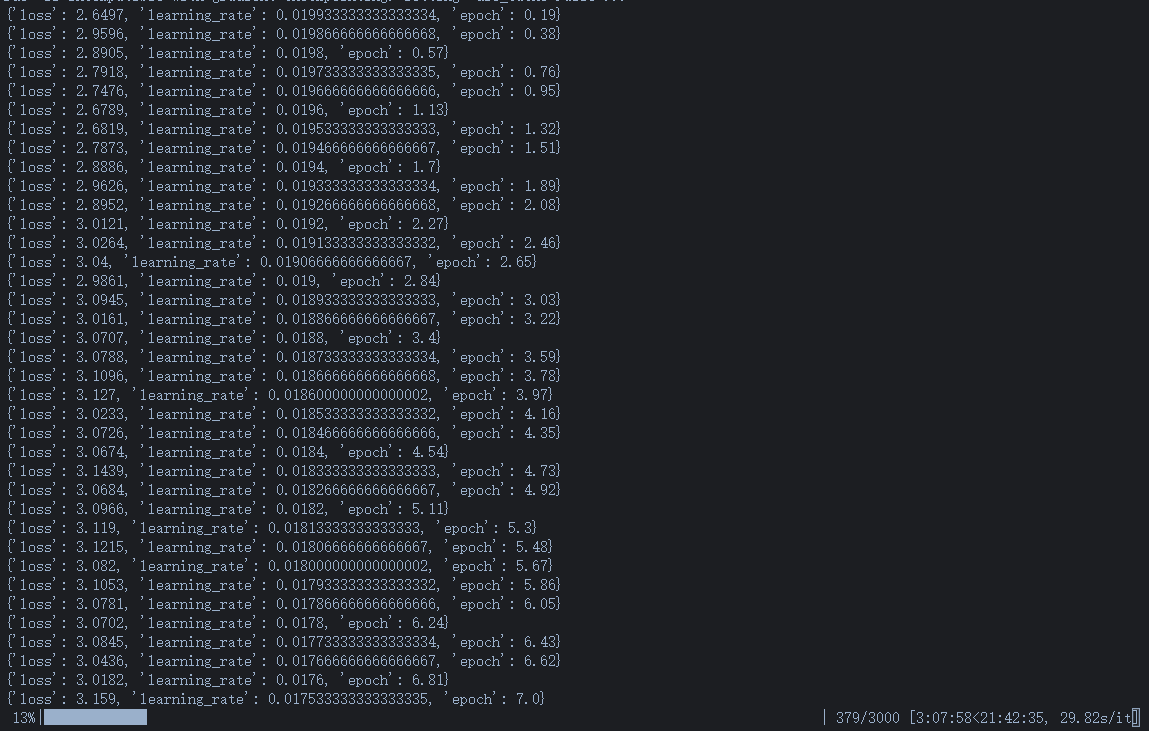

训练专利prompt的数据的时候基础训练参数 修改了 per_device_train_batch_size 为 4。

***** Running training *****

Num examples = 3384

Num Epochs = 58

Instantaneous batch size per device = 4

Total train batch size (w. parallel, distributed & accumulation) = 64

Gradient Accumulation steps = 16

Total optimization steps = 3000

Number of trainable parameters = 29360128

其中每一个设备的batch size设定为4,总共训练的批次大小是64。这里的总批次是因为采用了梯度累计策略,所以总训练批次大小是64。那如果是两张卡的话这里是128。

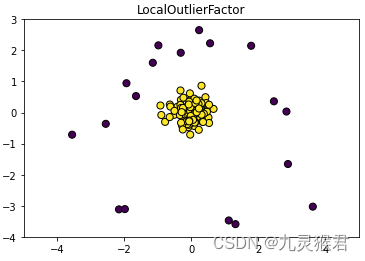

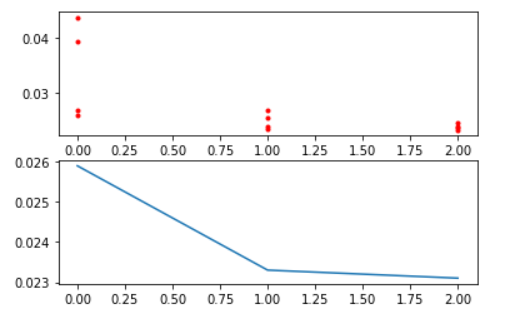

训练专利prompt的数据集的时候的损失表现

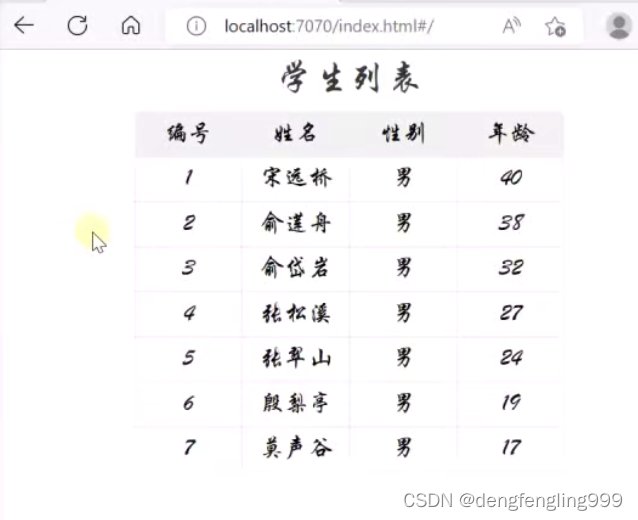

中国大百科数据集

PyTorch DataParallel和DDP是PyTorch提供的两个数据并行扩展。 1. PyTorch Data Parallel PyTorch Data Parallel是PyTorch框架中的一个重要组成部分,它提供了一种高效的并行计算机制,使得在GPU上运行Torch模型变得更加容易。Data Parallel使用GPU上的多线程来并行计算多个输入特征,从而提高计算效率。 Data Parallel的实现方式包括: - Data parallel器:负责将输入特征按照一定的规则划分成一组数据 parallel,例如按照相似度、长度、形状等特征进行划分。 - 并行化操作:将数据 parallel划分为多个并行块,并执行相应的操作。 - 数据预处理:对数据parallel块进行一些预处理,例如合并、排序、归一化等操作。 使用Data Parallel可以大大简化GPU编程,并提高模型的训练效率。 2. DDP 官方建议用新的DDP,采用all-reduce算法,本来设计主要是为了多机多卡使用,但是单机上也能用,使用方法如下:

初始化使用nccl后端

torch.distributed.init_process_group(backend="nccl")

模型并行化

model=torch.nn.parallel.DistributedDataParallel(model)

需要注意的是:DDP并不会自动shard数据 1. 如果自己写数据流,得根据torch.distributed.get_rank()去shard数据,获取自己应用的一份 2. 如果用Dataset API,则需要在定义Dataloader的时候用DistributedSampler 去shard:

sampler = DistributedSampler(dataset) # 这个sampler会自动分配数据到各个gpu上

DataLoader(dataset, batch_size=batch_size, sampler=sampler)

在chatglm 6B中训练的并行是基于transformers架构实现的

from transformers.trainer import Trainer

trainer默认是用torch.distributed的api来做多卡训练的,因此可以直接支持多机多卡,单机多卡,单机单卡。

目前autodl没有多卡资源,所以也没办法验证多卡这个如何可以更高效率的执行出来有效的结果。

不同的云计算平台

autodl 模型下载速度比较慢 可以通过在新建环境时候选择合适的thuglm镜像来减少模型下载上所需要的时间。实例初始化空间为20GB系统空间+50GB数据空间,数据空间可以扩容。

openbayes 模型下载速度比较快,环境每次重启的时候都要执行一遍pip install安装步骤。启动训练是需要在命令行中加上 --fp16 False,不然会报错。实例硬盘上限只有50GB,需要注意保存策略。存储空间费用如下。

用我的专用邀请链接,注册 OpenBayes,双方各获得 60 分钟 RTX 3090 使用时长,支持累积,永久有效:

注册 - OpenBayes

要不是autodl没有卡,我也不会来openbayes租用显卡。最吐槽的问题就是硬盘空间问题。作为个人研究者还要为硬盘按月付费实在是让人不舒服。目前我付费了100GB的硬盘。一个月80多块。