Transformer-XL:打破序列长度限制的Transformer模型

在自然语言处理领域中,序列模型是至关重要的一类模型,但是它们受到了序列长度的限制。在传统的循环神经网络(RNN)模型中,由于梯度消失或梯度爆炸的问题,只能处理较短的序列。为了克服这个问题,Attention机制被引入到了序列模型中,其中Transformer是最著名的例子。

但是,即使是Transformer,它也有一个长度限制。由于输入和输出是一次性给出的,因此Transformer不能处理超过固定长度的序列。为了克服这个问题,Dai等人提出了Transformer-XL,它能够处理超过固定长度的序列,并且能够捕捉更长期的依赖关系。

1. Transformer-XL介绍

Transformer-XL是由Dai等人在2019年提出的,是Transformer模型的一种扩展。Transformer-XL通过使用可重复的缓存机制来解决Transformer模型的长度限制问题。它使用了两种类型的缓存:前向缓存和后向缓存。

前向缓存是指在当前时间步之前的所有时间步的表示形式。它可以被看作是一个保存在模型中的记忆,包含了之前所有时间步的信息。后向缓存是指在当前时间步之后的所有时间步的表示形式。这个缓存是由前向缓存生成的,因此它只能在前向传递后被使用。使用这两种缓存,Transformer-XL能够从之前的计算中获取上下文,并将其用于当前的计算。

具体来说,Transformer-XL使用了一种称为相对位置编码的技术来表示缓存。相对位置编码是指根据缓存中的位置来编码每个时间步的表示形式。相对位置编码不仅考虑了时间步之间的绝对位置,还考虑了它们之间的相对位置。这种编码方式可以帮助Transformer-XL捕捉更长期的依赖关系。

在前向传递期间,Transformer-XL使用前向缓存来计算当前时间步的表示形式。在后向传递期间,它使用后向缓存来计算当前时间步的表示形式。通过这种方式,Transformer-XL能够利用之前计算的信息,并将其用于当前的计算。这使得Transformer-XL能够处理超过固定长度的序列,并捕捉更长期的依赖关系。

2. Transformer-XL原理

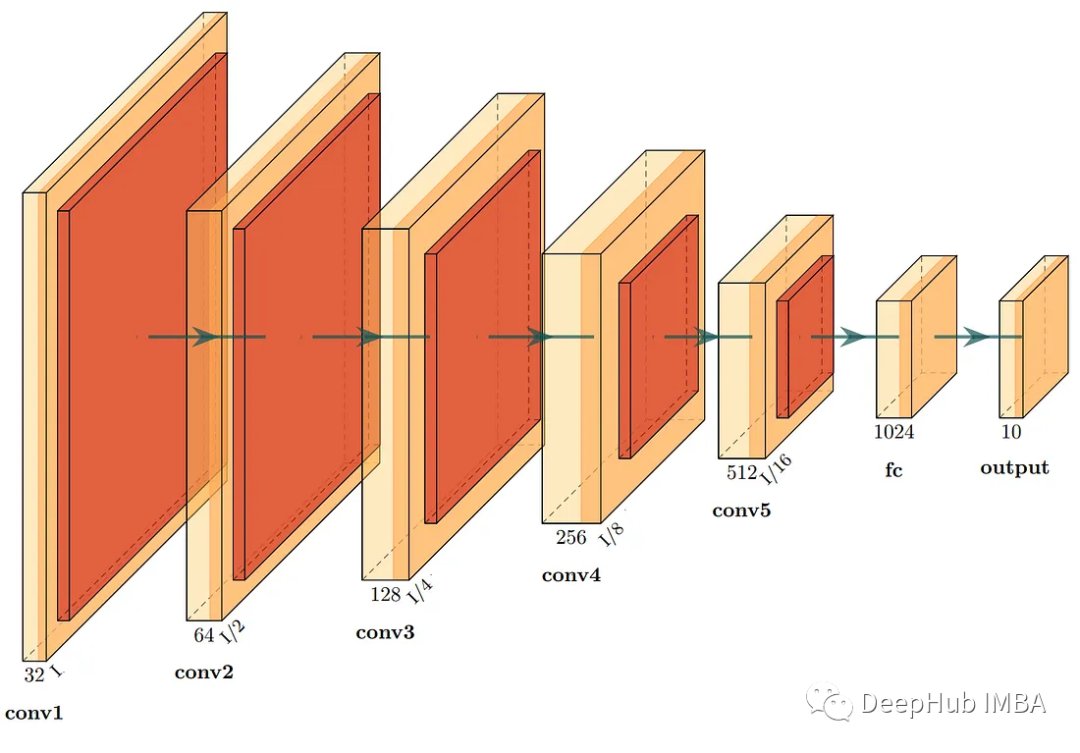

Transformer-XL的核心是通过增强Transformer中的循环机制,来增强长序列上下文的记忆。为了理解这个改进,我们首先回顾一下Transformer的结构。Transformer由多个Encoder和Decoder堆叠而成,其中每个Encoder和Decoder均由多头自注意力机制(Multi-Head Self-Attention)和前向神经网络(Feed-Forward Neural Networks)两部分组成。

在Transformer中,每个Encoder或Decoder的自注意力机制的输入是序列中的某个位置,然后它会计算出该位置对所有位置的注意力分数,并对所有位置的值进行加权平均,得到该位置的输出。这个过程是在所有位置上并行计算的,因此Transformer的计算复杂度是线性的。然而,由于需要同时处理整个序列,每个位置的计算都是独立的,因此Transformer无法直接处理超过固定长度的序列。

Transformer-XL的改进之一是增加了一种记忆机制,可以将之前的状态保存下来,并在下一步计算时使用这些状态。具体来说,每个Encoder和Decoder都有一个内存(Memory),用于存储之前的状态。每当计算到一个新的位置时,会从内存中读取之前的状态,并与当前的输入一起计算,得到新的输出,并将输出存储到内存中。这个过程相当于是对前面的序列进行了循环,从而扩展了序列的长度。Transformer-XL中的每个Encoder包含一个内存,可以在计算当前位置时使用之前的内存状态。

另一个Transformer-XL的改进是针对长距离依赖的处理。长距离依赖是指序列中两个相距较远的位置之间存在的依赖关系。传统的循环神经网络(RNN)可以处理长距离依赖,但由于其顺序计算的特性,其计算速度较慢,并且无法进行并行计算。而Transformer可以进行并行计算,但在处理长序列时也存在长距离依赖的问题,因为在自注意力机制中,每个位置只能通过加权平均得到相对位置的信息,无法获取到绝对位置的信息。

Transformer-XL通过增加一种新的方法来解决长距离依赖问题,称为相对位置编码(Relative Positional Encoding)。相对位置编码的思路是通过引入相对位置的概念,来获取序列中不同位置之间的关系。具体来说,对于一个位置i和另一个位置j,相对位置的定义是它们之间的距离d=i-j。通过引入相对位置编码,Transformer可以获取到位置i和位置j之间的相对位置信息,从而处理长距离依赖。相对位置编码的具体实现方式是,在原有的位置编码的基础上,增加一部分相对位置编码,表示当前位置与其他位置之间的相对位置信息。Transformer-XL中的相对位置编码包括了相对位置的信息,从而能够处理长距离依赖。

Transformer-XL的训练过程与传统的语言模型相同,即通过最大化下一个单词的条件概率来训练模型。在Transformer-XL中,每个位置的输入是之前的一段序列,输出是下一个单词的概率分布。因此,Transformer-XL的目标函数可以表示为:

L = − 1 N ∑ i = 1 N log P ( w i ∣ w < i ) \mathcal{L} = -\frac{1}{N}\sum_{i=1}^N\log P(w_i|w_{<i}) L=−N1i=1∑NlogP(wi∣w<i)

其中, w < i w_{<i} w<i表示序列中前i-1个单词, w i w_i wi表示第i个单词,N表示训练样本的总数。在实际训练中,可以使用随机梯度下降(Stochastic Gradient Descent)或其变种方法来优化目标函数,以更新模型参数。

3. Transformer-XL优劣势

(1)优势

Transformer-XL具有以下几个优势:

-

能够处理超过固定长度的序列。在传统的Transformer中,输入和输出是一次性给出的,因此Transformer不能处理超过固定长度的序列。Transformer-XL通过使用可重复的缓存机制来解决这个问题。缓存机制使Transformer-XL可以从之前的计算中获取上下文,并将其用于当前的计算。这使得Transformer-XL能够处理比传统Transformer更长的序列。

-

能够捕捉更长期的依赖关系。在传统的Transformer中,由于输入和输出是一次性给出的,因此传统Transformer只能利用上下文中较近的信息。Transformer-XL采用的相对位置编码方法使得模型可以处理更长的序列,使得模型更加适合用于语言建模任务,而在较长的序列上,传统的位置编码方法往往存在限制。这使得Transformer-XL在某些任务上比传统Transformer更具优势。

-

能够提高模型的可训练性。在传统的Transformer中,模型的训练过程需要在固定长度的序列上进行。这使得模型的训练非常困难。Transformer-XL通过使用可重复的缓存机制,可以将长序列分成多个较短的序列,并在这些较短的序列上进行训练。这提高了模型的可训练性,并使得模型的训练更加稳定。

-

在不同的NLP任务中,Transformer-XL也有出色的表现,证明了其在不同场景下的通用性。

(2)劣势

- Transformer-XL的模型结构较为复杂,需要更多的计算资源和时间来训练模型,并且模型的训练过程需要使用分布式训练,进一步增加了训练难度和计算成本。

- 在处理较短的序列时,Transformer-XL可能会存在过拟合的风险,因为它的模型结构和参数数量比较大,需要更多的数据来避免过拟合。

4. 案例

下面是使用Transformer-XL进行语言建模的一个示例。在这个示例中,我们将使用Penn Treebank数据集,该数据集是一个常用的语言建模数据集,包含了经过标记的英语句子。我们将使用Transformer-XL来训练一个语言建模器,该模型将预测下一个单词的概率,给定之前的单词序列。

我们使用PyTorch实现Transformer-XL,并使用Penn Treebank数据集进行训练。代码如下:

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import Dataset, DataLoader

from pytorch_transformers import (XLNetConfig, XLNetTokenizer,

XLNetForSequenceClassification, XLNetModel,

AdamW, WarmupLinearSchedule)

# Define the model

class TransformerXLModel(nn.Module):

def __init__(self, ntoken, n_layer, n_head, d_model, d_head, d_inner, dropout, **kwargs):

super().__init__()

self.transformer = XLNetModel(XLNetConfig(n_layer=n_layer,

n_head=n_head,

d_model=d_model,

d_head=d_head,

d_inner=d_inner,

dropout=dropout,

**kwargs))

self.drop = nn.Dropout(dropout)

self.decoder = nn.Linear(d_model, ntoken)

def forward(self, input_ids, mems=None):

if mems is None:

mems = self.init_mems(input_ids.size(0))

output, new_mems = self.transformer(input_ids, mems)

output = self.drop(output)

decoded = self.decoder(output.view(output.size(0) * output.size(1), output.size(2)))

return decoded.view(output.size(0), output.size(1), decoded.size(1)), new_mems

def init_mems(self, bsz):

mems = []

for i in range(self.transformer.config.n_layer):

empty = torch.zeros(self.transformer.config.mem_len, bsz, self.transformer.config.d_model).to(next(self.parameters()))

mems.append(empty)

return mems

# Define the dataset

class PTBDataset(Dataset):

def __init__(self, data, tokenizer):

self.tokenizer = tokenizer

self.data = []

with open(data, 'r') as f:

for line in f:

self.data.extend(tokenizer.encode(line.rstrip()))

def __len__(self):

return len(self.data) - 1

def __getitem__(self, idx):

return (self.data[idx], self.data[idx+1])

# Define the training function

def train(model, train_loader, optimizer, scheduler, criterion, device):

model.train()

total_loss = 0.

for step, (x, y) in enumerate(train_loader):

optimizer.zero_grad()

x = x.to(device)

y = y.to(device)

logits, _ = model(x)

logits = logits.view(-1, logits.size(2))

y = y.view(-1)

loss = criterion(logits, y)

loss.backward()

optimizer.step()

scheduler.step()

total_loss += loss.item()

return total_loss / len(train_loader)

# Define the evaluation function

def evaluate(model, eval_loader, criterion, device):

model.eval()

total_loss = 0.

with torch.no_grad():

for step, (x, y) in enumerate(eval_loader):

x = x.to(device)

y = y.to(device)

logits, _ = model(x)

logits = logits.view(-1, logits.size(2))

y = y.view(-1)

loss = criterion(logits, y)

total_loss += loss.item()

return total_loss / len(eval_loader)

# Set hyperparameters

batch_size = 32

lr = 5e-5

n_layer = 6

n_head = 8

d_model = 512

d_head = 64

d_inner = 2048

dropout = 0.1

n_epochs = 10

# Load the dataset

tokenizer = XLNetTokenizer.from_pretrained('xlnet-base-cased')

train_dataset = PTBDataset('ptb.train.txt', tokenizer)

eval_dataset = PTBDataset('ptb.valid.txt', tokenizer)

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

eval_loader = DataLoader(eval_dataset, batch_size=batch_size)

# Initialize the model and optimizer

model = TransformerXLModel(tokenizer.vocab_size, n_layer, n_head, d_model, d_head, d_inner, dropout)

model.to('cuda')

optimizer = AdamW(model.parameters(), lr=lr, correct_bias=False)

scheduler = WarmupLinearSchedule(optimizer, warmup_steps=0.1, t_total=len(train_loader) * n_epochs)

criterion = nn.CrossEntropyLoss()

# Train the model

for epoch in range(n_epochs):

train_loss = train(model, train_loader, optimizer, scheduler, criterion, 'cuda')

eval_loss = evaluate(model, eval_loader, criterion, 'cuda')

print(f"Epoch {epoch+1} - train_loss: {train_loss:.4f} - eval_loss: {eval_loss:.4f}")

# Test the model

test_dataset = PTBDataset('ptb.test.txt', tokenizer)

test_loader = DataLoader(test_dataset, batch_size=batch_size)

test_loss = evaluate(model, test_loader, criterion, 'cuda')

print(f"Test loss: {test_loss:.4f}")