【论文速递】WACV 2023 - 一种全卷积Transformer的医学影响分割模型

【论文原文】:The Fully Convolutional Transformer for Medical Image Segmentation

【作者信息】:Athanasios Tragakis, Chaitanya Kaul,Roderick Murray-Smith,Dirk Husmeier

论文:https://openaccess.thecvf.com/content/WACV2023/papers/Tragakis_The_Fully_Convolutional_Transformer_for_Medical_Image_Segmentation_WACV_2023_paper.pdf

代码:https://github.com/Thanos-DB/FullyConvolutionalTransformer

博主关键词:医学图像分割、全卷积Transformer

推荐论文:无

摘要

我们提出了一种新的transformer,能够分割不同形态的医学图像。医学图像分析的细粒度特性所带来的挑战意味着transformer对其分析的适应仍处于初级阶段。UNet压倒性的成功在于它能够欣赏分割任务的细粒度性质,这是现有的基于transformer的模型目前不具备的能力。为了解决这个缺点,我们提出了全卷积transformer(FCT),它建立在卷积神经网络学习有效图像表示的能力的基础上,并将它们与transformer的能力相结合,有效地捕获其输入中的长期依赖关系。FCT是医学影像文献中第一个全卷积Transformer模型。它分两个阶段处理输入,首先,它学习从输入图像中提取长期语义依赖关系,然后学习从特征中捕获分层的全局属性。FCT结构紧凑、准确、健壮。我们的结果表明,它在不需要任何预训练的情况下,在不同数据形态的多个医学图像分割数据集上,大大优于所有现有的transformer架构。FCT在ACDC数据集上比其直接模型高出1.3%,在Synapse数据集上高出4.4%,在Spleen数据集上高出1.2%,在ISIC 2017数据集上高出1.1%,在dice metric上的参数少了多达5倍。在ACDC Post-2017MICCAI-Challenge在线测试集上,我们的模型在未见过的MRI测试用例上设置了新的最先进的技术,优于大型集成模型以及参数更少的nnUNet。

1、简介

医学图像分割是计算机辅助诊断的关键工具。它有助于检测和定位图像中病变的边界,有助于快速识别肿瘤和癌变区域的潜在存在。这有可能加快诊断,提高检测肿瘤的可能性,并使临床医生更有效地利用他们的时间,对患者的结果有利[15]。传统上,现代医学图像分割算法构建为对称的自顶向下编码器-解码器结构,首先将输入图像压缩(编码)到潜在空间,然后学习解码图像中感兴趣区域的位置。将中间信号的水平传播(跳越连接)添加到这个垂直信息流中,我们就得到了UNet架构,这可以说是最近分割算法中最具影响力的飞跃。今天大多数现代分割系统都包括UNet或其变体。UNet成功的关键在于其全卷积的性质。UNet在其结构中不估计任何非卷积可训练参数。

基于卷积神经网络(CNN)的UNet模型在医学图像分割任务中的准确性和性能方面取得了巨大的成功。然而,为了真正帮助临床医生进行早期疾病诊断,它们仍然需要额外的改进。卷积算子固有的局部特性是CNN的一个关键问题,因为它阻止了它们利用来自输入图像的长范围语义依赖。人们提出了各种方法来为CNN添加全局上下文,最引人注目的是引入注意力机制,以及扩大卷积核以增加核的感受野。然而,这些方法都有自己的缺点。Transformer在语言学习任务中取得了巨大的成功,因为它们能够有效地处理非常长范围的序列依赖。这导致它们最近适应了各种视觉任务[7,18,21,22]。最近提出的架构,如ViT[7],已经超过了cnn在基准成像任务上的性能,而最近对ViT的许多改进,如CvT [36], CCT[10]和Swin Transformer[25],已经表明transformer不需要庞大的数据消耗模型,甚至可以处理少量数据,从而超过CNN的性能。通常,ViT风格的模型首先从图像中提取离散的非重叠patch(在NLP中称为token)。然后,他们通过位置编码将空间定位注入到这些patch中,并将此表示通过标准transformer层来建模数据中的长期语义依赖关系。

考虑到CNN和Transformer的明显优点,我们认为医学图像分割的下一步是一个完全卷积编码器-解码器深度学习模型,能够有效地利用医学图像中的长期语义依赖。为了实现这一目标,我们提出了第一个用于医学图像分割的全卷积Transformer。我们新颖的全卷积Transformer层构成了我们模型的主要构建块。它包含两个关键组件,一个卷积注意力模块和一个全卷积Wide-Focus模块(见第3节)。我们将我们的贡献形式化如下:

- 我们提出了第一个用于医学图像分割的全卷积Transformer,它超越了所有现有的基于卷积和transformer的医学图像分割架构的性能,用于多个二分类和语义分割数据集。

- 我们提出了一种新型的全卷积transformer层,它使用卷积注意力模块来学习长范围的语义上下文,然后通过宽焦点模块使用多分辨率空洞卷积创建分层的局部到全局上下文。

- 通过广泛的消融研究,我们展示了我们模型的各种构建块在其对模型性能影响的背景下的影响。

2、全卷积Transformer

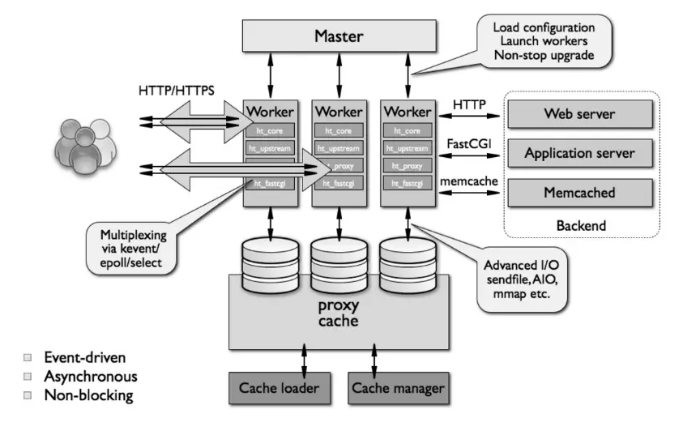

给定一个数据集 { X , Y } \{\mathbf{X}, \mathbf{Y}\} {X,Y},其中, X \mathbf{X} X是我们模型的输入图像, Y \mathbf{Y} Y是相应的语义或二分类分割映射。对于每个图像 x i ∈ R H × W × C \mathbf{x}_i∈\mathbb{R}^{H×W ×C} xi∈RH×W×C,其中 H H H和 W W W为图像的空间分辨率, C = { 3 , … , N } C =\{3,\ldots, N\} C={3,…,N}为输入通道数,我们的模型产生一个输出分割映射 y i ∈ R H × W × K \mathbf{y}_i∈\mathbb{R}^{H×W ×K} yi∈RH×W×K,其中, K ∈ { 1 , … , D } K∈\{1,\ldots,D\} K∈{1,…,D}。FCT的输入是从输入3D图像的每个切片中采样的2D patch。我们的模型遵循熟悉的UNet形状,FCT层作为其基本构建块。与现有的方法不同,我们的模型既不是CNN-Transformer的混合,也不是Transformer-UNet的结构,它使用现成的transformer层来编码或细化输入特征。它首先从图像中提取重叠的patch,然后创建基于patch的扫描嵌入,然后在这些patch上应用多头自注意,从而构建特征表示。然后通过我们的Wide-Focus模块处理给定图像的输出投影,以从投影中提取细粒度信息。图1显示了我们的网络体系结构的概述。

3、结果