我们目前用的spark版本还是2.x

spark的history事件是保存在hdfs上的,通过spark.history.fs.logDirectory指定保存的hdfs目录

使用中发现history日志文件占用磁盘还挺高的

于是写了一个脚本来定期进行清理,只保留一定时间的文件

对于spark离线任务来说,这样做是没问题的

但是对于spark streaming来说,就会导致问题

spark streaming程序是长期运行的,但是对应的文件是固定的

如果只是根据时间去删,会导致正在运行的任务,history文件被删除

好在spark history server本身就提供了日志清理的支持

直接配置一下即可:

spark.history.fs.cleaner.enabled=true

spark.history.fs.cleaner.interval=1d

spark.history.fs.cleaner.maxAge=7d

具体配置说明见:https://spark.apache.org/docs/2.1.0/monitoring.html

但是这样其实还是有个问题

那就是单个history文件会一直增长,越来越大

一来会导致磁盘占用较大,二来spark ui进行日志解析也会耗费很多资源

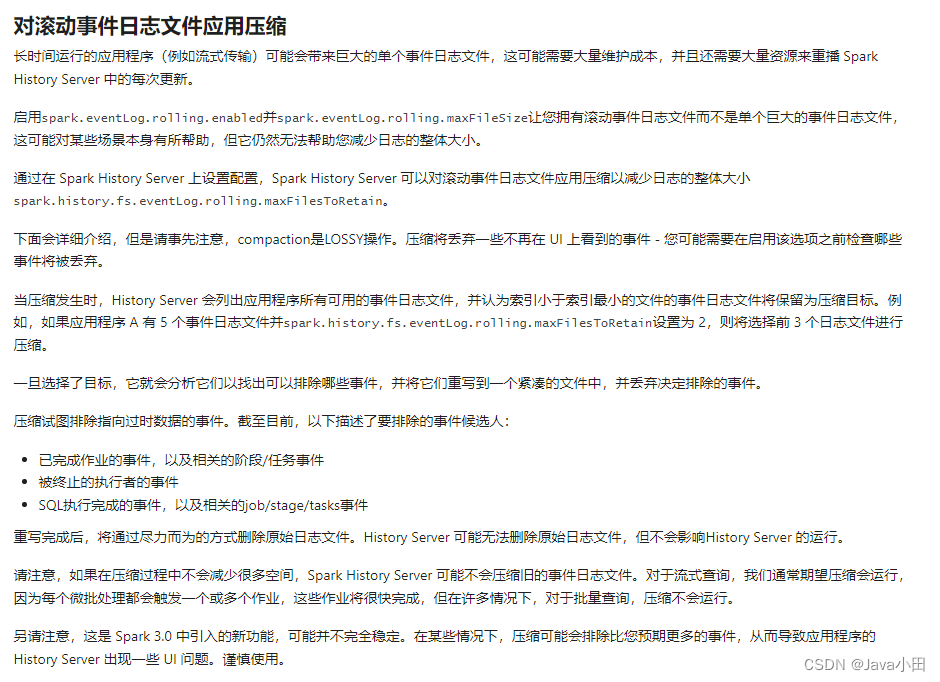

spark3.x开始支持history日志滚动输出,还可以对旧日志进行压缩

见文档:https://spark.apache.org/docs/latest/monitoring.html#applying-compaction-on-rolling-event-log-files

所以可以升级spark版本到3.x来解决这个问题

如果不想升级spark版本,对spark streaming程序进行重启,也可以作为一个临时解决方案

重启后是一个新的application,对应的history文件也变成新的,旧的文件保留7天