5.3 实时数据ETL存储

实时从Kafka Topic消费数据,提取ip地址字段,调用【ip2Region】库解析为省份和城市,存储到HDFS文件中,设置批处理时间间隔BatchInterval为10秒,完整代码如下:

package cn.itcast.spark.app.etl

import cn.itcast.spark.app.StreamingContextUtils

import org.apache.kafka.clients.consumer.ConsumerRecord

import org.apache.spark.rdd.RDD

import org.apache.spark.streaming.StreamingContext

import org.apache.spark.streaming.dstream.DStream

import org.lionsoul.ip2region.{DataBlock, DbConfig, DbSearcher}

/**

* 实时消费Kafka Topic数据,经过ETL(过滤、转换)后,保存至HDFS文件系统中,BatchInterval为:10s

*/

object StreamingETLHdfs {

def main(args: Array[String]): Unit = {

// 1. 获取StreamingContext实例对象

val ssc: StreamingContext = StreamingContextUtils.getStreamingContext(this.getClass, 10)

// 2. 从Kafka消费数据,使用Kafka New Consumer API

val kafkaDStream: DStream[ConsumerRecord[String, String]] = StreamingContextUtils

.consumerKafka(ssc, "search-log-topic")

// 3. 数据ETL:过滤不合格数据及转换IP地址为省份和城市,并存储HDFS上

kafkaDStream.foreachRDD{(rdd, time) =>

// i. message不为null,且分割为4个字段

val kafkaRDD: RDD[ConsumerRecord[String, String]] = rdd.filter{ record =>

val message: String = record.value()

null != message && message.trim.split(",").length == 4

}

// ii. 解析IP地址

val etlRDD: RDD[String] = kafkaRDD.mapPartitions{ iter =>

// 创建DbSearcher对象,针对每个分区创建一个,并不是每条数据创建一个

val dbSearcher = new DbSearcher(new DbConfig(), "dataset/ip2region.db")

iter.map{record =>

val Array(_, ip, _, _) = record.value().split(",")

// 依据IP地址解析

val dataBlock: DataBlock = dbSearcher.btreeSearch(ip)

val region: String = dataBlock.getRegion

val Array(_, _, province, city, _) = region.split("\\|")

// 组合字符串

s"${record.value()},$province,$city"

}

}

// iii. 保存至文件

val savePath = s"datas/streaming/etl/search-log-${time.milliseconds}"

if(!etlRDD.isEmpty()){

etlRDD.coalesce(1).saveAsTextFile(savePath)

}

}

// 4.启动流式应用,一直运行,直到程序手动关闭或异常终止

ssc.start()

ssc.awaitTermination()

ssc.stop(stopSparkContext = true, stopGracefully = true)

}

}

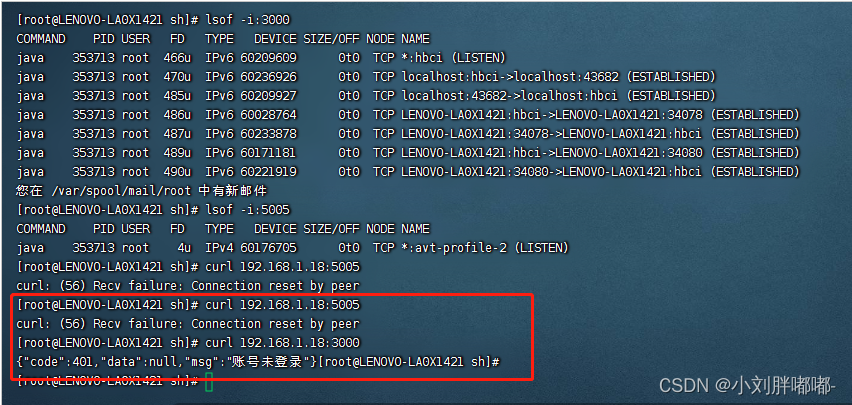

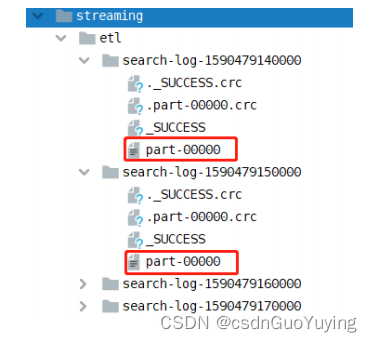

运行模拟日志数据程序和ETL应用程序,查看实时数据ETL后保存文件,截图如下:

5.4 实时状态更新统计

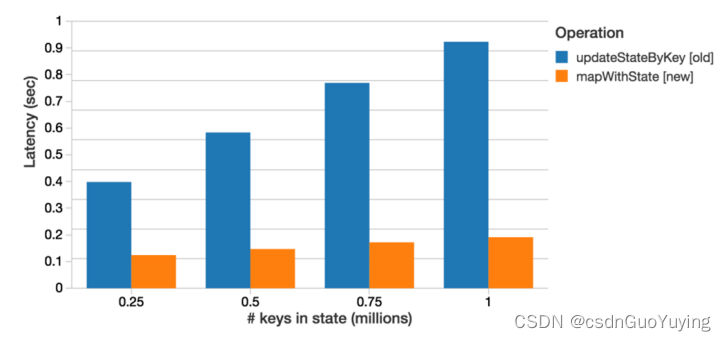

实 时 累 加 统 计 用 户 各 个 搜 索 词 出 现 的 次 数 , 在 SparkStreaming 中 提 供 函 数【updateStateByKey】实现累加统计,Spark 1.6提供【mapWithState】函数状态统计,性能更好,实际应用中也推荐使用。

updateStateByKey 函数

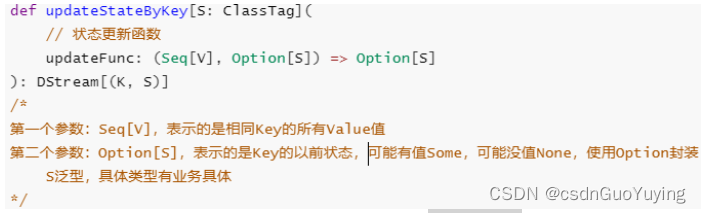

状态更新函数【updateStateByKey】表示依据Key更新状态,要求DStream中数据类型为【Key/Value】对二元组,函数声明如下:

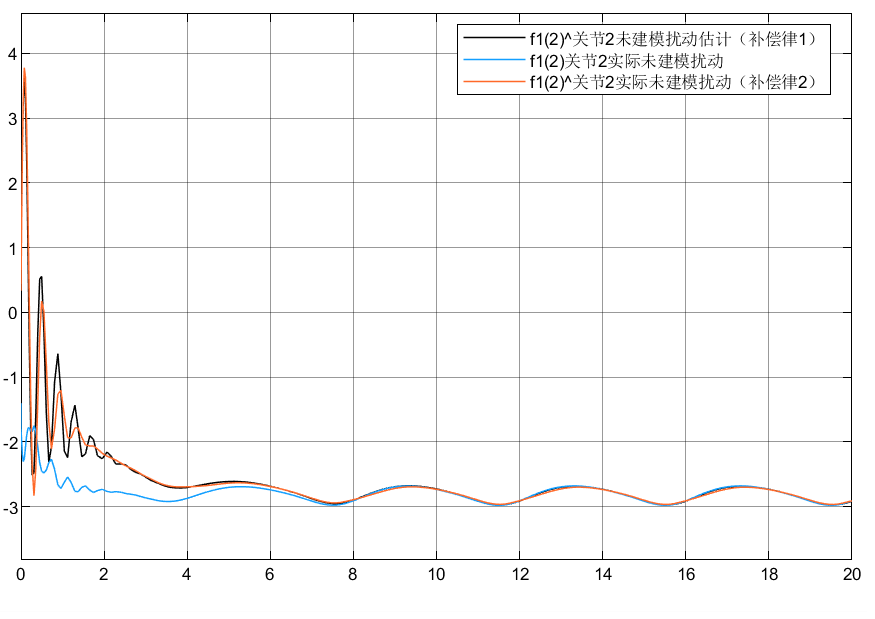

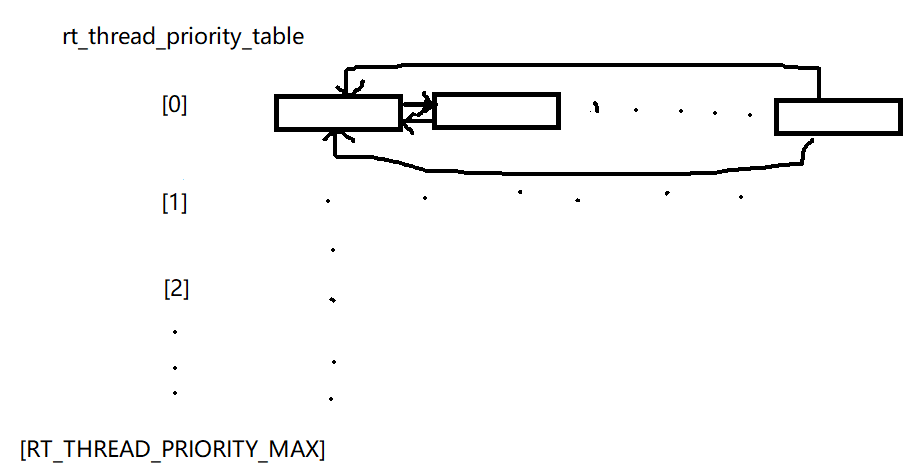

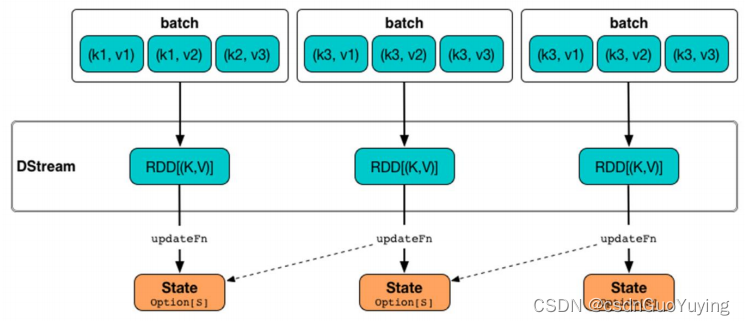

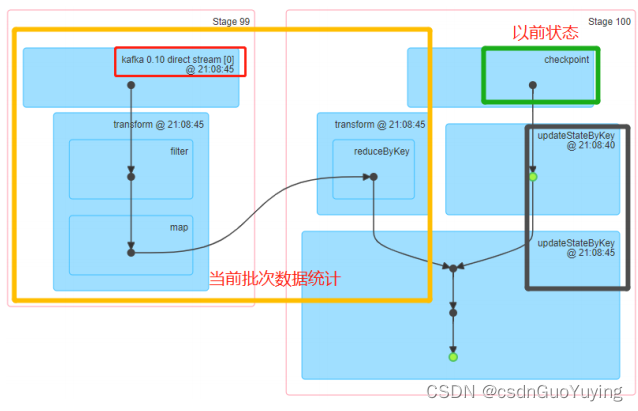

将每批次数据状态,按照Key与以前状态,使用定义函数【updateFunc】进行更新,示意图如下:

文档:http://spark.apache.org/docs/2.4.5/streaming-programming-guide.html#updatestatebykey-operation

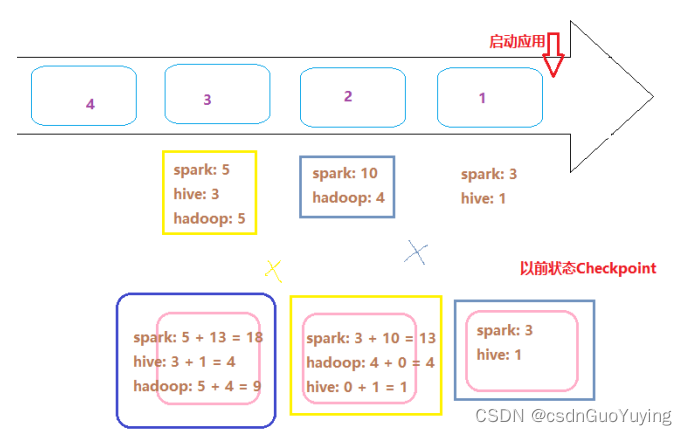

针对搜索词词频统计WordCount,状态更新逻辑示意图如下:

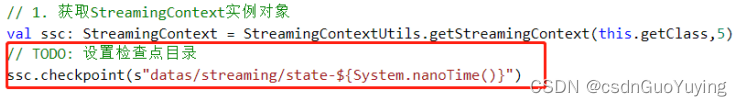

以前的状态数据,保存到Checkpoint检查点目录中,所以在代码中需要设置Checkpoint检查点目录:

完整演示代码如下:

package cn.itcast.spark.app.state

import cn.itcast.spark.app.StreamingContextUtils

import org.apache.kafka.clients.consumer.ConsumerRecord

import org.apache.spark.streaming.StreamingContext

import org.apache.spark.streaming.dstream.DStream

/**

* 实时消费Kafka Topic数据,累加统计各个搜索词的搜索次数,实现百度搜索风云榜

*/

object StreamingUpdateState {

def main(args: Array[String]): Unit = {

// 1. 获取StreamingContext实例对象

val ssc: StreamingContext = StreamingContextUtils.getStreamingContext(this.getClass, 5)

// TODO: 设置检查点目录

ssc.checkpoint(s"datas/streaming/state-${System.nanoTime()}")

// 2. 从Kafka消费数据,使用Kafka New Consumer API

val kafkaDStream: DStream[ConsumerRecord[String, String]] = StreamingContextUtils

.consumerKafka(ssc, "search-log-topic")

// 3. 对每批次的数据进行搜索词次数统计

val reduceDStream: DStream[(String, Int)] = kafkaDStream.transform{ rdd =>

val reduceRDD = rdd

// 过滤不合格的数据

.filter{ record =>

val message: String = record.value()

null != message && message.trim.split(",").length == 4

}

// 提取搜索词,转换数据为二元组,表示每个搜索词出现一次

.map{record =>

val keyword: String = record.value().trim.split(",").last

keyword -> 1

}

// 按照单词分组,聚合统计

.reduceByKey((tmp, item) => tmp + item) // TODO: 先聚合,再更新,优化

reduceRDD // 返回

}

/*

def updateStateByKey[S: ClassTag](

// 状态更新函数

updateFunc: (Seq[V], Option[S]) => Option[S]

): DStream[(K, S)]

第一个参数:Seq[V]

表示的是相同Key的所有Value值

第二个参数:Option[S]

表示的是Key的以前状态,可能有值Some,可能没值None,使用Option封装

S泛型,具体类型有业务具体,此处是词频:Int类型

*/

val stateDStream: DStream[(String, Int)] = reduceDStream.updateStateByKey(

(values: Seq[Int], state: Option[Int]) => {

// a. 获取以前状态信息

val previousState = state.getOrElse(0)

// b. 获取当前批次中Key对应状态

val currentState = values.sum

// c. 合并状态

val latestState = previousState + currentState

// d. 返回最新状态

Some(latestState)

}

)

// 5. 将结果数据输出 -> 将每批次的数据处理以后输出

stateDStream.print()

// 6.启动流式应用,一直运行,直到程序手动关闭或异常终止

ssc.start()

ssc.awaitTermination()

ssc.stop(stopSparkContext = true, stopGracefully = true)

}

}

运行应用程序,通过WEB UI界面可以发现,将以前状态保存到Checkpoint检查点目录中,更新时在读取。

此外,updateStateByKey函数有很多重载方法,依据不同业务需求选择合适的方式使用。

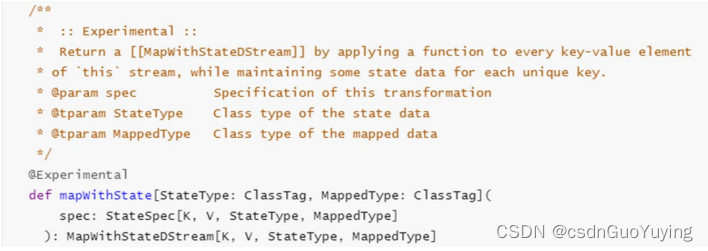

mapWithState 函数

Spark 1.6提供新的状态更新函数【mapWithState】,mapWithState函数也会统计全局的key的状态,但是如果没有数据输入,便不会返回之前的key的状态,只是关心那些已经发生的变化的key,对于没有数据输入,则不会返回那些没有变化的key的数据。

这样的话,即使数据量很大,checkpoint也不会像updateStateByKey那样,占用太多的存储,效率比较高;

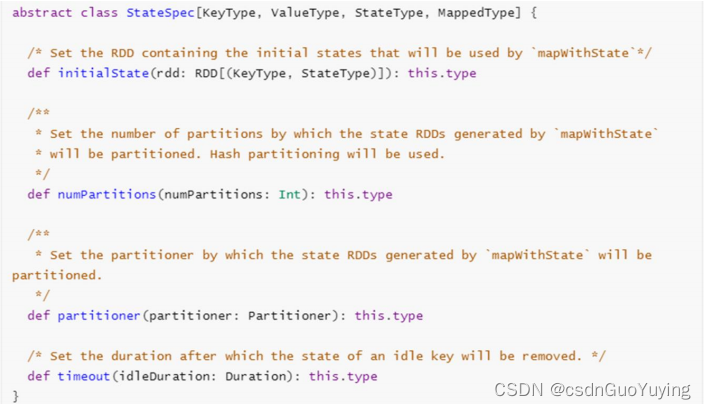

需要构建StateSpec对象,对状态State进行封装,可以进行相关操作,类的声明定义如下:

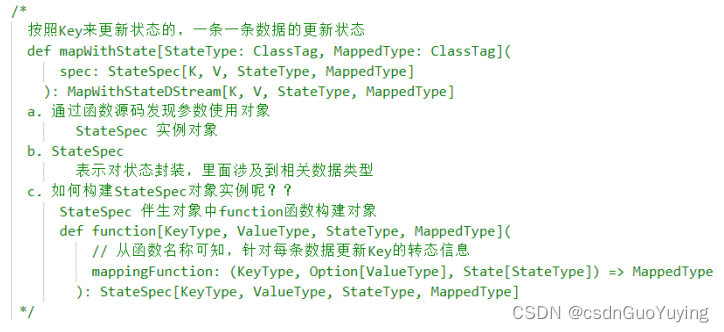

状态函数【mapWithState】参数相关说明:

完整演示代码如下:

package cn.itcast.spark.app.state

import cn.itcast.spark.app.StreamingContextUtils

import org.apache.kafka.clients.consumer.ConsumerRecord

import org.apache.spark.rdd.RDD

import org.apache.spark.streaming.{State, StateSpec, StreamingContext}

import org.apache.spark.streaming.dstream.DStream

/**

* 实时消费Kafka Topic数据,累加统计各个搜索词的搜索次数,实现百度搜索风云榜

*/

object StreamingMapWithState {

def main(args: Array[String]): Unit = {

// 1. 获取StreamingContext实例对象

val ssc: StreamingContext = StreamingContextUtils.getStreamingContext(this.getClass, 5)

// TODO: 设置检查点目录

ssc.checkpoint(s"datas/streaming/state-${System.nanoTime()}")

// 2. 从Kafka消费数据,使用Kafka New Consumer API

val kafkaDStream: DStream[ConsumerRecord[String, String]] = StreamingContextUtils

.consumerKafka(ssc, "search-log-topic")

// 3. 对每批次的数据进行搜索词进行次数统计

val reduceDStream: DStream[(String, Int)] = kafkaDStream.transform{ rdd =>

val reduceRDD: RDD[(String, Int)] = rdd

// 过滤不合格的数据

.filter{ record =>

val message: String = record.value()

null != message && message.trim.split(",").length == 4

}

// 提取搜索词,转换数据为二元组,表示每个搜索词出现一次

.map{record =>

val keyword: String = record.value().trim.split(",").last

keyword -> 1

}

// 按照单词分组,聚合统计

.reduceByKey((tmp, item) => tmp + item) // TODO: 先聚合,再更新,优化

// 返回

reduceRDD

}

// TODO: 4、实时累加统计搜索词搜索次数,使用mapWithState函数

/*

按照Key来更新状态的,一条一条数据的更新状态

def mapWithState[StateType: ClassTag, MappedType: ClassTag](

spec: StateSpec[K, V, StateType, MappedType]

): MapWithStateDStream[K, V, StateType, MappedType]

a. 通过函数源码发现参数使用对象

StateSpec 实例对象

b. StateSpec

表示对状态封装,里面涉及到相关数据类型

c. 如何构建StateSpec对象实例呢??

StateSpec 伴生对象中function函数构建对象

def function[KeyType, ValueType, StateType, MappedType](

// 从函数名称可知,针对每条数据更新Key的转态信息

mappingFunction: (KeyType, Option[ValueType], State[StateType]) => MappedType

): StateSpec[KeyType, ValueType, StateType, MappedType]

*/

// 状态更新函数,针对每条数据进行更新状态

val spec: StateSpec[String, Int, Int, (String, Int)] = StateSpec.function(

// (KeyType, Option[ValueType], State[StateType]) => MappedType

(keyword: String, countOption: Option[Int], state: State[Int]) => {

// a. 获取当前批次中搜索词搜索次数

val currentState: Int = countOption.getOrElse(0)

// b. 从以前状态中获取搜索词搜索次数

val previousState = state.getOption().getOrElse(0)

// c. 搜索词总的搜索次数

val latestState = currentState + previousState

// d. 更行状态

state.update(latestState)

// e. 返回最新省份销售订单额

(keyword, latestState)

}

)

// 调用mapWithState函数进行实时累加状态统计

val stateDStream: DStream[(String, Int)] = reduceDStream.mapWithState(spec)

// 5. 将结果数据输出 -> 将每批次的数据处理以后输出

stateDStream.print()

// 6.启动流式应用,一直运行,直到程序手动关闭或异常终止

ssc.start()

ssc.awaitTermination()

ssc.stop(stopSparkContext = true, stopGracefully = true)

}

}

运行程序可以发现,当Key(搜索单词)没有出现时,不会更新状态,仅仅更新当前批次中出现的Key的状态。

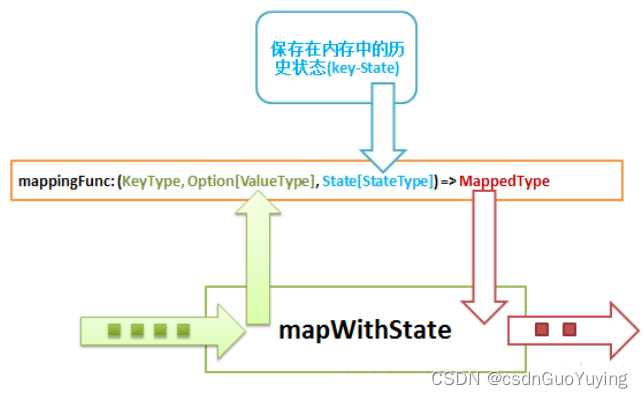

mapWithState 实现有状态管理主要是通过两点:a)、历史状态需要在内存中维护,这里必需的了,updateStateBykey也是一样;b)、自定义更新状态的mappingFunction,这些就是具体的业务功能实现逻辑了(什么时候需要更新状态)

首先数据像水流一样从左侧的箭头流入,把 mapWithState看成一个转换器的话,mappingFunc就是转换的规则,流入的新数据(key-value)结合历史状态(通过key从内存中获取的历史状态)进行一些自定义逻辑的更新等操作,最终从红色箭头中流出。