文章目录

- 最小二乘法

- 返回值

- 测试

最小二乘法

scipy.sparse.linalg实现了两种稀疏矩阵最小二乘法lsqr和lsmr,前者是经典算法,后者来自斯坦福优化实验室,据称可以比lsqr更快收敛。

这两个函数可以求解 A x = b Ax=b Ax=b,或 arg min x ∥ A x − b ∥ 2 \argmin_x\Vert Ax-b\Vert^2 argminx∥Ax−b∥2,或 arg min x ∥ A x − b ∥ 2 + d 2 ∥ x − x 0 ∥ 2 \argmin_x\Vert Ax-b\Vert^2+d^2\Vert x-x_0\Vert^2 argminx∥Ax−b∥2+d2∥x−x0∥2,其中 A A A必须是方阵或三角阵,可以有任意秩。

通过设置容忍度

a

t

,

b

t

a_t, b_t

at,bt,可以控制算法精度,记

r

=

b

−

A

x

r=b-Ax

r=b−Ax为残差向量,如果

A

x

=

b

Ax=b

Ax=b是相容的,lsqr在

∥

r

∥

⩽

a

t

∗

∥

A

∥

⋅

∥

x

∥

+

b

t

∥

b

∥

\Vert r\Vert\leqslant a_t*\Vert A\Vert\cdot\Vert x\Vert + b_t\Vert b\Vert

∥r∥⩽at∗∥A∥⋅∥x∥+bt∥b∥时终止;否则将在

∥

A

T

r

∥

⩽

a

t

∥

A

∥

⋅

∥

r

∥

\Vert A^T r\Vert\leqslant a_t\Vert A\Vert \cdot\Vert r\Vert

∥ATr∥⩽at∥A∥⋅∥r∥。

如果两个容忍度都是

1

0

−

6

10^{-6}

10−6,最终的

∥

r

∥

\Vert r\Vert

∥r∥将有6位精度。

lsmr的参数如下

lsmr(A, b, damp=0.0, atol=1e-06, btol=1e-06, conlim=100000000.0, maxiter=None, show=False, x0=None)

参数解释:

A可谓稀疏矩阵、数组以及线性算子b为数组damp阻尼系数,默认为0atol,btol截止容忍度,是lsqr迭代的停止条件,即 a t , b t a_t, b_t at,bt。conlim另一个截止条件,对于最小二乘问题,conlim应该小于 1 0 8 10^8 108,如果 A x = b Ax=b Ax=b是相容的,则conlim最大可以设到 1 0 12 10^{12} 1012iter_limint迭代次数show如果为True,则打印运算过程calc_var是否估计(A.T@A + damp**2*I)^{-1}的对角线x0阻尼系数相关

lsqr和lsmr相比,没有maxiter参数,但多了iter_lim, calc_va参数。

上述参数中,damp为阻尼系数,当其不为0时,记作

δ

\delta

δ,待解决的最小二乘问题变为

[ A δ I ] x = [ b δ x 0 ] \begin{bmatrix}A\\\delta I\end{bmatrix} x=\begin{bmatrix}b\\\delta x_0 \end{bmatrix} [AδI]x=[bδx0]

返回值

lsmr的返回值依次为:

x即 A x = b Ax=b Ax=b中的 x x xistop程序结束运行的原因itn迭代次数normr∥ b − A x ∥ \Vert b-Ax\Vert ∥b−Ax∥normar∥ A T ( b − A x ) ∥ \Vert A^T(b-Ax)\Vert ∥AT(b−Ax)∥norma∥ A ∥ \Vert A\Vert ∥A∥condaA的条件数normx∥ x ∥ \Vert x\Vert ∥x∥

lsqr的返回值为

x即 A x = b Ax=b Ax=b中的 x x xistop程序结束运行的原因itn迭代次数r1norm∥ b − A x ∥ \Vert b-Ax\Vert ∥b−Ax∥r2norm∥ b − A x ∥ 2 + δ 2 ∥ x − x 0 ∥ 2 \sqrt{\Vert b-Ax\Vert^2+\delta^2\Vert x-x_0\Vert^2} ∥b−Ax∥2+δ2∥x−x0∥2anorm估计的Frobenius范数 A ˉ \bar A AˉacondA ˉ \bar A Aˉ的条件数arnorm∥ A T r − δ 2 ( x − x 0 ) ∥ \Vert A^Tr-\delta^2(x-x_0)\Vert ∥ATr−δ2(x−x0)∥xnorm∥ x ∥ \Vert x\Vert ∥x∥var( A T A ) − 1 (A^TA)^{-1} (ATA)−1

二者的返回值较多,而且除了前四个之外,剩下的意义不同,调用时且须注意。

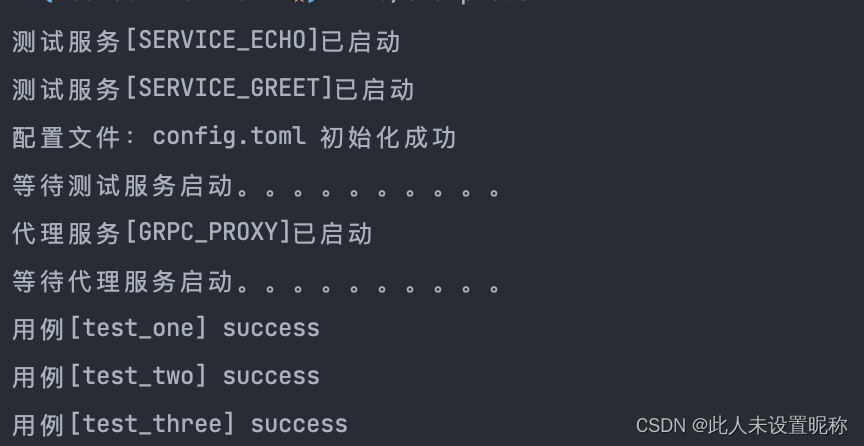

测试

下面对这两种算法进行验证,第一步就得先有一个稀疏矩阵

import numpy as np

from scipy.sparse import csr_array

np.random.seed(42) # 设置随机数状态

mat = np.random.rand(500,500)

mat[mat<0.9] = 0

csr = csr_array(mat)

然后用这个稀疏矩阵乘以一个 x x x,得到 b b b

xs = np.arange(500)

b = mat @ xs

接下来对这两个最小二乘函数进行测试

from scipy.sparse.linalg import lsmr, lsqr

import matplotlib.pyplot as plt

mx = lsmr(csr, b)[0]

qx = lsqr(csr, b)[0]

plt.plot(xs, lw=0.5)

plt.plot(mx, lw=0, marker='*', label="lsmr")

plt.plot(qx, lw=0, marker='.', label="lsqr")

plt.legend()

plt.show()

为了对比清晰,对图像进行放大,可以说二者不分胜负

接下来比较二者的效率, 500 × 500 500\times500 500×500这个尺寸显然已经不合适了,用 2000 × 2000 2000\times2000 2000×2000

from timeit import timeit

np.random.seed(42) # 设置随机数状态

mat = np.random.rand(500,500)

mat[mat<0.9] = 0

csr = csr_array(mat)

timeit(lambda : lsmr(csr, b), number=10)

timeit(lambda : lsqr(csr, b), number=10)

测试结果如下

>>> timeit(lambda : lsqr(csr, b), number=10)

0.5240591000001587

>>> timeit(lambda : lsmr(csr, b), number=10)

0.6156221000019286

看来lsmr并没有更快,看来斯坦福也不靠谱(滑稽)。