57 长短期记忆网络(LSTM)【动手学深度学习v2】

深度学习学习笔记

学习视频:https://www.bilibili.com/video/BV1JU4y1H7PC/?spm_id_from=autoNext&vd_source=75dce036dc8244310435eaf03de4e330

长短期记忆网络(LSTM)

LSTM 实际中比较常用的网络,LSTM比GRU复杂一些。

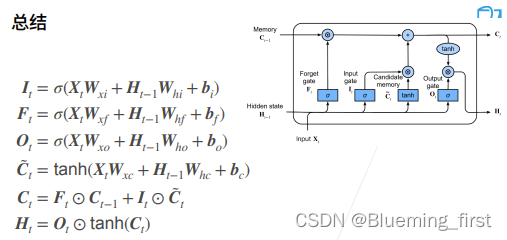

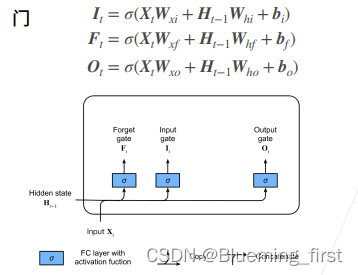

忘记门、输入门、输出门,效果上也是是不是要忘记过去的状态尽量去看现在的输入数据;还是说不看现在的状态尽量去用前一个时刻的状态。

三个门,计算差不多,XW + Ht-1W + b。

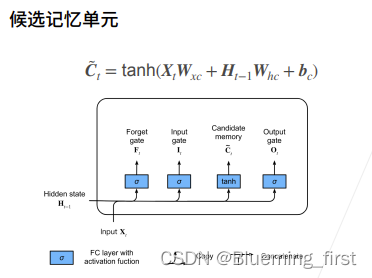

候选记忆单元

C : 之前算RNN里面那个H相似。

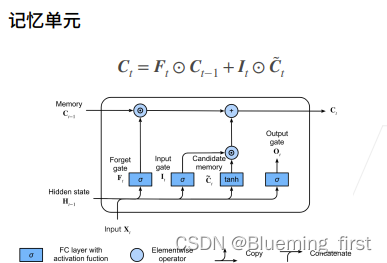

记忆单元

上一个时刻的记忆单元会当做状态传进来,F 尽量不去记住前一个状态 Ct-1,I 尽量去用Ct。

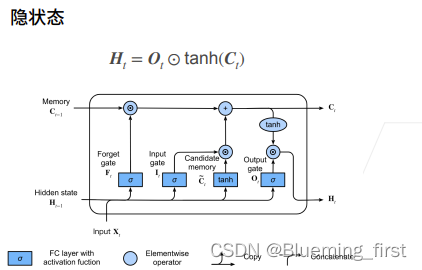

隐藏状态

对候选记忆单元Ct再做一个tanh。

记忆单元处的计算公式,可能将Ct变化为(-2,2),Ht需要在(-1,1)所以需要再做一次tanh,Ot是控制要不要输出(1 输出 ,0 重置不要所有的信息)。

总结:LSTM 和GRU实现效果差不多,但是更加复杂,多了一个C(没有被normalize,所以区间可能会大,忘掉前面的Ct-1,只用当前的Ct),Ht一样可要之前又可不要之前。