● 🍨 本文为🔗365天深度学习训练营 中的学习记录博客

● 🍦 参考文章:Pytorch实战 | 第P9周:YOLOv5-Backbone模块实现(训练营内部成员可读)

● 🍖 原作者:K同学啊|接辅导、项目定制

说明:

1.本次进学习YOLOv5-Backbone模块实现,其余程序与P8周相同

2.C3模块大致已经在上周了解,本次主要了解一下SPP结构

学习记录

1.CBS

CBS由一个二维卷积层+一个Bn层+一个SiLU激活函数构成

SiLU(x)=x⋅Sigmoid(x)

2.C3运作流程

输入A分为两个部分,第一部分通过一个卷积层得到输出A。

第二部分则通过一个CBS层+一个瓶颈层

瓶颈层中采用了shortcut

shortcut为了解决深度网络的梯度发散问题

输入B与经过两次卷积的输出B进行add操作得到输出C

最后输出C和经过卷积层的输出A通过concat操作拼接

3.SPPF

SPPF是SPP结构的改进,速度更快

运作流程为:

1.通过CBS层,即卷积层+BN层+SiLU,输出为x

2.x通过第一次最大池化记为y1,y1通过第二次最大池化层记为y2,最后通过一个最大池化层记为y3

3.将x,y1,y2,y3进行融合

4通过一个CBS层得到最终输出

看起来是可以获得不同层次(池化次数)的特征,融合局部特征和整体特征的效果

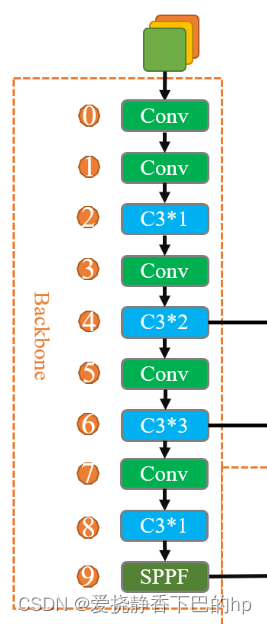

4.YOLOv5-Backbone模块组合方法

输入经过两个CBS层后,经过三组C3+CBS的组合,最后通过SPPF完成卷积操作

图的绘制者@K同学啊

YOLOv5-Backbone模块实现

import torch.nn.functional as F

def autopad(k, p=None): # kernel, padding

# Pad to 'same'

if p is None:

p = k // 2 if isinstance(k, int) else [x // 2 for x in k] # auto-pad

return p

class Conv(nn.Module):

# Standard convolution

def __init__(self, c1, c2, k=1, s=1, p=None, g=1, act=True): # ch_in, ch_out, kernel, stride, padding, groups

super().__init__()

self.conv = nn.Conv2d(c1, c2, k, s, autopad(k, p), groups=g, bias=False)

self.bn = nn.BatchNorm2d(c2)

self.act = nn.SiLU() if act is True else (act if isinstance(act, nn.Module) else nn.Identity())

def forward(self, x):

return self.act(self.bn(self.conv(x)))

class Bottleneck(nn.Module):

# Standard bottleneck

def __init__(self, c1, c2, shortcut=True, g=1, e=0.5): # ch_in, ch_out, shortcut, groups, expansion

super().__init__()

c_ = int(c2 * e) # hidden channels

self.cv1 = Conv(c1, c_, 1, 1)

self.cv2 = Conv(c_, c2, 3, 1, g=g)

self.add = shortcut and c1 == c2

def forward(self, x):

return x + self.cv2(self.cv1(x)) if self.add else self.cv2(self.cv1(x))

class C3(nn.Module):

# CSP Bottleneck with 3 convolutions

def __init__(self, c1, c2, n=1, shortcut=True, g=1, e=0.5): # ch_in, ch_out, number, shortcut, groups, expansion

super().__init__()

c_ = int(c2 * e) # hidden channels

self.cv1 = Conv(c1, c_, 1, 1)

self.cv2 = Conv(c1, c_, 1, 1)

self.cv3 = Conv(2 * c_, c2, 1) # act=FReLU(c2)

self.m = nn.Sequential(*(Bottleneck(c_, c_, shortcut, g, e=1.0) for _ in range(n)))

def forward(self, x):

return self.cv3(torch.cat((self.m(self.cv1(x)), self.cv2(x)), dim=1))

class SPPF(nn.Module):

# Spatial Pyramid Pooling - Fast (SPPF) layer for YOLOv5 by Glenn Jocher

def __init__(self, c1, c2, k=5): # equivalent to SPP(k=(5, 9, 13))

super().__init__()

c_ = c1 // 2 # hidden channels

self.cv1 = Conv(c1, c_, 1, 1)

self.cv2 = Conv(c_ * 4, c2, 1, 1)

self.m = nn.MaxPool2d(kernel_size=k, stride=1, padding=k // 2)

def forward(self, x):

x = self.cv1(x)

with warnings.catch_warnings():

warnings.simplefilter('ignore') # suppress torch 1.9.0 max_pool2d() warning

y1 = self.m(x)

y2 = self.m(y1)

return self.cv2(torch.cat([x, y1, y2, self.m(y2)], 1))

"""

这个是YOLOv5, 6.0版本的主干网络,这里进行复现

(注:有部分删改,详细讲解将在后续进行展开)

"""

class YOLOv5_backbone(nn.Module):

def __init__(self):

super(YOLOv5_backbone, self).__init__()

self.Conv_1 = Conv(3, 64, 3, 2, 2)

self.Conv_2 = Conv(64, 128, 3, 2)

self.C3_3 = C3(128,128)

self.Conv_4 = Conv(128, 256, 3, 2)

self.C3_5 = C3(256,256)

self.Conv_6 = Conv(256, 512, 3, 2)

self.C3_7 = C3(512,512)

self.Conv_8 = Conv(512, 1024, 3, 2)

self.C3_9 = C3(1024, 1024)

self.SPPF = SPPF(1024, 1024, 5)

# 全连接网络层,用于分类

self.classifier = nn.Sequential(

nn.Linear(in_features=65536, out_features=100),

nn.ReLU(),

nn.Linear(in_features=100, out_features=4)

)

def forward(self, x):

x = self.Conv_1(x)

x = self.Conv_2(x)

x = self.C3_3(x)

x = self.Conv_4(x)

x = self.C3_5(x)

x = self.Conv_6(x)

x = self.C3_7(x)

x = self.Conv_8(x)

x = self.C3_9(x)

x = self.SPPF(x)

x = torch.flatten(x, start_dim=1)

x = self.classifier(x)

return x

device = "cuda" if torch.cuda.is_available() else "cpu"

print("Using {} device".format(device))

model = YOLOv5_backbone().to(device)

model

(cv1): Conv( (conv): Conv2d(1024, 512, kernel_size=(1, 1), stride=(1, 1), bias=False) (bn): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True) (act): SiLU() ) (cv2): Conv( (conv): Conv2d(1024, 512, kernel_size=(1, 1), stride=(1, 1), bias=False) (bn): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True) (act): SiLU() ) (cv3): Conv( (conv): Conv2d(1024, 1024, kernel_size=(1, 1), stride=(1, 1), bias=False) (bn): BatchNorm2d(1024, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True) (act): SiLU() ) (m): Sequential( (0): Bottleneck( (cv1): Conv( (conv): Conv2d(512, 512, kernel_size=(1, 1), stride=(1, 1), bias=False) (bn): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True) (act): SiLU() ) (cv2): Conv( (conv): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1), bias=False) (bn): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True) (act): SiLU() ) ) ) ) (SPPF): SPPF( (cv1): Conv( (conv): Conv2d(1024, 512, kernel_size=(1, 1), stride=(1, 1), bias=False) (bn): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True) (act): SiLU() ) (cv2): Conv( (conv): Conv2d(2048, 1024, kernel_size=(1, 1), stride=(1, 1), bias=False) (bn): BatchNorm2d(1024, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True) (act): SiLU() ) (m): MaxPool2d(kernel_size=5, stride=1, padding=2, dilation=1, ceil_mode=False) ) (classifier): Sequential( (0): Linear(in_features=65536, out_features=100, bias=True) (1): ReLU() (2): Linear(in_features=100, out_features=4, bias=True) ) )

# 统计模型参数量以及其他指标

import torchsummary as summary

summary.summary(model, (3, 224, 224))

----------------------------------------------------------------

Layer (type) Output Shape Param #

================================================================

Conv2d-1 [-1, 64, 113, 113] 1,728

BatchNorm2d-2 [-1, 64, 113, 113] 128

SiLU-3 [-1, 64, 113, 113] 0

Conv-4 [-1, 64, 113, 113] 0

Conv2d-5 [-1, 128, 57, 57] 73,728

BatchNorm2d-6 [-1, 128, 57, 57] 256

SiLU-7 [-1, 128, 57, 57] 0

Conv-8 [-1, 128, 57, 57] 0

Conv2d-9 [-1, 64, 57, 57] 8,192

BatchNorm2d-10 [-1, 64, 57, 57] 128

SiLU-11 [-1, 64, 57, 57] 0

Conv-12 [-1, 64, 57, 57] 0

Conv2d-13 [-1, 64, 57, 57] 4,096

BatchNorm2d-14 [-1, 64, 57, 57] 128

SiLU-15 [-1, 64, 57, 57] 0

Conv-16 [-1, 64, 57, 57] 0

Conv2d-17 [-1, 64, 57, 57] 36,864

BatchNorm2d-18 [-1, 64, 57, 57] 128

SiLU-19 [-1, 64, 57, 57] 0

Conv-20 [-1, 64, 57, 57] 0

Bottleneck-21 [-1, 64, 57, 57] 0

Conv2d-22 [-1, 64, 57, 57] 8,192

BatchNorm2d-23 [-1, 64, 57, 57] 128

SiLU-24 [-1, 64, 57, 57] 0

Conv-25 [-1, 64, 57, 57] 0

Conv2d-26 [-1, 128, 57, 57] 16,384

BatchNorm2d-27 [-1, 128, 57, 57] 256

SiLU-28 [-1, 128, 57, 57] 0

Conv-29 [-1, 128, 57, 57] 0

C3-30 [-1, 128, 57, 57] 0

Conv2d-31 [-1, 256, 29, 29] 294,912

BatchNorm2d-32 [-1, 256, 29, 29] 512

SiLU-33 [-1, 256, 29, 29] 0

Conv-34 [-1, 256, 29, 29] 0

Conv2d-35 [-1, 128, 29, 29] 32,768

BatchNorm2d-36 [-1, 128, 29, 29] 256

SiLU-37 [-1, 128, 29, 29] 0

Conv-38 [-1, 128, 29, 29] 0

Conv2d-39 [-1, 128, 29, 29] 16,384

BatchNorm2d-40 [-1, 128, 29, 29] 256

SiLU-41 [-1, 128, 29, 29] 0

Conv-42 [-1, 128, 29, 29] 0

Conv2d-43 [-1, 128, 29, 29] 147,456

BatchNorm2d-44 [-1, 128, 29, 29] 256

SiLU-45 [-1, 128, 29, 29] 0

Conv-46 [-1, 128, 29, 29] 0

Bottleneck-47 [-1, 128, 29, 29] 0

Conv2d-48 [-1, 128, 29, 29] 32,768

BatchNorm2d-49 [-1, 128, 29, 29] 256

SiLU-50 [-1, 128, 29, 29] 0

Conv-51 [-1, 128, 29, 29] 0

Conv2d-52 [-1, 256, 29, 29] 65,536

BatchNorm2d-53 [-1, 256, 29, 29] 512

SiLU-54 [-1, 256, 29, 29] 0

Conv-55 [-1, 256, 29, 29] 0

C3-56 [-1, 256, 29, 29] 0

Conv2d-57 [-1, 512, 15, 15] 1,179,648

BatchNorm2d-58 [-1, 512, 15, 15] 1,024

SiLU-59 [-1, 512, 15, 15] 0

Conv-60 [-1, 512, 15, 15] 0

Conv2d-61 [-1, 256, 15, 15] 131,072

BatchNorm2d-62 [-1, 256, 15, 15] 512

SiLU-63 [-1, 256, 15, 15] 0

Conv-64 [-1, 256, 15, 15] 0

Conv2d-65 [-1, 256, 15, 15] 65,536

BatchNorm2d-66 [-1, 256, 15, 15] 512

SiLU-67 [-1, 256, 15, 15] 0

Conv-68 [-1, 256, 15, 15] 0

Conv2d-69 [-1, 256, 15, 15] 589,824

BatchNorm2d-70 [-1, 256, 15, 15] 512

SiLU-71 [-1, 256, 15, 15] 0

Conv-72 [-1, 256, 15, 15] 0

Bottleneck-73 [-1, 256, 15, 15] 0

Conv2d-74 [-1, 256, 15, 15] 131,072

BatchNorm2d-75 [-1, 256, 15, 15] 512

SiLU-76 [-1, 256, 15, 15] 0

Conv-77 [-1, 256, 15, 15] 0

Conv2d-78 [-1, 512, 15, 15] 262,144

BatchNorm2d-79 [-1, 512, 15, 15] 1,024

SiLU-80 [-1, 512, 15, 15] 0

Conv-81 [-1, 512, 15, 15] 0

C3-82 [-1, 512, 15, 15] 0

Conv2d-83 [-1, 1024, 8, 8] 4,718,592

BatchNorm2d-84 [-1, 1024, 8, 8] 2,048

SiLU-85 [-1, 1024, 8, 8] 0

Conv-86 [-1, 1024, 8, 8] 0

Conv2d-87 [-1, 512, 8, 8] 524,288

BatchNorm2d-88 [-1, 512, 8, 8] 1,024

SiLU-89 [-1, 512, 8, 8] 0

Conv-90 [-1, 512, 8, 8] 0

Conv2d-91 [-1, 512, 8, 8] 262,144

BatchNorm2d-92 [-1, 512, 8, 8] 1,024

SiLU-93 [-1, 512, 8, 8] 0

Conv-94 [-1, 512, 8, 8] 0

Conv2d-95 [-1, 512, 8, 8] 2,359,296

BatchNorm2d-96 [-1, 512, 8, 8] 1,024

SiLU-97 [-1, 512, 8, 8] 0

Conv-98 [-1, 512, 8, 8] 0

Bottleneck-99 [-1, 512, 8, 8] 0

Conv2d-100 [-1, 512, 8, 8] 524,288

BatchNorm2d-101 [-1, 512, 8, 8] 1,024

SiLU-102 [-1, 512, 8, 8] 0

Conv-103 [-1, 512, 8, 8] 0

Conv2d-104 [-1, 1024, 8, 8] 1,048,576

BatchNorm2d-105 [-1, 1024, 8, 8] 2,048

SiLU-106 [-1, 1024, 8, 8] 0

Conv-107 [-1, 1024, 8, 8] 0

C3-108 [-1, 1024, 8, 8] 0

Conv2d-109 [-1, 512, 8, 8] 524,288

BatchNorm2d-110 [-1, 512, 8, 8] 1,024

SiLU-111 [-1, 512, 8, 8] 0

Conv-112 [-1, 512, 8, 8] 0

MaxPool2d-113 [-1, 512, 8, 8] 0

MaxPool2d-114 [-1, 512, 8, 8] 0

MaxPool2d-115 [-1, 512, 8, 8] 0

Conv2d-116 [-1, 1024, 8, 8] 2,097,152

BatchNorm2d-117 [-1, 1024, 8, 8] 2,048

SiLU-118 [-1, 1024, 8, 8] 0

Conv-119 [-1, 1024, 8, 8] 0

SPPF-120 [-1, 1024, 8, 8] 0

Linear-121 [-1, 100] 6,553,700

ReLU-122 [-1, 100] 0

Linear-123 [-1, 4] 404

================================================================

Total params: 21,729,592

Trainable params: 21,729,592

Non-trainable params: 0

----------------------------------------------------------------

Input size (MB): 0.57

Forward/backward pass size (MB): 137.59

Params size (MB): 82.89

Estimated Total Size (MB): 221.06

----------------------------------------------------------------