SimCSE: Simple Contrastive Learning of Sentence Embeddings

这篇论文,我觉得有意思。在创造对抗学习的正负例时,正例直接使用它本身。将同一个句子传递给预先训练好的编码器两次:通过应用两次dropout,我们可以得到两个不同的嵌入作为 “正实例”。然后,我们把同一小批中的其他句子作为 “负实例”。

我们首先描述了一种无监督的方法,它采用输入句子并在对比性目标中预测自己,只用dropout 的size大小作为噪音。

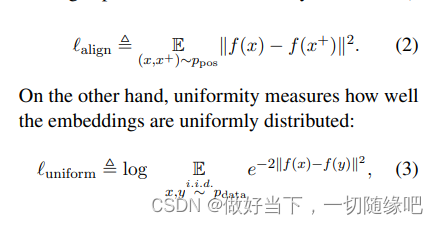

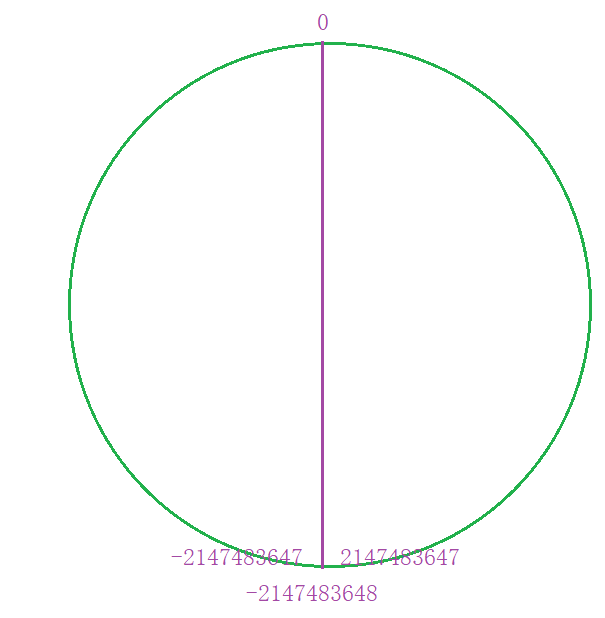

以语义相关的正实例之间的一致性和整个表示空间的均匀性来衡量所学嵌入的质量

alignment and uniformity

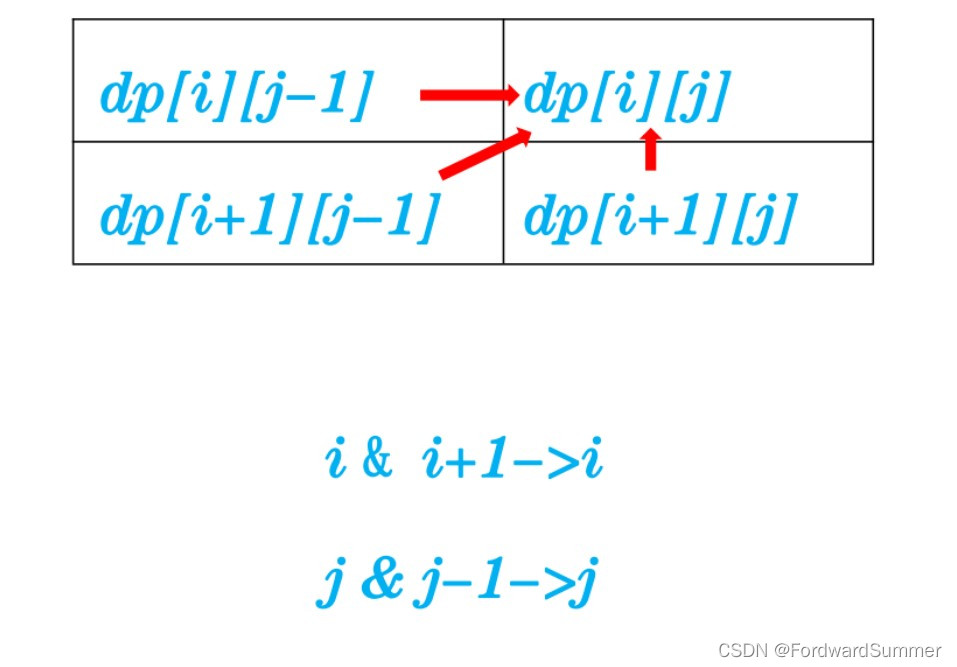

无监督训练过程

在无监督学习中,采用对抗学习增强实例语义表征能力。

训练目标:两个相同的实例采用不同的dropout mask。

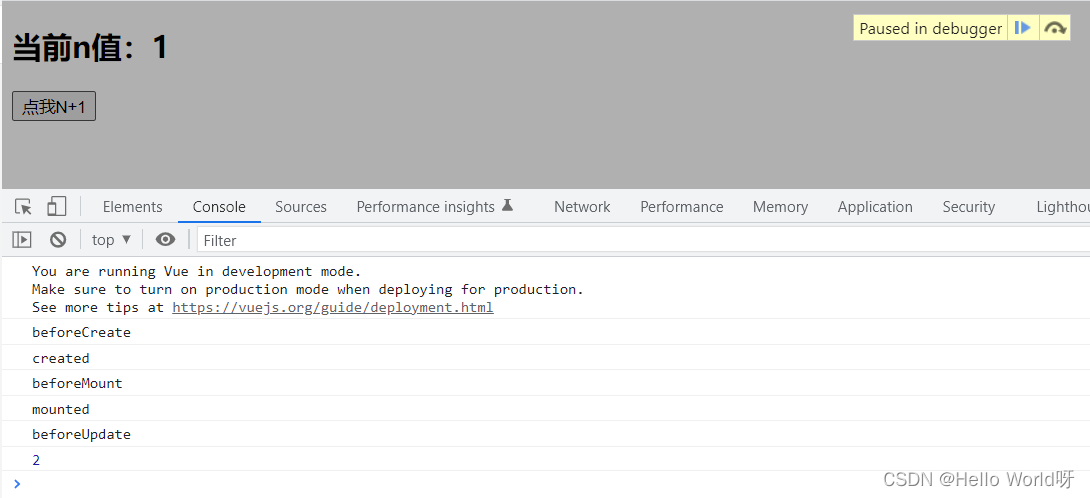

监督训练过程

训练目标是预测两个句子之间的关系:是连带的、中性的还是矛盾的——entailment, neutral or contradiction.

在语料中,有positive instance,negative instance,original instance。

所以,做对抗学习的目的,也是为了解决了词向量表征的各项异性问题。

实验

STS任务:semantic textual similarity 任务

![【1024社区大奖】让你一小时内狂揽大奖[保姆级教程①]](https://img-blog.csdnimg.cn/81935ae65e084954bfddd2ac88c8e5b5.png#pic_center)